基于Q学习的CDMA/WLAN异构网络接入控制算法*

刘惠茹,马 琳,徐玉滨

(1.北京机电工程研究所,北京 100074;2.哈尔滨工业大学 通信技术研究所,黑龙江 哈尔滨 150080)

基于Q学习的CDMA/WLAN异构网络接入控制算法*

刘惠茹1,马 琳2,徐玉滨2

(1.北京机电工程研究所,北京 100074;2.哈尔滨工业大学 通信技术研究所,黑龙江 哈尔滨 150080)

针对CDMA和WLAN异构网络环境下用户呼叫阻塞率高和系统资源利用率低的问题,提出一种结合Q学习的CDMA/WLAN网络智能接入控制方法。该方法通过将Q学习引入接入控制算法,对网络的进行网络状态离散化处理,并根据各网络所处的状态,驱使网络选择适合自己的用户,进而提高系统资源利用率。仿真结果表明,该方法通过Q学习的在线试错学习,降低了系统阻塞率,从整体上实现两个网络中用户累计回报值的最大化,并获得智能接入的系统状态——动作Q值表。

异构网络;Q学习;接入控制;CDMA;WLAN

现有的CDMA和WLAN网络接入选择策略中,常用的接入算法主要分为三类:①基于终端位置算法[2]是在重叠覆盖区尽可能使用WLAN网络,当用户处于高速移动状态或处于WLAN系统边缘时,会导致切换频率加快;②基于信号强度的方法[3]是通过周期性地测量WCDMA和WLAN网络信号,从而保证服务的持续连接;③基于系统收益的方法[4]引入效用参数,计算目标网络的代价函数,代价最小说明该网络具有最多的资源,从而接入到该网络。

强化学习中的Q学习理论是一种试错的在线学习技术,智能体通过与环境的交互获得经验,并逐步改进其行为策略。随着Q学习算法研究以及应用的越来越广泛,近年来已有学者将Q学习算法应用到网络的接入控制领域,并且取得了一定的成果。文献[5]提出了一种WCDMA/WLAN异构网络中适用于多媒体业务的模糊Q学习接入控制算法,采用效用函数方法判断一个用户业务请求接入到哪个网络最为合适。在保证服务质量的同时,将低了对新用户和切换用户的阻塞率,增大了系统吞吐量,减少了切换发生率,平衡了两个网络的负荷和系统利用率。文献[6]提出一种基于Q学习的WCDMA系统多速率传输控制策略的无线资源管理,将该控制问题根据用户QoS和传输代价建模为一个马尔科夫决策问题,以实现保证用户QoS需求的前提下,提高频谱利用率。2008年,张永靖提出给予Q学习的自主联合无线资源管理算法[7],即设置一个联合无线资源管理控制器,通过与环境的交互,学习环境中的知识,进而更有利于采取能够提高频谱效用的动作,并且实现了呼叫阻塞率与频谱效用的折中。文献[8]则提出一种能够适应网络环境动态变化的Q学习异构网络选择算法。该算法考虑了网络的负载情况,并结合呼叫的业务类型、终端在网络中所处的位置,实现了网络的自主选择,降低了系统阻塞率。

鉴于用户数目和业务类型的增加,网络状态呈现出爆炸式增长的问题。同时,为了使用户获得更好的网络接入性能,需要充分利用CDMA和WLAN的网络特性,挖掘Q学习算法的技术优势。为此,本文提出一种基于Q学习的异构网络接入控制方法,以实现对用户的智能接入控制,提高系统资源利用率。

1 系统模型

本文考虑一个CDMA网络和一个WLAN网络的情形,且WLAN网络位于CDMA网络的覆盖区域内。

1.1CDMA网络准入条件

在CDMA网络中,判断一个新用户能否接入需要满足两个条件:①接入后是否会影响已有用户QoS;②网络能否满足该呼叫用户的QoS要求。

CDMA网络上行链路准入条件分析。假设CDMA网络中用户数为N,信噪比Eb/N0为每个用户比特能量与噪声谱密度之比,用户i的信噪比为:

式中,W为码片速率;Pi为来自用户i的信号接收功率;vi为用户i的激活因子;Ri为用户i的比特速率;Itotal是基站处的总接收功率,可表示为:

因此,解得Pi为:

定义Pi=LiItotal,得到一个连接的负载因子Li:

负载因子中考虑来自其他小区的干扰,各条连接负载因子之和ηUL可写成:

式中,f为其他小区与本小区干扰之比,取0.55[4]。

当上行负载因子ηUL增加时,上行干扰功率Itotal也增加。由文献[9]可知,预测干扰功率增加量为:

式中,新用户负载因子ΔL是新连接的负载因子:

CDMA网络的准入条件需同时满足:

(1)新的总干扰电平低于门限,即

(2)新的总负载不大于负载门限,即

式中,Ithreshold和ηthreshold为干扰电平和负载门限。

1.2WLAN网络准入条件

由文献[10]得到,WLAN网络信道利用率为:

采用RTS/CTS机制来避免冲突。根据信道利用率,WLAN网络归一化吞吐量S可通过式(11)得到:

式中,Tdata是成功传输一次数据包所需要的平均时间。WLAN网络的最大吞吐量只有在非饱和情况下,通过控制冲突概率为一个最优值p*才能达到[10]。此时,WLAN网络提供的总带宽为:

式中,B为WLAN网络的总发射速率。定义WLAN网络中用户i的负载为:

式中,bi为用户i的带宽,Ba由式(12)决定。因此,有n个用户的WLAN网络总负载为:

当一个新用户接入WLAN网络后总负载小于负载门限时,该请求才被允许。

2 Q学习算法设计

由于Q学习算法训练是利用网络状态和选取动作进行迭代并获得即时回报,从而引导智能体选择有利于增大系统收益的动作。所以,用户的选择过程中,参数对网络性能有直接的影响。Q学习里的状态是离散的,需要将CDMA和WLAN网络中的网络状态离散化。同时,即时回报需要深入探讨,因为它是智能体在采取某个动作的重要衡量标准,影响着智能体选择动作的正确性。

2.1网络状态离散化

主要采取了取样试验和钻孔压注水检查手段,结果均满足设计要求。通过钻孔提取芯样分析,墙体连续性和完整性较好,满足设计要求。

由于网络中的最大用户数和最小用户数相差较大,均匀离散化网络状态会导致网络中的某些状态出现次数较少,因此需要仿真更多次数才能使Q学习算法达到收敛。文中充分利用网络中用户数的均值和方差来进行网络离散化处理,有助于Q学习在线学习时保证每一个状态都能够被遍历无数次,加快收敛速度。根据CDMA和WLAN网络中的用户数,将分别对两个网络的状态离散为4个,分别用SCDMA和SWLAN表示CDMA和WLAN网络中离散化后的四个状态。

CDMA网络中,状态SCDMA定义如下:

式中,NCDMA为CDMA网络当前用户数;Naver_CDMA为CDMA网络中的平均用户数;δCDMA为CDMA网络中的用户数方差。根据方差的定义,CDMA网络用户数的方差为:

式中,N为CDMA网络中当前在线用户数。

同理,WLAN网络中也可得到类似的表达式。WLAN网络状态SWLAN定义如下:

式中,NWLAN为WLAN网络中当前在线用户数;Naver_WLAN为WLAN网络平均用户数;δWLAN为WLAN网络用户数方差:

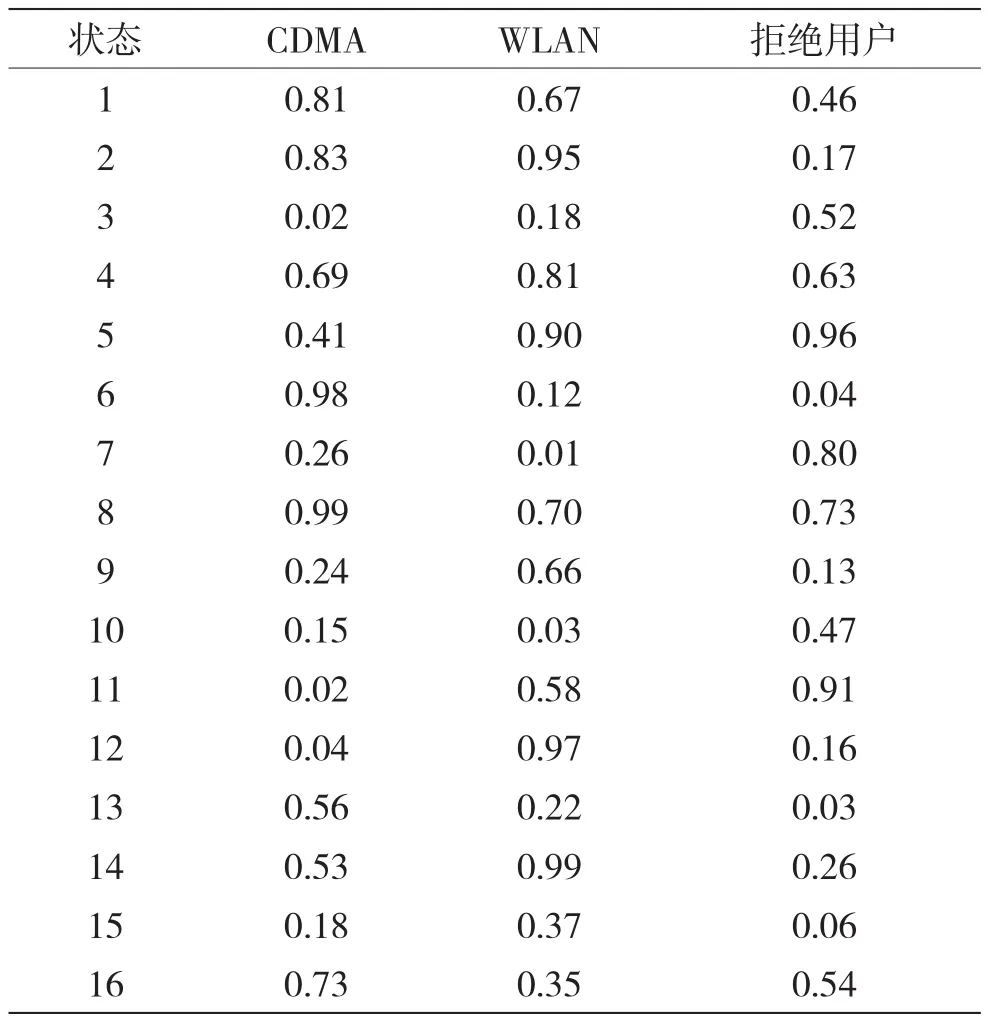

分别得到CDMA和WLAN两个网络中的4个状态后,考虑异构网络环境时,则两两组合可以组成的状态总共有16种。每个用户到达网络后,智能体可选择的动作有三个:接入到CDMA系统、接入到WLAN系统和拒绝用户请求。于是,通过Q学习能得到16行3列的Q值表。

2.2回报函数定义

本文业务属性函数定义为:若新呼叫用户为语音业务,用户接入CDMA网络,业务属性η(v,d)=5,用户接入到WLAN网络,业务属性η(v,d)=2,用户请求被拒绝,业务属性η(v,d)=0;若新呼叫用户为数据业务,用户接入CDMA网络,业务属性η(v,d)=2,用户接入WLAN网络,业务属性η(v,d)=5,用户请求被拒绝,业务属性η(v,d)=0。

根据用户请求带宽和网络能够给用户提供的实际带宽,定义网络收益函数[4]。

式中,θ为用户请求的带宽,x为当前系统能够分配给用户的带宽。根据网络收益函数的定义及业务属性,得到CDMA/WLAN异构网络的回报函数:

通过Q学习算法的在线学习,获得即时回报值,该值由式(20)给出。

2.3算法流程

本文综合考虑CDMA和WLAN网络中的用户数、用户请求速率、业务属性以及系统实际分配给用户的速率等诸多因素,利用Q学习算法,根据网络状态和回报函数的分析,提出基于Q学习的CDMA/WLAN异构网络接入控制算法。

算法具体步骤如下:

步骤一:初始化Q(s,α)。初始化Q值表,可以令Q值表中每一个元素都为零或者利用函数产生随机值,并分别设定初始学习率α和折扣因子γ,设定初始动作选择探索概率ε。因为Q学习需要通过状态-动作进行迭代,故需要在迭代过程中快速、高效地遍历每一个策略空间。避免贪婪算法开始迭代过程中,由于学习的环境知识较少,会“掩盖”最优策略的问题。为了避免其发生,本文采用Boltzmann[11]搜索方法,在网络的当前状态s下,按式(21)定义的概率来选择动作a,即:

式中,T为模拟退火温度参数,随迭代逐渐降为0。

步骤二:获取当前状态s。先判断当前CDMA和WLAN网络的各业务用户数,然后根据网络离散化策略获得两个网络的当前所处状态,从而判断出当前网络所处16个状态中的位置。

步骤三:选择执行的动作α。观察作集合A(CDMA、WLAN和拒绝),根据当前时刻网络的状态-动作函数值Qt(s,α),按式(21)给出的概率来选择动作α,并执行该动作。

步骤四:获取回报r和下一时刻的状态s'。根据动作执行的结果,计算当前用户获得的回报值R,并获得网络下一个状态的动作值函数的最大值利用式(22)更新Qt(s,α):

步骤五:系统参数更新。每次迭代结束后,更新探索概率和学习率。

步骤六:更新Q值表,最后找到最优的Q值,即:

步骤七:比较前后两次Q值的变化情况。如果满足ΔQ( s, a)<ε,∀s∈S, a∈A,算法达到收敛,停止计算。否则,重复步骤二到步骤六。

3 仿真与分析

3.1仿真建立

根据以上对Q学习接入控制策略的分析,在CDMA/WLAN异构网络条件下,考察一个由单一小区重叠覆盖区域的异构网络环境,如图1所示。CDMA和WLAN的覆盖范围和小区容量不一样,假设都支持12.2 kbps和32 kbps的语音和数据两种业务。用户达到率服从泊松分布,业务持续时间服从负指数分布。为了验证所提出的Q学习接入控制算法的性能,仿真评估基于Q学习的CDMA/WLAN异构网络接入控制策略的系统阻塞率、用户收益及吞吐量。

图1 CDMA和WLAN单小区重叠覆盖场景

根据离散化的16个状态,可选动作为三个:CDMA网络、WLAN网络和拒绝用户接入。对CDMA/WLAN异构网络采用Q学习进行接入控制算法训练,同时根据当前网络的用户数判断网络所处的状态,根据Q学习迭代公式进行训练。仿真10 000次在不同到达率情况下的阻塞率情况,最后给出某个到达率下训练结束后的Q值表。智能体根据最终Q值表,从为用户带来收益的角度选择最适合异构网络的最佳动作。CDMA/WLAN系统仿真参数设定如表1所示,并设定语音业务和数据业务的速率与CDMA中的请求速率一样。

表1 系统仿真参数

3.2结果分析

为了说明本文提出Q学习接入控制方法的性能,本文与WLAN优先接入控制算法的系统阻塞率和长期累计回报值进行比较。图2和图3给出了不同用户到达率情况下系统阻塞率和归一化的累计回报。

图2 不同到达率下的系统阻塞率

如图2所示,本文提出的Q学习接入控制算法比WLAN网络优先接入控制算法有着更低的阻塞率。因为在WLAN优先接入控制算法中,只考虑了当用户到达时所有用户都尝试接入到WLAN网络中,而没有考虑当前两个网络的整体情况。例如,当WLAN网络中用户数较多时,更多的用户向WLAN网络发起呼叫请求,那么呼叫请求被系统引导到CDMA网络中的用户数较多。本文提出的Q学习接入控制算法是通过在线学习选择能够最大化网络中用户总收益的网络进行接入,能够从长远角度考虑,使智能体能够选择一个最优的动作。这样不仅平衡了两个网络负荷,同时也降低了系统阻塞率。可见,该Q学习接入控制算法从整体上实现了两个网络中用户累计回报的最大化。

图3给出了两种算法在不同到达率下用户的归一化累计回报值。可以看出,当采用本文提出的Q学习接入控制算法后,用户的归一化累计回报明显高于WLAN网络优先接入算法,说明提出的算法在通过学习网络当前的状态而采取相应的策略,不仅能够降低系统阻塞率,同时系统还能得到更高的长期回报,从而验证了本文提出算法的有效性。

图3 不同到达率下归一化用户累计回报

根据 对网络状态进行离散化和定义的回报函数,仿真中分别考虑了CDMA和WLAN网络的4个状态组合后形成的16个新的状态。在给定的每一个用户到达率下,本文所提出的Q学习异构网络接入控制方法都能够获得一个Q表。假设用户平均到达率为0.5个/秒,则根据学习结束后获得的Q表,每个对应的状态下智能体做出的动作是选择该状态行中Q的最大值所对应的动作,如表2所示。

表2 Q学习状态—动作表

由表2可以得到,当CDMA/WLAN异构网络系统处于某个状态时,则找到Q表中对应于该状态的行,选择该行中最大值对应的动作执行。例如,当网络处于第6个状态时,一个新用户到达后将接入到CDMA系统中;当网络处于第12个状态时,用户接入到WLAN网络中;当网络处于第7个状态时,新用户的请求被拒绝。根据该Q表可以实现CDMA和WLAN异构网络接入控制,不仅能够降低系统对用户的阻塞率,还能够简单明了得从Q值表中即可实现最佳的接入控制。这样可以根据该Q值表决定用户接入到某一个网络中或者拒绝用户请求,从而实现CDMA/WLAN异构网络的智能接入控制。

4 结 语

针对CDMA和WLAN异构网络接入控制策略的不足以及Q学习的优势,提出了基于Q学习的接入控制算法。根据网络中的用户数分别对两个网络的状态进行离散化处理,并根据用户的业务类型和用户收益定义智能体选择动作所获得的即时回报。通过对Q学习算法进行仿真迭代,降低了系统阻塞率、提高了用户的累积回报值和系统资源利用效率,同时得到了一定用户到达率下的网络状态-动作Q表,根据该表可以实现对CDMA/WLAN异构网络的智能接入控制。

[1] 3rd Generation Partnership Project(3GPP),3GPP System to Wireless Local Area Network(WLAN) Interworking System Description,Release 6,TS 23.234 V6.10.0[S].2006.

[2] Yilmaz O, Furuskar A, Pettersson J, et al.Access Selection in WCDMA and WLAN Muti-access Networks[C].IEEE VTC Spring,2005:2220-2224.

[3] Gordon J. Pareto Process as a Model of Self-simiar Packet Traffic[C].IEEE GLOBECOM,1995(03):2232-2236.

[4] Pei X, Jiang T, Qu D, et al. Radio Resource Management and Access-Control Mechanism based on a Novel Economic Model in Heterogeneous Wireless Networks[J]. IEEE Trans. Veh. Technol.,2010,59(06):3047-3056.

[5] Chen Y, Chang C, Ren F. Q-learning-Based Multirate Transmission Control Scheme for RRM in Multimedia WCDMA Systems[J].IEEE Trans. Veh. Technol.,2004,53(01):38-48.

[6] Chen Y, Chang C, Huang C. Fuzzy Q-Learning Admission Control for WCDMA/WLAN Heterogeneous Networks with Multimedia Traffic[J].IEEE Trans. Mob. Computing,2009,8(11):1469-1479.

[7] 张永靖,冯志勇,张平.基于Q学习的自主联合无线资源管理算法[J].电子与信息学报,2008,3(03):676-680. ZHANG Yong-jing, FENG Zhi-yong, ZHANG Ping. A Q-learning Based Autonomic Joint Radio Resource Management Algorithm[J].Journal of Electronics & Information Technology, 2008,3(03):676-680.

[8] 赵彦清,朱琦.基于Q学习的异构网络选择新算法[J].计算机应用,2011,31(06):1641-1644. ZHAO Yan-qing, ZHU Qi. New Q-learning based Heterogeneous Network Selection Algorithm [J].Journal of Computer Applications. 2011,31 (06): 1641-1644.

[9] Lundin E, Gunnarsson F, Gustafsson. Uplink Load Estimation in WCDMA[C].IEEE Conference Wireless Communications and Networking, 2003:1669-1674.

[10] Zhai H, Chen X, Fang Y. How Well Can the IEEE 802.11 Wireless LAN Support Quality of Service?[J]. IEEE Trans. Wireless Commun.,2005,4(06):3084-3094.

[11] Kaelbling L, Littman M, Wang X, et al. Reinforcement Learning: A Survey[J]. Journal of Artificial Intelligence Research, 1996, 4(02): 237-285.

刘惠茹(1977—),女,硕士,高级工程师,主要研究方向为宽带移动通信;

马 琳(1980—),男,博士,副教授,博士生导师,主要研究方向为宽带移动通信、室内定位技术;

徐玉滨(1954—),男,博士,教授,博士生导师,主要研究方向为宽带移动通信、室内定位技术。

Q Learning-based Access-Control Algorithm for CDMA/WLAN Heterogeneous Networks

LIU Hui-ru1, MA Lin2, XU Yu-bin2

(1.Beijing Research Institute of Mechanical & Electrical Technology, Beijing 100074, China; 2.Communication Research Center of Harbin University of Technology, Harbin Heilongjiang 150080, China)

in heterogeneous CDMA and WLAN scenario, aiming at the problem of low system-resource utilization and the high blocking probability, a Q learning-based smart access-control algorithm for CDMA/WLAN heterogeneous networks is proposed. By introducing the Q learning method the proposed algorithm, this smart access-control algorithm could thus implement discrete processing of the network states, and based on the states of various networks, make the networks choose proper users for themselves, and via this enhance the system-resource utilization ratio. Simulation results show that by using Q learning to the online study, the proposed algorithm could globally reduce the blocking probability and maximizes the circulative rewards for the users in the two networks, and acquire the system state-action Q learning table for smart access-control.

heterogeneous network; Q learning; access-control; CDMA; WLAN

0 引 言

异构网络的融合能够为用户提供不同业务需求、满足不同的服务质量(Quality of Service,QoS)要求。鉴于CDMA和WLAN[1]网络的互补特性、重叠网络覆盖及业务的多样性,使得二者的融合成为必然。松耦合和紧耦合模式为网络互联奠定了基础。网络接入选择作为异构网络融合的关键技术之一,是实现CDMA和WLAN异构网络间无缝连接的关键。

National Natural Science Foundation of China (No.61571162);Science and Technology Project of Ministry of Public Security Foundation (No.2015GABJC38);Major National Science and Technology Project(No.2015ZX03004002-004)

TN925.93

A

1002-0802(2016)-08-01017-06

10.3969/j.issn.1002-0802.2016.08.012

2016-04-24;

2016-07-25

date:2016-04-24;Revised date:2016-07-25

国家自然科学基金(No.61571162);公安部科技强警基础工作专项(No.2015GABJC38);国家科技重大专项子课题(No.2015ZX03004002-004)