基于改进Mask R-CNN的铁路扣件状态检测方法研究

白堂博 高嘉琳 杨建伟 许贵阳

1.北京建筑大学机电与车辆工程学院,北京100044;2.北京建筑大学城市轨道交通车辆服役性能保障北京市重点实验室,北京100044

扣件是城市轨道中不可忽视的基础部件,扣件状态的准确智能化检测对于保证轨道列车安全运行具有重要意义[1]。在列车运行过程中扣件容易出现移位、断裂、丢失等问题。这些问题所产生的振动及噪声十分微小,基于振动、噪声信号分析的检测方法处理难度大,检测效果差[2]。

目前基于图像采集与处理的扣件状态检测方法有流行排序方法[3]、十字交叉与特征测度方法[4]、引导滤波与积分投影方法[5]、垂向定位与灰度投影方法[6]、置信图方法[7]等。这些方法优点是计算效率较高,但需要分别进行扣件的定位及扣件图像特征的提取,并须根据特定的检测对象进行算法修正,难以适应多变的现场情况。

近年来随着目标检测技术的发展,深度学习被应用于扣件状态检测。Guo等[8]提出基于YOLOv4(You Only Look Once v4)算法的扣件状态检测方法;龙炎[9]提出了基于Faster R-CNN(Faster Region-based Convolutional Neural Networks)算法的扣件状态检测方法;李兆洋等[10]建立了基于改进SSD(Single Shot Multibox Detector,SSD)算法的扣件定位方法。该类方法不用经过目标定位及图像特征提取,可直接对图像中的扣件区域进行检测,但是该类方法重点在于检出目标,对扣件断裂及缺失检测效果好,对扣件偏移的检测效果较差。

针对这种情况,本文提出一种基于改进Mask R-CNN的铁路扣件状态检测方法,首先利用Mask R-CNN方法实现扣件的位置检测与扣件图像分割,然后利用最小外接矩形法改进Mask R-CNN的输出层,计算获得扣件图像角度信息,进而识别偏移扣件。

1 Mask R-CNN算法简介

区域卷积神经网络(R-CNN)是在经典深度学习算法卷积神经网络(CNN)基础上发展起来的,在图像处理中具有较好的性能,被广泛应用到目标检测领域。R-CNN算法先通过搜索或者边框检测生成候选图像区域,再将每个图像区域视为一张待分类图像输入CNN进行网络训练和目标检测。为了实现目标检测,R-CNN算法须首先选定大量的候选图像区域进行训练,计算量太大,影响检测效率。为解决这一问题,Fast R-CNN和Faster R-CNN相继被提出,通过改变卷积次序和引入区域候选网络减少了计算量,提高了计算效率。

掩膜区域卷积神经网络(Mask R-CNN)[11]是在Faster R-CNN的基础上改进而来的,增加了感兴趣区域(Region of Interest,ROI)排列步骤和全卷积网络,以实现图像分割和目标提取。

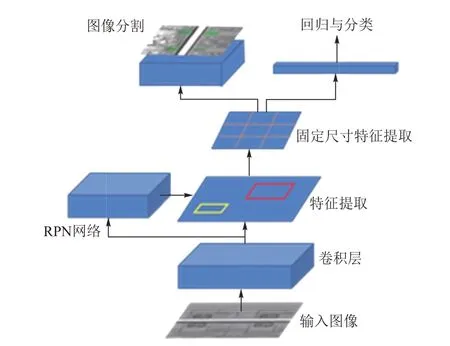

Mask R-CNN(图1)主要分为特征提取、区域候选和结果输出三大部分,输出结果包括目标物体分类、目标检测框回归及目标图像分割。在进行目标检测时,系统会通过卷积网络生成候选图像区域并实现目标检测。Mask R-CNN将原来的ROI池化改进为ROI排列,通过这一操作,特征图被划分为一定规格的二值掩膜图,保证了像素输入和输出的对应关系,从而实现了Faster R-CNN所不具备的图像分割功能。

图1 Mask R-CNN结构

2 基于改进Mask R-CNN的铁路扣件状态检测方法

2.1 设计思路及具体步骤

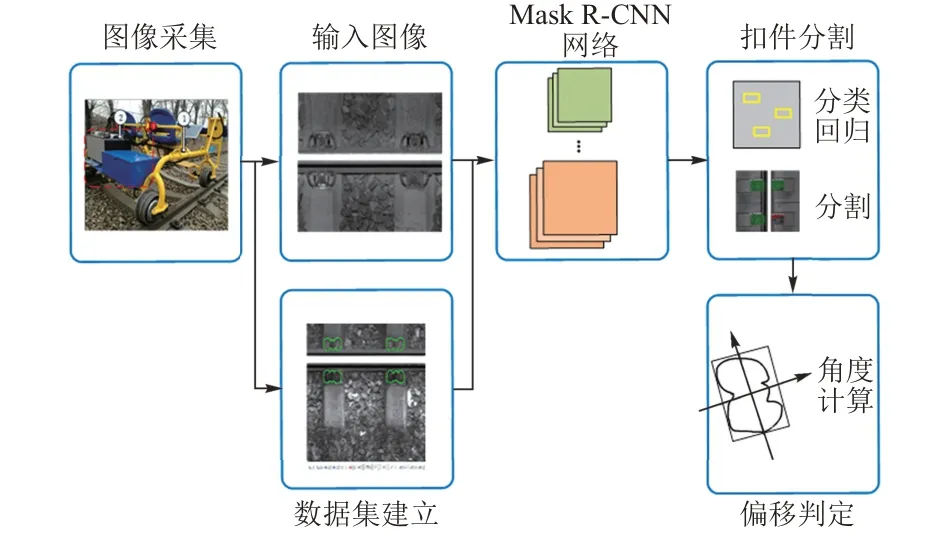

利用Mask R-CNN算法进行扣件状态检测时可将完整扣件与断裂、丢失状态的扣件分开,但正常扣件与偏移扣件同属于完整扣件,分类时难以有效区分。本文根据Mask R-CNN具备目标物体图像分割的特点,利用最小外接矩形法改进Mask R-CNN的输出层,以实现偏移扣件的角度计算及状态检测。设计思路如图2所示。具体步骤:首先进行现场试验,完成图像采集并建立数据集;然后利用Mask R-CNN将扣件中完整扣件和断裂、丢失状态的扣件进行初步分类;最后利用最小外接矩形法对Mask R-CNN的输出层中完整扣件的分割图像进行角度计算,以判断其是否为偏移扣件。

图2 本文方法的设计思路

2.2 基于最小外接矩形法的Mask R-CNN输出层改进

最小外接矩形法[12]是一种获取图像中特定目标物体角度的方法。计算时将图像中目标物体区域分割出来,并使目标物体区域在90°范围内等角度旋转,每次旋转后,用一个水平外接矩形拟合其边界。通过计算这一过程中得到的最小外接矩形特征参数即可得到物体角度等信息。

最小外接矩形法采用顶点链码方法[12]对目标的最小外接矩形的几何形状特征参数进行计算,以得到目标偏转角度。

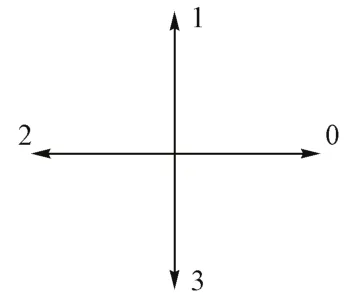

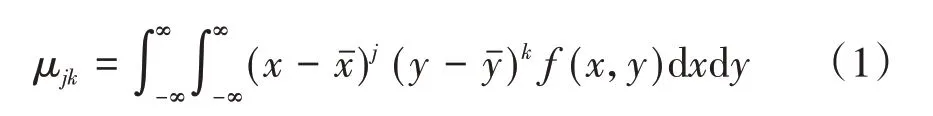

根据四方向顶点链码方法,目标图像顶点在旋转过程中在4个步进方向0、1、2、3进行遍历(图3),得到图像中目标物体边界[12]f(x,y),然后利用该边界求中心矩μjk,最终求得目标物体主轴与x轴的夹角α。μjk的计算公式为

图3 四方向顶点链码方法步进方向示意

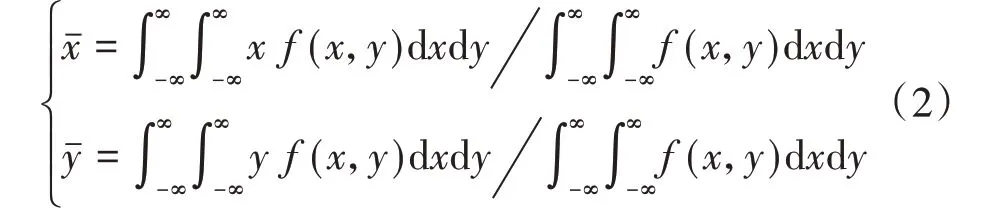

式中:j,k分别为目标物体边界f(x,y)横纵坐标的阶次,j,k=0,1,2;xˉ和yˉ为目标物体质心横纵坐标,其计算公式为

目标物体主轴与x轴的夹角α为

式中:μ11,μ20,μ02分别为目标图像主轴方向、x轴方向和y轴方向上的二阶中心矩,由式(1)计算得到。

利用最小外接矩形法改进Mask R-CNN的输出层,可以在得到扣件分割图像后直接输出扣件角度信息。在该方法中,目标扣件边界f(x,y)不需采用顶点链码方法求取,只需通过Mask R-CNN算法中的ROI排列,直接获取目标扣件分割区域并得出扣件边界坐标,简化了计算,提高了效率。

3 工程现场验证

3.1 检测设备

选取京沪高速铁路上长15 km的轨道区间(其中无砟轨道约10.2 km,有砟轨道4.8 km)作为试验段,对基于改进Mask R-CNN的扣件状态检测方法应用效果进行验证。试验采用的智能轨道巡检车(图4)由北京鹰路科技有限公司研发,该车分为电动巡检车和轨道状态巡检系统两部分。电动巡检车由车体、轨道轮和座椅组成;轨道状态巡检系统由主机和高清线阵图像扫描模块组成。采集轨道图像时巡检车运行速度为20 km/h,图像分辨率为2 048×2 048。

图4 智能轨道巡检车

3.2 图像采集与处理

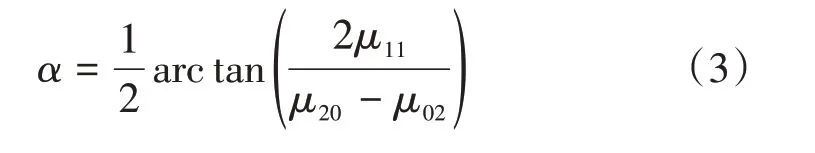

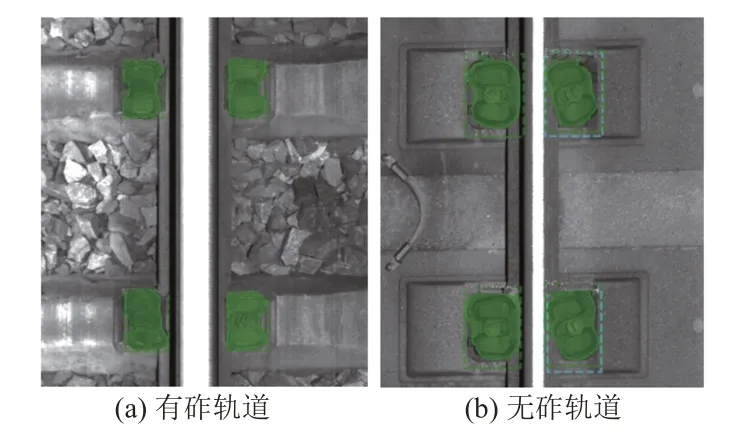

本次检测中获得的轨道图像分有砟轨道和无砟轨道两种,见图5。扣件状态检测算法运行所采用的关键硬件中GPU为NVIDIA RTX2080,CPU为Intel i7 9700,内存为16 GB。算法运行平台为Windows 10,算法运行所需软件包括Tensorflow 1.6,Python 3.6.5,CUDA 10.0,CUDNN 10.0。

图5 轨道图像

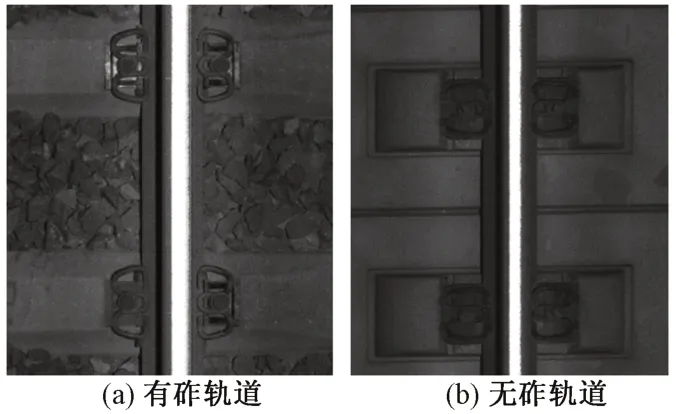

选用现场采集的1 000张轨道图像(其中无砟轨道600张,有砟轨道400张)进行扣件状态检测分析,随机选取500张作为训练集,其余500张作为测试集。测试前需要进行图像标注以建立训练集特征信息库。采用LABELME软件进行训练集图像标注(图6),将图像中的扣件区域作为目标检测区域。

图6 图像标注

根据训练集图像标注生成的扣件边界坐标数据集进行算法训练。

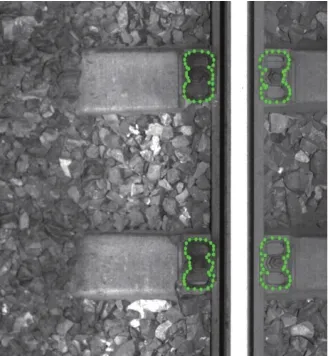

3.3 检测结果与分析

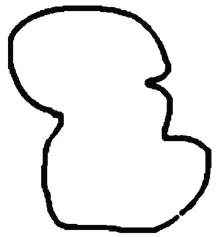

将测试集图像输入到改进的Mask R-CNN,得到扣件区域的分割结果,见图7。可见,改进的Mask R-CNN能够检测出图像中扣件位置并进行分割,对所分割的扣件区域进行预处理,包括去除边界外部信息、去除噪声、滤波、二值化,最终提取出扣件边界,见图8。

图7 扣件位置检测及分割结果

图8 扣件边界提取

根据提取出的扣件边界数据,构造扣件边界函数f(x,y),将该边界函数代入式(1)—式(3),即可得到扣件偏移角度。以图8中扣件为例,经计算得到该扣件主轴与轨道方向的偏移角度(即夹角α)为-15.28°。根据工程经验,夹角超过±10°即可判定为扣件偏移,因此该扣件被判定处于偏移状态。

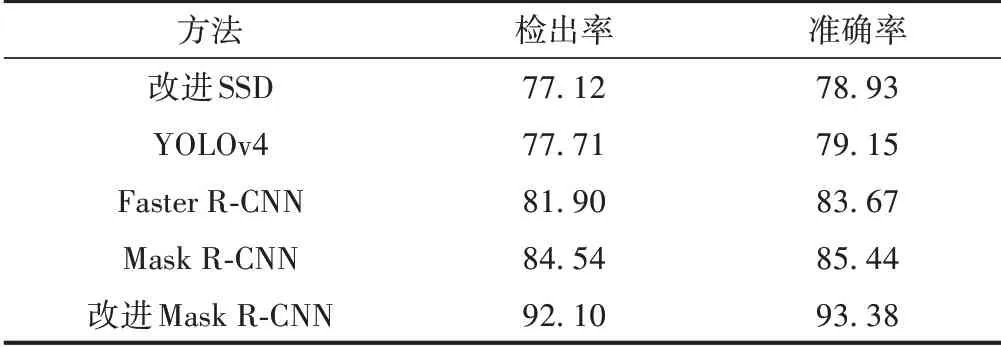

基于改进Mask R-CNN的扣件状态检测方法与其他基于深度学习的扣件状态检测方法对偏移扣件的检测结果对比见表1。其中,检出率为正确检出扣件占所有待检测扣件的百分比,准确率为正确检出扣件占所有检出扣件的百分比。可见,本文提出的改进Mask R-CNN扣件状态检测方法的检出率和准确率均高于其他方法。该方法对扣件角度进行计算,可有效判定扣件偏移状态,提高偏移扣件的检出率和准确率。

表1 偏移扣件检测结果对比 %

4 结论

针对轨道扣件状态检测中偏移扣件检测难的问题,提出了基于改进Mask R-CNN的扣件状态检测方法。该检测方法可以有效检测出图像中扣件的位置并进行分割,分割后的扣件图像经预处理和计算后可直接获得扣件偏移角度,进而实现对扣件偏移状态的判定。经在京沪高速铁路试验段现场测试,该检测方法能够对偏移扣件进行有效检测,并且检出率和准确率均较高。