基于深度学习的番茄授粉机器人目标识别与检测

余贤海,孔德义,谢晓轩,王 琼,白先伟

基于深度学习的番茄授粉机器人目标识别与检测

余贤海1,孔德义2,3※,谢晓轩2,3,王 琼2,3,白先伟2,3

(1. 合肥工业大学微电子学院,合肥 230601;2. 中国科学院合肥智能机械研究所,合肥 230031;3. 中国科学技术大学研究生院科学岛分院,合肥 230009)

针对植物工厂中对番茄花朵授粉作业的自动化和智能化需求,为克服当前机器人在授粉作业过程中因番茄花朵小、姿态朝向各异而导致的检测精度不高和授粉策略不完善等难题,该研究提出了一种由目标检测、花期分类和姿态识别相结合的番茄花朵检测分类算法——TFDC-Net(Tomato Flower Detection and Classification Network)。在目标检测阶段,提出了一种改进的YOLOv5s网络模型ACW_YOLOv5s,通过在YOLOv5s网络中添加卷积块注意力模块(Convolutional Block Attention Module,CBAM)并采用加权框融合(Weighted Boxes Fusion,WBF)方法,使模型的准确率达到0.957,召回率达到0.942,mAP0.5为0.968,mAP0.5-0.95为0.620,各项指标相较于原YOLOv5s网络模型分别提高了0.028、0.004、0.012、0.066,并改善了目标漏检和误检的状况。进而,针对不同花期的花朵以及花蕊不同姿态朝向的授粉问题,采用EfficientNetV2分类网络分别对3种不同花期和5种不同花蕊姿态朝向的花朵进行训练,分别得到花期分类模型及姿态识别模型,通过选取300张花期图片和200张姿态图片对其进行测试,花期分类模型和姿态分类模型的总体准确率分别为97.0%和90.5%。将研究提出的TFDC-Net算法应用于自主研发的授粉机器人中进行试验验证,结果表明,该算法能够实现对番茄花朵的目标检测、花期分类和姿态识别。在此基础上,通过坐标转换对目标快速定位,利用机器人机械臂末端执行器对番茄花朵中的花蕊完成了精准授粉,验证了该算法的有效性。该研究可实现对番茄花朵的目标识别与检测,有助于进一步推动授粉机器人的研发与应用。

深度学习;神经网络;目标检测;花期分类;姿态识别;授粉机器人

0 引 言

番茄是植物工厂中种植最广泛的蔬菜之一,在自然环境中可通过自然风或昆虫等媒介完成授粉,但在植物工厂这样的密闭环境中,由于缺乏自然风和昆虫活动,导致番茄植株授粉不良,易造成落花、落果、畸形果等问题,影响番茄的产量和品质[1]。而人工授粉存在授粉不均匀、劳动强度大等问题[2],因此授粉机器人应运而生。授粉机器人能有效减少授粉工作量,提高番茄的产量和品质[3]。由于番茄花朵生长环境为非结构化环境[4],且花朵小、姿态朝向各异,不易识别,因此番茄花朵的目标检测与定位成为授粉机器人的关键技术和研究热点。

目前国内外对花朵的目标检测已经取得了一定的进展。崔明等[5]针对草莓图像特点,采用改进K均值聚类方法完成图像的分割,并利用形态学处理和连通区域特征分析提取花朵区域目标,完成对草莓花朵的识别。Jason等[6]采用远近识别相结合的方法,使用相机对目标进行远程识别,并用分类器对颜色进行粗分割,提取图像中可能是花的区域,再用迁移学习的方法判断在此区域中是否存在花朵目标。在近距离识别中使用RGB-D相机(深度相机)以及实时密集SLAM(Simultaneous Localization and Mapping)对植株进行重构,再用分类算法对重构的植株图像中的花朵进行识别,总体准确率达到78.6%。

传统图像处理技术在进行目标检测时存在检测精度低、抗干扰能力差、无法适应复杂环境等问题[7]。近年来,对于花朵的目标检测,基于深度学习的方法应用最为广泛。该方法利用深度卷积神经网络提取花朵的多维特征,可实现端到端的目标检测,达到更高的检测准确率[8-9]。Williams等[10]采用深度学习方法,通过Faster RCNN(Regions with Convolutional Neural Network Features)网络算法训练猕猴桃花朵的数据集,得到的模型平均精度为85.3%。Dias等[11]采用一种对杂乱和光照变化具有鲁棒性的花卉识别技术,对深度卷积神经网络进行调整,使其对花朵有更好的识别效果,训练得到的模型精准率和召回率都高于90.0%。Tian等[12]采用SSD(Single Shot Multibox Detector)深度学习方法,利用牛津大学出版的花卉数据集VOC2007和VOC2012进行训练,前者的平均准确率为83.6%,后者的平均准确率为87.0%,并可以检测2个或多个目标花卉。

针对番茄花朵检测,Yuan等[13]利用双目视觉系统,根据饱和度和色相的颜色特征以及大小特征对番茄花簇进行检测。当花簇只有1朵花时识别率只有50.0%,当有2朵花以上时识别率高于80.0%。对花簇进行识别后再授粉,如果不能准确地识别每一个花朵目标,就无法达到精准授粉的目的。

综上所述,传统图像处理技术提取的番茄花朵特征有限,识别精度较低[14],而对花簇进行识别再授粉的方法无法达到精准授粉的目的。鉴于此,本文提出了一种基于深度学习的TFDC-Net(Tomato Flower Detection and Classification Network)算法,它由番茄花朵目标检测算法、花期分类和花朵姿态朝向识别算法整合而成,不仅对番茄花朵具有较高的检测准确率,而且能够对花期和花朵姿态朝向进行准确识别,更符合实际场景需求,因此更具有实用性,可为机器人优化授粉控制策略提供依据。

1 TFDC-Net算法

1.1 番茄花朵目标检测

本文基于YOLOv5s算法,提出一种改进的YOLOv5s算法,并用于番茄花朵的目标检测。

1.1.1 YOLOv5s算法原理

YOLOv5s网络可以分为4个部分,分别是输入层,主干网络,颈部网络和输出层。输入层用于输入图片,通过主干网络提取特征[15],随后将特征送到颈部网络进行多尺度融合[16],再将融合特征传入检测层,最后经过非极大值抑制等处理得到置信度得分最高的预测类别以及目标框的位置坐标[17-18]。图1展示了YOLOv5s 5.0目标检测网络的整体框图。

图1 YOLOv5s 5.0网络结构

输入层包括Mosaic(马赛克)数据增强、自适应缩放图片以及自适应计算锚框。Mosaic数据增强即对图片进行裁剪再拼接,并按照网络输入尺寸进行自适应缩放,达到丰富数据集的目的。自适应计算锚框是指通过计算真实框与预测框之间的误差并反向传播,通过不断更新参数得到最合适的锚框值。

主干网络主要包含C3(Concentrated-Comprehensive Convolution Block)模块、空间金字塔池化(Space Pyramid Pooling,SPP)模块[19]以及Focus模块。C3模块是用于特征学习的主要模块,在减少网络计算量的同时增强网络学习能力。SPP模块能将任意尺寸的图片转换成固定大小的图片,以满足网络输入的要求。Focus模块用于对图片进行切片操作和卷积处理,在无信息损失的同时获得采样特征图,并提升训练速度。

颈部网络位于主干网络和输出层的中间,利用它可以进一步提升特征的多样性和鲁棒性。YOLOv5s的颈部网络采用特征金字塔网络(Feature Pyramid Networks,FPN)[20]和路径聚合网络(Path Aggregation Network,PAN)结构,前者从上至下传递语义特征,后者则由下到上传递定位特征。将两者结合,可加强网络特征融合能力,使模型获得更加丰富的特征信息。

输出层用于目标检测结果的输出,包括目标的预测类别、置信度得分、目标框的位置坐标等[21]。

1.1.2 YOLOv5s损失函数

YOLOv5s网络在训练过程中使用损失函数计算误差,包括分类损失函数、置信度损失函数、定位损失函数,通过BP(Back Propagation)算法不断迭代模型,优化参数,以获得最优模型。

YOLOv5s用二元交叉熵损失函数作为分类损失和置信度损失的损失函数。以分类损失为例,其二元交叉熵损失函数如式(1)所示。

式中表示类别总个数,取值为1;y为当前类别预测值经过Sigmoid激活函数后得到的当前类别的概率;y*则为当前类别的真实值(0或1);class为分类损失。

YOLOv5s用CIoU(Complete Intersection over Union)损失函数作为定位损失函数。CIoU通过更多的维度来考量预测框与真实框之间的差异。当真实框和预测框不重叠时,将真实框和预测框中心点欧氏距离的平方与这2个框的最小外接矩形对角线长度的平方之比作为计算定位损失的因素之一。CIoU损失函数如式(2)所示。

式中IoU(,B)表示预测框与真实框的交并比,为预测框和真实框长宽比例差值的归一化参数,是用于平衡比例的参数,和b分别为两框的中心点,表示欧氏距离,表示两框的最小外接矩形的对角线长度,CIoU为定位损失。

1.1.3 不同网络模型性能对比

YOLOv5s是一种单阶目标检测网络,具有模型尺寸小、检测速度快、检测精度高、能有效区分目标与背景等特点。该网络有利于模型的部署,能够实现端到端的实时目标检测,适用于本文对番茄花朵的检测。为验证YOLOv5s检测番茄花朵的优越性,本文用同一番茄花朵数据集在相同条件下训练得到YOLOv5-Lite、YOLOv5n、YOLOv5s、YOLOv5m等番茄花朵检测模型,并采用准确率(Precision,)、召回率(Recall,)、平均精度(Average Precision,AP)、平均精度均值(mean Average Precision,mAP)和模型大小作为衡量模型性能的主要指标,对比结果如表1所示。

表1 不同模型性能对比

注:mAP0.5是IoU(Intersection over Union)阈值为0.5时的平均精度均值,mAP0.5-0.95是在不同IoU阈值下的平均精度均值。

Note: mAP0.5is the average mean accuracy at an IoU threshold of 0.5. mAP0.5-0.95is the average mean accuracy at different IoU thresholds.

YOLOv5s模型的值为0.929,值为0.938,mAP0.5为0.956,mAP0.5-0.95为0.554。其中准确率略低于YOLOv5m的0.932,其余指标都优于其他模型。YOLOv5s模型大小为14.06 MB,高于YOLOv5-Lite的3.30 MB和YOLOv5n的3.83 MB,但是远低于YOLOv5m的41.48 MB。综合考虑,YOLOv5s网络模型针对番茄花朵的目标检测更具优势。

1.1.4 YOLOv5s网络改进

为进一步提升对番茄花朵的检测精度,本文对原网络做了两点改进,一是增加了卷积块注意力模块[22](Convolutional Block Attention Module,CBAM),二是采用了加权框融合(Weighted Boxes Fusion,WBF)方法[23]。

注意力机制广泛应用于视觉识别领域[24]。本文采用的CBAM模块结构如图2所示,包括通道注意力模块(Channel Attention Module,CAM)和空间注意力模块(Spatial Attention Module,SAM)。在CAM模块中,采用全局平均池化和全局最大池化,提取更丰富的高层次特征,再通过2个全连接层和对应的激活函数获取通道之间的关联性,进而将2个输出进行合并获得通道权重,进而将得到的权重与原来的特征进行乘法操作,得到新的特征分布。在SAM模块中,将通过CAM模块得到的(××)维度特征图作为输入,采用2种池化操作,得到2个(××)维度特征图,再采用一个 7×7大小的卷积核进行卷积操作,得到新的(××)维度特征图。最后采用加权操作,将得到的新特征图加权到通道注意力模块特征上,得到经过双注意力模块优化的最终特征图,使得有效特征得到加强,而无效特征得到抑制。

注:CAM,通道注意力模块;SAM,空间注意力模块。

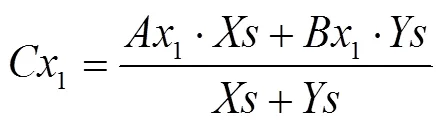

第二点改进是采用WBF方法。在筛选预测框的过程中,常用的方法是非极大值抑制(Non-Maximum Suppression,NMS)[25],其原理是从多个预测框中筛选出置信度最高的预测框。NMS不能有效结合多个预测框来产生一个平均的预测框,而WBF则能够利用多个预测框来构造出融合的预测框,这样能充分利用预测信息得到更准确的结果。WBF先把预测框按照置信度得分高低进行排序,然后通过聚类方法把同一个目标的预测框聚类在一起,再用融合框公式把同一类的预测框做加权融合,得到最终的预测框。融合公式如式(3)~(7)所示,(1,1)、(2,2)和(1,1)、(2,2)分别为融合前两个预测框的左上角和右下角的像素坐标,(1,1)、(2,2)分别为融合后预测框左上角和右下角的像素坐标,、分别为融合前两个预测框的置信度得分,为融合后预测框的置信度得分。

1.1.5 线下数据增强

为减少过拟合现象,提高模型的泛化能力,本文在Mosaic数据增强的基础上进一步采用了线下数据增强。对图像的具体操作包括改变亮度、仿射变换、正负30°旋转、80.0%~95.0%之间图像比例缩放,以及沿轴和轴将图像平移15个像素等。通过线下数据增强可使数据集扩充一倍。

根据修改后的《指南》规定,申请人可根据需要选择不同类型的权利要求撰写形式来寻求专利保护。从权利要求的主题名称来看,涉及硬件装置及其改进的发明专利申请即可以撰写为系统类、装置类的产品权利要求,也可以依据数据流向和处理流程撰写为方法类权利要求。而全部基于计算机程序的软件类专利申请,由于计算机程序天然具有时序性,可以很方便地撰写为方法类权利要求;此外,根据修改后的《指南》规定,还允许撰写为硬件与软件相结合的混合式装置权利要求、与方法权利要求一一对应的“程序模块构架”类的装置权利要求,以及直接以“存储介质”为主题名称的介质类权利要求。以下试以一个具体方案为例加以解释说明。

1.2 番茄花朵的花期分类和姿态识别

本文基于EfficientNetV2[26]网络训练得到花期和姿态分类模型,用于花期分类和花朵姿态识别,以判断是否对目标花朵进行授粉。

EfficientNetV2是谷歌团队在2021年推出的一个新的卷积网络,相比于之前的EfficientNetV1[27]网络,该网络具有更快的训练速度和更好的参数效率。为提高训练速度并保证准确率,该网络引入改进的渐进学习方法,同时还采用Fused-MBConv模块,前者会根据训练图片的尺寸动态调节正则方法,后者能够更好地利用移动端或服务端的加速器,提高训练速度。为减少参数数量,EfficientNetV2采用非均匀缩放策略来缩放模型。因此,EfficientNetV2与EfficientNetV1和NFNet(Normalizer-Free ResNets)系列网络相比,训练速度更快,并且参数数量更少。

本文通过整合番茄花朵目标检测算法、花期分类算法和姿态识别算法,得到TFDC-Net算法。该算法能够从复杂背景中检测出番茄花朵并截取出目标框,然后对截取的花朵依次进行花期分类和姿态识别。TFDC-Net算法原理如图 3所示。

图3 TFDC-Net算法原理

2 试验及结果分析

本文将TFDC-Net算法移植到自主研发的授粉机器人控制系统中,通过TFDC-Net算法完成对番茄花朵的目标检测、花期分类和姿态识别,对处在全开期并且姿态为前的花朵目标进行定位,并控制机械臂完成授粉作业。

2.1 数据收集

本文的番茄花朵数据集采集于安徽东华农科番茄种植基地。总共采集了2 568张番茄花朵的图片,按照8:2的比例划分为训练集和测试集,训练集为2 054张,测试集为514张。在不重标不漏标的原则下,使用LabelImg标注工具对每张图片的目标对象进行标注,将番茄花朵的目标框作为分类网络的数据集。本文把花期分为花蕾期、全开期、谢花期[28]3种,各筛选出789、755、248张图片。3种不同花期的代表性番茄花朵如图4所示。如图5所示,将花朵的姿态按照花蕊的朝向分为前、后、左、右、下5种,各筛选出323、310、315、326、316张图片。

图4 3种不同花期的番茄花朵

图5 5种不同的姿态

2.2 试验设置

本文网络训练硬件环境的CPU为Intel i7 9700 K,GPU为Nvidia RTX 2080Ti,内存为64 G,网络训练框架选用Pytorch,并配有并行计算框架CUDA 10.02和深度学习加速计算库CuDNN7.6.5。根据该硬件环境以及采集到的数据集图片数量,在检测网络训练试验中将Epochs(轮数)设置为400轮,Batch-size(批次大小)设置为8,训练和测试时的图片大小设置为640×480,并采用迁移学习的方法提高训练速度和模型精度;在分类网络训练中将Epochs设置为500轮,Batch-size设置为16,同样采用迁移学习的方法来提高训练速度和模型精度。

2.3 模型性能衡量指标

与目标检测模型有所不同,对于分类网络模型,主要采用准确率和模型大小来评估模型的性能。

2.4 消融试验

本文通过消融试验来对比不同改进模型的性能,结果如表2所示。A_YOLOv5s模型相较于YOLOv5s模型,其准确率和mAP0.5-0.95有所提高,分别达到了0.937和0.588;W_YOLOv5s模型相较于YOLOv5s模型其mAP0.5-0.95提高了0.012;CW_YOLOv5s模型相较于YOLOv5s模型其值提高了0.017,mAP0.5-0.95提高了0.043。在网络改进的基础上再进行数据增强训练得到ACW_YOLOv5s模型,该模型相比于原网络模型YOLOv5s各指标都有提升,值、值、mAP0.5和mAP0.5-0.95分别提高了0.028、0.004、0.012、0.066。此外,各模型大小差别不大,均在14~15 MB之间。总体来说,网络改进以及数据增强均使值有一定程度的提高,平均精度均值也有不同程度的提升,但值总体变化不大。在不同改进模型中,ACW_YOLOv5s模型性能最优。

2.5 目标检测模型性能对比试验

为进一步验证ACW-YOLOv5s模型对番茄花朵的实际检测性能,本文采用该模型与原YOLOv5s模型对目标被部分遮挡、存在小目标、目标数量较多这3种不同复杂情况下的花朵进行识别对比,识别效果如图6所示。YOLOv5s模型存在远处的小目标及被遮挡的目标漏检的情况,并存在重叠目标误检的问题,而本文的ACW-YOLOv5s模型都能准确检测出花朵目标。另外,随机选取8张未经过网络训练的图片对模型进行测试,两个模型的实际检测性能比较如表3所示。8张测试图片中共计38个花朵目标,YOLOv5s模型正确检测出31个,漏检数为7个,而ACW-YOLOv5s模型将全部38个目标正确检测出来。

表2 消融试验结果

注:A表示使用了线下数据增强,C表示增加了CMBA模块,W表示采用了WBF方法。

Note: A indicates adoption of offline data enhancement, C indicates addition of the CMBA module,W indicates application of the WBF method.

图6 复杂情况下模型识别效果图

表3 目标检测模型性能比较

2.6 分类模型训练及测试结果

花期分类网络训练的第308轮得到的模型精度最高,达到了94.5%,模型大小为79.69 MB;姿态分类网络训练的第467轮得到的模型精度最高,达到了86.9%,模型大小为79.70 MB。

为进一步测试花期分类模型的性能,选取了共300张未经网络训练的不同花期花朵图片进行测试,其中花蕾期、全开期、谢花期分别为100张。测试结果如表4所示。由表4可知,花蕾期、全开期、谢花期测试图片的正确识别数分别为95、99、97,识别准确率分别为95.0%、99.0%、97.0%。花期分类模型对3种花期测试图片的识别准确率均为95.0%以上,处于全开期的花朵识别准确率最高,达到了99.0%。300张测试图片的总体识别准确率为97.0%,说明花期分类模型具有较高的准确度。

为测试姿态分类模型的性能,选取了200张未经网络训练的不同姿态花朵图片进行了测试,5种不同姿态花朵图片各40张。测试结果如表4所示。其中花蕊向前、向后、向下、向左、向右的测试图片的正确识别数分别为39、38、33、34、37,识别准确率分别为97.5%、95.0%、82.5%、85.0%、92.5%。姿态分类模型对花蕊朝向为前、后、右的测试图片识别效果较好,这3种姿态测试图片的平均识别准确率为95.0%;而对于花蕊朝向为下和左的测试图片,该模型的平均识别准确率为83.8%,仍有待提高。这200张姿态测试图片的总体识别准确率为90.5%。

表4 花期与姿态分类模型测试结果

通过测试结果可知,花期分类模型和姿态分类模型有较好的分类效果,模型的测试准确率较高,可用于机器人在授粉作业时对花期和姿态的识别和判断。图7给出了一组对番茄花朵的姿态及花期的分类识别测试结果,其中姿态测试图片的分类结果为下(down),置信度为0.852;花期测试图片的分类结果为谢花期,置信度为0.908。

2.7 授粉试验

授粉试验的硬件平台为一台自主研发的授粉机器人,主要由智能移动底盘、升降台、六自由度机械臂、用于接触式授粉的末端执行器、Intel Realsense D435深度相机等部件组成。其中,深度相机不仅用于检测番茄花朵目标并获取其花期和姿态信息,还用于对番茄花朵进行空间定位,即获得目标在机械臂底座坐标系下的真实三维坐标,并把坐标信息反馈给机械臂进行授粉。在不考虑相机畸变的情况下,真实坐标是由目标框中心点的像素坐标及深度信息、相机的内参矩阵以及刚体变换的外参矩阵经过坐标变换得到的。坐标变换如式(12)所示,是目标中心像素点的深度,(,)是像素坐标,f、f、C、C为相机内参,f、f分别为相机方向和方向的焦距,C,C分别为相机方向和方向上的偏移量,、为刚体变换外参矩阵,其中为旋转矩阵,为平移矩阵,(X,Y,Z)是真实坐标。

注:横纵坐标轴为像素;class代表分类结果;prob代表置信度得分。

本文通过张正友相机标定方法[29]得到相机的内参矩阵,通过观察和测量相机坐标系与机械臂底座坐标系的相对位置得到外参矩阵。内参标定结果如表5所示;外参标定结果如式(13)所示。

表5 相机内参

将本文提出的集目标检测、花期分类、姿态识别算法于一体的TFDC-Net模型移植到上述授粉机器人控制系统,在模拟植物工厂条件下,对正处于开花期的番茄花朵进行授粉试验。图8是机器人进行授粉作业时的情形。首先,通过安装在机械臂上的深度相机,寻找并检测出视野内的番茄花朵;与此同时,对花期和花朵姿态进行识别,对处于全开期并且其姿态符合授粉条件的花朵,计算出其空间位置。随后,利用机械臂携带的末端执行器蘸取花粉,对花朵内的花蕊进行接触式授粉。在多达100次的重复性试验中,末端执行器均能与花蕊准确接触,验证了本文提出的TFDC-Net模型的有效性。

3 结 论

针对植物工厂中对番茄花朵授粉作业的自动化和智能化需求,为克服当前机器人在授粉作业过程中因番茄花朵小、姿态朝向各异而导致的检测精度不高和授粉策略不完善等难题,本文提出了TFDC-Net(Tomato Flower Detection and Classification Network)算法,实现了对番茄花朵的目标检测、花期分类及姿态识别。具体如下:

1)针对花朵的单目标检测,本文提出了一种改进的YOLOv5s网络模型ACW_YOLOv5s,通过在YOLOv5s网络中添加卷积块注意力模块(Convolutional Block Attention Module,CBAM)并采用加权框融合(Weighted Boxes Fusion,WBF)方法,使模型的准确率达到0.957,召回率达到0.942,mAP0.5为0.968,mAP0.5-0.95为0.620,各项指标相较于原YOLOv5s网络模型分别提高了0.028、0.004、0.012、0.066,并改善了目标漏检和误检的状况。

2)针对不同花期的花朵以及花蕊不同姿态朝向的授粉问题,采用EfficientNetV2分类网络分别对3种不同花期和5种不同花蕊姿态朝向的花朵进行训练,分别得到花期分类模型及姿态识别模型,通过选取300张花期图片和200张姿态图片对其进行测试,花期分类模型和姿态分类模型的总体准确率分别为97.0%和90.5%。

3)将目标检测算法与花期分类和姿态识别算法进行整合,得到TFDC-Net算法。将其移植到自主研发的授粉机器人中进行试验验证,结果表明,该算法能够实现对番茄花朵的目标检测、花期分类和姿态识别,进而利用机器人机械臂末端的执行器对番茄花朵中的花蕊完成了接触式授粉操作,验证了该算法的有效性。

[1] 王景盛,刘巧英,赵平珊. 日光温室冬春茬番茄振动器授粉效果研究[J]. 蔬菜,2016(4):21-23.

Wang Jingsheng, Liu Qiaoying, Zhao Pingshan. Pollination effect of tomato vibrator in winter and spring crop in solar greenhouse[J]. Vegetable Science, 2016(4): 21-23. (in Chinese with English abstract)

[2] 孙艳军,徐刚,高文瑞,等. 不同授粉方式对日光温室番茄产量、品质及效益的影响[J]. 中国蔬菜,2017(6):38-41.

Sun Yanjun, Xu Gang, Gao Wenrui, et al. Effects of different pollination methods on yield, quality and efficiency of tomato in solar greenhouse[J]. China Vegetables, 2017(6): 38-41. (in Chinese with English abstract)

[3] Mao S H, Li Y H, Ma Y, et al. Automatic cucumber recognition algorithm for harvesting robots in the natural environment using deep learning and multi-feature fusion[J]. Computers and Electronics in Agriculture, 2020(170): 105254.

[4] 王新忠,韩旭,毛罕平. 基于吊蔓绳的温室番茄主茎秆视觉识别[J]. 农业工程学报,2012,28(21):135-141.

Wang Xinzhong, Han Xu, Mao Hanping. Vision-based detection of tomato main stem in greenhouse with red rope[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2012, 28(21): 135-141. (in Chinese with English abstract)

[5] 崔明,陈仕雄,李民涛. 基于图像处理的草莓花朵识别算法研究[J]. 数字技术与应用,2019,37(12):109-111.

Cui Ming, Chen Shixiong, Li Mintao. Research on strawberry flower recognition algorithm based on image proc-essing[J]. Digital Technology and Application, 2019, 37(12): 109-111. (in Chinese with English abstract)

[6] Jason G, Yong-Lak P, Xin L, et al. Design of an Autonomous Precision Pollination Robot[C]. 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS 2018), Madrid(ES), 2018: 7711-7718.

[7] 张凡,张鹏超,王磊,等. 基于YOLOv5s的轻量化朱鹮检测算法研究[J]. 西安交通大学学报,2023(1):1-12.

Zhang Fan, Zhang Pengchao, Wang Lei, et al. Research on lightweight ibis detection algorithm based on YOLOv5s[J]. Journal of Xi'an Jiaotong University, 2023(1): 1-12. (in Chinese with English abstract)

[8] 樊湘鹏,许燕,周建平,等. 基于迁移学习和改进 CNN的葡萄叶部病害检测系统[J]. 农业工程学报,2021,37(6):151-159.

Fan Xiangpeng, Xu Yan, Zhou Jianping, et al. Detection system for grape leaf diseases based on transfer learning and updated CNN[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(6): 151-159. (in Chinese with English abstract)

[9] 林景栋,吴欣怡,柴毅,等. 卷积神经网络结构优化综述[J].自动化学报,2020,46(1):24-37.

Lin Jingdong, Wu Xinyi, Chai Yi, et al. Structure optimization of convolutional neural networks: A survey[J]. Acta Automatica Sinica, 2020, 46(1): 24-37. (in Chinese with English abstract)

[10] Williams H, Nejati M, Hussein S, et al. Autonomous pollination of individual kiwifruit flowers: Toward a robotic kiwifruit pollinator[J]. Journal of Field Robotics. 2020, 37: 246–262.

[11] Dias P A, Tabb A, Medeiros H. Apple flower detection using deep convolutional networks[J]. Computers in Industry, 2018, 99:17-28.

[12] Tian M, Chen H, Wang Q. Detection and recognition of flower image based on SSD network in video stream[J]. Journal of Physics Conference Series, 2019, 1237: 32-45.

[13] Yuan T, Zhang S, Sheng X, et al. An autonomous pollination robot for hormone treatment of tomato flower in greenhouse[C]. 2016 3rd International Conference on Systems and Informatics (ICSAI). Shanghai, China, 2016: 108-113.

[14] 岑海燕,朱月明,孙大伟,等. 深度学习在植物表型研究中的应用现状与展望[J]. 农业工程学报,2020,36(9):1-16.

Cen Haiyan, Zhu Mingyue, Sun Dawei, et al. Current status and future perspective of the application of deep learning in plant phenotype research[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(9): 1-16. (in Chinese with English abstract)

[15] 高明华,杨璨. 基于改进卷积神经网络的交通目标检测方法[J]. 吉林大学学报(工学版),2021,45(5):1-9.

Gao Minghua, Yang Can. Traffic target detection method based on improved convolutional neural network[J]. Journal of Jilin University (Engineering and Technology Edition), 2021, 45(5): 1-9. (in Chinese with English abstract)

[16] Zhu L, Geng X, Li Z, et al. Improving YOLOv5 with attention mechanism for detecting boulders from planetary images[J]. Remote Sensing, 2021, 13(18): 152-161.

[17] 高云鹏. 基于深度神经网络的大田小麦麦穗检测方法研究[D]. 北京:北京林业大学,2019:1-68.

Gao Yunpeng. Research on Wheat Ear Detection Method Based on Deep Neural Network in Field[D]. Beijing: Beijing Forestry University, 2013: 1-68. (in Chinese with English abstract)

[18] 马永康,刘华,凌成星,等. 基于改进YOLOv5的红树林单木目标检测研究[J]. 激光与光电子学进展,2022,59(18):436-446.

Ma Yongkang, Liu Hua, Ling Chengxing, et al. Research on mangrove single wood target detection based on improved YOLOv5[J]. Laser and Optoelectronics Progress, 2022, 59(18): 436-446. (in Chinese with English abstract)

[19] He K, Zhang X, Ren S, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916.

[20] Lin T Y, Dollár P, Girshick R, et al. Feature pyramid networks for object detection[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Honolulu, HI, USA, 2017: 936-944.

[21] 杨其晟,李文宽,杨晓峰,等. 改进YOLOv5的苹果花生长状态检测方法[J]. 计算机工程与应用,2022,58(4):237-246.

Yang Qisheng, Li Wenkuan, Yang Xiaofeng, et al. Improved YOLOv5 method for apple blossom Growth state detection[J]. Computer Engineering and Application, 2022, 58(4): 237-246. (in Chinese with English abstract)

[22] Woo S, Park J, Lee J Y, et al. CBAM: Convolutional Block Attention Module[C]. Proceedings of the 2018 European Conference on Computer Vision, 2018: 3-19.

[23] Roman S, Weimin W, Tatiana G. Weighted boxes fusion: Ensembling boxes from different obj-ect detection models[J]. Image and Vision Computing, 2021(107): 104117.

[24] 张连超,乔瑞萍,党祺玮,等. 具有全局特征的空间注意力机制[J]. 西安交通大学学报,2020,54(11):129-138.

Zhang Lianchao, Qiao Ruiping, Dang Qiwei, et al. Spatial attention mechanism wi-th global features[J]. Journal of Xi'an Jiaotong University, 2020, 54(11): 129-138. (in Chinese with English abstract)

[25] Neubeck A, van Gool L. Efficient non-maximum suppressi-on[C]. 18th Intern-ational Conference on Pattern Reco-gnition (ICPR'06). Hong Kong: IEEE, 2006, 3: 850-855.

[26] Tan M X. Quoc V. L. EfficientNetV2: Smaller Models and Faster Training[C]. Proceedings of the 38th International Conference on Machine Learning, PMLR, 2021:10096-10106.

[27] Tan M X, Quoc V L. EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks[C]. Proceedings of the 36 th International Conference on Machine Learning, Long Beach, California, PMLR, 2019,1905:11946.

[28] 赵春江,文朝武,林森,等. 基于级联卷积神经网络的番茄花期识别检测方法[J]. 农业工程学报,2020,36(24):143-152.

Zhao Chunjiang, Wen Chaowu, Lin Sen, et al. Identification and detection method of tomato flowering period based on cascade convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(24): 143-152. (in Chinese with English abstract)

[29] Zhang Z. A flexible new technique for camera calibration[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(11): 1330-1334.

Deep learning-based target recognition and detection for tomato pollination robots

Yu Xianhai1, Kong Deyi2,3※, Xie Xiaoxuan2,3, Wang Qiong2,3, Bai Xianwei2,3

(1.,,230601,;2.,()230031,; 3.,,230009,)

Intelligent pollination of tomatoes has been widely used in plant factories in modern agriculture in recent years. However, the low detection accuracy cannot fully meet the needs of large-scale production during robotic pollination. The imperfect pollination strategies can also be caused by the small flowers and different posture orientations in the pollination robots. In this study, tomato flower detection and classification were proposed to combine target detection, flowering classification, and posture recognition using deep learning. According to the characteristics of tomato flowers, the tomato flower detection and classification network (TFDC-Net) were also divided into two parts: The target detection of tomato flowers, and the flowering pose classification of flowers. In flower detection, the YOLOv5s network was selected to improve the target detection accuracy. Two improvements were proposed for the network structure: firstly, a Convolutional Block Attention Module (CBAM) was added to enhance the effective features but suppress the invalid ones, and secondly, a Weighted Boxes Fusion (WBF) approach was adopted to fully use the prediction information. The network was then trained using offline data augmentation to obtain the ACW_YOLOv5s model, indicating an accuracy of 0.957, a recall of 0.942, a mAP0.5of 0.968, and a mAP0.5-0.95of 0.620, with each index improving by 0.028, 0.004, 0.012, and 0.066, respectively, compared with the original. The actual detection performance of the model was verified for the tomato flowers. The original YOLOv5s model was selected to compare with the recognition of flowers under different complex situations. The tests show that the ACW_YOLOv5s model was used to better treat the missed detection of small distant targets, obscured targets, and false detection of overlapping targets that exist in the original YOLOv5s. At the same time, the better pollination of flowers was realized under the various flowering stages and different stamen orientations. EfficientNetV2 classification network was used to train three flowering stages and five postures of flowers, in order to obtain the flowering stage classification model and posture recognition model, respectively, indicating accuracy of 94.5%, and 86.9%, respectively. Furthermore, 300 flowering and 200 gesture images were selected to further validate the performance of the classification model. The overall accuracies were 97.0%, and 90.5%, respectively, for the flowering and gesture classification models. The TFDC-Net was obtained to integrate the ACW_YOLOv5s target detection, the flowering, and the posture classification model. As such, the detection of tomato flowers and the classification of flowering pose fully met the vision requirements of pollination robots. The TFDC-Net was also applied to the self-developed pollinator robot. It was found that the TFDC-Net was used to implement the target detection, flowering classification, and pose recognition of flowers. The target was then localized using coordinate conversion. The true 3D coordinates of the target were obtained in the coordinate system of robot arms. The feedback was received in the robot arm for the pollination of the target in full bloom with a front attitude. This finding can provide a technical basis for the target detection and localization of pollination robots.

deep learning; neural networks; target detection; flower classification; gesture recognition; pollination robot

10.11975/j.issn.1002-6819.2022.24.014

TP391.4

A

1002-6819(2022)-24-0129-09

余贤海,孔德义,谢晓轩,等. 基于深度学习的番茄授粉机器人目标识别与检测[J]. 农业工程学报,2022,38(24):129-137.doi:10.11975/j.issn.1002-6819.2022.24.014 http://www.tcsae.org

Yu Xianhai, Kong Deyi, Xie Xiaoxuan, et al. Deep learning-based target recognition and detection for tomato pollination robots[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(24): 129-137. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2022.24.014 http://www.tcsae.org

2022-10-10

2022-12-13

安徽省科技重大专项资助(202203a06020002)

余贤海,研究方向为机器视觉与图像处理。Email:1399310012@qq.com

孔德义,博士,研究员,研究方向为农业机器人、仿生机器人等。Email:kongdy@iim.ac.cn