混合动力电动汽车能量管理技术研究综述

何洪文,孟祥飞

(1. 北京理工大学 电动车辆国家工程研究中心, 北京 100081;2. 北京理工大学 机械与车辆学院, 北京 100081)

以化石能源为基础的交通运输系统是造成石油生产需求增加、汽油价格升高以及气候变化的重要原因[1]. 为了改善上述问题,高效、安全、清洁的新型动力系统以及先进的节能控制技术已经成为环境和交通领域最关注的研究主题. 混合动力系统装载具有不同工作特性的动力源并包含至少一种清洁动力源,是一种行之有效的环境友好型解决方案[2].

能量管理策略(energy management strategy, EMS)是混合动力汽车的核心技术. 其主要任务是根据车辆的动力需求、动力系统的运行状态以及不同动力源在工作效率、瞬态响应特性、负载能力等方面的差异协调不同动力源之间的动力分配. 目的是实现包括燃料消耗、污染物排放、驾驶机动性以及动力源使用寿命在内的单目标或多目标优化. 然而,由于动力系统复杂的非线性结构、驾驶工况的不确定性以及在线应用过程的实时性要求,开发高效且自适应的EMS 是一项挑战性极高的任务[3]. 在过去十年左右的时间里,人们对能量管理技术进行了大量的研究.这不仅针对传统的油电混合动力系统,还包括燃料电池电动汽车,以及超级电容混合动力汽车等车型所搭载的新型混合动力系统.

本文作者旨在通过对现有文献的回顾以及对相关关键技术的总结促进能量管理技术的发展. 具体工作内容包括:首先,概述了各种机电耦合系统的拓扑结构以及运行特点. 其次,从各项研究所基于的理论基础出发,对现有的能量管理方法进行分类. 结合各类方法的控制原理、技术优势、技术缺陷对能量管理技术的最新研究进展进行系统地调查. 最后,结合电动化、智能化、网联化的技术发展趋势,展望智能网联环境下能量管理技术可能的研究方向.

1 机电耦合系统构型分析

根据能量耦合方式的差异,混合动力系统可以被分为电耦合系统、机械耦合系统、机械-电耦合系统三种类型. 本章主要介绍各种机电耦合系统的拓扑结构与运行特点.

1.1 电耦合动力系统

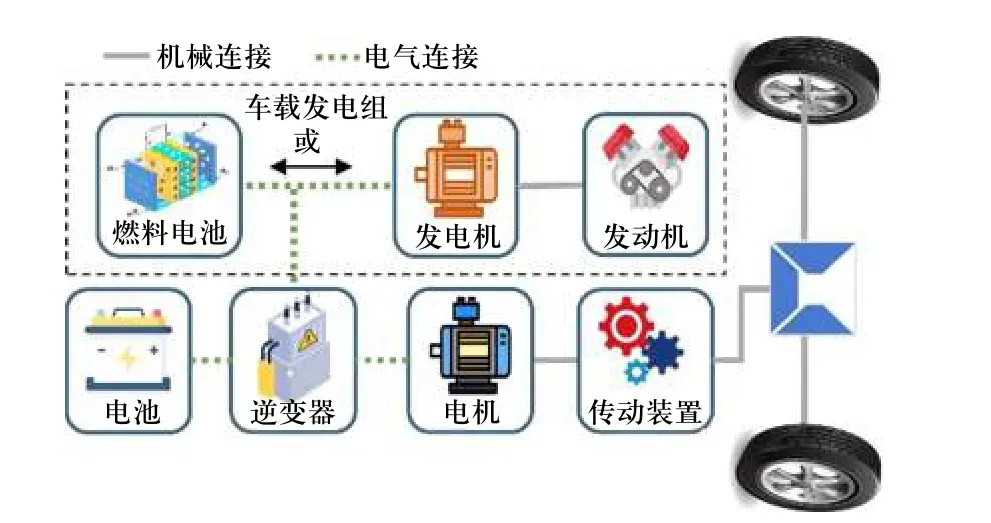

电耦合动力系统如图1 所示,通过电耦合器(一般为功率逆变器)实现来自动力电池与车载发电组的电功率耦合. 常见的车载发电组包括由内燃机(internal combustion engine, ICE)-发电机组成的辅助功率单元(auxiliary power unit, APU)、燃料电池(fuel cell,FC)、或者能量型动力电池等具有高能量密度的动力源. 车载发电组与驱动轮之间不存在机械连接,对于APU 而言,可以将ICE 的工作点控制在最佳效率区域内,改善ICE 的工作与排放效率;对于FC 系统而言,除了可以优化燃料电池的工作效率,还可以避免大功率变化率、怠速、过载等不利于FC 使用寿命的工况.

图1 电耦合动力系统Fig. 1 Electrical coupled powertrain

1.2 机械耦合动力系统

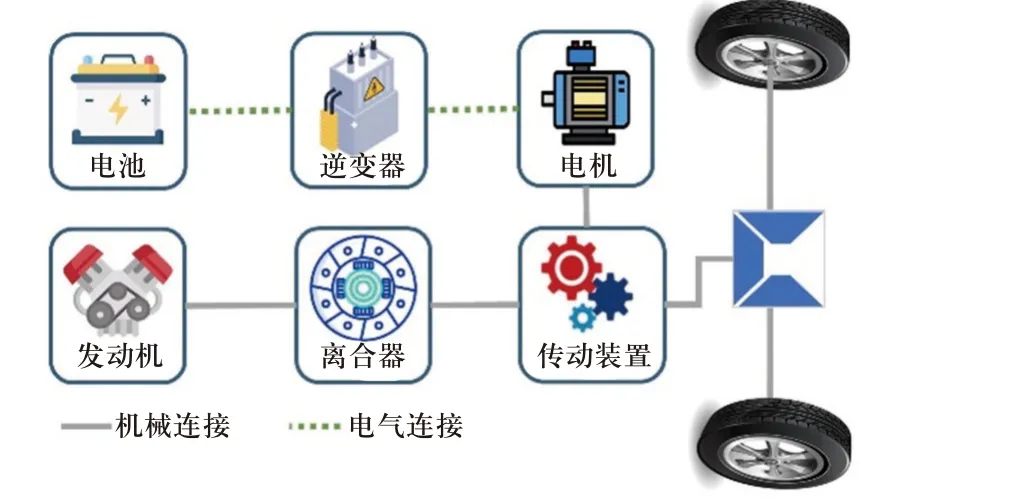

机械耦合动力系统的显著特征是通过机械耦合装置将电动机与内燃机的机械动力共同传输给驱动轮,其结构简图如图2 所示. 由于ICE 和电动机都可以直接向驱动轮输出驱动力,机械耦合系统的能量损耗比电耦合更低. 但由于功率守恒条件的约束,机械耦合系统只能实现单一的转矩或转速耦合,ICE无法始终工作在最佳燃油消耗区.

图2 机械耦合动力系统Fig. 2 Mechanical coupled powertrain

1.3 机械-电耦合动力系统

机械-电耦合动力系统的显著特征是同时使用了两种功率耦合器. 如图3 所示,由于同时实现了ICE和驱动轮之间转速和转矩的解耦,发动机工作点不再受车辆的负载转矩和车速的制约. 另外,部分发动机功率可以直接传递至驱动轴,而无需其他形式的动力转换,因此具有较高的综合能源转换效率. 但另一方面,机械-电耦合多源动力系统结构更加复杂,成本与控制难度普遍较高.

图3 机械-电耦合动力系统Fig. 3 Mechanical-electrical coupled powertrain

2 能量管理技术的研究进展

2.1 能量管理技术概述与分类

EMS 的主要目标是通过对动力系统操作模式与功率分配的控制,实现关于燃油经济性、污染物排放、驾驶性能,以及储能系统健康状态的单目标或多目标优化. 在过去十年左右的时间里,人们发表了大量以能量管理技术为主题的研究. 如图4 所示,文中将这些方法分为三种类型:基于规则、基于优化、以及基于学习的方法. 需要强调的是,由于各类方法存在各自的优缺点,可以通过不同方法之间的协同工作实现更好的控制效果,因此各类方法之间并不是完全独立的.

图4 能量管理技术分类Fig. 4 Classification of energy management strategies

2.2 基于规则的能量管理策略

基于规则的能量管理策略(rule based energy management strategy, RB-EMS)通过人类的直觉或专业知识定义控制规则. 这类方法对控制器的算力要求较低且易于实现,是目前实车应用最成熟的控制方法.然而RB-EMS 也存在缺乏最优性、需要大量的参数校准以及对于驾驶环境、动力系统架构的适应能力不足等问题. 文中将RB-EMS 进一步分为基于确定性规则的控制策略和基于模糊规则的控制策略.

2.2.1 基于确定性规则的能量管理策略

确定性控制策略根据设计者的“专家经验”制定控制规则,在满足车辆动力需求的前提下实现系统工作模式的切换与多动力源之间的功率分配. 例如,电能消耗-电能维持(charging deplete-charging sustain,CD-CS)策略的控制逻辑如图5 所示. 常见的方法还包括恒温器控制策略[4-6]、功率跟随控制策略[7-9]以及有限状态机控制策略[10-12].

图5 CD-CS 控制策略Fig. 5 The logic structure of CD-CS

近些年,人们将低通滤波器[13-15]以及小波变换等方法[16-18]引入能量管理技术,目的是实现动力源之间的频率解耦控制. 实验结果表明,相关方法可以在满足车辆动力需求的前提下控制慢动态的能量源(ICE 或FC)提供基本/低频功率,快动态的能量源(动力电池或超级电容)提供峰值/高频功率. 真实驾驶环境下整车需求功率具有极高的不确定性,而频率解耦控制可以有效降低瞬态/峰值功率对动力系统(尤其是燃料电池)造成的损害.

2.2.2 基于模糊规则的能量管理策略

系统数字化模型的建模精度是影响策略有效性的关键因素之一. 然而,对于包括混合动力系统在内的动态系统,精确地建立对应的数学模型是十分困难的. 模糊控制在多域、时变、非线性的控制问题中具有较好的鲁棒性与自适应性,因此被广泛用于车辆的能量管理问题.

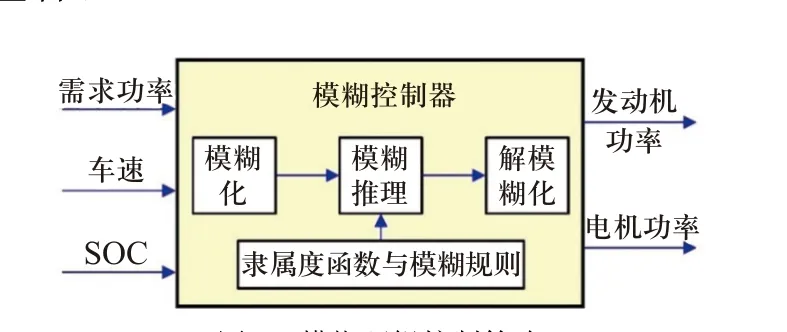

从控制系统的架构来看,可以将模糊控制策略分为单模糊控制器策略和多模糊控制器策略. 单模糊控制器策略[19]通常以整车需求功率、动力电池组SOC 以及实时车速为状态变量,发动机/电机输出功率为动作变量,通过输入量化-模糊化-模糊推理-解模糊化-输出量化完成对能量流的鲁棒控制,其结构简图如图6 所示. 多模糊控制器策略通常基于模糊逻辑实现对激进、普通、保守等模糊概念的描述以识别驾驶员的驾驶风格[20-22],或进行驾驶意图[23-25]以及驾驶工况类型[26-28]的识别. 将识别结果作为功率分配控制器的输入,实现基于多模糊逻辑的自适应能量管理.

图6 模糊逻辑控制策略Fig. 6 Schematic diagram of fuzzy logic strategy

另外,隶属度函数和模糊规则是影响模糊控制有效性的关键因素. 为此,许多学者基于遗传算法[29-30]、粒子群优化等[31-32]最优化方法调整控制器的隶属度函数与模糊规则. 这类研究属于模糊控制与优化控制的集成方法,最优性的本质是由于最优化算法对控制参数的优化,基于“专家经验”开发的模糊策略很难达到最优的控制性能.

2.3 基于优化的控制策略

在满足动态状态约束的前提下,基于优化的控制策略(optimization based energy management strategy,OB-EMS)基于最优化方法求解最小化成本函数的控制动作序列. 根据对先验知识和信息的依赖程度,本节将OB-EMS 进一步分为离线优化控制策略和在线优化控制策略.

2.3.1 离线优化控制策略

在全局工况信息已知的前提下,离线优化控制策略首先将控制问题离散化,再应用最优化方法求解固定驾驶循环下的最优控制动作. 常见的离线优化方法有动态规划(dynamic, programming, DP)、庞特里亚金最小化原理(pontryagin's maximum principle, PMP)以及遗传算法(genetic algorithm, GA)、粒子群优化(particle swarm optimization, PSO)和模拟退火(simulated annealing, SA)等元启发式搜索方法.

PMP 的核心思想是将约束条件下的全局优化问题转化为基于哈密顿函数的局部极小化问题. 例如,SCHMID 等基于PMP 实现HEVs/PHEVs 的EMS 优化[33-35]. BERNARD 等将PMP 应用于FCEV 的能量管理任务中,实现氢燃料消耗以及运行成本的最小化控制[36-38]. DU 等以高能量密度磷酸铁锂电池与超级电容器组成的多源动力系统为被控对象,基于PMP算法实现动力电池降解和生命周期成本的最小化[39].

DP 是离线优化策略中最具代表性的算法. 其基本原理是将复杂问题分解为一系列结构相似且相对简单的子问题,再对所有子问题进行遍历寻优. YU等[40]基于DP 算法实现给定工况下全局最优的动力系统综合工作效率,同时保持动力电池与超级电容的电量平衡. SANTUCCI 等[41]以延缓蓄电池-超级电容多源动力系统的电池老化为目标,设计了基于DP的能量管理策略.

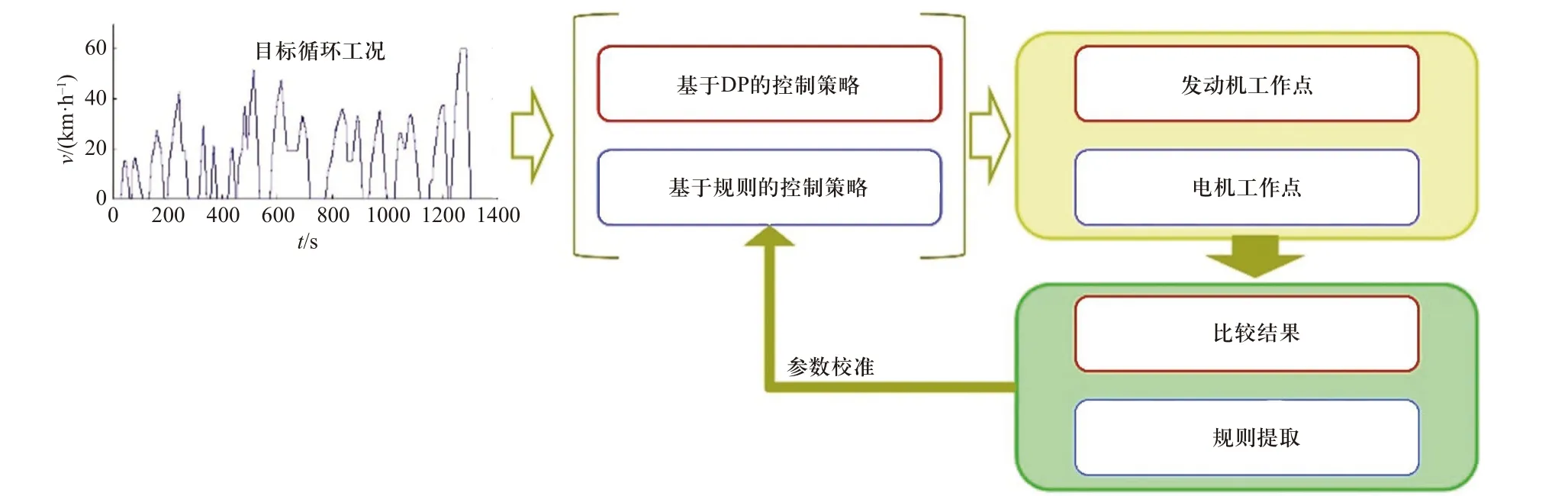

然而,实际驾驶环境具有极强的随机性与不确定性,获取整个驾驶工况的准确信息是十分困难的.且全局优化算法对计算单元提出了很高的算力要求,因此很难直接应用于能量管理的实时控制. 在现有的研究中,离线优化多用作其他方法的最优性基准,协助在线控制策略的改进[42-43]. 此外,也有一些研究者通过提取离线优化策略的控制参数提高RB-EMS的控制性能. 例如,PENG 等[44]提出了如图7 所示的基于动态规划的规则型控制策略参数校准方法,并基于半实物仿真实验验证该方法的有效性. 但基于离线优化算法得到的控制参数只能在特定的驾驶循环中表现出较高的水平,对驾驶环境的变化极为敏感.

图7 基于动态规划的规则型策略参数校准Fig. 7 Dynamic programming-based parameter recalibration of the rule-based strategies

2.3.2 在线优化控制策略

与离线优化方法不同,在线优化控制策略追求的是有限计算时间与内存资源下的在线优化能力.因此,在线优化策略通常以瞬时燃油消耗或未来几秒内的燃油消耗为优化目标. 典型的方法包括模型预测控制(model predictive control, MPC)策略和等效消耗最小化策略(equivalent consumption minimization strategy, ECMS).

基于对驾驶工况的预测信息,MPC 将整个行驶工况内的全局优化问题转化为预测时域内的局部优化问题. 同时,结合最优化方法与反馈校正的机制实现预测时域内能量管理问题的滚动优化. 根据预测模型的不同,可以将MPC 分为基于指数变化的MPC[45-46]、基于马尔科夫链的MPC[47-48]以及基于神经网络的MPC[49-50]. 常见的求解方法包括动态规划、连续广义最小残差方法、非线性规划以及庞特里亚金最小原理等. 与离线优化算法相比,MPC 可以更好地处理实际工况的不确定性,具有良好的动态控制能力与鲁棒性.

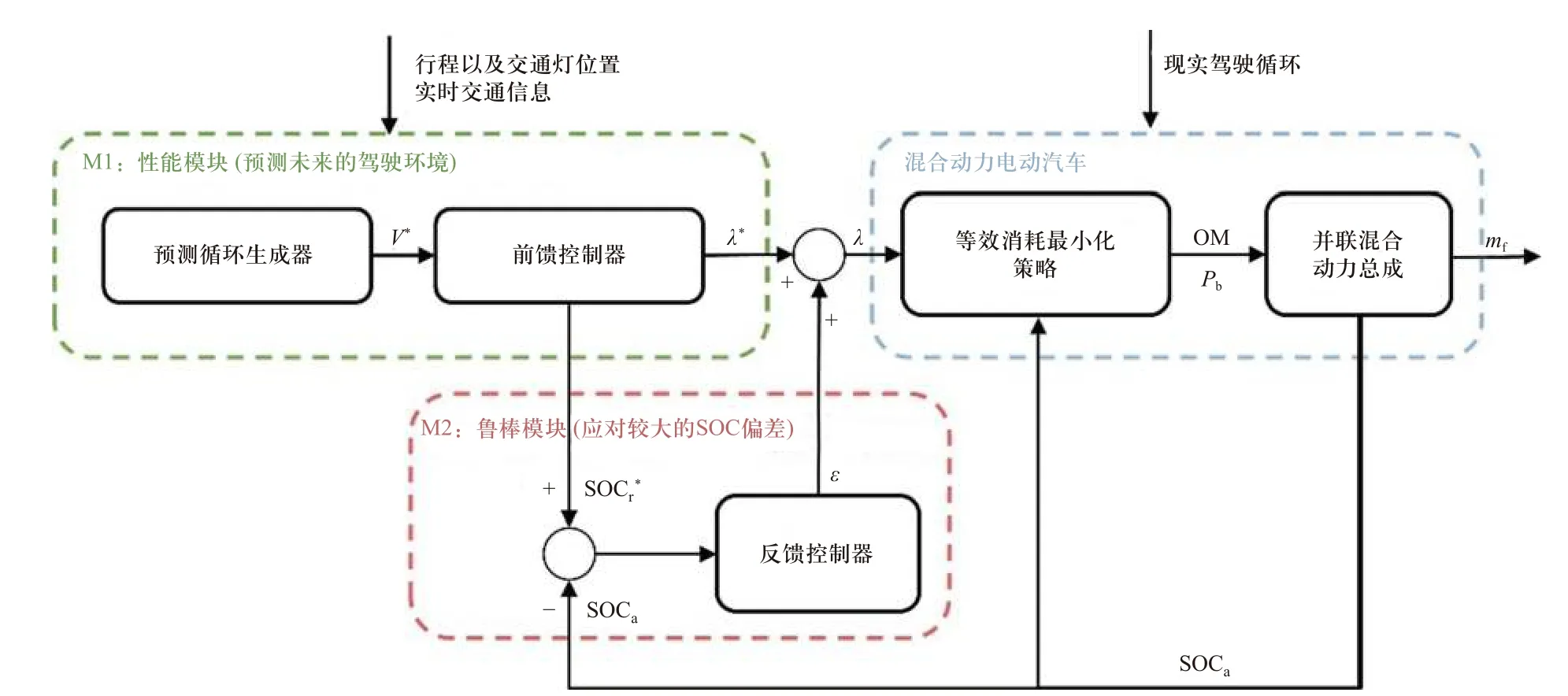

ECMS 将电机消耗的电能转化为等效的燃油消耗,再通过最小化综合燃油消耗实现能量管理的优化. 但不足之处在于策略的优劣严重依赖于等效因子(equivalent factor, EF),对工况的敏感性较大. 为了保证ECMS 的有效性,人们提出了大量EF 估计方法,大致可以分为离线估计和在线估计2 大类. 离线EF估计方法基于全局优化算法搜索整个驾驶周期内固定的最优EF,但需要预知给定驾驶周期的全部信息[51-53]. 在线EF 估计方法基于PI[54]以及非线性反馈控制[55]在离线EF 的基础上进行在线修正, 这有利于提高ECMS 对时变驾驶环境的适应能力. 在文献[56]中,Bouwman 等将ECMS 策略与基于MPC 的控制框架相结合,提出一种融合交通信息预测ECMS 控制策略. 如图8 所示,该模型主要由性能模块和鲁棒性模块组成. 在性能模块中,预测循环生成器根据交通流数据,交通灯位置等信息生成距离索引的未来车速曲线. 前馈控制器基于蒙特卡罗方法优化预测区间内的参考等效因子λ*与SOC 参考值 SOC∗r. 鲁棒性模块根据SOC 参考值与实际值在线调节等效因子的修正系数ɛ,目的是降低不准确的预测结果对策略最优性的影响.

图8 预测ECMS 策略示意图Fig. 8 Schematic diagram of the predictive ECMS strategy

然而,随着约束条件、模型精度以及问题离散化程度的增加,在线优化策略的计算量也会呈现指数型增加的变化趋势.

2.4 基于学习的控制策略

随着大数据、人工智能与计算机技术的发展,机器学习(machine learning, ML)被积极地应用于能量管理问题中,为突破传统方法的限制提供了研究思路. 与上述方法不同的是,基于学习的控制策略(learning based energy management strategy, LB-EMS)既不依赖设计者的“专家经验”定义控制规则,也不依赖被控对象的数字化模型计算最优控制动作. 而是基于先进的数据挖掘方法与大量的历史/实时经验数据获得预测结果或控制策略. 如图9 所示,文中根据学习方式的不同将ML 分为监督学习、非监督学习以及强化学习3 大类.

图9 机器学习方法Fig. 9 Machine learning methods

2.4.1 监督学习

监督学习以事先定义的特征数据与目标数据作为训练集,基于这种已知的组合关系训练最优控制模型,目的是使模型具有一定的预测以及分类识别能力. 因此,监督学习可以被进一步分为回归监督学习和分类监督学习.

回归监督学习通常被集成在基于MPC 的控制框架中,用于实现车速、发动机转矩以及动力电池功率等信息的预测. SUN 等[57]对广义的指数变化、马尔可夫链,以及基于神经网络的预测器进行了比较.结果表明,神经网络预测器在一系列验证和真实驾驶循环中提供了最佳的整体性能. 其中,径向基函数神经网络优于对时间序列问题有效的递归神经网络和反向传播神经网络.

分类监督学习普遍用于驾驶模式、车辆工作模式以及驾驶工况类型的分类与识别,目的是辅助实现自适应的能量管理控制. 例如,WU 等[58]提出了一种基于驾驶工况识别的模糊控制策略. 如图10 所示,驾驶工况识别模型基于车辆行程参数识别当前的驾驶循环,并将识别结果传递给模糊转矩分配模型. 同时基于PSO 方法对不同驱动循环下模糊控制器的隶属度函数与模糊规则进行优化,以改善燃油经济性.

图10 基于驾驶工况识别的模糊逻辑控制Fig. 10 Driving cycle recognition based fuzzy logic control

2.4.2 无监督学习

与监督学习相对应,无监督学习的主要功能是在探索性数据分析阶段发现隐藏的模式或者对数据进行分组. 在车辆能量管理领域,无监督学习主要用于驾驶循环的分类或数据降维,辅助完成高效的控制策略开发.

例如,GRELLE 等[59]使用c-均值聚类方法对数据库中的元素进行分组,这些元素包含标准行驶循环中的最佳混合程度以及车辆的状态向量,如车速、电池SOC、催化剂温度以及ICE 温度. MONTAZERI等[60]对真实交通条件下的驾驶周期进行数据采集,基于聚类算法进行驾驶特征识别并实现对驾驶周期的分类,提高了能量管理策略的效率. FINESSO 等[61]基于聚类算法开发了一种无监督机器学习技术,识别基于规则的最优策略. VENDITTI 等[62]使用相似的方法提取并联HEV 的控制策略.

2.4.3 强化学习

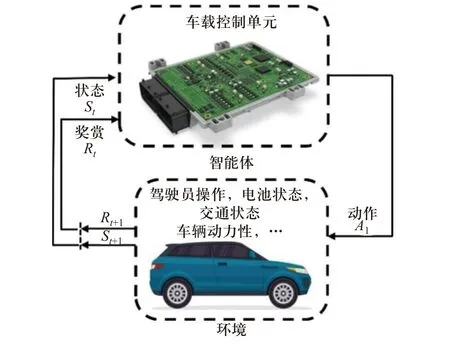

强化学习(reinforcement learning, RL)是基于智能体与环境的持续交互实现策略优化的一种机器学习方法. 如果智能体的行为导致了环境对智能体的积极奖励,那么这种动作被再次采取的趋势就会有所增加. 反之,产生消极惩罚的行为在未来被采取的概率会被降低. 因此,除了智能体和环境两个交互对象之外,强化学习还包括状态、奖励与动作3 个关键要素. 如图11 所示,在能量管理问题中,动力系统燃油经济性模型、动力电池衰退模型以及交通条件通常被定义为环境,控制器内部的优化算法与映射关系被定义为智能体.

图11 基于强化学习的能量管理策略Fig. 11 Reinforcement learning based EMS

与其他方法最大的差异在于,强化学习可以实现无模型的策略寻优. 因此,这类方法不会像优化型算法那样高度依赖数字化模型的建模精度. 此外,收敛后的强化学习模型可以直接根据状态到动作的最优映射关系完成能量管理,避免了基于数字化模型的在线计算,因此具有巨大的在线应用潜力[63]. 由于上述原因,强化学习成为了近些年能量管理领域的研究热点. 例如,YUE 等[64]采用时序差分(temporal difference, TD)方法处理超级电容-锂电池复合电源纯电动汽车的能量管理问题. FANG 等[65]基于TD 方法与历史工况数据优化混联式公交车的燃油经济性和排放特性,并在ADVISOR 环境下进行仿真验证.QI 等[66]在基于Q-learning 的能量管理方法中加入电池SOC 保持功能. LIU 等[67-68]和 ZOU 等[69]对基于RL 的能量管理策略进行了大量的研究,并全面评估了Q-learning、Dyna 等算法在能量管理问题中的优化能力和训练成本.

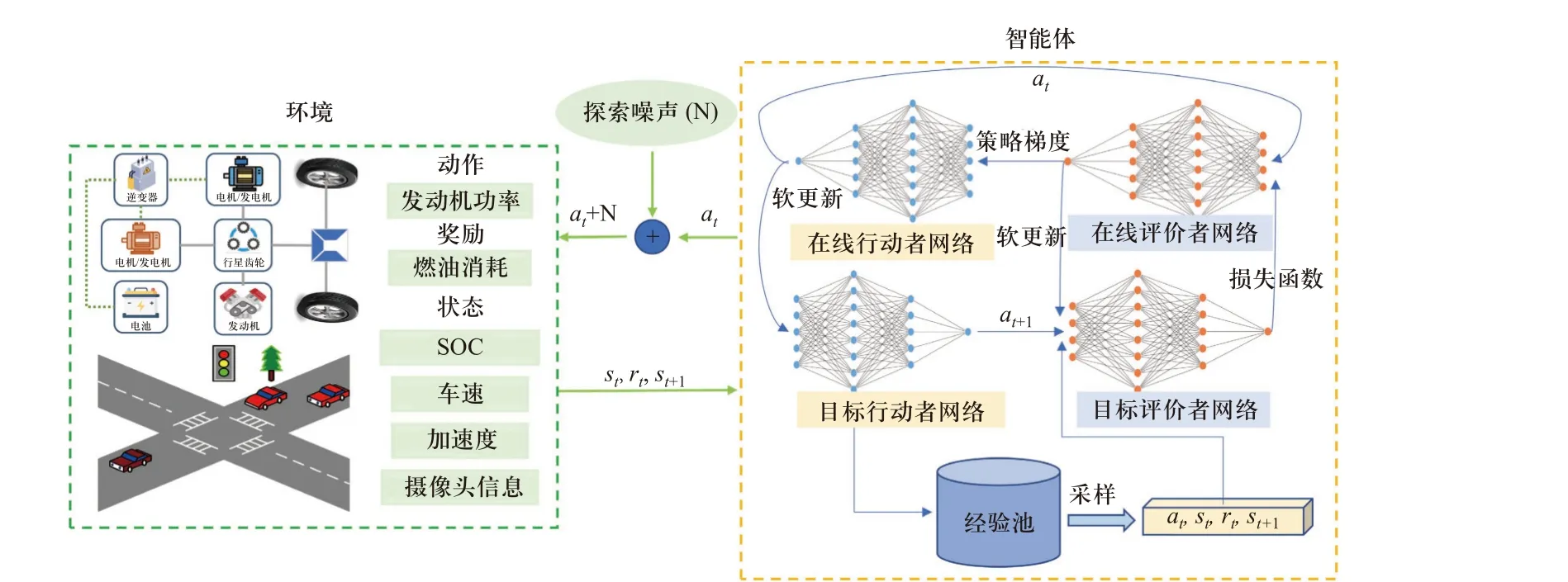

然而,经典强化学习方法通过低维的离散化表格表征控制策略. 这会带来“维数灾难”的限制,具体表现为随着环境状态的维数或策略离散化精度的提高,控制模型所需的存储空间和计算时间呈现指数级增长的变化趋势. 深度强化学习(deep reinforcement learning, DRL)基于深度神经网络(deep neural network, DNN)拟合策略的价值函数或策略本身,是解决相关问题的有效方法. 在最近的研究中,WU 等[70]将DQL 算法应用于并联式HEV 的能量管理问题中,结果表明DQL 在训练时间和收敛速度上都优于Qlearning 方法. LI 等[71]对深对深度确定性策略梯度(deep deterministic policy gradient, DDPG)方法与动态规划、MPC 方法进行比较. 结果表明,基于DDPG 的EMS 与基于DP 的全局优化结果相差3.5%,优于预测结果准确的MPC. WANG 等[72]提出了一种结合计算机视觉的能量管理模型. 如图12 所示,他们利用基于卷积神经网络的目标检测方法提取车载摄像头的视觉信息. 并将检测结果作为DDPG 模型的状态变量. 综合工况的测试结果表明,视觉信息可以帮助EMS 节省4.3%~8.8%的燃油消耗,所提出的方法可以达到全局最优结果96.5%的燃油经济性.

图12 基于DDPG 与计算机视觉的能量管理策略Fig. 12 DDPG with computer vision based EMS

3 结论与展望

文中全面总结了混合动力电动汽车的机电耦合系统和能量管理技术的最新研究进展,对现有的能量管理技术进行了系统的分类和比较. 在各类能量管理方法中,基于规则的方法对控制器的算力要求较低且易于实现,但需要大量的人工参数校准工作,并且策略的最优性与适应性较差. 基于优化的控制策略可以达到全局最优或接近全局最优的控制效果,但需要基于被控对象的数字化模型进行大量的计算,存在最优性与计算时长的矛盾. 基于学习的方法通过先进的数据挖掘技术与大量的历史/实时经验数据挖掘输入到输出的最优映射关系,是近些年能量管理领域的研究热点. 其中监督学习通常用于实现车速等驾驶环境信息的预测,以辅助基于工况预测的能量管理. 或用于车辆工作模式以及驾驶工况类型的分类,以辅助实现自适应的能量管理控制. 无监督学习主要用于驾驶循环分类或数据降维. 强化学习基于智能体与环境的交互信息优化控制策略,以表格或深度神经网络的形式存储控制策略,可以有效地避免数字化模型与维数灾难带来的最优性与实时性限制.

电动化、智能化、网联化是汽车产业发展的必然趋势. 凭借着高效、环保、适应性强、里程稳定等优点,混合动力电动汽车将成为智能化与网联化技术的重要载体. 未来能量管理技术的研究可以包括以下内容:

①基于车路协同的分布式EMS 训练架构:通过云平台所搭载的全局经验缓存系统收集同类型车辆在不同交通环境中的运行数据与控制参数. 基于离线策略学习方法(例如,离线强化学习)提取全局经验并进行学习. 这样可以避免有限状态环境与强相关数据对策略泛化能力的影响,同时提高训练样本的采样效率、缩短算法的训练时间.

②网联多车系统的协同控制:利用个体之间的行为一致性和耦合性,实现多车系统的能耗优化将是进一步改善能源消耗的重要思路. 例如:在保证驾驶安全性的条件下,通过对多车驾驶行为的协同控制降低空气阻力,改善多车系统的能源消耗.

③智能混合动力汽车的生态驾驶技术:智能网联环境下, EMS 的功能不再局限于固定车速曲线下的功率分配. 驾驶行为规划与功率分配的协同优化将在很大程度上提高HEVs 的节能减排表现.