基于强化学习的再入飞行器“新质”走廊在线生成技术

惠俊鹏,汪韧,俞启东

中国运载火箭技术研究院 研究发展部,北京 100076

高升阻比飞行器具有飞行速度快、升阻比高、航程远、机动能力强等特点,在军事和民用领域发挥着重要的作用。高升阻比飞行器再入制导技术通过设计制导律,在动力学方程、过程约束、控制量约束等条件下,使得飞行器在中末交班点满足再入终端约束。因临近空间环境的复杂性和不确定性,飞行器再入制导技术已成为航空航天领域研究的热点之一。

高升阻比飞行器再入制导方法主要分为两种:基于标称轨迹的制导方法和预测校正制导。基于标称轨迹的制导方法离线设计标称轨迹,在飞行过程中跟踪标称轨迹进行制导。离线设计的标称轨迹可以是阻力加速度-能量(Drag-Energy, D-E)剖面、高度-速度(Height-Velocity, H-V)剖面等。由于标称轨迹是离线设计所得,因而该方法对复杂环境的适应性和鲁棒性方面存在明显的不足。预测校正制导方法对动力学方程进行积分,预测飞行器的终端状态,并基于终端状态与目标点的偏差来校正制导指令,从而实现对飞行器的精确制导。相比于基于标称轨迹跟踪的制导方法,预测校正制导具有更强的自主性和对复杂环境的适应能力。

人工智能(Artificial Intelligence)目前已成为学术界和工业界的研究热点。机器学习(Machine Learning)技术是人工智能领域的核心技术,机器学习主要包括监督学习(Supervised Learning)、无监督学习(Unsupervised Learning)和强化学习(Reinforcement Learning)。相比于监督学习和无监督学习,强化学习主要用于解决智能体的序贯决策问题,其核心思想是智能体自主地与环境进行交互,实时观测状态信息,并基于一定的策略采取相应的动作,同时从环境中获取与动作相对应的反馈信息,智能体基于数据[,,]进行训练,在不断“试错”的过程中优化行动策略,以期完成预定任务。近年来提出的具有代表性的强化学习算法有深度Q网络算法(Deep Q Network, DQN)、深度确定性策略梯度算法(Deep Deterministic Policy Gradient, DDPG)、近端策略优化算法(Proximal Policy Optimization, PPO)、软动作-评价算法(Soft Actor-Critic, SAC)等,目前已广泛应用于游戏、无人驾驶等领域。

基于人工智能的飞行器制导控制技术研究尚处于起步阶段。文献[9]综述了深度学习在飞行器动力学与控制中的应用,从3个方面总结了深度学习在飞行器动力学与控制中的应用,包括:在动力学建模中应用深度学习来提升模型计算效率和建模精度、求解模型反问题;在最优控制中应用深度学习来提升轨迹规划速度、最优控制实时性和自主性;在飞行器任务设计中应用深度学习来提升任务优化的计算效率和决策水平。在制导律设计方面,文献[10-12]将深度学习技术应用于飞行器制导和在线轨迹优化问题,基于大量的飞行轨迹训练神经网络模型,从而实现飞行器实时状态到制导指令的快速映射;文献[13-18]研究了基于Q-Learning、PPO等强化学习算法的智能制导律,该方法消除了原有传统制导律对飞行器附加的一些不必要约束,通过飞行器与环境的大量交互和试错,并基于奖励信息来学习制导律,使得飞行器初步具备了自主决策能力。在姿态控制方面,文献[19-20]在传统PID控制的基础上,进一步利用强化学习技术实现对飞行器6自由度的稳定控制,并验证了该方法在控制精度和实时性方面的优势。在飞行器协同制导与轨迹规划方面,方科等开展了高升阻比飞行器时间协同再入制导研究,将协同再入制导结构分为两层,其中底层提出了基于神经网络的时间可控再入制导律,以实现再入飞行时间的可知性与可控性为目标;上层根据不同再入阶段特点设计相应的协调函数,生成时间协调信息。周宏宇等提出了一种改进粒子群优化(Particle Swarm Optimization, PSO)算法的飞行器协同轨迹规划,并借助强化学习方法构建协同需求与惯性权重间的动态映射网络,提高在线轨迹规划效率。

无论是基于标称轨迹的制导还是预测校正制导,都需要基于人工经验设计飞行走廊参数。基于标称轨迹的制导方法根据飞行器再入过程中需要满足的过程约束,设计可行的飞行走廊,在走廊约束下精心设计满足航程和终端约束的标称飞行轨迹;预测校正制导方法在横向制导中通过设置合适的横程误差或航向角误差走廊来确定倾侧角的符号,当横向控制量到达走廊边界时,倾侧角符号翻转。

本文旨在研究基于强化学习的再入飞行器“新质”走廊在线生成技术,打破传统预测校正制导等方法中固有的走廊约束,在满足飞行过程约束(热流率、过载、动压等约束)和中末交班点约束的前提下,通过飞行器与环境大量交互“试错”,并借鉴人类基于反馈来调整学习策略的思想,设置有效的奖励(反馈)引导,利用强化学习中PPO算法训练飞行器倾侧角制导模型,颠覆现有制导方法在横向走廊/纵向剖面的约束,实现飞行器基于实时的状态信息在线决策倾侧角指令。通过智能技术的赋能,充分发挥再入飞行器的宽域飞行优势,进一步拓展飞行剖面,探索已有飞行模式以外的新质飞行走廊,达到出敌不意的灵活飞行效果,从而满足未来飞行器对智能决策的自主性需求。

1 再入飞行器制导问题

1.1 再入飞行器运动模型

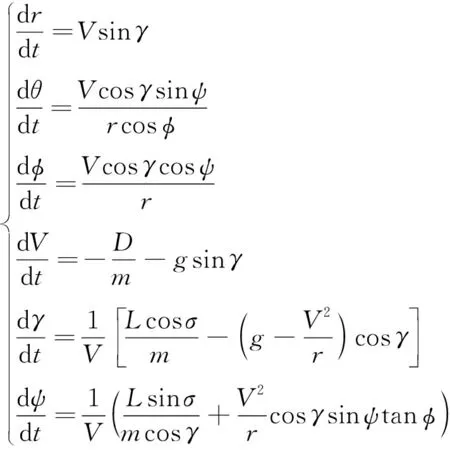

再入飞行器3自由度动力学方程为

(1)

式中:为地心距;和分别表示飞行器的经纬度;为飞行速度;和分别表示飞行器的航迹角和航向角;表示倾侧角;为飞行器的质量;为重力加速度;和分别表示飞行器的升力和阻力。

1.2 再入制导约束

为了保证再入飞行器成功地完成飞行任务,飞行器需满足各种约束条件,其中核心的约束条件包括过程约束、拟平衡滑翔约束、再入终端约束和控制量约束。

1) 过程约束

一方面,飞行器再入过程中高超声速气流会产生严重的气动热,尤其是飞行器的驻点区域。为保证飞行器各个部件正常运行,再入段制导必须考虑驻点区的热流率约束。另一方面,飞行器机身和机翼结构强度的上限以及气动舵面铰支链的承受能力,决定了再入飞行过程中的最大允许过载和动压。热流率约束、过载约束和动压约束是飞行器再入飞行过程中必须要满足的“硬约束”条件,其表达式为

(2)

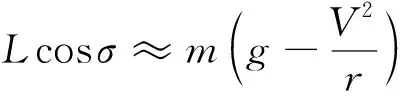

2) 拟平衡滑翔约束

(3)

当满足拟平衡滑翔条件时,飞行器所受重力与升力的合力恰好与其所受的向心力平衡,此时飞行轨迹高度变化较小,航迹角保持很小的量。

3) 再入终端约束

滑翔段的终端约束为滑翔段和末制导段的交班参数,再入终端约束一般包括高度、速度、经纬度等约束,可表示为

()=,()=,()=,()=

(4)

式中:、、、、分别表示滑翔段的终端时刻、地心距、速度、经度、纬度。

4) 控制量约束

在3自由度飞行器再入制导中,攻角和倾侧角为控制量,由于飞行器内部控制机构的作用,控制量的变化需要一定的变化时间和变化速度,不能瞬间变化到指定值。由于攻角采用标准攻角剖面,因而控制量的约束主要限制在倾侧角的幅值及其变化率上,即

(5)

2 再入飞行器智能制导模型的设计

在再入飞行器制导中,控制量包括攻角和倾侧角。攻角一般通过预先设定的速度-攻角剖面生成。在再入初期为满足热流率约束采用大攻角飞行,在中后段为满足飞行器的射程需求,采用最大升阻比对应的攻角飞行。本文着重研究再入飞行器倾侧角制导模型的设计。

2.1 解决的问题

传统的飞行器再入制导,主要分为2种方法:① 基于标称轨迹的制导方法,根据飞行器再入过程中需要满足的热流率约束、过载约束和动压约束,设计可行的飞行走廊,飞行走廊一般在D-E剖面或H-V等剖面内描述,在走廊约束下精心设计满足航程和终端约束的标称飞行轨迹,实际飞行中在线跟踪标称轨迹;② 预测校正制导方法,在纵向制导中基于预测的待飞航程与剩余航程的差,采用割线法迭代求解倾侧角的幅值,在横向制导中通过设置合适的横程误差或航向角误差走廊来确定倾侧角的符号,当横向控制量到达走廊边界时,倾侧角符号翻转。上述分析表明,无论是基于标称轨迹的制导还是预测校正制导,都需要基于人工经验设计飞行走廊参数。

借鉴Alpha Go的思想,将监督学习方法和强化学习方法相结合应用于飞行器再入制导中,研究框架如图1所示,主要包括3步:

1) 预测校正制导:基于预测校正制导方法,通过灵活设置飞行器再入初始点的状态参数,生成大量的样本数据。

2) 监督学习:建立倾侧角智能制导模型,利用监督学习中带有动量的随机梯度下降(Stochastic Gradient Descent with Momentum,SGDM)算法和第1步产生的样本数据,训练倾侧角智能制导模型,这里记基于SGDM算法训练得到的倾侧角智能制导模型的参数为。

3) 强化学习:以第2步训练得到的智能制导模型参数为初始化参数,进一步利用强化学习在智能决策方面的优势,在动力学方程的约束下通过飞行器与环境进行大量交互,并借鉴人类基于反馈来调整学习策略的思想,设置有效的奖励(反馈),利用强化学习中PPO算法进一步训练飞行器倾侧角制导模型,得到PPO算法再训练后的模型参数,记为。该制导模型和参数将颠覆现有制导方法在横向走廊的约束,在满足飞行器过程约束的前提下,进一步拓展飞行剖面,生成完全不同于传统制导方法的飞行走廊,达到出敌不意的灵活飞行效果,从而满足未来飞行器对智能决策的自主性和实时性要求。

图1 再入飞行器智能制导研究框架Fig.1 Research framework of intelligent guidance of reentry vehicles

将监督学习方法与强化学习方法相结合应用于再入制导具有2个方面的优势:

1) 相比于监督学习方法,监督学习是利用神经网络模型对再入飞行器制导指令的解算过程进行拟合,其本质上是使得基于监督学习训练的智能制导模型生成的飞行轨迹最大程度逼近预测校正制导方法下的飞行轨迹。因而,可以利用监督学习对倾侧角智能制导模型进行预训练,利用领域知识(预测校正制导方法)引导制导模型中未知参数的搜索。

2) 相比于强化学习方法,若没有监督学习的预训练过程,直接利用强化学习算法训练倾侧角智能制导模型将带来训练难以收敛等问题。强化学习训练过程是以监督学习预训练出的模型参数为初始化参数,进一步通过飞行器与环境的大量交互,通过奖励的引导,探索完全不同于传统方法的“新质”飞行走廊。

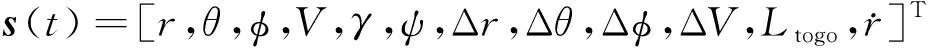

2.2 倾侧角智能制导模型

倾侧角智能制导模型如图2所示,其中制导模型的输入为飞行器的状态向量,定义状态向量为

(6)

式中:Δ=-表示时刻的地心距与滑翔终端地心距的差;Δ=-表示时刻的经度与滑翔终端经度的差;Δ=-表示时刻的纬度与滑翔终端纬度的差;Δ=-表示时刻的速度与滑翔终端速度的差;表示时刻飞行器距离滑翔终端的剩余航程:

=×arccos[sinsin+coscos·

cos(-)]

(7)

其中:为地球半径。隐层为长短期记忆(Long Short-Term Memory, LSTM)模型,隐层输出的节点数为64个,隐层到输出层是全连接,输出为倾侧角。

图2 基于LSTM的倾侧角制导模型架构Fig.2 Structure diagram of bank angle guidance model based on LSTM neural network

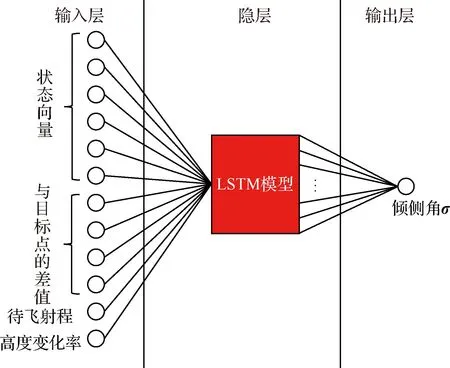

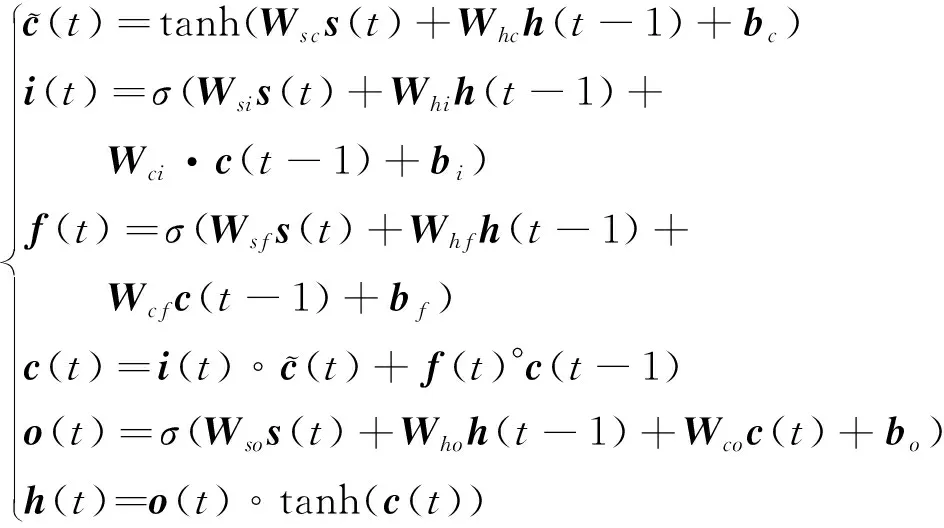

LSTM模型如图3所示,其数学表达式为

(8)

图3 LSTM模型Fig.3 LSTM model

选取LSTM模型的根本原因在于,从智能决策的角度来说,飞行器倾侧角的决策属于典型的序贯决策问题,每一时刻的倾侧角符号不仅取决于飞行器当前时刻的状态,还与上一时刻的倾侧角符号以及上一时刻航向角误差与走廊的关系有关。这是因为若上一时刻航向角误差在走廊内,当前时刻超出走廊,则需要翻转;但若上一时刻已经超出走廊,倾侧角已经翻转过一次,当前时刻还在走廊外,则无需二次翻转。因而在决策倾侧角时需要考虑飞行器在相邻时刻间的状态关系,而这也恰好是LSTM所具有的独特优势,是解决序贯决策的经典模型。

2.3 倾侧角幅值的约束

为保证再入飞行器的安全飞行,基于LSTM模型输出的倾侧角需进一步满足再入过程约束。飞行器的指数大气密度、升力和阻力的计算公式为

(9)

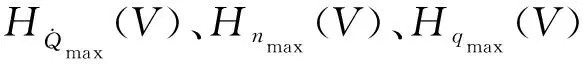

将式(9)代入式(2)的约束条件得到在H-V剖面再入走廊的边界:

(10)

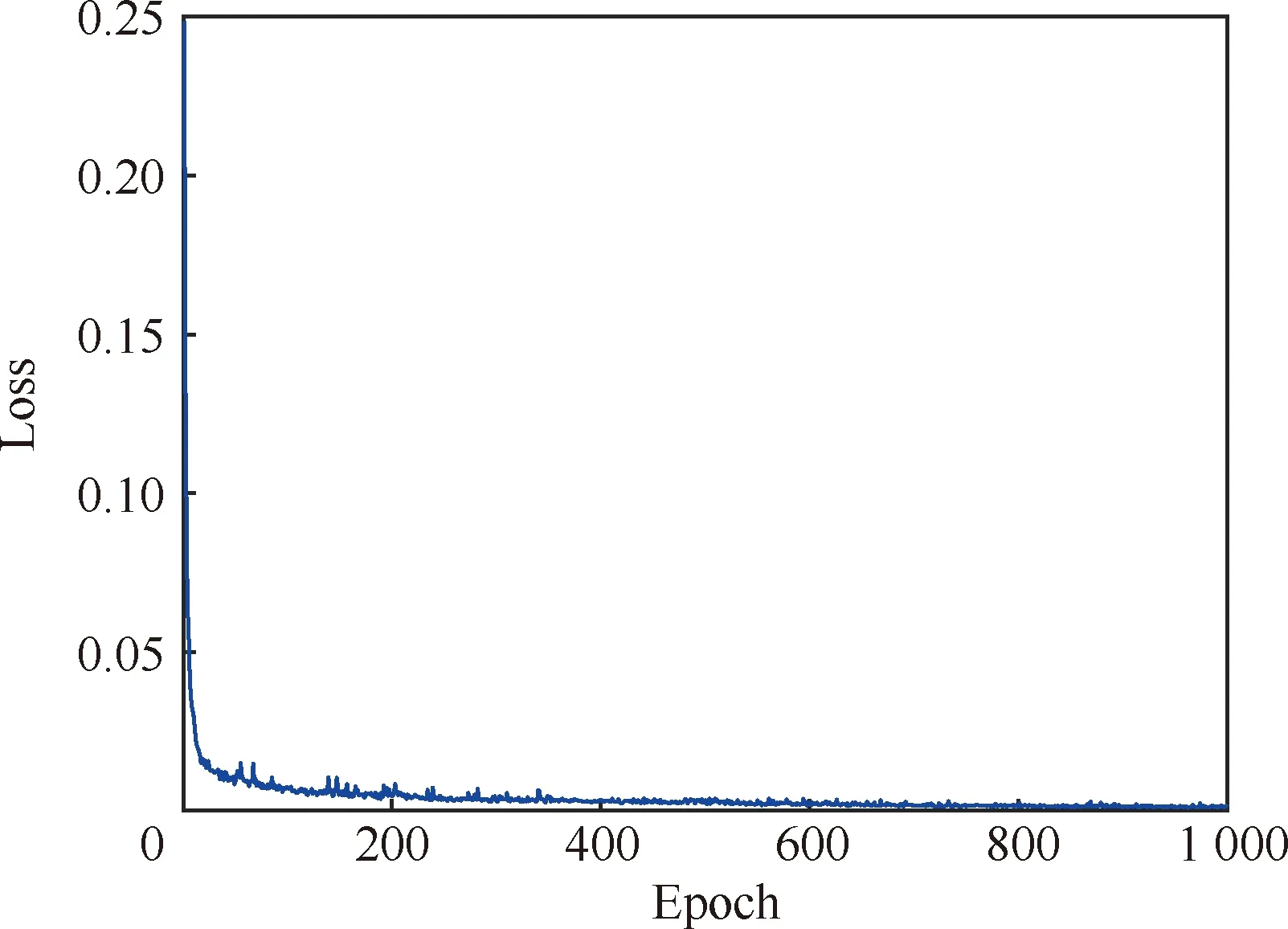

然而,在再入飞行过程中,如果时刻判断高度-速度剖面是否满足过程约束的边界条件会带来较大的计算量,为此将上述再入过程约束式(10) 转化为对倾侧角幅值的约束:

(11)

|()|}

(12)

基于式(12)对基于LSTM模型输出的倾侧角幅值进一步限制,使其满足过程硬约束条件。

3 基于监督学习的再入飞行器倾侧角智能制导模型的训练

基于监督学习的再入飞行器倾侧角智能制导模型的训练分为两步:一是训练样本的生成;二是倾侧角制导模型的训练。

3.1 训练样本的生成

在训练样本的生成方面,本文选取美国通用航空飞行器CAV-H为研究对象,基于预测校正制导方法产生仿真数据。参数设置为

2) 中末交班点参数:高度=23 km,经度为=50°,纬度为=3°,速度为=1 100 m/s。

3) 攻角剖面:

=

(13)

式中:、分别为初始、末端速度;、为可调的速度参数,本文设置=5 000 m/s,=2 500 m/s;为最大攻角,本文设置为20°;max为最大升阻比对应的攻角,本文设置为10°。

4) 纵向预测校正的周期:当剩余射程大于500 km时,=50 s;当剩余射程小于500 km,大于200 km时,=15 s;当剩余射程小于200 km时,=5 s。

5) 动力学方程积分步长:纵向制导的积分步长为1 s,横向制导的积分步长为0.1 s。

6) 飞行器再入初始点的状态参数设置如表1所示。

表1 飞行器再入初始点的参数范围Table 1 Range of initial state parameters of vehicle reentry

在上述参数范围内随机设置飞行器的再入初始点参数,在预测校正制导下可以获得大量的飞行轨迹数据。本文选取其中1 331条飞行轨迹,每条轨迹约16 000个样本点。

3.2 倾侧角智能制导模型的训练

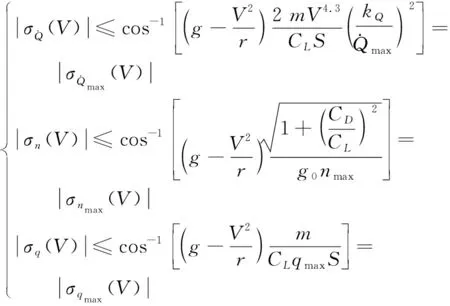

将基于预测校正制导方法生成的1 331条飞行轨迹输入图2基于LSTM的飞行器倾侧角制导模型中,基于监督学习的思想,在训练时目标损失函数(Loss function)定义为

(14)

(15)

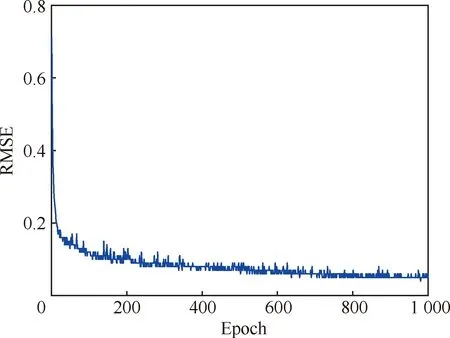

训练效果如图4和图5所示。可以看出目标损失函数和均方误差随着训练迭代次数的增加逐渐减小且趋于收敛,表明上述训练参数设置的合理性。

图4 损失函数随迭代次数的变化曲线Fig.4 Loss function vs epoch curve

图5 均方根误差随迭代次数的变化曲线Fig.5 RMSE vs epoch curve

4 基于强化学习的再入飞行器倾侧角制导模型的训练

记第3节中基于监督学习SGDM算法训练得到的倾侧角智能制导模型的参数为,本节将以参数为初始化参数,进一步利用强化学习的思想,将强化学习技术应用于飞行器再入制导中,在动力学方程的约束下通过飞行器与环境进行大量交互,在“试错”的过程中根据设置的有效奖励(反馈),利用PPO强化学习算法训练飞行器倾侧角制导模型,得到PPO算法训练后的模型参数,记为进一步拓展飞行剖面,生成完全不同于传统制导方法的飞行走廊,包括再入飞行器马尔科夫决策过程建模和PPO算法原理。

4.1 再入飞行器马尔科夫决策过程建模

基于强化学习研究再入飞行器制导律,需首先利用马尔科夫决策过程对再入制导问题进行建模,主要包括3部分:飞行器的状态空间、动作空间和奖励(反馈)的设计。

飞行器的动作空间为倾侧角,包括倾侧角的幅值和符号:

=

(16)

奖励函数在利用强化学习算法训练倾侧角智能制导模型中起着引导的作用,不同的奖励函数对训练结果将产生不同影响。若只考虑是否满足中末交班点的精度要求,即无过程奖励信息,则稀疏奖励会带来训练难以收敛的问题。结合再入飞行器的飞行特性,倾侧角影响横向制导的经纬度和纵向制导的高度、速度,因而奖励的设置从横向和纵向2个维度来设置。

1) 横向奖励的设置

横向奖励的设置如图6所示,着重考虑2个方面:① 为了增加飞行器与环境交互过程中的探索性,期望其能够探索出完全不同于传统预测校正制导的飞行轨迹,因而在接近目标点一定距离后才设置相应的奖励,如本文中考虑剩余航程小于1 000 km后才设置奖励;② 为了引导飞行器精确到达目标点,在飞行器接近目标点的过程中,距离越近,奖励的设置越密集,飞行器获得的奖励越大,且飞行器一旦远离目标点则被惩罚(负奖励),该负奖励将迅速抵消接近目标飞行过程获得的正奖励,从而引导飞行器精确到达目标点。

图6 飞行器横向奖励的设置Fig.6 Lateral reward set of reentry vehicles

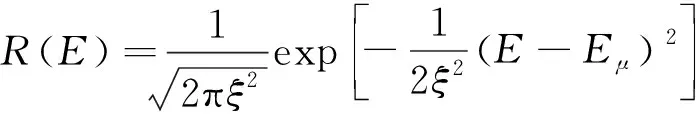

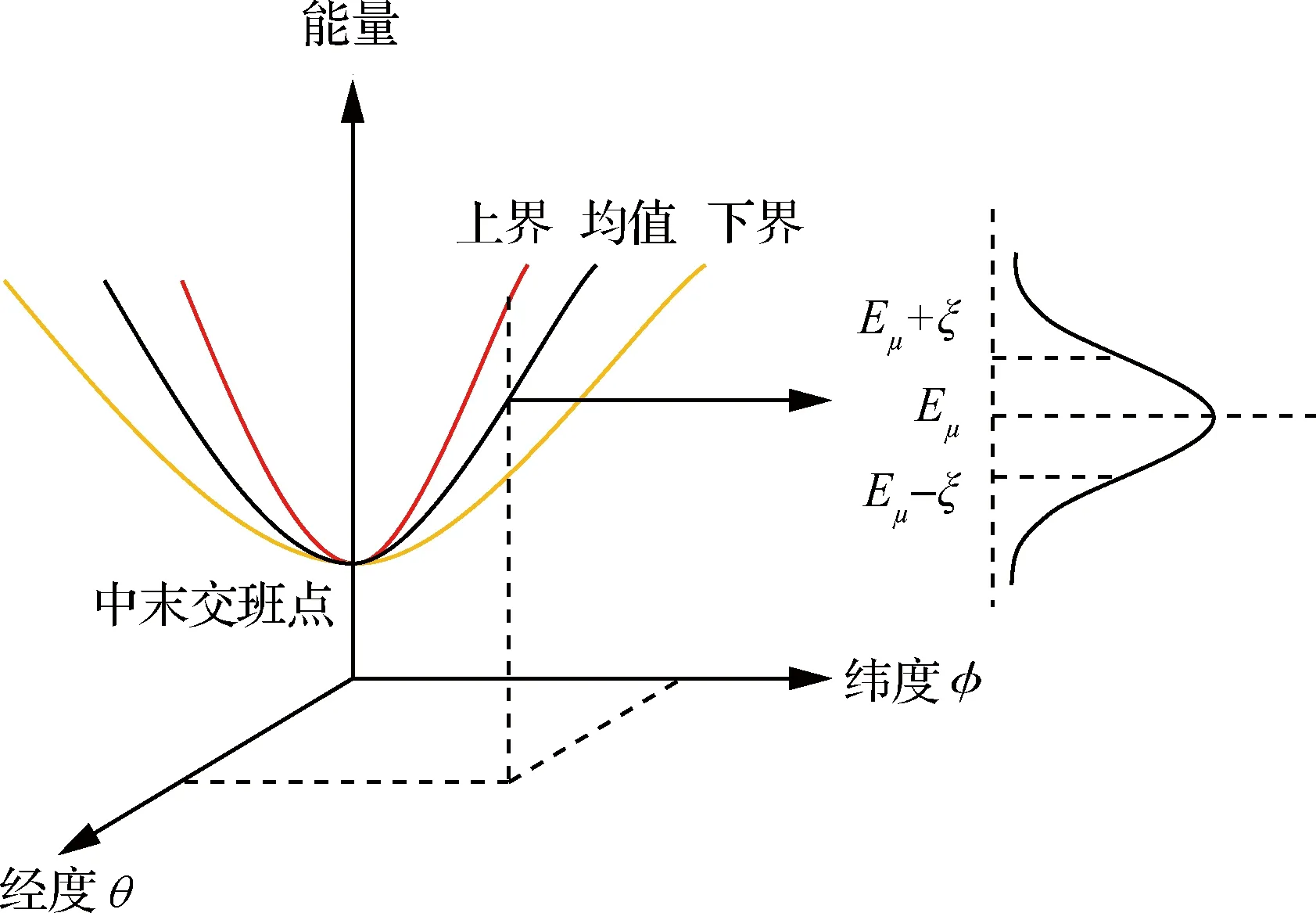

2) 纵向奖励的设置

除了满足中末交班点经纬度约束外,还需满足高度和速度的约束,从能量的角度出发,定义飞行器的能量为

(17)

式中:表示飞行器的能量;GM表示引力系数,取值为3.986×10N·m/kg。飞行器在位置点(,)所具有的能量均值为,将飞行器获得的奖励设置为能量的高斯分布函数:

(18)

式中:为标准差。通过如图7所示的飞行器纵向奖励的设置,引导飞行器在位置点(,)处的能量在[-,+]的范围内,以确保飞行器具备足够的能量到达目标点。

图7 飞行器纵向奖励的设置Fig.7 Longitudinal reward set of reentry vehicles

4.2 PPO算法原理

PPO算法在连续动作空间的智能决策任务中表现出较好的效果,目前Open AI已经将PPO作为强化学习研究的首选算法。

1) 优化的目标函数

定义优化的目标函数为

(19)

式中:~()表示飞行器的初始状态分布;记2.2节中设计的倾侧角智能制导模型为(|),它实现的是从飞行器状态到动作(即倾侧角指令)的映射;为倾侧角智能制导模型(或策略模型)中待训练的参数;()为奖励函数,表示飞行器在状态执行动作获得的即刻奖励的期望;∈[0,1]为折扣因子。

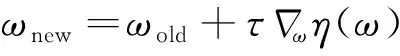

在强化学习算法中,一般采用策略梯度法来更新策略参数从而最大化目标函数。策略参数的更新方程为

(20)

策略梯度算法的关键在于如何选择更新步长,合适的步长是指当策略更新后,目标函数的值单调增加,或单调不减,这是PPO算法要解决的关键问题。

2) PPO算法的核心思想

PPO算法是由信赖域策略优化(Trust Region Policy Optimization, TRPO)算法演变而来。TRPO算法并不是从策略梯度的更新步长着手,而是从优化的目标函数出发。鉴于目标函数难以优化,寻找替代函数(Surrogate Function),替代函数具有3个特点:① 替代函数是目标函数的下界函数;② 在当前策略下替代函数近似等于目标函数;③ 替代函数相比于目标函数更容易优化。

TRPO算法用一个替代函数来作为目标函数的下界函数,下界函数易于优化,通过迭代的方式让下界函数逼近原目标函数的最优解。在TRPO算法中,将式(19)中的目标函数转化为

(21)

式中:(|)表示参数更新前的策略;由于(|)表示更新后的策略,是未知的,无法基于未知分布(|)采样得到动作序列,因而利用重要性采样(Importance Sampling),即~(|)获得采样动作序列;(,)=(,)-()表示优势函数(Advantage Function),它描述的是动作值函数(,)相比于状态值函数()的优势,如果优势函数大于零,则说明该动作比平均动作好,如果优势函数小于零,则说明当前动作不如平均动作好。((·|)|(·|))表示分布(·|)与(·|)之间的KL散度(Kullback-Leibler Divergence),引入该约束条件的目的是限制每一步策略参数的更新幅度。

TRPO算法能够保证在迭代的过程中飞行器的制导策略朝着最优的方向不断更新,并能确保算法的收敛性,但其计算过程比较复杂。为此,PPO算法将TRPO中KL散度的约束直接体现在目标函数中,移除了KL散度的计算,从而简化了TRPO算法。

1+)(,))]

(22)

由目标函数可知:

① 当旧策略(|)表现较好时,即优势函数(,)>0,此时由clip((),1-,1+)(,))可得(|)(|)≤1+,其表达的意思是此时策略表现较好,理应让(|)变大,但不能使(|)(|)变得过大,导致策略更新前后相差太大,引入的方差较大。

② 当旧策略(|)表现不好时,即优势函数(,)<0,此时由clip((),1-,1+)(,))可得(|)(|)≥1-,其表达的意思是此时策略表现不好,策略更新的比值(|)(|)不必受到限制。

因而,PPO算法通过clip((),1-,1+),将策略更新的比值(|)(|)约束在[1-,1+]之内。

由上述分析过程可以看出PPO算法避免了复杂的KL散度的计算过程,并将有约束的优化问题转化为无约束的优化问题,大大简化了计算复杂度,提升算法收敛性能。

5 仿真与分析

5.1 不同制导方法对比分析

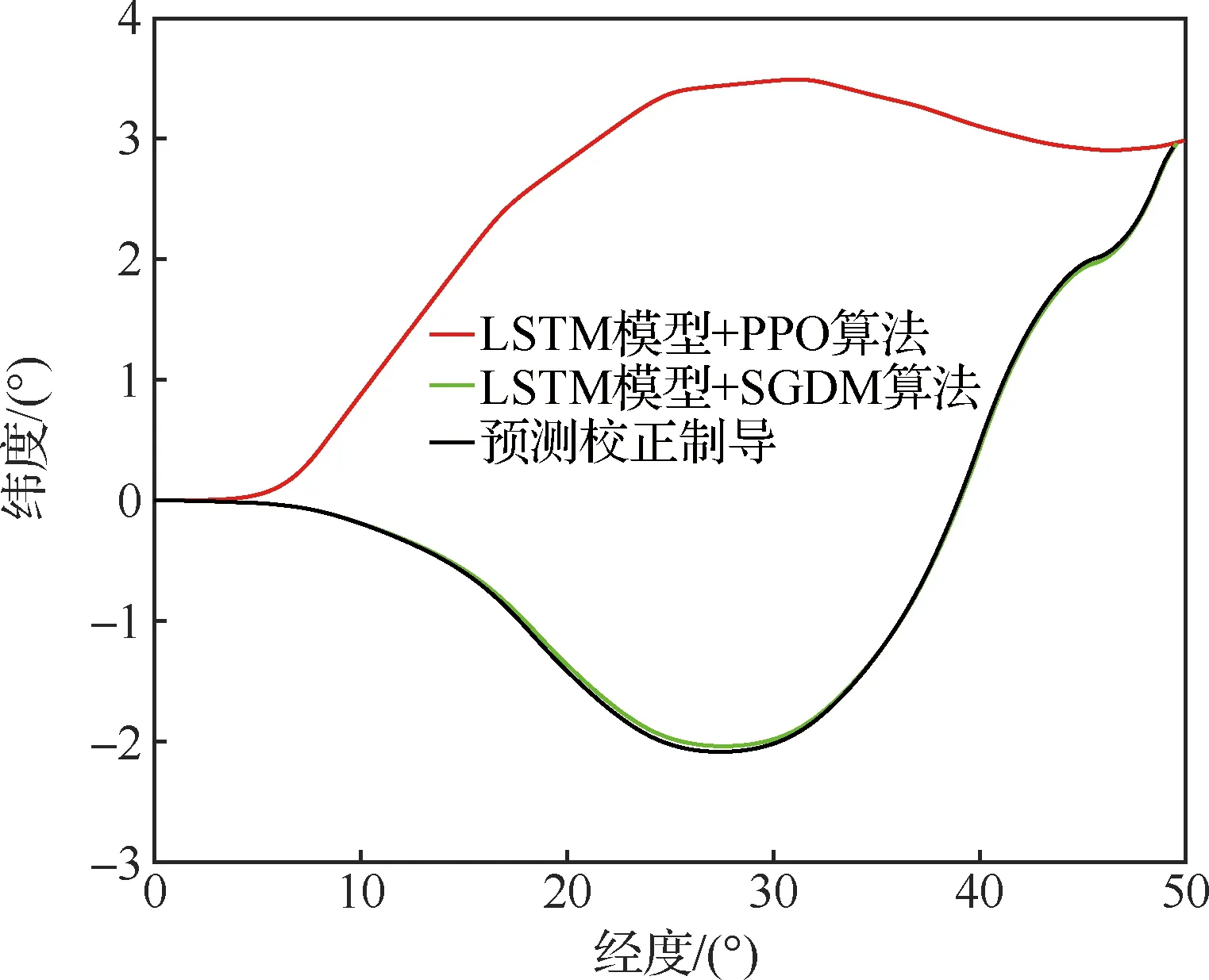

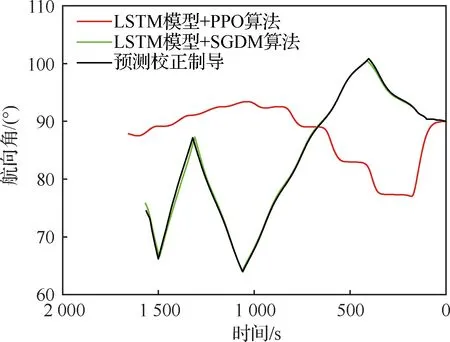

以通用航空飞行器(Common Aero Vehicle-H, CAV-H)为研究对象,参数设置见3.1节,比较3种不同制导方法的仿真结果:① 预测校正制导方法;② 第3节中基于监督学习中SGDM算法训练倾侧角制导模型的方法(图中记为“LSTM模型+SGDM算法”);③ 第4节中基于强化学习中PPO算法训练倾侧角制导模型的方法(图中记为“LSTM模型+PPO算法”),对比结果如图8~图12所示。

由图8~图12可以看出,“预测校正制导”与“LSTM模型+SGDM算法”两种制导方式下的飞行轨迹基本重合,这是由于利用监督学习训练倾侧角制导模型时,选取的样本轨迹是基于预测校正制导产生,该训练过程可理解为对预测校正制导的拟合过程。但“LSTM模型+PPO算法”制导下的飞行轨迹完全不同于预测校正制导下的飞行轨迹。从图9经纬度曲线和图10倾侧角曲线可以看出,预测校正制导从初始点(0°,0°)出发,由于航向角=90°且倾侧角大于>0°,因而初始飞行轨迹朝东南方向;相反,在“LSTM模型+PPO算法”制导下从初始点(0°,0°)出发后输出的倾侧角<0°,因而初始飞行轨迹朝东北方向。尽管两种不同的制导方式下飞行轨迹完全不同,但在满足热流率约束、过载约束和动压约束的前提下,都精确到达中末交班点。

图8 高度-速度曲线对比Fig.8 Comparison of height-velocity curves

图9 横向轨迹曲线对比Fig.9 Comparison of lateral trajectory curves

图10 倾侧角-速度曲线对比Fig.10 Comparison of bank angle-velocity curves

图11 航迹角-时间曲线对比Fig.11 Comparison of flight path angle-time curves

图12 航向角-时间曲线对比Fig.12 Comparison of heading angle-time curves

5.2 Monte Carlo仿真分析

为验证“LSTM模型+PPO算法”制导方法的鲁棒性和对参数偏差的适应性,本文对飞行器再入初始状态、气动参数进行拉偏仿真分析,偏差设置如表2所示。

表2 飞行器再入初始状态和气动参数偏差

在再入初始状态扰动和气动偏差的条件下,基于“LSTM模型+PPO算法”制导进行400组的Monte Carlo仿真,落点经纬度的散布如图13所示,并与传统的预测校正制导进行比较。可以看出,在满足中末交班点能量约束的前提下,相比于传统的预测校正制导方法,基于“LSTM模型+PPO算法”制导的末端状态更加靠近中末交班点,即更加靠近=50°,=3°。显然,在初始状态有扰动和气动参数有偏差的情形下,“LSTM模型+PPO算法”制导具有更高的精度,其原因在于采用LSTM模型输出倾侧角指令时需对输入的飞行器状态向量进行归一化处理,该过程会降低对状态偏差的敏感性,加上LSTM神经网络模型具有天然的泛化能力,因而对于参数的偏差具有更强的鲁棒性。

图13 初始状态和气动参数扰动下落点经纬度的散布图Fig.13 Longitude and latitude scatter diagram with initial state error and aerodynamic parameter perturbation

5.3 实时性分析

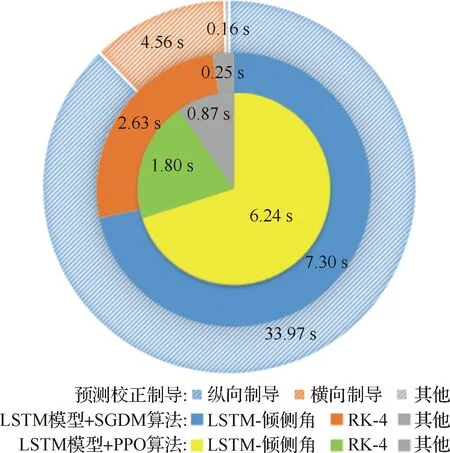

下面进一步对比分析不同制导方法的实时性。运行硬件为Intel Core(TM) i7-6500U CPU @2.50 GHz,在Matlab环境下运行代码。

在Monte Carlo仿真中,基于“LSTM模型+PPO算法”制导方法完成一次再入段飞行的平均时长为8.91 s,其具体分布如图14所示,其中基于LSTM模型生成倾侧角的时长占其中的6.24 s,龙格库塔RK-4积分时长占其中的1.80 s。

图14 计算实时性对比分析Fig.14 Comparison of computing time analysis

与之对比,在Monte Carlo仿真中,基于预测校正制导方法完成一次再入段飞行的平均时长为38.69 s,其中纵向制导过程占其中的33.97 s,横向制导过程占其中的4.56 s。这是因为在纵向制导中,对动力学方程进行积分的预测过程和基于割线法求解倾侧角的校正过程计算量较大,占用的时间较长。此外,基于“LSTM模型+SGDM算法”的制导方法与基于“LSTM模型+PPO算法”的制导方法耗时相当,这是由于训练算法虽然不一样,但均是基于LSTM模型生成倾侧角指令,这两种制导方法中没有“预测”环节和“积分”环节,大大减少了计算量,提高了计算速度。因而,在实时性方面,基于LSTM模型的制导方法相比于传统预测校正制导具有明显的优势。

6 结 论

传统基于标称轨迹制导和预测校正制导等方法普遍存在人工设置的飞行走廊的固有约束,为打破该约束条件的限制,本文将监督学习技术和强化学习技术应用于飞行器再入制导中:① 基于预测校正制导方法生成大量的飞行轨迹样本;② 建 立倾侧角智能制导模型,利用监督学习中带有动量的随机梯度下降算法训练倾侧角智能制导模型;③ 在第2步基于监督学习训练的倾侧角智能制导模型的基础上,利用强化学习在智能决策方面的优势,在动力学方程的约束下通过飞行器与环境进行大量交互,并设置有效的奖励,利用强化学习中PPO算法进一步训练飞行器倾侧角制导模型,颠覆现有制导方法中横向走廊的约束,进一步拓展飞行剖面,生成完全不同于传统制导方法的飞行走廊,达到出敌不意的灵活飞行效果。强化学习技术通过飞行器与环境的大量交互“试错”,优化飞行轨迹,其与制导控制技术的交叉融合是未来飞行器智能制导控制领域的热门研究方向。