基于导向滤波和聚焦区域局部标准差的多聚焦图像融合*

谢 明 曲怀敬 张志升 王纪委 张汉元

(山东建筑大学信息与电气工程学院 济南 250101)

1 引言

图像融合是将同一场景下的两个或多个源图像生成视觉质量较好的融合图像。由于相机镜头受景深限制,很难拍摄得到场景都聚焦良好的图像。多聚焦图像融合是一种能有效地解决这类问题的图像处理方式,它在遥感图像处理、医学成像以及计算机视觉等领域中得到了越来越广泛的应用[1]。

图像融合方法大致可分为三种:基于变换域、基于空间域以及基于深度学习的方法。基于变换域的方法主要把源图像通过变换分解成不同变换系数,然后以预定的融合规则进行一个系数融合,最后对融合系数做逆变换得到最终融合图像。这类方法包括离散小波变换[2]以及非下采样轮廓波变换[3]等。另一方面,Yang[4]等首次将稀疏表示(SR)引入到图像融合领域。此外,文献[5]提出了基于显著稀疏表示的图像融合方法。

空间域方法主要包括基于块和像素的方法,它首先找到源图像各自的聚焦块或像素,然后直接选取这些不同的聚焦块或像素构成融合图像。如Bai等[6]提出了一种基于四叉树的多聚焦图像融合方法;Duan等[7]提出了一种基于块的多聚焦图像融合方法。这些方法虽然对块的划分进行了优化,但是容易在融合图像目标边界上出现模糊以及伪影的问题。而基于像素的方法不需要对源图像进行分块,它大多是先通过融合方案生成决策图,再得到融合图像。Yan等[9]利用混合焦点测度结合图像强度的方差和图像梯度的能量获得初始决策图。文献[8]使用拉普拉斯滤波对源图像的活动水平测量,然后得到决策图。这种融合方法是基于像素计算,因此融合边界容易出现伪影或者光环等问题。

基于深度学习的多聚焦图像融合方法可分为两种方法,即有监督和无监督方法。其中,大多数基于深度学习的多聚焦图像融合方法是通过监督学习的方式去训练网络,如Liu 等[10]最早提出了一种基于CNN 的多聚焦图像融合方法。其中,基于深度学习的方法包括基于决策图和端到端方法。MFF-GAN[11]最早提出了一种基于GAN 的无监督多聚焦图像融合方法。但由于训练数据库的缺乏,基于深度学习的融合方法在融合效果和效率上都有较大改进空间。

针对上述空间域多聚焦图像融合方法存在的问题,本文提出了一种基于导向滤波和聚焦区域局部标准差的多聚焦图像融合方法。本文方法在保证算法实时性的同时,有效地解决了其他方法在融合边界出现伪影的问题。

本文的主要贡献如下:

1)本文提出了一种新的基于导向滤波的焦点区域检测方法。

2)根据主观视觉评价和客观指标评价的结果表明,本文方法对灰度和彩色多聚焦图像都有较好的融合效果。

3)与不同融合方法的计算效率对比实验结果表明,本文方法的计算效率更为突出、实用性较高。

2 相关工作

2.1 导向滤波

导向滤波器通过输入图像和引导图像的内容计算滤波输出。导向滤波假设输出图像与引导图像间存在一个局部的线性模型,即如下的线性变换[12]:

式中,(ak,bk)表示在窗口ωk中模型的线性系数。若使用半径为r的矩形窗口,则ωk的大小为(2r+1)×(2r+1)。Ii为窗口中引导图像的第i像素强度。通常,根据最小化式(2)的代价函数,并通过引导图像I和输入图像P计算出ak和bk。

式中,ε为正则化参数;ak和bk可通过式(3)的线性回归公式计算,即

式中,μk和σk2分别是I在ωk中的均值和方差;|ω|是ωk中的像素数;表示窗口ωk中pi的均值。对于滤波器输出,通过式(4)进行计算,即

2.2 局部标准差

一个聚焦良好的像素通常具有更高的局部方差或局部标准差。因此,本文将使用局部标准差作为焦点检测度量来构建一个初始决策图用于像素选择。为了估计每个像素与其相邻像素间的局部标准差,设N(i,j)为以(i,j)处像素为中心的给定邻域,ΩD为输入图像L(i,j)的定义域,则像素(i,j)∈ΩD在邻域N(i,j)上的局部方差定义为

式中,|N(i,j)|为|N(i,j)|中所包含的像素数。(i,j)为输入图像L(i,j)在N(i,j)邻域内的局部均值,定义为

相应地,像素(i,j)的局部标准差由σL(i,j)给出。

3 本文方法

本文提出了一种新的基于导向滤波和聚焦区域局部标准差的多聚焦图像融合方法,其融合过程流程图如图1所示。

图1 本文提出的融合方法流程图(其中,GF 为导向滤波;MF 为均值滤波;I1、I2 为源图像;M1、M1 为导向滤波图像;F1、F2 为均值滤波图像;RFM1、RFM2 为粗略焦点图;AFM1、AFM2 为精确焦点图;S1、S2 为局部标准差图像;IDM 为初始决策图;FDM 为最终决策图;IF 为融合图像)

本文设计了一种新的聚焦区域检测方法。它首先获取由导向滤波后的源图像与均值滤波后的源图像相减所得到的绝对差值图像;然后通过导向滤波对差值图像进行细节增强;最后根据局部标准差检测得到准确的聚焦区域。然后根据像素最大化原则对局部标准差图像取大、去噪得到初始决策图;最后进一步使用导向滤波得到最终决策图。其中,聚焦区域检测方法包括以下五个步骤。

Step1:通过导向滤波器GFr,ε将源图像作为引导图对输入图像进行一次滤波,得到源图像I1、I2的滤波图像M1、M2,如式(7)和(8)所示。

Step2:用均值滤波器fm处理源图像I1、I2,生成均值滤波图像F1、F2,如式(9)和(10)所示。

式中,*表示卷积算子,fm表示均值滤波器。

Step3:计算导向滤波图像M1、M2与均值滤波图像F1、F2之间的绝对差值图像,并提取高频信息生成粗略焦点图RFM1、RFM2,如式(11)和(12)所示。

Step4:用源图像I1、I2作为引导图的导向滤波器对粗略焦点图RFM1、RFM2进行细化,得到更为精确的焦点图AFM1、AFM2,如式(13)和(14)所示。

式中,GFr,ε表示导向滤波算子,其中r是滤波器窗口半径,ε是正则化参数。

Step5:用局部标准差来增强导向滤波后的差值图像的高频信息,由较精确焦点图AFM1、AFM2得到对应的、反映聚焦区域的局部标准差图像S1和S2,如式(15)和(16)所示。

式中,N(i,j)为以像素(i,j)为中心的给定邻域。

3.1 初始决策图

焦点测量值是聚焦图像像素的最大值[13]。因此,通过对精确焦点映射S1和S2按像素级最大化原则,可得到融合初始决策图IDM,如式(17)所示。其中,S1和S2分别表示源图像I1、I2的焦点测量。

3.2 最终决策图

为了避免初始决策图IDM中出现黑白像素混合的情况,本文采用小区域去除策略[14]解决这个问题。小区域去除策略为从初始决策图中删除所有像素小于N的小区域,生成新的决策图。其中,N为删除小区域中的最大像素数(它由公式R×H×W算,其中R是一个比率因子,H和W分别表示源图像的长和宽)。本文实验R设为0.01。如图2 所示是两个用小区域去除策略得到的处理结果的示例,其中左侧为小区域处理前图像,右侧为处理后图像。

图2 采用小区域去除策略处理的示例

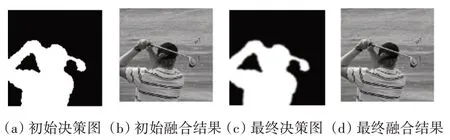

根据小区域去除处理后的初始决策图IDM′,利用像素加权平均规则由式(18)可得到初始的融合图像。如图3(a)、(b)所示。由图3 可见,初始融合图像的融合边界处容易产生伪影。为了获得理想的融合图像,本文再次使用导向滤波对IDM′进行空间一致性验证,从而输出最终决策图FDM,如式(19)所示。相应地,最终决策图如图3(c)所示。

图3 决策图比较

3.3 融合

根据最终决策图FDM,通过式(20)的像素加权平均规则将源图像融合在一起,得到最终的融合图像IF。

4 实验与讨论

为了证明本文方法的有效性,将不同融合方法得到的融合图像在主观视觉效果和客观评价指标上进行比较。本文选用典型的20对Lytro彩色多聚焦图像和10 对灰度多聚焦图像用于实验验证。本文将从主观和客观评价两方面将所提出的方法与目前较为先进的多聚焦融合方法进行对比实验,其中,SESF[20]、GFDF[14]以及MISF[18]为近三年多聚焦图像融合领域较为突出的方法,故平均排名靠前就具有一定的参考价值。这11 种融合方法可以归结为以下三类:1)基于变换域的方法,包括GFF[8]、SR[4]、ASR[15]、MWGF[16]和NSCT-SR[17]等;2)基于空间域方法,主要有GFDF 和MISF 等;3)基于深度学习方法,包括CNN[10]、SESF、MFF-GAN[11]和MADCNN[21]等方法。

为了对本文方法进行性能综合评估,本文采用了广泛使用的5 类客观评价指标,它们分别是归一化互信息QMI[19]、基于梯度的度量QG[22]、基于相位一致的度量QY[23]、基于结构相似度的度量QP[24]以及基于人类感知启发的度量QCB[25]。上述5 个指标均是值越大,融合效果越好。

4.1 主观视觉效果

不同方法典型的实验结果分别如图4和图5所示。为了直观地比较这些方法的融合效果,在图4的“clock”和图6的“golf”彩色源图像中,将图4圆形钟表和方形钟表交界区域和图5 两手臂形成的三角形区域的局部区域用红线框出,并且将放大后的图像在对应融合图像的右下侧呈现;然后,为了更加有效地对比各种方法的融合效果,图4 给出了由各种方法对应生成的差值图像(即,融合图像减去源图像2),并在各自的融合图像下方对应列出。

图4 针对“时钟”灰度源图像不同方法得到的融合结果

图5 针对“golf”彩色源图像不同方法得到的融合结果

由图4 的放大区域图可以发现,在ASR、GFF方法的融合图像中,在小钟的底部区域出现模糊;MFF-GAN、ASR、SR 和NSCT-SR 方法的融合图像在大钟的顶部边缘有一些不需要的伪影;MWGF、MADCNN 在小钟左边框出现伪影;进一步对比图中局部放大的区域可以发现,本文方法相比于SESF 和CNN 方法,在聚焦和离焦区域的边界上有更清晰的边缘和更高的对比度。此外,由不同方法所对应的差值图像对比可以看出,MFF-GAN、ASR、GFF、MADCNN、NSCT-SR 和SR 方法在小钟区域出现了很多的源图像2 的细节信息;CNN、MISF、GFDF 和SESF 方法在小钟区域有明显的的小区域错误;MWGF方法在小时钟区域判别基本正确,但在图像下方出现明显误判。综合比较来看,本文方法取得了较好的视觉效果。

在图5 的融合结果可以看出,在两手臂形成的三角形区域的局部放大图中,其中MWGF、ASR 和SR 方法存在一些模糊区域,而NSCT-SR 和MFF-GAN方法在放大区域的人物肩膀附近出现了伪影;其中,MADCNN、GFDF、SESF 和本文方法对高尔夫球的清晰度和对比度都保持得很好,而在GFF 和CNN 方法融合后的图像中,高尔夫球的轮廓比上面4 种方法更模糊。 其中,SESF、MADCNN、GFDF 以及本文方法的融合效果最为突出。另一方面,从图5 的差值图像发现,SESF、ASR、GFF、MADCNN、NSCT-SR 和SR 方法在衣服区域发现许多来自源图像2 的信息。此外,MFF-GAN方法在旗杆附近仍存在部分背景细节信息;CNN 方法在人物肩膀部分有错判;而方法MWGF 在两手臂之间的区域完全错判。综合比较来看,GFDF 以及本文融合方法得到的融合图像效果最好。

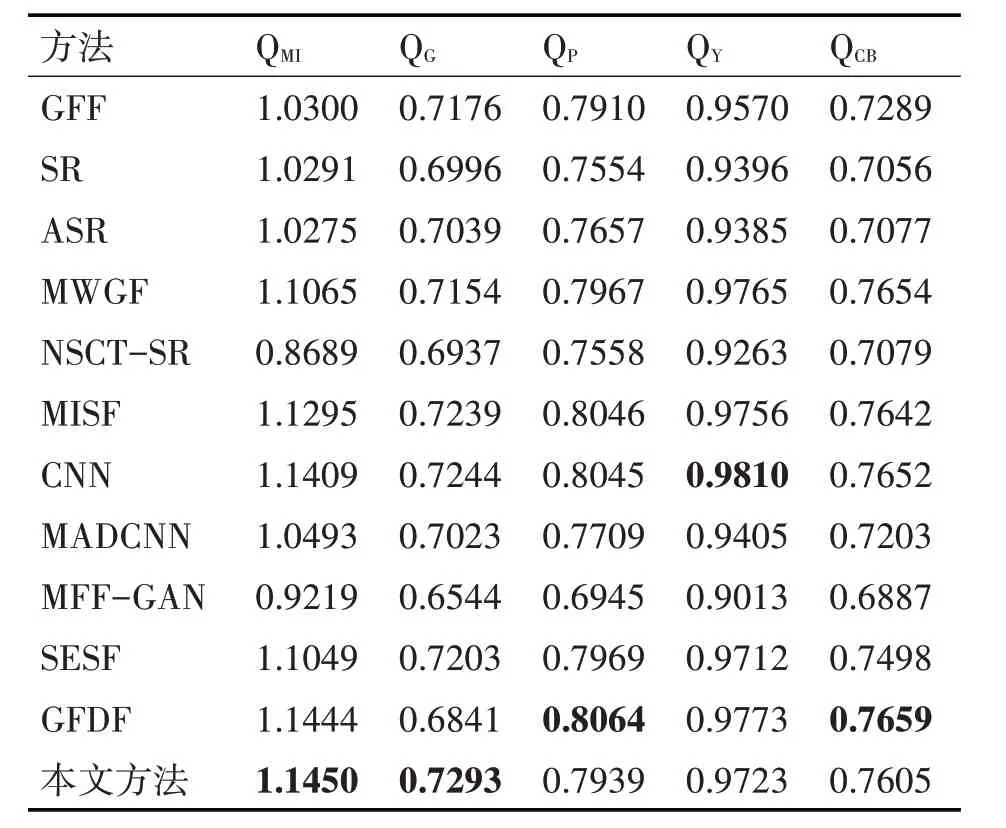

4.2 客观指标评价

本文对不同方法得到的融合图像进行客观分析。表1 与表2 分别列出了针对20 对多聚焦彩色源图像和10 对灰度多聚焦源图像在不同融合方法下得到的5 类客观指标的一个均值。其中,黑色加粗字体表示融合图像的客观性能在此指标下最佳。

表1 针对20对彩色图像不同融合方法的平均融合结果

表2 针对10对灰度图像不同融合方法的平均融合结果

由表1 可见,在“Lytro”彩色图像数据集中,GFDF 和本文方法融合效果最好。与11 种优秀多聚焦图像融合方法相比较,本文方法具有更好的融合效果,其中3 个指标是位列第1 名,而QY 指标也位于前5,也在平均水平之上。另一方面,由表2中的数据发现,对于灰度图像数据集,与其他11 种方法相比较,本文提出的方法在QMI和QG 指标上均是位列第1,而在其他三个指标上也都位列前5。综合表1和表2的客观性能来看,GFDF和本文方法最好,说明本文融合方法有着较好的融合性能。

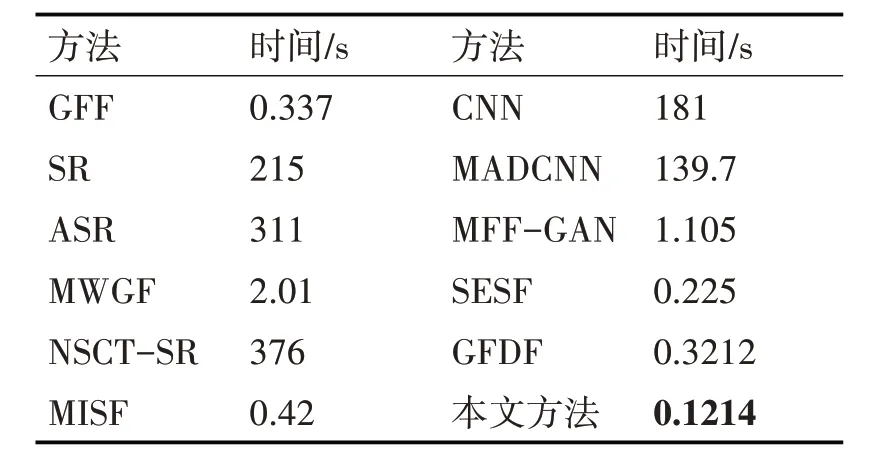

4.3 计算效率分析

为了验证实用性,本文对不同融合方法的计算效率进行了比较。

表3列出不同融合方法的运行时间。由表3中的数据可以看出,SR、ASR、NSCT-SR、CNN 和MADCNN 等方法的时间长,效率低;GFF、GFDF、MWGF、MISF、MFF-GAN、SESF 以及本文方法运行效率较高,其中本文方法仅为0.1214s。这说明本文所提出方法的计算效率和实用性较高。

表3 针对512×512像素的源图像不同融合方法的运行时间比较

5 结语

本文提出了一种基于导向滤波和聚焦区域局部标准差的多聚焦图像融合方法。与目前的利用导向滤波处理差值图像作为焦点区域检测不同,本文依据聚焦像素的局部标准差更大的原则,通过得到绝对差值图像的局部标准差图像,并用其作为焦点区域检测。本文结果表明,从主、客观指标评价去证明本文方法的有效性和可行性,从计算效率分析本文方法的实用性。目前,多聚焦图像融合领域仍然存在一些挑战,如聚焦和离焦区域边界的融合策略改进等。后续本文将继续攻坚这方面的研究工作。