基于卷积神经网络的风格迁移泳装图案设计

程鹏飞 王伟珍 房媛

摘要: 将深度学习中的风格迁移技术运用到服装图案设计领域正逐渐成为热门话题,但传统风格迁移图案设计的方法存在风格单一、纹理简单的缺点。本文提出一种辅助泳装设计师进行图案设计的方法,通过优化风格迁移中格拉姆矩阵结构,分别学习提取多张绘画作品和照片作为风格图生成创新的泳装图案设计图,同时运用Canny边缘检测算法和OpenCV图像处理库将作品从复杂背景中识别并分割出来,最终实现多风格图像输入的风格迁移辅助泳装图案设计方法。经过对比实验证明,本文生成的图案比其他风格迁移方法在风格满意度等方面获得更高评价。

关键词: 卷积神经网络;风格迁移;泳装;图案设计;Canny边缘检测;泳装图像分割

中图分类号: TS941.734

文献标志码: A

文章编号: 1001-7003(2023)03-0097-08

引用页码:

031201

DOI: 10.3969/j.issn.1001-7003.2023.03.013(篇序)

随着人工智能技术向各领域的渗透,将人工智能同艺术设计相结合,为服装的智能设计提供了更广阔的前景。风格迁移作为人工智能深度学习的一个活跃课题,已开始被用于服装图案设计、艺术绘画等领域。其原理是通过一个深度学习模型提取输入图像的纹理、色彩等艺术风格,迁移到另一张图片上,使得新生成的图像兼具所输入图像的风格和纹理特征。

在服装图案及色彩设计过程中,多风格融合的个性化设计一直是难点。因为泳装对于图案的依赖性明显超出大多品类服装,且泳装因其款式相对简洁的特点,适合作为当前阶段人工智能技术的产业应用场景切入点,因此本研究以泳装作为实验载体。泳装图案印染主要分为两类:一类是独立印染图案,该图案轮廓就是泳装裁剪样板的规定尺寸;另一类是与普通成衣服装面料图案一样非独立图案的整片坯布连续图案。由于泳装独立图案的设计难度更大、市场需求更多,因此,本研究将针对第一类图案需求,探究基于神经网络方法进行泳装特定区域图案风格迁移设计的可行性,寻求一种运用融合格拉姆矩阵和Canny边缘检测解决风格迁移中多风格融合与背景分割的问题。

在神经网络技术出现之前,傳统非参数的图像风格迁移工作主要是基于绘制物理模型及合成纹理。在深度学习[1]兴起之后,Gatys等[2]在2015年开创性地提出了基于卷积神经网络的图像风格迁移模型,极大提升了图像风格迁移方法的效果和可用性;在定义图像的风格和纹理方面,Erfos等[3]提出了一种对样本纹理进行重组拼接以合成新纹理的算法;Hertzmann等[4]提出一种通过推导图像特征映射之间的关系,并将其定义为风格的纹理特征。

传统的卷积神经网络风格迁移方法,大多选择VGG(Visual Geometry Group Network)模型作为特征提取器,运用VGG模型中某层提取出的结果构建格拉姆矩阵(Gram Matrix,GM)来量化图像的风格。但是该方法导致在风格迁移中输入的风格图像只能有一张,且将风格迁移技术运用到服装图案设计领域时,无法消除迁移过程中产生的冗余背景。本研究提出一种新的适用于辅助设计师进行泳装图案设计的风格迁移方法,通过改变格拉姆矩阵来实现多输入的风格迁移,并使用Canny边缘检测技术对生成图像进行处理。最终生成的泳装图像相较于传统风格迁移色彩更丰富,解决了传统风格迁移服装图案设计风格单调、纹理简单的缺点。

1 技术背景

1.1 卷积神经网络

本研究使用卷积神经网络来实现泳装风格迁移图案设计。卷积神经网络是一类包含卷积计算且具有深度结构的前馈神经网络,是深度学习的代表算法之一[5]。卷积神经网络核心操作是卷积,即自定义一个卷积核,将卷积核在原图上覆盖并逐像素滑动,将覆盖到的值和卷积核上的权重对应位置相乘求和并填在一张Feature map上。其作用是把卷积核定义的特征从原图中提取出来反映在Feature map上,每一个卷积核提取一种特征对应一张Feature map。

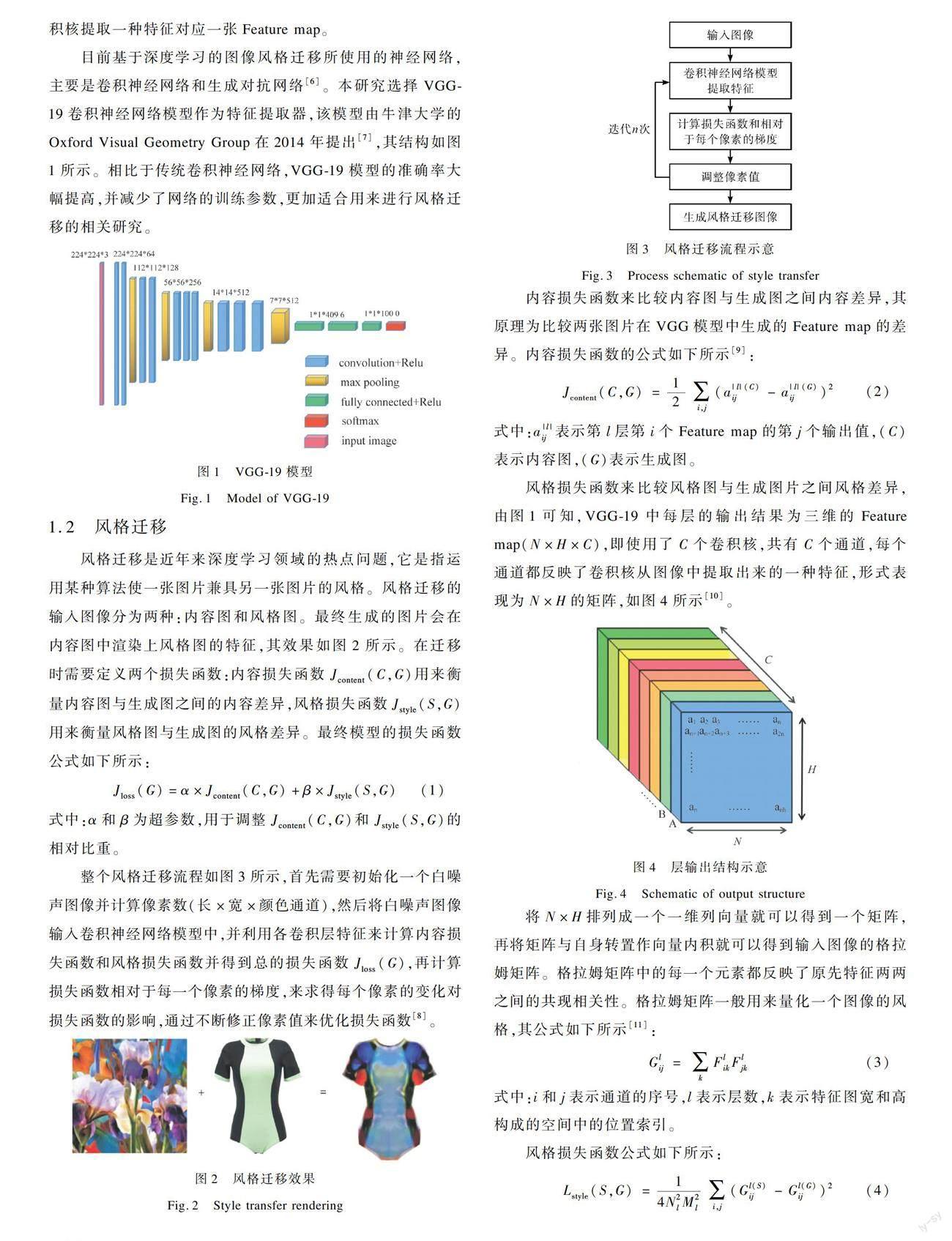

目前基于深度学习的图像风格迁移所使用的神经网络,主要是卷积神经网络和生成对抗网络[6]。本研究选择VGG-19卷积神经网络模型作为特征提取器,该模型由牛津大学的Oxford Visual Geometry Group在2014年提出[7],其结构如图1所示。相比于传统卷积神经网络,VGG-19模型的准确率大幅提高,并减少了网络的训练参数,更加适合用来进行风格迁移的相关研究。

1.2 风格迁移

风格迁移是近年来深度学习领域的热点问题,它是指运用某种算法使一张图片兼具另一张图片的风格。风格迁移的输入图像分为两种:内容图和风格图。最终生成的图片会在内容图中渲染上风格图的特征,其效果如图2所示。在迁移时需要定义两个损失函数:内容损失函数Jcontent(C,G)用来衡量内容图与生成图之间的内容差异,风格损失函数Jstyle(S,G)用来衡量风格图与生成图的风格差异。最终模型的损失函数公式如下所示:

Jloss(G)=α×Jcontent(C,G)+β×Jstyle(S,G)(1)

式中:α和β为超参数,用于调整Jcontent(C,G)和Jstyle(S,G)的相对比重。

整个风格迁移流程如图3所示,首先需要初始化一个白噪声图像并计算像素数(长×宽×颜色通道),然后将白噪声图像输入卷积神经网络模型中,并利用各卷积层特征来计算内容损失函数和风格损失函数并得到总的损失函数Jloss(G),再计算损失函数相对于每一个像素的梯度,来求得每个像素的变化对损失函数的影响,通过不断修正像素值来优化损失函数[8]。

内容损失函数来比较内容图与生成图之间内容差异,其原理为比较两张图片在VGG模型中生成的Feature map的差异。内容损失函数的公式如下所示[9]:

Jcontent(C,G)=12∑i,j(a|l|(C)ij-a|l|(G)ij)2(2)

式中:a|l|ij表示第l层第i个Feature map的第j个输出值,(C)表示内容图,(G)表示生成图。

风格损失函数来比较风格图与生成图片之间风格差异,由图1可知,VGG-19中每层的输出结果为三维的Feature map(N×H×C),即使用了C个卷积核,共有C个通道,每个通道都反映了卷积核从图像中提取出来的一种特征,形式表现为N×H的矩阵,如图4所示[10]。

将N×H排列成一个一维列向量就可以得到一个矩阵,再将矩阵与自身转置作向量内积就可以得到输入图像的格拉姆矩阵。格拉姆矩阵中的每一个元素都反映了原先特征两两之间的共现相关性。格拉姆矩阵一般用来量化一个图像的风格,其公式如下所示[11]:

Glij=∑kFlikFljk(3)

式中:i和j表示通道的序号,l表示层数,k表示特征图宽和高构成的空间中的位置索引。

风格损失函数公式如下所示:

Lstyle(S,G)=14N2lM2l∑i,j(Gl(S)ij-Gl(G)ij)2(4)

式中:(S)表示风格圖片,(G)表示生成图片,N表示卷积核的个数,M表示卷积核的大小。

2 基于卷积神经网络的风格迁移泳装图案设计方法

在将传统卷积神经网络风格迁移运用到泳装图案设计中

时,由于只能输入一张风格图片,用于定义风格损失的格拉姆矩阵形式表现为单一元素的矩阵,故生成的泳装图案风格单一、纹理简单,且无法消除迁移过程中产生的冗余背景。本研究提出一种新的适用于泳装图案设计的风格迁移方法,通过改变格拉姆矩阵和损失函数优化方法来实现多输入的风格迁移,并使用Canny边缘检测技术对生成图像进行处理,流程如图5所示。

首先根据内容图随机初始化一张高斯白噪声图像输入模型中,同时使VGG-19提取输入的内容图与多张风格图的特征。利用内容图在conv5_2层得到的特征图与白噪声图像在conv5_2层得到的特征图求出内容损失函数;利用风格图在conv1_1层、conv2_1层、conv3_1层、conv4_1层、conv1_2层、conv2_2层、conv3_2层、conv3_3层、conv3_4层、conv4_2层、conv4_3层、conv4_4层输出计算出的新格拉姆矩阵Gnew与白噪声图像在风格层的格拉姆矩阵求出风格损失函数;并使用设置好的超参数α和β求出总损失函数和损失函数相对于原始图像每个像素的梯度,将结果输入优化器中,使用L-BFGS算法来优化损失函数,不断迭代此过程生成泳装风格迁移图像。将生成图像输入边缘检测模型中,画出所有轮廓并将所有轮廓闭合,通过计算闭合后的轮廓周长和面积筛选出泳装轮廓来分割出最终的泳装图案设计图。

2.1 格拉姆矩阵优化

本研究为实现多风格迁移将n张风格图像输入VGG-19模型中,使指定为风格输出的层分别提取各张风格图像的特征并输出,分别计算每一张图像的格拉姆矩阵如式(5)所示,矩阵中X1-2表示通道1与通道2之间的共现相关性。通过特征值之间的共现相关性来表示一个图像的风格,再将所有格拉姆矩阵加权形成新的矩阵Gnew,权重参数的个数需要与风格图像张数相同,如式(6)所示,并将该矩阵作为本层的结果代入风格损失函数进行计算。

G=X1-1X1-2…X1-CX2-1X2-2…X2-CXC-1XC-2…XC-C(5)

Gnew=aG1+bG2+cG3+…+nGn(6)

式中:G1、G2、G3、Gn为各张输入风格图像的格拉姆矩阵,a、b、c、n为各个格拉姆矩阵权重,可自行设定,此时矩阵Gnew拥有本层提取出的所有输入风格图像的特征。

2.2 损失函数优化

在卷积神经网络中,越深的层就越能提取图片中抽象、全局的特征,能够更好地衡量内容图与生成图之间的差异,所以一般选择高层的输出定义内容,本研究选择conv5_2层的输出来计算内容损失。为了同时提取风格图底层特征与高层特征,增强生成泳装图案的风格,本研究增加了风格损失函数计算的层数,选择使用由conv1_1层、conv2_1层、conv3_1层、conv4_1层、conv1_2层、conv2_2层、conv3_2层、conv3_3层、conv3_4层、conv4_2层、conv4_3层、conv4_4层输出计算出的格拉姆矩阵代入风格损失函数。此时风格损失函数如下所示:

Lstyle(S,G)=∑lw|l|·L|l|style(S,G)(7)

式中:w|l|为参与计算的各层的权重系数。

在迭代过程中,由于需要不断修正像素值来优化损失函数,为了使最终的生成图像更加平滑,具有空间连续性,本研究将相邻像素值差的平方作为正则化项加入最终的总损失函数中[12],公式如下所示:

Lt=wt×∑CC=1∑H-1i=1∑Wj=1(xi+1,j,c-xi,j,c)2+∑CC=1∑Hi=1∑W-1j=1(xi,j+1,c-xi,j,c)2(8)

式中:wt为权重;C、N、H分别表示通道数、宽和高,与图4中定义相同;xijc表示表示第C层第i行第j列的像素值。

一般卷积神经网络风格迁移使用随机梯度下降法来优化损失函数[13],但随机梯度下降法存在精准度较低、收敛速度较慢等缺陷,对多输入风格迁移的效果较差。本研究选择具有更快收敛速度的L-BFGS算法来优化损失函数。在深度学习中函数最优化问题的本质是寻找其导函数为零的点或近似点来作为算法表现最好的点,Hessin矩阵是牛顿法求驻点在深度学习领域的延伸,BFGS算法是通过迭代不断逼近Hessin矩阵的近似正定矩阵的算法,其公式如下所示[14]:

Hk+1=Hk+ykyTkyTksk-Hksk(Hksk)TsTkHksk(9)

式中:yk为梯度更新量,sk为速度模型更新量。

BFGS算法在运算时需要储存和计算的量很大,而L-BFGS算法直接利用保存在存储器中的数据,节省了大量储存空间和计算量,因此常用于深度学习中的损失优化。本研究同时计算损失函数和损失函数相对于每个像素的梯度,将结果输入优化器,通过不断迭代来降低损失[15]。

2.3 Canny边缘检测

上述步骤生成的图像除了泳装之外,还有大量冗杂的背景,本研究使用Canny边缘检测算法来处理风格迁移生成的图像,提取出泳装款式图。其主要处理过程分为5步[16]:

1) 使用高斯滤波器,以平滑图像,消除噪声。

2) 增强图像。在风格迁移生成图中泳装边界像素点与背景像素点之间具有较大差值,计算图像中每个像素点的梯度强度与方向。本研究选择Sobel算子来计算梯度,将被卷积核扫描的3×3的像素点值xij设为矩阵A[17]:

A=x11x12x13x21x22x23x31x32x33(10)

设横向梯度为Gx,纵向梯度为Gy,利用Sobel算子x与y方向矩阵Sobel-X和Sobel-Y与矩阵A做卷积则可得Gx和Gy,分别为[18]:

Gx=Sobel-X×A=-1-2-1000121×A(11)

Gy=Sobel-Y×A=-101-202-101×A(12)

梯度方向Angle(θ)为:

Angle(θ)=tan-1GyGx(13)

梯度大小G为:

G=G2x+G2y(14)

3) 应用非极大值抑制,以消除检测泳装边缘时带来的杂散效应[19]。

4) 应用双阈值检测来确定边缘。

5) 通过抑制弱边缘来完成最终边缘检测。

3 实 验

3.1 搭建环境

本研究的软件环境为PyCharm,以TensorFlow 2.6.0作为风格迁移的深度学习框架。硬件环境使用了配备NVIDIA Quadro RTX 5000显卡的高性能计算机,内存64 G,处理器为Intel(R) Xeon(R) Silver 4215R CPU@3.20GHz。

3.2 设 定

3.2.1 实验风格图选取

遴选绘画艺术流派作为实验对象,共选取毕加索、葛饰北斋、蒙德里安、安德烈·德朗等画家的作品和中国传统文化代表之一的青花瓷,作为风格图片输入模型进行训练内容图选择了基础款泳装图片。

3.2.2 超参数设置

超参数是内容损失函数权重,超参数β是风格损失函数权重。α越大最终迁移图会越接近内容图的内容,β越大最终迁移图会越接近风格图的风格。本研究从迁移效果与边缘分割精确度的角度考虑,经过多次实验,最终设置α=0.01,β=1。

3.2.3 迭代次数设置

在实验中当迭代次数不断增加,迁移图像的风格化程度也不断加深,当迭代次数大于50次时,泳装边缘轮廓会逐渐失真,且泳装部分区域会出现色块;当迭代次数在20~40次时,视觉效果与评价指标差异并不大。从节约计算资源与时间角度考虑,本实验最终选择20次迭代,生成的泳裝图像大小为400×400像素。

4 结果分析

4.1 风格迁移结果

本研究将《女子》《拿书的女人》《哭泣的女人》《星月夜》《查林十字桥》《红、蓝、黄的构成》《百老汇爵士乐》不同流派风格的7幅画和青花瓷图片,采用随机配对形式每三幅为一组输入模型,最终生成结果,如图6所示。

4.2 生成图像处理

4.2.1 正面图像处理

在风格迁移生成图像中,除了有实验所需要的设计成品之外,还有实验不需要的与泳装纹理相似的背景,故本研究选择使用Canny边缘检测对图像进行处理,识别并分割出需要的服装图案设计图。本研究通过如下3个步骤来实现图像分割:

1) 将风格迁移生成图像转化为灰度图并将图像局部二值化。

2) 在消除噪声后运用Canny边缘检测算法识别并画出图像中所有轮廓,再将轮廓线闭合后通过计算所有轮廓的周长和面积来腐蚀不需要的背景。

3) 制作掩膜并填充便可以得到分割后的泳装图像,图7展示了图像处理过程中的(a)原图、(b)边缘检测图、(c)掩膜图和(d)轮廓图。

在对泳装正面的图案设计中,由于透视与泳装款式设计的缘故,泳装的胯部与肩带处的灰色区域属于泳装内侧,不需要渲染图案,本研究通过使用OpenCV图像处理库对该区域进行处理。在泳装正面的原图中,渲染区域与非渲染区域存在明显的色差与面积差异,使用Canny边缘检测将原图中所有闭合区域画出,并按照面积从大到小排序,再将原图转换为HSV图,求出所有闭合区域内各个像素的HSV数值。由于色差明显,非渲染区域的HSV区间和渲染区域的HSV区间存在明显差异,可以提取出非渲染区域,如图8所示。经过实验,本研究的非渲染区域HSV区间设定为H:0~195,S:0~43,V:46~220。将图8非渲染区域图与图7(d)轮廓图修改为同样大小,叠加后便可得到最终的泳装正面生成图,如图9所示。

4.2.2 侧面图像处理

泳装的侧面图除胯部与肩带处的泳装内侧不需要迁移之外,肩带之间和腿部的空隙也无需迁移。针对泳装款式这一特点,本研究的边缘处理模型方法步骤为:首先对泳装侧面原图进行处理,利用灰度差异和色差提取出侧面非渲染区域图和遮罩图,再将侧面图风格迁移后使用Canny边缘检测分割出泳装侧面轮廓图,然后将遮罩图及非渲染区域图与泳装侧面轮廓图叠加后进行裁剪便可得到最终的泳装侧面生成图,流程如图10所示。

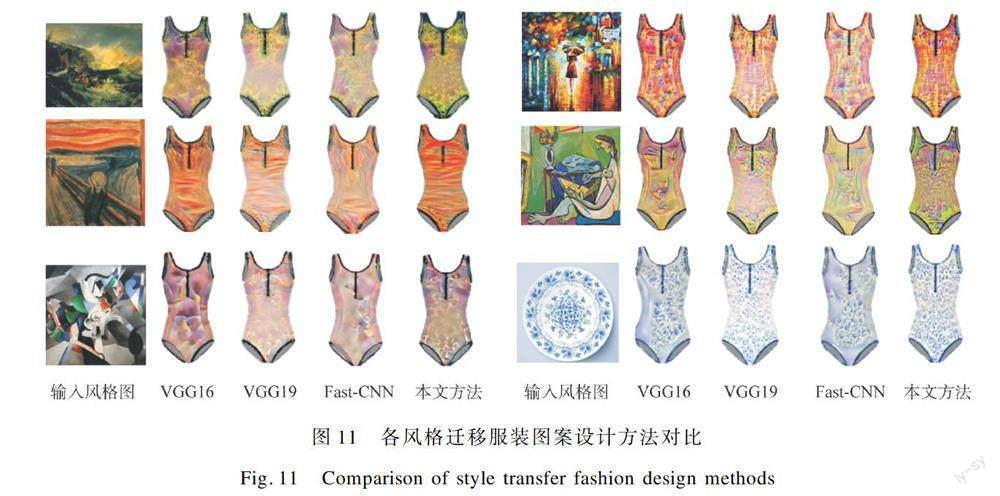

4.3 与其他方法比较

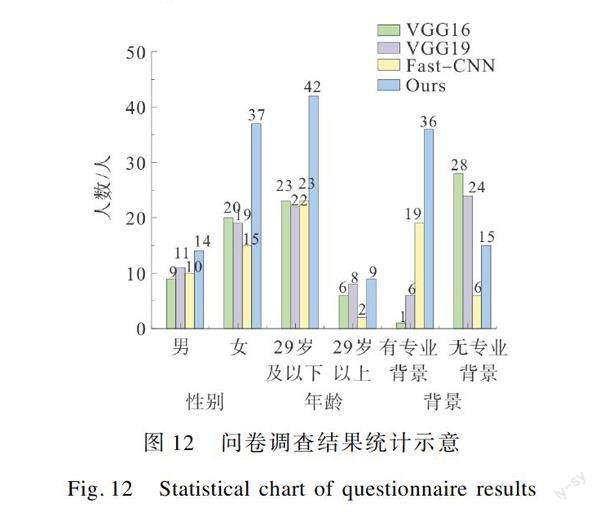

为了验证本研究在服装图案设计领域的有效性,将本研究生成的效果图与其他卷积神经网络风格迁移方法的效果图进行对比,如图11所示,所选风格图分别为《运输船遇难》《雨中女郎》《呐喊》《缪斯女神》《皮卡比亚》和青花瓷盘。由于对风格迁移泳装图案设计的效果很难单独使用客观指标进行评价,本研究采用主客观结合的形式,使用问卷调查评分、PSNR、SSIM这3种指标进行比较。

4.3.1 主观评价

调查问卷从设计的风格满意度、色彩满意度、纹理满意度三个方面进行调查,选项为评分制,共设1~5分共5个选项,三项总分视为实验对象对该组结果的最终评价。

本研究问卷调查共选取实验对象135人,其中男性44人,女性91人;拥有服装相关专业背景55人,无服装相关背景80人;年龄分布29岁及以下110人,29岁以上25人。将实验对象对三组泳装图案设计结果评价的最高分视为对该组的偏好,问卷调查结果如图12所示。

4.3.2 客观评价

本研究选择峰值信噪比PSNR(Peak Signal-to-Noise Ratio)和结构相似性SSIM(Structural Similarity)作为评价迁移效果的客观指标。

峰值信噪比PSNR是一个表示信号最大可能功率和影响表示精度的破坏性噪声功率的比值的工程术语,常被用来衡量图像的质量,PSNR越大,代表生成图像的质量越好。结构相似性SSIM是衡量两张图片相似度的指标,本研究将生成的泳装图像和原图像进行对比,可以用来判断风格迁移过程中对泳装轮廓造成的影响;SSIM取值范围为[0,1],SSIM越大,代表生成图像的质量越好。

将100幅不同的风格图像输入四种方法并测量生成图像的PSNR和SSIM大小取均值进行对比,结果如图13和图14所示。

由图12的问卷调查结果可知,在生成效果方面,本研究方法在不同年龄、性别、专业背景的被调查人均给出比更高的评价。由图13和图14可知,本研究方法与其他三种方法相比,生成图像质量更高,结构上也与原图更接近。

5 结 论

本文采用卷积神经网络VGG-19模型作为风格迁移的特征提取器,提出了一种运用卷积神经网络风格迁移辅助设计师进行泳装图案设计的方法。通过改变格拉姆矩阵并结合Canny边缘检测技术,可以提取多张绘画作品的艺术风格来与泳装图案设计结合,且具有自动识别分割功能,能精准地将设计成果从复杂的背景中提取出来。本研究將绘画艺术风格与泳装的图案设计结合,能够以极低的成本设计出大量富有多风格融合特征的泳衣图案,具有巨大的应用前景。后续将针对边缘检测与图像分割的精度和其他风格迁移算法进行深入研究。

参考文献:

[1]LECUN Y, BENGIO Y, HINTON G. Deep learning[J]. Nature, 2015, 521(7553): 436-445.

[2]GATYS L A, ECKER A S, BETHGE M. A neural algorithm of artistic style[J]. Journal of Vision, 2015, 22(11): 54-65.

[3]EFROS A A, FREEMAN W T. Image quilting for texture synthesis and transfer[C]//Proceedings of the 28th Annual Conference on Computer Graphics and Interactive Techniques. New York: ACM Press, 2001: 341-346.

[4]HERTZMANN A, JACOBS C E, OLIVER N. Image analogies[C]//Proceedings of the 28th Annual Conference on Computer Graphics and Interactive Techniques. New York: ACM Press, 2001: 327-340.

[5]林碧珺, 耿增民, 洪颖, 等. 卷积神经网络在纺织及服装图像领域的应用[J]. 北京服装学院学报(自然科学版), 2021, 41(1): 92-99.

LIN Bijun, GENG Zengming, HONG Ying, et al. Application of convolutional neural network in textile and clothing image field[J]. Journal of Beijing Institute of Fashion Technology (Natural Science Edition), 2021, 41(1): 92-99.

[6]KIM M S, CHOI H C. Uncorrelated feature encoding for faster image style transfer[J]. Neural Networks, 2021, 140: 148-157.

[7]XIANG S C, FU Y Z, LIU T. Progressive learning with style transfer for distant domain adaptation[J]. IET Image Processing, 2020, 14(14): 3527-3535.

[8]WANG C X, LU Y T, CHEN Z J, et al. An efficient method for training deep learning networks distributed: Special section on parallel, distributed, and reconfigurable computing, and networking

[J]. IEICE Transactions on Information and Systems, 2020(12): 2444-2456.

[9]CHONG Y W, PENG C W, ZHANG J J, et al. Style transfer for unsupervised domain adaptive person re-identification[J]. Neurocomputing, 2020, 422: 314-321.

[10]LI J Y, WANG Q, CHEN H et al. A review on neural style transfer[J]. Journal of Physics: Conference Series, 2020, 1651(1): 21-23.

[11]WANG J J, MA Y L, ZHANG L B, et al. Deep learning for smart manufacturing: Methods and applications[J]. Journal of Manufacturing Systems, 2018, 48: 144-156.

[12]DING H, FU G, YAN Q A, et al. Deep attentive style transfer for images with wavelet decomposition[J]. Information Sciences, 2022, 587: 63-81.

[13]苗永康. 基于L-BFGS算法的时间域全波形反演[J]. 石油地球物理勘探, 2015, 50(3): 469-474.

MIAO Yongkang. Full waveform inversion in time domain based on limited memory BFGS algorithm[J]. Oil Geophysical Prospecting, 2015, 50(3): 469-474.

[14]俞海龙, 冯晅, 恩和得力海, 等. 基于梯度法和L-BFGS算法的探地雷达时间域全波形反演[J]. 物探化探计算技术, 2018, 40(5): 623-630.

YU Hailong, FENG Xuan, EN Hedelihai, et al. Time-domain full waveform inversion of ground-penetrating radar using gradient method and L-BFGS algorithm[J]. Computing Techniques for Geophysical and Geochemical Exploration, 2018, 40(5): 623-630.

[15]趙睿颖. 用于深度学习的一种改进L-BFGS算法[J]. 首都师范大学学报(自然科学版), 2021, 42(5): 8-14.

ZHAO Ruiying. An improved L-BFGS algorithm for deep learning[J]. Journal of Capital Normal University (Natural Science Edition), 2021, 42(5): 8-14.

[16]DONG L, SHENG H P. Improved Canny edge detection algorithm based on deep learning[J]. Scientific Journal of Intelligent Systems Research, 2021, 3(2): 114-118.

[17]HUA Q Z, KE L T, CHI Z, et al. Image segmentation based on GGVF Snake model and Canny operator[J]. Scientific Journal of Intelligent Systems Research, 2021, 3(3): 130-137.

[18]李磊, 李英娜, 赵振刚. 基于改进Canny算子的输电导线图像边缘检测[J]. 电力科学与工程, 2021, 37(12): 19-27.

LI Lei, LI Yingna, ZHAO Zhengang. Edge detection of transmission line image based on improved Canny operator[J]. Electric Power Science and Engineering, 2021, 37(12): 19-27.

[19]ZHANG H Z, LIANG J S, JIANG H B, et al. Lane line recognition based on improved 2D-gamma function and variable threshold Canny algorithm under complex environment[J]. Measurement and Control, 2020, 53(9/10): 1694-1708.

Design of style transfer swimsuit patterns based on convolutional neural network

CHENG Pengfeia, WANG Weizhena,b, FANG Yuanc

(a.School of Fashion; b.Clothing Human Factors and Intelligent Design Research Center; c.Engineering Training Center(Innovation and Entrepreneurship Education Center), Dalian Polytechnic University, Dalian 116034, China)

Abstract:

With the penetration of artificial intelligence technology into various fields, the combination of artificial intelligence and art design provides a broader prospect for the intelligent design of clothing. As an active topic of deep learning of artificial intelligence, style transfer starts to be used in the fields of clothing pattern design and art painting. At present, there are many technical shortcomings in using style transfer technology for clothing pattern design. When style transfer based on the convolutional neural network is applied to clothing pattern design, the problems of monotonous color, simple texture and inability to remove redundant backgrounds arise. Therefore, this study explores an integration of Gram matrix and Canny edge detector to solve the problem of multi-style fusion and background segmentation in style transfer.

In this study, in order to realize multi-style transfer, we first input multiple style images into the VGG-19 model, so that the layers designated as style output can extract the features of each style image and output them separately. We calculate the Gram matrix of each image separately, and weight all the obtained Gram matrices to form a new matrix. Therefore, the co-occurrence and correlation of each channel in the new matrix can represent the fusion style. In order to deal with the redundant backgrounds generated in the style transfer process and the non-rendered areas due to the features of swimsuit styles, we adopt the Canny edge detector algorithm and the OpenCV image processing library to perform operations such as rendering segmentation of images using the HSV interval differences of different rendered areas of swimsuit, and finally obtain the swimsuit pattern design drawings. Compared with other convolutional neural networks whose style transfer can only extract the style of one image, we optimize the structure of the Gram matrix, and can extract the style of multiple images to transfer at the same time. In the processing of the image generated by style transfer, by analyzing the structure and design features of swimsuit, a clothing image segmentation model applicable to swimsuits is established. In order to verify the effectiveness of this study in the field of clothing pattern design, we compare the effect drawings generated in this study with those generated by the style transfer method of other convolutional neural networks using the three metrics of questionnaire score, PSNR, and SSIM, and the results show that the method of this study obtains higher evaluation in all the three metrics.

This study, by combining the painting art style with swimsuit pattern design, is able to design a large number of swimsuit patterns with multi-style fusion features at a very low cost and has great application prospects. There is still room for improvement in the accuracy of swimsuit image segmentation in this study, and further research will be conducted in this area.

Key words:

convolutional neural network; style transfer; swimsuit; pattern design; Canny edge detector; swimsuit image segmentation

收稿日期:

2022-06-24;

修回日期:

2023-01-27

基金項目:

教育部社会科学规划基金项目(21YJAZH088);教育部产学协同育人项目(220404211305120);辽宁省教育厅高校基本科研重点攻关项目(LJKZZ20220069);辽宁省教育厅项目(1010152);中国纺织工业联合会项目(2021BKJGLX321)

作者简介:

程鹏飞(1999),男,硕士研究生,研究方向为人工智能服装设计。通信作者:王伟珍,副教授,wz-wang@foxmail.com。