其?险点到底在哪???智能“淘?热”是公司追求利润的产物?

最近,很多人收看了RightsCon大会的一系列讲座。这是世界上最大的数字权利会议,经过数年的网络会议之后,顶级互联网伦理学家、活动家和政策制定者终于再次回到了哥斯达黎加。

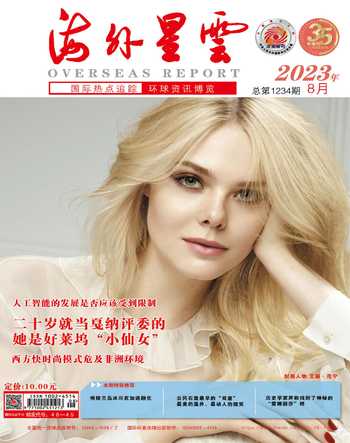

不出所料,每个人都在谈论人工智能和最近的大型语言模型热潮。在会议之前,联合国发表了一份声明,鼓励RightsCon与会者关注人工智能的监督和透明度。

然而,感到惊讶的是,RightsCon上关于生成式人工智能风险的对话与在新闻中看到的“硅谷大佬警告”有多么不同。

在过去的几周里,OpenAI首席执行官萨姆·奥特曼、人工智能先驱杰弗里·辛顿、顶级人工智能研究员约书亚· 班吉奥、埃隆·马斯克和其他许多科技名人一直在呼吁监管和采取紧急行动,以解决(人工智能带来的)“生存风险”,甚至包括人工智能灭绝人类的可能性。

当然,在没有风险评估、没有披露训练数据和流程的情况下,快速部署大型语言模型,或者似乎非常关注技术如何被滥用,这令人担忧。但在RightsCon的幾次会议上,一些演讲者强调,人工智能淘金热是公司追求利润的产物,而不一定是监管不力或技术上不可避免的发展趋势。

在第一次会议上,《连线》的首席编辑吉迪恩·利奇菲尔德和数字未来实验室的创始人乌尔瓦西·阿内贾与谷歌的肯特·沃克针锋相对。

利奇菲尔德说:“微软的萨蒂亚·纳德拉说,他想让谷歌加入战局。谷歌也这样做了。现在,我们所有人都被迫加入其中,因为这两家公司都在试图打败对方。”对此,沃克强调了人工智能的进步可能在药物发现等领域带来的社会效益,并重申了谷歌对人权的承诺。

第二天,人工智能研究人员提米特·格布鲁直接谈到了人工智能带来的生存风险:“将机构归为一种工具是一个错误,这是一种转移注意力的策略。如果你看到谁说这样的话,那么这些人很可能向这些公司投资了数十亿美元。”

她说:“就在几个月前,杰夫·辛顿还在谈论GPT-4,以及它是如何成为世界上最靓丽的蝴蝶——它就像一只毛毛虫获取数据,然后羽化成一只美丽的蝴蝶。突然之间,它变成了一种生存风险。我的意思是,人们为什么要认真对待这些人?”

人权观察的技术和人权总监弗雷德里克·卡尔特纳等专家对围绕人工智能的叙述感到失望,他们建议将自己置于我们已知的、困扰人工智能的风险中, 而不是猜测可能会发生什么。

人工智能的使用带来了一些明显的、有迹可循的危害。它们包括:

错误信息的增加和放大:Instagram、Twitter和YouTube等社交媒体平台上的推荐算法已被证明,无论准确性如何,都会优先推广极端和情感上令人信服的内容。大语言模型通过产生被称为“幻觉”的以假乱真的错误信息放大了这个问题。

有偏见的训练数据和输出:人工智能模型往往是在有偏见的数据集上训练的,这可能导致有偏见的输出,进而可能加剧现有的社会不平等,比如评估某些福利时存在歧视的算法,或者面部识别系统对深色皮肤人种的识别准确度不如白人。ChatGPT 散布种族主义内容的案例也比比皆是。

侵犯用户隐私:训练人工智能模型需要大量数据,这些数据通常是从网上找到或购买的,这引发了关于获得所有者同意和隐私的问题。开发大型语言模型(如 ChatGPT和Bard)的公司,尚未发布太多关于用于训练它们的数据集的信息,尽管它们肯定包含大量来自互联网的数据。

卡尔特纳表示,她特别担心生成式人工智能聊天机器人会被部署在心理健康治疗等高风险场景中:“我担心,生成式人工智能在技术不适合或目的不恰当的情况下,会出现特别鲁莽的使用案例。”

格布鲁重申了对运行复杂的大型语言模型所需的大量计算能力所造成的环境影响的担忧(她表示,自己因在内部研究中提出这些和其他问题而被谷歌解雇)。她指出,ChatGPT的内容审查员在薪水不高的情况下,仍在努力降低模型输出内容的毒性,由此也经历了创伤后应激障碍。

关于对人类未来的担忧,卡尔特纳问道:“谁的灭绝?整个人类的灭绝?我们已经看到历史上被边缘化的人在此刻正在受到伤害。这就是为什么我觉得灭绝的说法有点没找到重点。”