基于多特征融合的参数再合成语音增强算法

郑晨颖,马建芬+,张朝霞

(1.太原理工大学 信息与计算机学院,山西 晋中 030600;2.太原理工大学 物理与光电工程学院,山西 晋中 030600)

0 引 言

在理想情况下,语音增强系统应该完全消除噪声而不降低语音质量。语音增强的一般方法是对含噪语音进行处理,使其更接近干净语音,但是这类方法会由于对语音的过抑制在语音信号中引入额外的失真[1,2]。文本-语音(text-to-speech,TTS)合成系统通过训练声学模型将文本特征映射到声码器的时变声学参数上,然后由声码器生成语音,从而从文本输入产生高质量的语音。然而这类系统存在的问题是无法从纯文本中预测真实的韵律[3]。Soumi Maiti等[4]提出了使用干净语音声码器参数作为目标的神经网络进行语音增强的参数再合成(parametric resynthesis,PR)方法,结合了一般的语音增强算法和TTS,该方法主要分为预测和合成两个阶段,其预测模型是一种神经网络,以噪声的Mel频率倒谱系数(Mel frequency cepstrum coefficient,MFCC)特征作为输入,在固定帧率下预测干净语音的声学特征;在合成阶段利用传统的基于源滤波器WORLD声码器实现语音参数与纯净语音波形之间的转换。该系统的主要问题是使用单一声学特征MFCC进行预测以及非神经网络声码器WORLD声码器进行语音合成,这会导致在复杂的噪声环境下系统的增强性能大幅度下降。

针对以上问题,在基于参数再合成的语音增强算法上从噪声中分别提取GFCC、MFCC和韵律特征后进行注意力融合,采用综合特征代替单一特征预测干净语音的声学参数,并用神经网络声码器WaveNet声码器合成干净语音,从而在预测和合成两个方面同时提高语音质量。

1 传统的参数再合成语音增强算法

传统的参数再合成的增强方法分为预测和合成两个阶段,具体框架如图1所示,第一阶段是训练一个以含噪语音的声学特征(MFCC)作为输入,干净语音的声学特征作为输出的预测模型,预测的声学特征和干净的声学特征之间的均方误差最小;第二阶段是利用非神经网络WORLD声码器从预测的干净语音声学特征中重新合成语音。

图1 基于参数再合成的语音增强算法框架

2 基于多特征融合的参数再合成语音增强方法

在基于参数再合成的语音增强算法基础上的改进点主要为:采用注意力机制进行多种声学特征融合;然后采用多特征融合特征代替单一特征MFCC预测干净语音声学特征,通过结合不同特征,为预测模型提供更多可区分和互补的特征表示,从而保留更多关于干净语音的信息;最后为了避免在低信噪比下WORLD声码器合成语音质量较差的问题,提出采用神经网络声码器WaveNet声码器代替WORLD声码器合成干净语音,算法具体框架如图2所示。

图2 基于注意力机制多特征融合的参数再合成语音增强算法框架

2.1 基于注意力的多特征融合

2.1.1 多种特征的选择

基于参数再合成语音增强系统是采用含噪语音的单一声学特征(MFCC)进行干净语音的预测,MFCC特征[5]虽然考虑了人耳对频率的非线性感知特性,但是在提取MFCC时使用的三角形滤波器组对耳蜗基底膜分辨频率的特性模拟效果较差,在语音的低频部分具有较高的频率分辨能力,但是高频部分信息被一定程度的弱化,因此在复杂的噪声环境中单一使用MFCC的效果较差。基于Gammatone滤波器组的伽马通倒谱系数(Gammatone frequency cepstral coefficients,GFCC)特征[6]在处理带噪语音信号方面表现出了良好的能力,GFCC提取过程所使用Gammatone滤波器组是一组具有类似人类听觉滤波器的幅度特性的高脉冲响应滤波器,它的非线性形有助于其更好地模拟人类听觉系统的感知过程。GFCC的高抗干扰能力还来自于采用对数压缩来模拟人耳听觉系统的非线性特性,即对滤波器的输出进行对数压缩[7]。Shi等[8]使用GFCC进行说话人识别,他们发现GFCC相比MFCC在噪声环境下的识别率显著提高了,特别是在信噪比较低时,但同时发现在高信噪比情况下,GFCC的表现并不优于MFCC。

生活中的交流通常依赖语义来表达,但是实际上当我们处于不同情绪中表达同样的语句时向外传递出的信息可能不同,因此这些不同情绪的表征和区分在识别说话人和语音情感识别中至关重要,而在语音增强任务中我们在去除噪声的同时要尽可能最大限度地保留原始语音信息,所以不同情绪的表征和区分在语音增强任务中也很重要。语音的不同情绪可以通过韵律特征进行表征,最常用的韵律特征有短时过零率、短时平均能量、基音频率、共振峰等。例如,在“高兴”、“愤怒”、“中性”3种情感状态下由同一个说话人说同一句话,结果可以看出“高兴”状态下的短时平均过零率最高,“高兴”和“愤怒”状态下的短时平均能量较高,基音频率在“高兴”、“愤怒”时较高且频率变换较快,在“高兴”、“愤怒”时第二共振峰的变化范围较小,而在“中性”时第二共振峰的变化范围明显变大。

除了单个声学特征的研究,研究者们还对声学特征的组合或延伸进行了研究,王华朋等[9]就对比了3种特征组合方式下情感识别的识别效果,并通过实验验证了MFCC和GFCC与韵律特征组合的方法提高了情感识别的正确率和稳定性。综上,提出将MFCC、GFCC与韵律特征这一声学特征组合应用于语音增强中。

2.1.2 基于注意力机制的多特征融合

为了提高系统性能,通常会融合多个基于不同声学特征的子系统。有研究者[10]比较了多种声学特征融合架构在说话人验证和语音识别中的表现,如等权重融合、帧级融合、多层次融合以及嵌入融合等,经过实验验证帧级融合是最优策略。

我们可以在吵闹嘈杂的环境中自如的与他聊天交流,这是因为人类在听觉感知过程中可以将自己的注意力放在目标声音上,从而自动忽略嘈杂的背景噪声,这一现象被称为鸡尾酒会效应,鸡尾酒会效应表明了人类的听觉注意力特性在处理复杂背景噪声场景里是至关重要的[11]。受此启发提出通过在帧级融合中引入注意力机制进行多特征融合用于语音增强任务,通过增强区分干净语音部分和噪声部分的特征提高系统的去噪性能。

(1)帧级多特征融合

帧级多特征融合可以利用多种声学特征的互补性,具体结构如图3所示。在该结构中,多个声学特征同时训练模型,在池化层之前,将多个特征融合为一个综合特征。

图3 多特征帧级融合结构

设 (X1,X2,X3) 表示来自同一语音帧的3种声学特征向量,Y表示融合后的综合特征如式(1)所示

Y=f4(cat(f1(X1;θ1),f2(X2;θ2),f3(X3;θ3);θ4)

(1)

其中,cat(·) 表示连接操作,f1(X1;θ1) 为给定网络参数θ1声学特征X1的预投影,同理f2(X2;θ2) 为给定网络参数θ2声学特征X2的预投影,f3(X3,θ3) 为给定网络参数θ3声学特征X3的预投影,f4(θ4;·) 指完全连接的拼接层映射。

(2)基于注意力的多特征帧级融合

在帧级多特征融合结构中的TDNN层计算之后的特征可认为是用于语音增强的信息,但是,对于3个特征最后的TDNN层之间的输出可能仍然存在冗余,可能没有完全强调用于语音增强的有用信息。受到“鸡尾酒会效应”的启发,本文使用拼接层执行注意力来进行多特征学习,使综合特征能够更多强调干净语音部分和噪声部分的区分并且不丢失其它有用信息。

多特征基于帧级注意力结构的融合即将注意力加在拼接层内(具体结构如图4所示),注意机制是通过计算上下文和位置编码的权重来实现语音增强任务更重要的特征来减轻多个特征之间的冗余。Yatt表示基于注意力机制融合的综合特征,如式(2)所示

图4 多特征帧级注意力融合结构

Yatt=f4(attRL(cat(f1(X1;θ1),f2(X2;θ2),f3(X3;θ3));θ4)

(2)

其中,attRL表示从L到R语境下的注意力学习。

2.2 基于WaveNet的神经网络声码器

传统的基于参数再合成的语音增强算法利用WORLD声码器[12]实现了声音参数与纯净语音波形之间的转换,WORLD声码器比其它传统声码器处理速度快且需要的训练数据较少,但是却对输入语音帧的信噪比有较高的要求。Van den等提出了一种基于自回归网络模型WaveNet,该模型直接在原始波形层面对语音信号建模,并采用扩大因果卷积网络结构增加波形序列上的接受野,保证了整个网络的输入分辨率和计算效率。Tamamori等[13]提出了基于WaveNet模型的声码器,对语音参数和语音波形之间的关系进行建模,打破了原有线性滤波框架,改善了传统声码器性能。目前合成语音和人类自然语音已较为贴近,其显著的进步主要是因为WaveNet架构导致基于信号处理的声码器被神经网络声码器所取代。综上,为了解决在低信噪比下WORLD声码器合成语音质量较差的问题,本文提出使用WaveNet声码器代替非神经网络声码器WORLD声码器合成干净语音。

将输入的语音信号的声学特征作为条件h输入WaveNet模型即可构造WaveNet声码器,WaveNet可以模拟给定这个输入语音的条件分布,如式(3)所示

p(x|h)=∏Tt=1p(xt|x1,x2,…,xt-1,h)

(3)

其中,h为条件序列,它的采样频率一般会低于语音波形的采样频率,为了能够具有相同的时域分辨率,WaveNet声码器使用转置卷积网络(transposed convolution network)对这个时间序列进行变换,将其映射为与语音信号具有相同时域分辨率的时间序列y=f(h), 然后使用如下所示的激活函数

z=tanh(Wf,k*x+Vf,k*y)⊙σ(Wg,k*x+Vg,k*y)

(4)

其中,*表示卷积运算,⊙为点乘运算,σ(·) 为Sigmoid函数,W为可学习的卷积滤波器,Wf,k表示网络中第k层处理历史语音波形信息的滤波卷积权值矩阵,相应地,Wg,k表示门控卷积权值矩阵。Vf,k、Vg,k分别表示第k层处理条件输入的卷积权值矩阵和门控卷积权值矩阵。

WaveNet声码器的模型结构如图5所示,在训练阶段,以预测的干净语音信号的声学特征和干净语音波形序列作为模型的条件输入和输出对模型参数训练;在生成阶段,根据预测的声学特征和历史波形信息模拟各个采样点的条件概率分布,然后通过逐点自回归生成语音波形。

图5 WaveNet声码器网络结构

3 实验和结果分析

3.1 实验配置

实验中使用的语音均来自于TIMIT语料库,TIMIT语料库包含了来自不同说话人所说的6300条干净语音,其中训练集中有4620句,测试集中有1680句。实验中所用的噪声来自NOISEX-92数据库,NOISEX-92语料库中共有15种噪声。本文设置在4种信噪比(-5 dB,0 dB,5 dB,10 dB)下,将TIMIT训练集中的4000条干净语音与NOISEX-92的4种噪声(white,Factory1,Pink,F16)叠加得到64000(4000×4×4)条含噪语音,加噪后的含噪语音与其相对应的干净语音共同作为训练集。在测试过程中,在上述4种信噪比条件下,选取TIMIT测试集中的300条干净语音和NOISEX-92语料库中的其它3种不同噪声类型(Factory2,Volvo,Babble)叠加得到一个包含3600(300×3×4)条含噪语音的测试集。实验中所有的干净语音和噪声的采样率均为16 KHz,依次对语音信号分帧,加窗其中帧长为32 ms(512个采样点),帧移为16 ms(256个采样点),然后进行快速傅里叶变化将语音信号从时域转换到频域。

3.2 评价方法

本文用短时客观可懂度(short-time objective intelligibility,STOI)来衡量增强语音的客观可懂度,用语音质量感知(perceptual evaluation of speech quality,PESQ)来衡量语音客观质量。其中,PESQ得分在-0.5到4.5之间,得分越高代表增强语音的质量越好;STOI反映了人对于一段语音的可理解程度,得分在0到1之间,同样得分越高代表语音的可懂度越好。

3.3 评价结果

为了验证本文提出的基于注意力机制多特征融合的方法(PR-AMFI)能够有效提高系统增强性能,将方法PR-AMFI与直接使用干净语音声学特征进行参数再合成的语音增强方法(PR-Clean)以及传统使用单一声学特征的参数再合成语音增强方法(PR)进行对比,表1为在4种信噪比(-5 dB,0 dB,5 dB,10 dB)和3种噪声下(Factory2,Volve,Babble)PR-AMFI、PR、PR-Clean这3种方法的PESQ得分,从表中可以看出,PR-AMFI与PR相比在不同信噪比和不同噪声类型下语音质量都有明显提高,且PR-AMFI系统增强语音的PESQ得分较PR系统更接近以干净语音直接作为输入的PR-Clean系统,这说明了多种声学特征基于注意力融合得到的综合特征比单一声学特征能够更好表征语音信号信息。表2列出了本文所提方法PR-AMFI与PR、PR-Clean的STOI得分,从表中可以看出PR-AMFI系统的语音可懂度在不同噪声和不同信噪比下都有提高,并且更接近PR-Clean系统的增强语音的可懂度,这表明PR-AMFI系统能够有效提高PR系统增强语音的语音可懂度。

表1 3种方法在不同噪声和不同信噪比下的PESQ得分

表2 3种方法在不同噪声和不同信噪比下的STOI得分

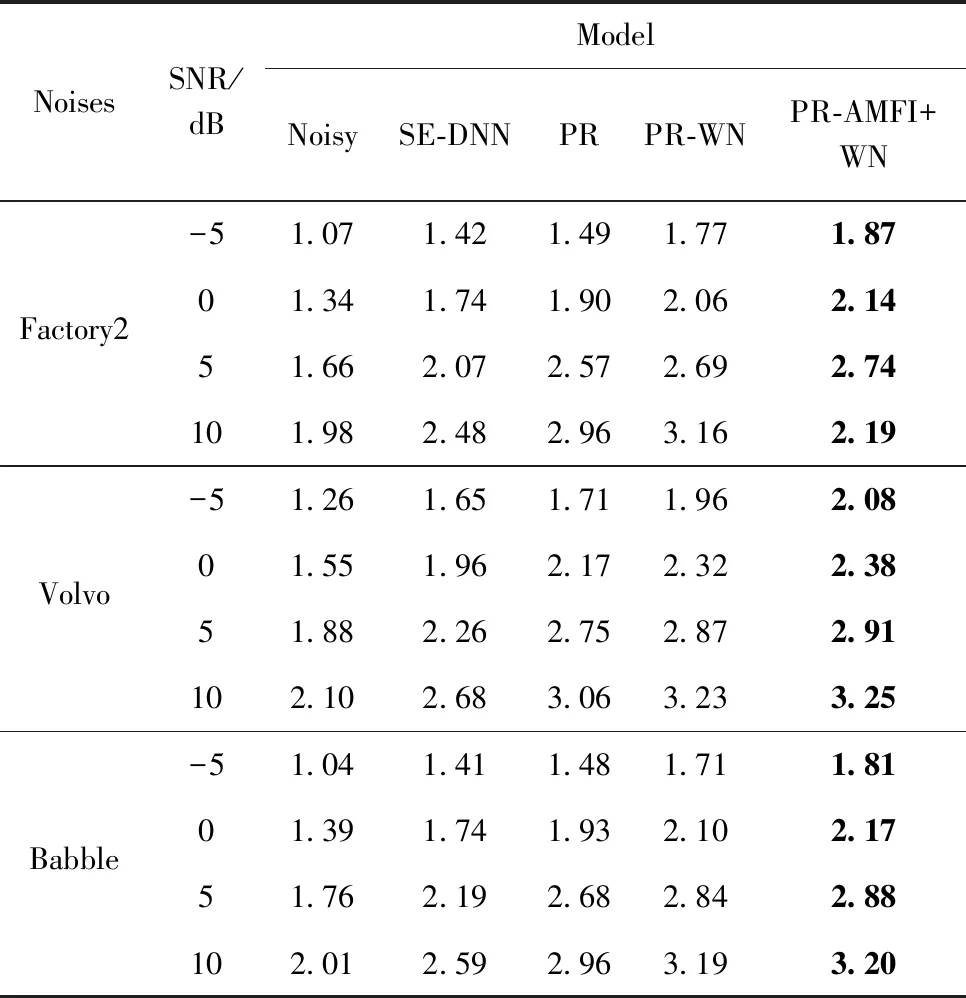

为了验证本文采用神经网络声码器WaveNet声码器能够在PR-AMFI基础上进一步改善系统的增强性能,用基于多特征融合的参数再合成的语音增强方法(PR-AMFI+WN)分别与基于DNN的语音增强方法(SE-DNN)、原始的基于参数再合成增强系统(PR)、只在语音合成阶段用WaveNet声码器代替WORLD声码器的方法(PR-WN)进行对比,表3为在4种信噪比(-5 dB,0 dB,5 dB,10 dB)和3种噪声(Factory2,Volve,Babble)下SE-DNN、PR、PR-WN、PR-AMFI+WN这4种方法的PESQ得分,通过分析可以看出,在不同信噪比不同噪声类型下PR-AMFI+WN的增强语音PESQ得分均高于PR、SE-DNN、PR-WN的增强语音PESQ得分,说明本文提出的PR-AMFI+WN的方法能够有效提高传统PR系统的增强性能。表4列出了本文所提方法与SE-DNN、PR、PR-WN这4种方法的 STOI得分,从表中可以看出PR-AMFI+WN的语音可懂度在不同情况下都有提高。

表3 4种方法在不同噪声和不同信噪比下的PESQ得分

表4 4种方法在不同噪声和不同信噪比下的STOI得分

为了更直观观测实验结果,任意选择一种噪声类型Factory2,将各方法在4种信噪比下的PESQ得分可视化,图6为可视化后的折线图。从折线图可以看出,PR-AFMI+WN在低信噪比下的增强性能提升效果更好,而在高信噪比下的提升效果较弱。这是由于GFCC在低信噪比环境下对语音的表征能力以及抗干扰能力确实明显高于MFCC,但是在高信噪比情况下,GFCC的表现并不优于MFCC。在今后的研究学习中可以尝试将自适应算法加入到算法中,使系统能够根据相应的背景噪声情况自动选择适合的声学特征,从而使本算法在高、低信噪比下都能有更好的提升效果。

图6 Factory2噪声不同信噪比下的PESQ得分折线

图7分别为干净语音、含噪语音Noisy、PR增强语音、PR-AMFI增强语音、PR-WN增强语音以及PR-AMFI+WN增强语音的语谱图,从这些语谱图可以看出通过PR-AMFI、PR-WN以及PR-AMFI+WN增强后的语音的残留噪声均少于PR增强语音,并且可以看出PR-AMFI、PR-AMFI+WN增强后语音的谐波结构较PR更加清晰,语音的基因频率及其变换范围更加明显,这验证了多特征融合后的综合特征保留了更多原始语音信息,能够有效提高系统的增强性能。

图7 不同方法的增强语音的语谱

4 结束语

本文提出了一种基于多特征融合的参数再合成语音增强算法,采用多特征融合特征代替单一特征预测干净语音声学特征,此外使用神经网络声码器WaveNet声码器代替WORLD声码器合成干净语音。实验结果表明,基于多特征融合的参数再合成语音增强算法的增强语音在语音质量和语音可懂度都有了相应的提高。

但本文方法也存在着不足,最后的改进效果在高信噪比下较弱,为了在高信噪比和低信噪比的情况下都能获得良好的性能,在今后的学习中可以尝试将自适应算法加入到本文算法中,从而使系统能够根据背景噪声自动选择声学特征。