融合红外与可见光的实验室火焰图像分割识别

李 颀,张 冉

(陕西科技大学 电子信息与人工智能学院,陕西 西安 710021)

1 引言

近年来,教育体系引入安全发展理念,其中实验室安全建设尤为重要。高校实验室事故仍时有发生。2021 年7 月,南方科技大学化学实验室在实验过程中发生火灾;2021 年10 月,南京航空航天大学一实验室发生爆炸;2022 年4 月,中南大学实验室发生火灾。安全是教育事业不断发展、学生成长成才的基本保障[1]。

当检测到早期火苗判断火灾有可能发生,应及时预警,避免火灾的发生,降低实验室损失。火灾发生必会伴随火焰烟雾产生,可见火焰烟雾识别仍必不可少。

近年来,基于图像处理的火焰烟雾检测技术发展迅速,检测方法包括传统机器学习和深度学习两类。早期Toreyin 等提出基于小波变换和背景去除的方法提取烟雾火焰的边缘纹理特征,判断视频中是否存在烟雾发生火灾[2]。Gong 等通过获取图像质心点以解决火焰形状的不规则问题,结合颜色空间和火焰特征检测火焰,但该方法泛化能力不足,易受光线干扰[3]。Kim 等提出了多输出编码器-解码器的火灾检测框架,虽检测准确率有较大提升,但需要人工操作[4]。周泊龙等提出结合动态和静态烟雾火焰特征识别视频火灾烟雾,但该方法易受形似烟雾物质的干扰,误报率高[5]。

通过卷积神经网络获取火焰烟雾特征信息对火焰进行识别,提高了火焰识别准确率,但卷积神经网络巨大的计算导致检测实时性较差[6]。严忱等提出了融合尺度特征的视频火焰检测方法[7]。Hosseini等提出一种高效卷积神经网络模型UFSNet 以检测视频中的火焰和烟雾[8]。本文提出一种基于红外和可见光图像融合的实验室火焰烟雾分割识别模型,该模型通过融合红外图像和可见光图像增强火焰烟雾目标图像的显著性,以提高实验室内早期火苗识别准确性;根据不受烟雾遮挡影响的热红外图像提供的热辐射信息,增强可见光图像光谱信息,同时通过边缘提取模块增强边缘信息,以提高烟雾遮挡下火焰的分割识别精度。

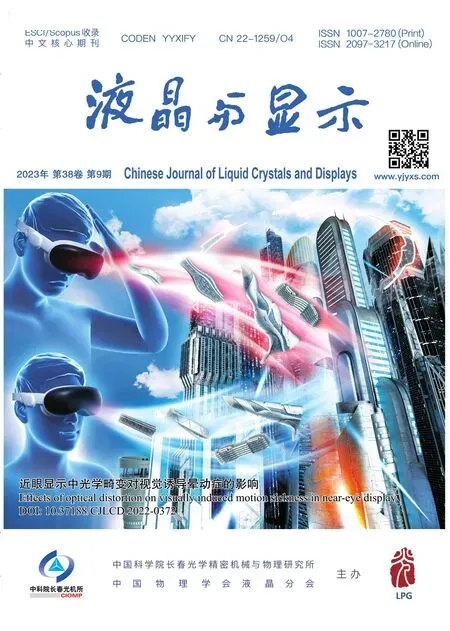

2 语义感知实时红外和可见图像融合分割网络

实验室需要实时检测实验室内火焰和烟雾,因此要求融合网络的实时性。语义感知的实时图像融合分割网络将图像融合网络和语义分割网络级联,利用语义分割损失约束图像融合,再通过新的融合结果和优化联合损失函数来更新分割模型的参数,可提高高层视觉任务在融合图像上的性能,增强烟雾和蒸汽情况下火焰图像的显著性。网络结构如图1 所示。

图1 语义感知实时红外和可见图像融合分割网络结构图Fig.1 Diagram of semantic perception of real-time infrared and visible image fusion division network structure

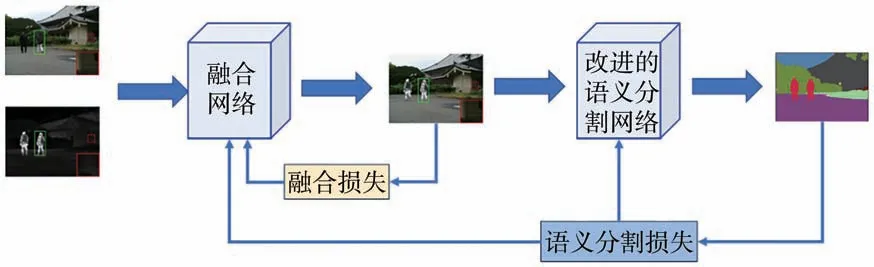

2.1 基于GRDB 的轻量级红外与可见光图像融合网络

为了实时融合热红外图像和可见光图像,语义感知实时红外和可见图像融合网络采用基于梯度残差密集块(GRDB)的轻量级红外与可见光图像融合网络,融合可见光纹理信息和热红外中的热辐射信息[9]。如图2 所示,该网络由特征提取器和图像重构器组成,特征提取器包含红外特征提取流通道A 和可见特征提取流通道B,每个由一个公共卷积层、两个梯度残差密集块组成来提取细粒度特征。图像重构是由3 个串联的3×3 卷积层和一个1×1 卷积层组成。3×3 卷积层采用LRe-LU 作为激活函数,1×1 卷积层采用Tanh 作为激活函数。

图2 基于GRDB 的轻量级红外与可见光图像融合网络结构图Fig.2 Diagram of lightweight infrared and visible light image fusion network structure based on GRD

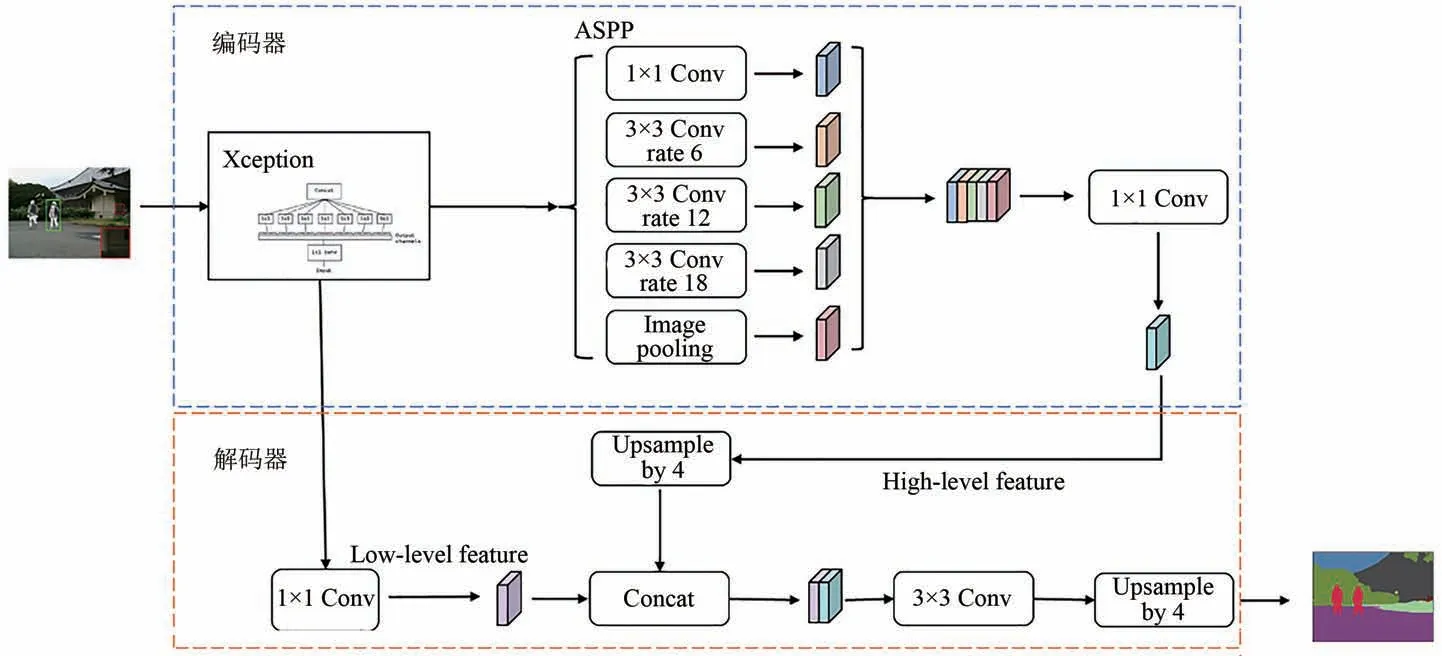

2.2 语义分割Deeplabv3+网络模型

Deeplabv3+网络结构如图3 所示[10]。Deeplabv3+网络分为编码器和解码器两部分。编码器包含主干网络和空洞空间金字塔池化模块(ASPP)。主干网络通过下采样提取高级语义特征,生成特征图,随后通过由3 个空洞率分别为6,8,12 的空洞卷积核、一个1×1 的卷积核和一个全局平均池化层组成的ASPP 模块得到5 个特征图,将特征图进行级联后经过一个1×1 的卷积核实现通道降维。解码器是将主干网络中4 倍下采样获取的低级语义特征图经过一个1×1 的卷积核进行通道降维,随后再与编码器进行4 倍上采样后的特征图进行拼接,实现高级特征语义特征与低级特征语义特征图的融合。再经过3×3 的卷积核提取融合后的图像特征,最后再进行4 倍上采样,最终输出预测分割图像。

图3 Deeplabv3+网络模型Fig.3 Deeplabv3+network model

3 改进的语义感知实时红外和可见图像融合分割模型及训练

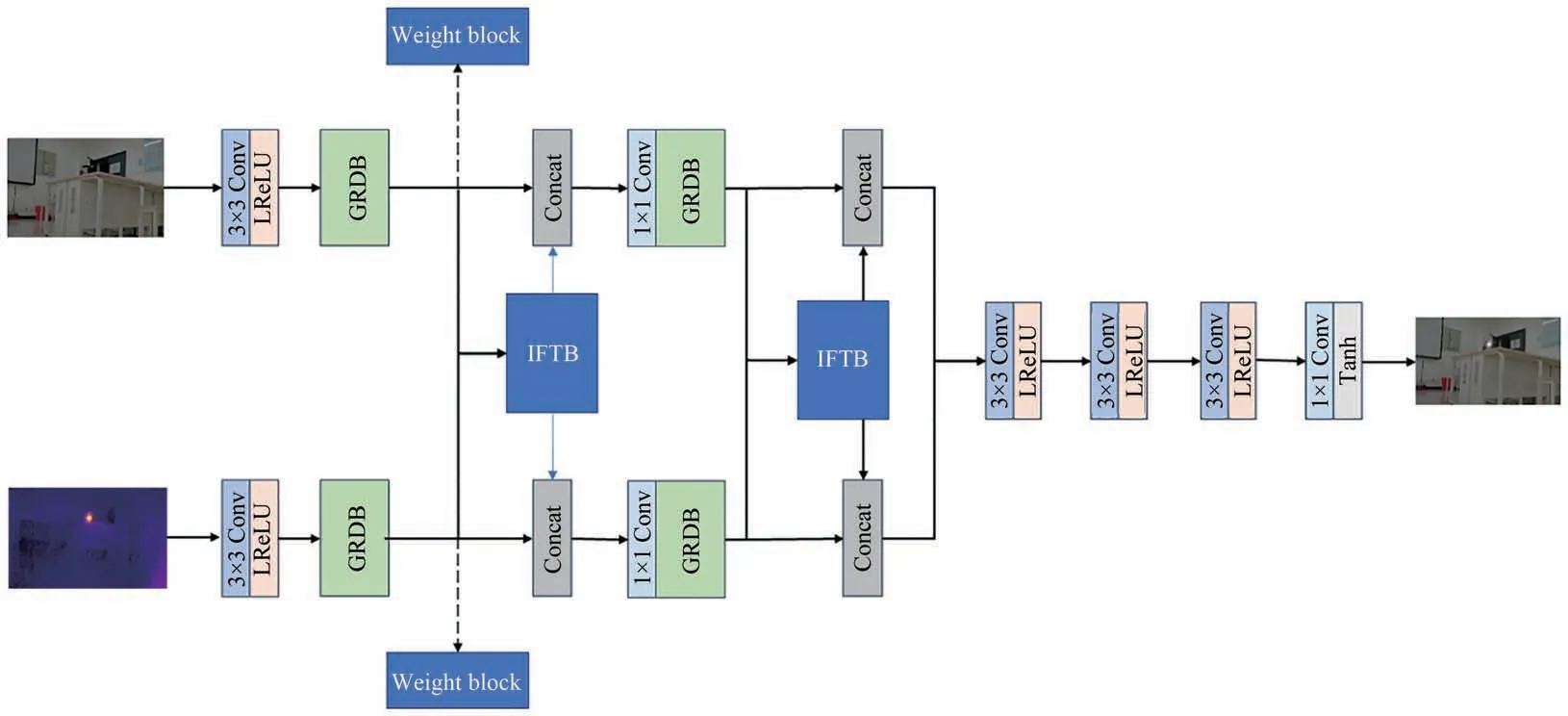

3.1 改进的融合网络

在融合网络训练阶段,由于损失函数只考虑了强度和梯度信息,当存在烟雾遮挡或实验室环境设备杂乱时,可能会丢失重要结构信息[11]。为解决该问题,本文设计一种中间特征传输块,建立网络中前后信息流之间的连接,避免卷积造成火焰图像信息丢失。同时在网络中引入权重块,实现自适应结构相似性损失约束,减少中间信息损失,起到信息保护的作用。改进的融合网络结构如图4所示。

图4 改进的融合网络结构图Fig.4 Diagram of improved fusion network structure

3.1.1 权重模块

权重模块结构如图5 所示。该模块由3 部分组成,即特征度量、softmax 和相似性约束,特征度量过程可定义为:

图5 权重模块结构图Fig.5 Diagram fo weight module structure

其中:Φc(I)表示提取的热红外图像特征Φc(IA)或可见光图像特征Φc(IB),H、W和N表示图像的高度、宽度和颜色通道,∇2为拉普拉斯算子,‖ · ‖F表示Frobenius范数。为保留红外和可见光图像的细节,融合采用边缘定位能力强、锐化效果好的拉普拉斯算子。

特征度量输出结果为GIA和GIB,然后输入到softmax 中。softmax 函数计算为:

其中:ω1和ω2的值在0~1 之间,且ω1+ω2=1;c为预定义的正态尺度常数,用于调节权重分布。权重越高,相应源图像保留信息越多。损失函数通过权重ω1、ω2实现自适应相似性约束,提高融合图像结构和内容的完整性。

3.1.2 中间特征传输块

中间特征传输块(IFTB)结构如图6 所示。特征图Φc(IA)和Φc(IB)连接后分别输入到两个1×1 卷积层和LReLU 卷积层组合中,提高速度同时防止过拟合。经过中间特征传输块后的输出结果分别传输至A 通道和B 通道,并与处理前特征图Φc(IA)和Φc(IB)分别进行串联连接,来交换A、B 通道之间的信息,对可见光和热红外图像信息进行预融合,同时加强图像重构阶段的信息,以防止可见光图像背景特征丢失。

图6 IFTB 结构图Fig.6 Diagram of IFTB structure

3.2 改进的Deeplabv3+语义分割识别模型

为提高实验室复杂环境细小火苗的识别,通过改进的Deeplabv3+对融合后的实验室火焰图像进行分割,得到细小火苗语义分割图,并对火苗分割图进行识别。主干网络Xception 通过4 倍下采样获取图像低级特征作为解码器输入,但实验室设备器材多、背景复杂,引入大量实验室背景特征、火焰烟雾边缘模糊会导致边缘语义分割不精确。为增强对边缘模糊特征的感知,提高火焰烟雾检测分割能力,对Deeplabv3+模型的解码器中Xception引入梯度变换边缘特征提取模块(EMM)[12-13],改进后的Deeplabv3+网络如图7所示。

图7 改进的Deeplabv3+模型网络结构Fig.7 Improved Deeplabv3+ model network structure

由于热红外提高了融合图像中火焰烟雾的显著性,火焰烟雾边缘明暗变化较大,因此采用梯度处理融合图像进行边缘提取。首先,EMM 对融合图像中的火焰进行显示建模,将底层图像特征中的火焰烟雾边缘特征提取出来。然后,将火焰烟雾边缘语义特征与特征ASPP 提取的高级语义特征融合,并对融合特征输出解码以增强火焰烟雾边界特征。边缘特征提取模块结构如图8 所示。

图8 基于梯度变换的边缘提取模块结构图Fig.8 Diagram of edge extraction module structure based on gradient transformation

将Xception主干网络提取的特征图作为输入,然后分别经过全局平均池化和全局最大池化,在加强实验室场景变换鲁棒性的同时保留局部特征信息。使用1×1 卷积对池化后的特征图进行卷积操作,得到通道数为K的特征M∈RW×H×K,然后通过argmax 得到K类标签图M',对标签图进行梯度变换,获取K个掩模版∇M'(∇M1,∇M2,…,∇MK)。设置Sigmoid 激活函数并与M融合得到特征图B∈RW×H×K,其表达式如式(3)、(4)所示:

其中:δ表示Sigmoid 激活函数;dis 表示距离转换,该运算通过非背景像素点与背景像素点最近距离,计算火焰烟雾与背景之间的边界处点的梯度值∇M'。通过火焰烟雾边缘掩模乘以特征图M,可以在训练过程中抑制非边缘像素,同时在分割网络中增强图像中火焰烟雾边缘定位的细节信息。

3.3 损失函数

融合火焰图像分割的损失函数包含两部分:一是内容损失函数,即红外图像中的突出目标和可见光图像中的纹理细节保真度;二是语义损失函数,通过语义损失来反映融合图像对高级视觉任务的贡献程度[14-15]。

3.3.1 内容损失

改进的融合网络利用结构相似性和灰度分布实现自适应相似性约束,通过梯度损失保证丰富的纹理细节。因此最终内容损失函数Lcontent(θ,D)由3 部分组成:

其中:θ表示网络中的参数,D是训练数据集,LSSIM(·)和LMSE(·)是源图像和融合图像之间的相似性损失项,LGrad(θ,D)为梯度损失约束,α为平衡均方误差系数。

相似性约束包括结构相似性(SSIM)和强度分布(MSE)。结构相似性指数度量(SSIM)是一种有效的度量,广泛用于两幅图像之间的结构相似性。SSIM 结合了亮度、结构和对比度3 个组成部分[16-17]。均方误差(MSE)用来约束融合图像以保持与源图像相似的强度分布。LSSIM(θ,D)和LMSE(θ,D)的公式定义如式(6)、(7)所示:

式中:IA表示热红外图像,IB表示可见光图像,If表示融合图像。权重ω1和ω2为权重模块的输出结果,为控制相似信息的保留度。其中,SSIM 和MSE 具体计算公式为:

式中:Ia表示热红外图像或可见光图像,If表示融合图像,μ代表平均值,σ代表标准差,C1、C2和C3是用来保持矩阵稳定的参数,M为图像If的像素总数,N为图像Ia的像素总数。梯度损失函数为:

式中:H、W表示图像的高度和宽度,If表示融合图像,IA表示热红外图像,IB表示可见光图像,λA和λB分别表示特征提取通道A 和特征提取通道B的梯度权重,∇为梯度算子。由于红外图像和可见图像中包含的可见纹理细节在融合时易丢失,因此参数设置时需满足λA>λB。

3.3.2 语义损失

本文引入实时语义分割模型来分割火焰烟雾融合图像,分割网络输出包括分割结果Is∈RH×W×C和辅助分割结果Isa∈RH×W×C,因此语义损失包括主语义损失和辅助语义损失。主语义损失和辅助语义损失定义如式(11)、(12)所示:

其中:H、W、C分别表示图像高度宽度和通道数,是对语义分割标签Ls=(1,C)H×W进行One-Hot 编码。语义损失表示如式(13)所示:

其中μ用于平衡语义损失和辅助语义损失的常数,初始值设置为0.1。

最后,构建联合损失函数Lloss,用于融合模型的训练,其定义为:

其中β是表征语义损失Lsemantic的超参数。随着训练的进行,分割网络与融合模型变得自适应,β根据低级和高级联合自适应训练策略逐渐增加。

3.4 可见光与热红外融合分割网络联合训练

传统任务驱动低层次视觉方法有两种:一是采用预先训练的高级模型来引导低层次视觉任务模型的训练;二是在同一个阶段联合训练高、低级视觉任务模型的训练。然而,在图像融合网络设计中,无法提供融合图像好坏的衡量准则去训练一个高级视觉任务模型。此外,同一个阶段的联合训练策略可能会破坏高低视觉任务训练之间的平衡。因此,本文对融合网络和分割网络进行迭代训练,迭代次数设置为M。首先,在联合损失Lloss的约束下,利用Adam 优化器对融合网络中的参数进行优化,并通过迭代结果动态调整超参数β,如式(15)所示:

其中,m表示第m次的迭代。β随着m增大而逐渐增加,因此分割网络可以逐渐适应融合模型,语义损失函数可以更准确地引导融合网络的训练。γ为平衡语义损失和内容损失的常数。最后,通过最新的融合结果和优化语义损失函数来更新分割模型的参数。

4 实验结果及对比分析

4.1 实验配置和数据集构建

本文实验硬件选择AMD Ryzen 7 5800H with Radeon Graphics 3.20 GHz 和NVIDIA GeForce RTX 3060 Laptop GPU 6G,软件环境选择Python 3.7 和PyTorch 1.7.1。

本文通过数据清洗从MFNet 数据集中筛选4 000 对热红外图像和可见光图像(一对数据包含一张热红外图像以及一张相应可见光图像),同时在生物化学实验室通过奥比中光相机和Lepton3.0 模块采集成对数据集,数据集包含实验室正常情况下的650 对、火焰燃烧前期情况下的650 对以及有大量烟雾遮挡情况下的650 对图像。分别对3 种情况下的数据集进行数据增强至2 000 对图像,最终总数据集包含10 000 对图像(其中60% 为实验室自采数据集,40% 为MFNet 数据集),其中7 000 对作为训练数据集,2 000 对设定为验证数据集,1 000 对作为测试集。在训练阶段,融合网络中红外和可见光特征提取通道的梯度权重λA=6,λB=5,正态尺度常数c=3×103,损失函数中平衡均方误差系数α=20,联合自适应训练中M=4,γ=1。网络epoch 设置为5 000,batch size 为8,Adam 优化器初始学习速率为5×10-4,终止学习率为1×10-5。

4.2 融合网络权重模块和IFTB 模块的消融实验

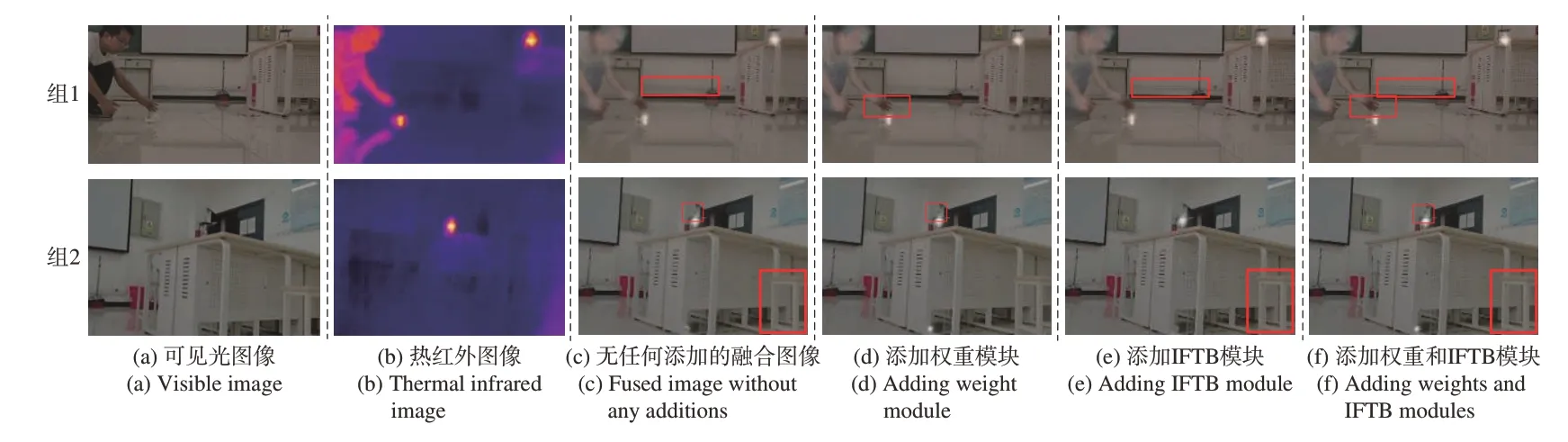

为了验证权重模块和IFTB 模块的有效性,本文对有无模块的性能进行了比较实验。可见光和热红外原图如图9(a)、(b)所示。

图9 有无权重和IFTB 模块的融合结果对比图Fig.9 Comparison of fusion results with or without weights and IFTB module

同时对比了无权重模块且无IFTB 模块、仅添加权重模块、仅添加IFTB 模块以及同时添加两种模块的4 种融合结果,如图9(c)、(d)、(e)和(f)所示,测试时其他模块和参数不变。由融合结果对比图可知,无权重模块的融合图像会丢失结构细节信息,导致整体图像细节信息丢失。图9 中第一组添加了权重模块的融合图像的手部结构细节清晰,第二组添加权重模块的烧杯边缘信息较清晰。因此通过权重模块获得的权值控制损失函数,可以达到更好的约束效果。

对有无IFTB 模块的算法进行融合实验。同样由对比结果可得,第一组添加IFTB 模块的墙面线条信息较清晰,第二组添加IFTB 模块的凳子结构信息较清晰,无IFTB 模块的融合图像相较改进的融合结果图明显缺乏详细的纹理信息。可见添加IFTB 模块对可见光与热红外进行预融合可以减少卷积造成的细节丢失。同时本文测试了验证数据集,通过7 个融合网络主流评价指标来进行客观验证融合网络,包括熵(En)、空间频率(SF)、视觉信息融合保真(VIFF)、差异相关性的总和(SCD)、平均梯度(AG),图像结构相似度指标(QY)以及基于人类感知的度量(QCB)。由表1 可知,添加了IFTB 模块的融合网络在空间频率和平均梯度上提升较大。同时可看出,增加了权重模块在图像熵和结构相似度指标上提升较大。权重模块因增加了火焰烟雾权重导致融合图像整体空间频率下降,但权重模块使红外图像和可见图像之间的特征紧密相连,在迭代学习过程中,紧密连接的特征的传输使融合更加充分。综合比较,同时添加权重模块和IFTB 模块能全面提升图像融合网络的融合效果。

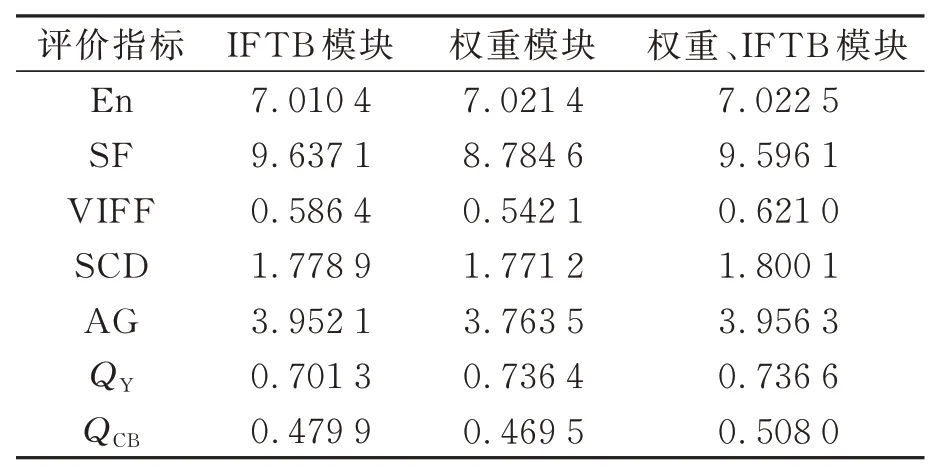

表1 权重模块和IFTB模块在融合结果上的平均估计指标Tab.1 Average estimation indicator of the weight module and IFTB module on the fusion result

4.3 分割网络分割效果与性能评估

对于改进后的语义分割网络,本文通过对比平均交并比(Mean intorsection over unin,MIoU)和每秒检测帧数(FPS)来评估网络的分割精度和检测效率[18-19]。MIoU 计算公式如式(16)所示:

式中:TP 表示正确分割实验室火焰烟雾区域的像素数量,FN 表示被错误标记为实验室内背景的火焰烟雾区域像素数量,FP 表示被错误标记为实验室背景的像素数量。改进的Deeplab3+分割网络和Deeplab3+基础分割网络的融合实验室火灾烟雾图像分割量化指标对比结果如表2 所示。

由表2 可知,改进Deeplabv3+分割网络模型的MIoU 和FPS 分别为91.27%和11.96,两种指标比Deeplabv3+基础分割网络模型分别提升了3.47%和-0.6,因此改进Deeplabv3+分割网络可以通过损失较少检测效率取得更高的分割精度。

本文在烟雾遮挡以及火苗小的情况下,通过改进后的Deeplabv3+分割网络分别对可见光与融合图像中的火焰进行分割识别,分析融合网络对两种情况下火焰烟雾分割识别性能的提升。不同情况下的Deeplabv3+火焰分割识别MIoU 结果如表3 所示。由表3 可知在烟雾遮挡情况下,融合热红外与可见光图像提供热辐射信息,提高火焰分割识别精度。在火焰燃烧前期,火苗较小,融合图像通过增强显著性提高了小火苗的分割识别精度。

表3 不同情况下改进Deeplabv3+的火焰分割识别结果(MIoU)Tab.3 Flame segmentation and recognition results of improved Deeplabv3+ in different cases (MIoU)

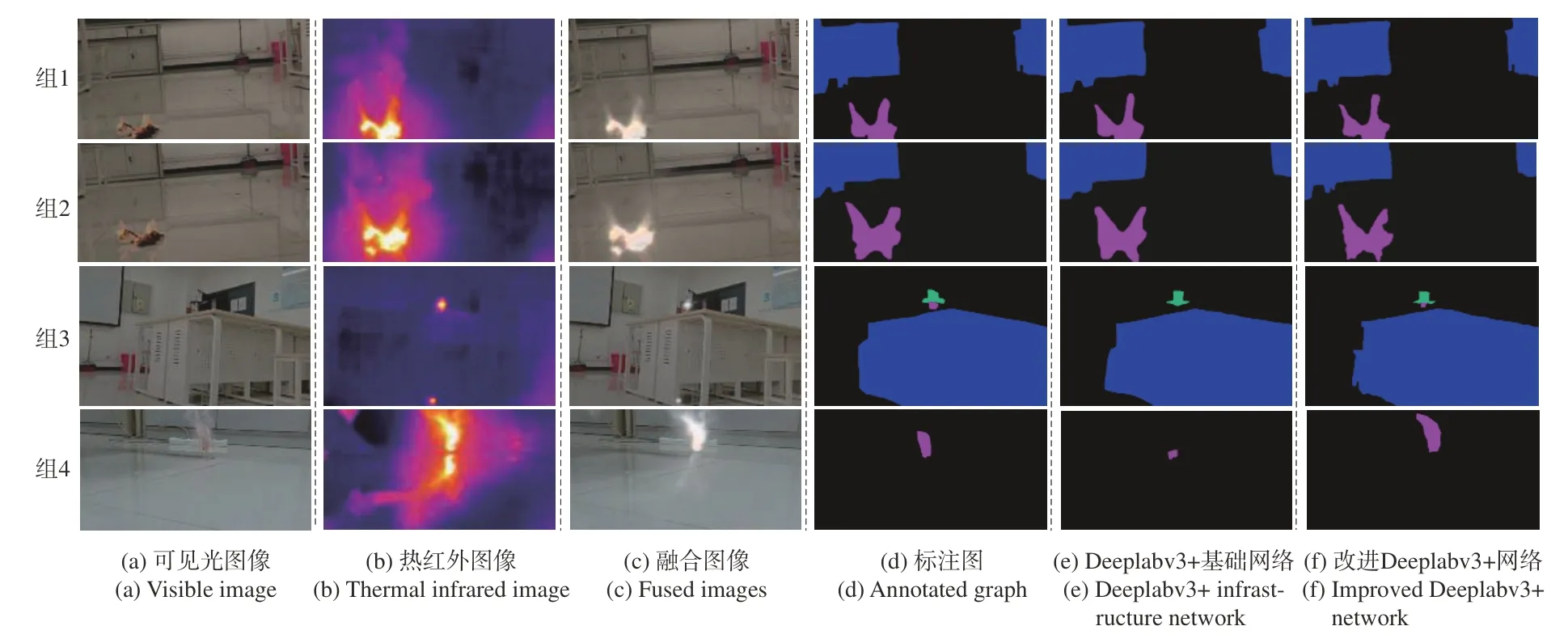

为验证改进后的分割网络模型的分割性能,在相同实验环境下,对改进的Deeplabv3+网络与Deeplabv3+基础网络进行实验室火焰烟雾分割效果对比,结果如图10 所示。实验包含4 组,其中组1 和组2 为Deeplabv3+基础网络和改进的Deeplabv3+网络对融合图像的分割识别,由分割识别结果可知,融合后的图像可以更好地结合可见光纹理信息和热红外热辐射信息,精确地分割出火焰烟雾区域。Deeplabv3+基础网络可完整地分割识别实验室火灾烟雾区域,但火焰烟雾边缘处理相较于标注图仍存在不小的差异,将标注图中的火焰烟雾边缘分割过于平滑,边缘细节信息丢失严重。在火焰烟雾与实验室背景对比度较低的区域,Deeplabv3+基础网络存在误分割情况。改进的Deeplabv3+网络可以在相同图像场景下对火焰烟雾边缘分割识别更加准确清晰,较好地保留了火焰烟雾细节特征,具备较好的泛化能力。组3 和组4 为不同情况下改进的Deeplabv3+网络对可见光图像与融合图像的分割结果对比。由组3 结果可知,当火焰初期火苗较小时,融合图像增强火焰效果显著,改进的Deeplabv3+网络可分割识别出小火苗。组4结果显示,当存在烟雾遮挡时,改进的Deeplabv3+网络通过融合图像热辐射信息可精确分割识别出火焰。对于小火苗和烟雾遮挡情况,融合图像通过提供热辐射信息增强火焰显著性,提高火焰分割识别精度。

图10 改进Deeplabv3+网络与Deeplabv3+基础网络分割结果对比图Fig.10 Comparison of segmentation results between the improved Deeplabv3+ network and the Deeplabv3+ infrastructure network

5 结论

针对实验室环境复杂、火苗小以及燃烧产生烟雾遮挡等导致相机采集到的火焰图像显著性不高,以及火焰伴随烟雾遮挡影响识别精度的问题,本文改进了一种语义感知的实时红外和可见图像融合网络,用于融合可见光与热红外图像,提高火焰图像显著性,再对融合图像进行火焰烟雾分割识别。对融合网络增加中间特征传输模块以及权重模块,对Deeplabv3+语义分割网络添加基于梯度变换的边缘提取模块。最后对融合网络和分割网络进行迭代训练,并对验证数据集进行测试。实验数据显示,基于融合红外与可见光的火焰烟雾分割识别算法在测试集中平均交并比为91.27%,分割效率为11.96 FPS,分割效果优于Deeplabv3+分割算法。该网络对融合实验室图像中火焰烟雾区域具有良好的分割识别能力,全场景语义细节分割能力突出,对于实验室火灾检测具有一定的现实应用价值。