基于Res2Net-IDCN-SCF算法的多模态医学图像融合

程 颖,方贤进

(安徽理工大学 计算机科学与工程学院,安徽 淮南 232001)

图像融合是将不同模态的信息融合到1张图片中,在许多领域有着广泛的应用,例如在军事和医学领域[1]。医学影像在临床诊断治疗中扮演着至关重要的作用,它们包含1个部位的生理和结构等信息,能够辅助医生分析患者的病情。医学影像有多种类型,其中磁共振成像(magnetic resonance imaging,MRI)展示了结构软组织信息,计算机断层扫描(computed tomography,CT)展示了骨骼信息,单光子发射计算机断层成像(single photon emission computed tomography,SPECT)展示了细胞功能代谢信息[2]。不同序列MRI图像展示的脑肿瘤信息有较大差异,液体衰减反转恢复序列(fluid-attenuated inversion recovery pulse sequence,FLAIR)对脑实质内的病灶敏感,T1加权像(T1-weighted-imaging,T1)提供脑部解剖信息,T2加权像(T2-weighted-imaging,T2)展示脑肿瘤和水肿形状和细节,对比增强T1加权像(contrast-enhanced T1-weighted,T1ce)鉴别肿瘤与非肿瘤性病变[3]。因此,融合多个序列信息,实现多模态医学图像融合,消除模态之间冗余信息,有助于医生对多个序列信息的提取并提高诊断效率。

近几年,很多方法被用于解决医学图像融合的问题,这些方法包括:基于金字塔变换的方法[4]、基于小波变换的方法[5]、基于稀疏矩阵的方法[6]、基于卷积神经网络(convolutional neural networks,CNN)的方法[7]、基于生成式对抗网络(generative adversarial networks,GAN)的方法[8]等。基于金字塔变换的方法融合图像能够整合一定的结构信息,但不能有效保存显著特征并且会提供不需要的边缘信息。为了解决这个问题,基于小波变换的方法被提出。Bhardwaj等[5]提出了基于离散小波变换与遗传算法在医学图像融合的应用,但仍然存在着泛化性能低、无法保留源图像特征的提取细节、边缘会产生伪影等问题。因为CNN[15]良好的特征提取能力,Liu等[7]将多模态融合的工作扩展到医学图像上,使用CNN生成权重图以融合2张图像的特征。Ma等[8]将GAN应用在图像融合上,利用GAN的生成特性,生成包含2张源图信息的融合图像,但GAN训练不稳定,生成的样本具有随机性、可控性低。在此基础上,Ma等[9]提出了双鉴别器融合网络,设计2个鉴别器分别学习2个模态的语义信息,能更好地学习到图像中的信息,提高图像的融合质量,但在融合图像的结果中肿瘤边缘信息仍然存在伪影,而且网络结构并未捕捉到源图中的多尺度信息。

现有的医学图像融合方法已经能实现较好的融合结果,同时保留多模态图像几何信息和纹理信息,但对脑肿瘤病灶边缘信息和多尺度信息提取仍然存在不足。因此,提出一种基于残差多尺度网络(residual multi-scale network,Res2Net)、交错稠密网络和空间通道融合的多模态医学图像融合(multimodal medical image fusion based on Res2Net and interleaved dense connection network and spatial channel fusion,Res2Net-IDCN-SCF)算法。针对脑肿瘤图像多尺度纹理信息提取有限的问题,采用Res2Net作为编码器提取图像的纹理结构特征并用交错稠密网络进行解码,构建鉴别器约束掩码图像和脑肿瘤边缘图像的差异,丰富脑肿瘤边缘细节,设计注意力融合方法,减少多模态图像的冗余,整合更多有效信息。

1 Res2Net-IDCN-SCF算法结构

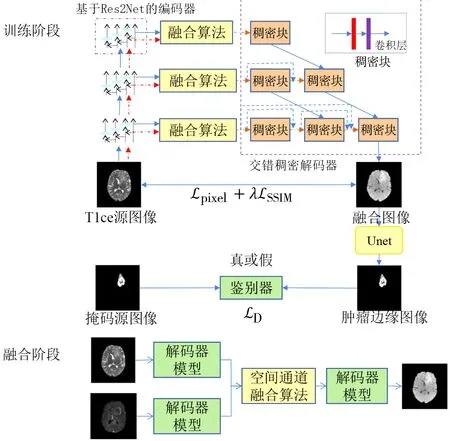

Res2Net-IDCN-SCF特征训练网络的融合架构如图1所示。由图1可知,Res2Net-IDCN-SCF算法包括整体网络架构和其中的融合算法。

图1 Res2Net-IDCN-SCF融合架构Fig.1 Fusion architecture of Res2Net-IDCN-SCF

1.1 基于Res2Net的稠密融合网络

算法分为基于Res2Net的稠密融合网络和融合算法2个部分:基于Res2Net的稠密融合网络由基于Res2Net的编码器、交错稠密解码器、掩码鉴别器和损失函数组成;融合算法由空间融合算法和通道融合算法组成。

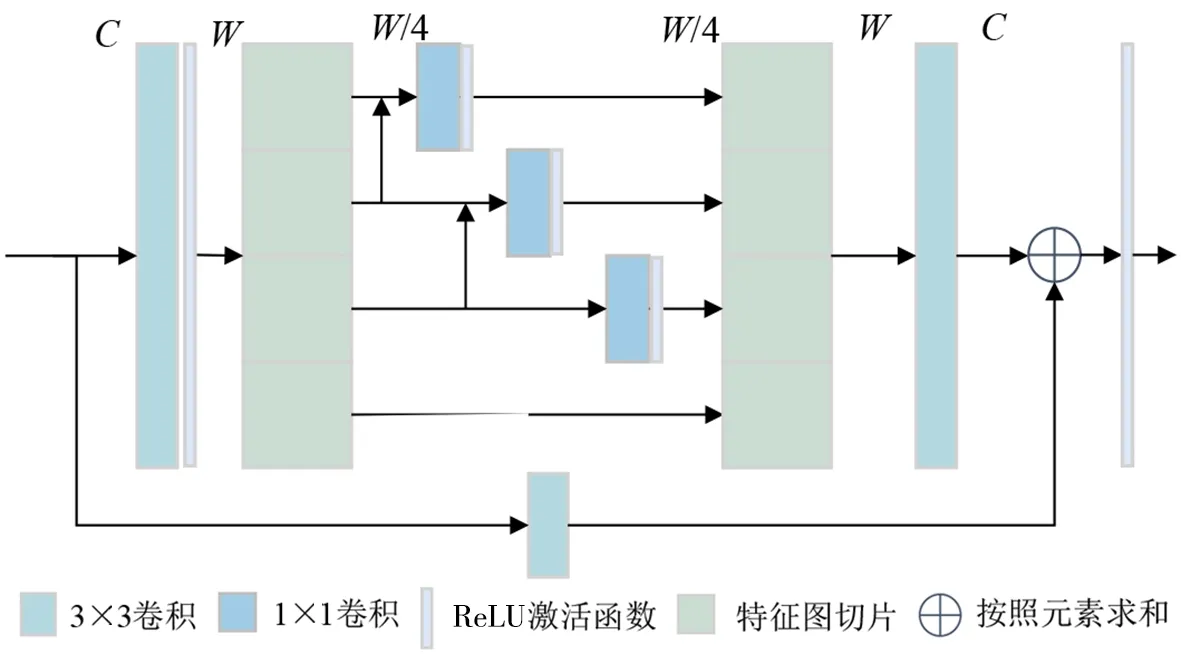

1.1.1 基于Res2Net的编码器 为了捕捉粒度级别的多尺度特征,Res2Net[10]在残差网络(residual network,ResNet)基础上增加了每个网络层的感受野,Res2Net网络结构如图2所示。由图2可知,与传统CNN的不同之处在于其使用了更小的滤波器捕捉多尺度特征信息,同时计算负荷相似,以分层残差连接的网络结构保留了更多图像中的语义信息。在特征图X进入1×1的卷积层后被等分为4个子特征图xi,其中i∈(1,2,…,s)。子特征图xi的通道数是特征图X的1/s,随后进行3×3卷积操作。这个卷积操作被定义为Ki(x),如下:

图2 Res2Net网络结构Fig.2 Architecture of Res2Net

Ki(x)=fReLU(fconv(x)),

(1)

式(1)中,fconv(x)指3×3的卷积计算,fReLU(·)指线性整流单元(rectified linear unit,ReLU)。

用fi(xi)定义每个子特征图xi的计算函数,下一个子特征图xi+1的输出由xi和yi构成。这样的分层残差连接能提取更多的多尺度特征信息,xi+1接收xi的特征信息Ki(xi+1),其卷积算子比Ki(xi)的感受野更大。fi(xi)的定义如下:

(2)

式(2)中,s是子特征图的切片数。

1.1.2 交错稠密解码器 Unet++[11]的交错稠密连接网络优化了医学图像分割工作,重新设计了跳跃连接以减少编码器和解码器之间的语义差异。在深度神经网络中,跳跃连接可以保留源图像中丰富的语义信息和纹理信息,然而,在编码器和解码器之间使用跳跃连接可能会产生意想不到的语义差异。因此,采用交错稠密连接网络(interleaved dense connection network,IDCN)作为解码器对特征图进行重构。每个稠密块(dense block,DB)由卷积算子组成,每一层的DB接收不同尺度的特征图。每层最后一个DB接收的输入包括上一层输出到下采样的结果和同一层的稠密跳跃连接信息,减少了编码与解码之间信息的丢失。

在交错稠密连接网络中,假设xi,j表示DB模块的输出,i表示下采样的方向,j表示跳跃稠密连接的方向,xi,j的映射计算公式如下:

(3)

式(3)中,K(·)表示卷积算子,由1个卷积层和1个ReLU激活函数组成;U(·)表示上采样层,[·]指稠密跳跃连接层;[xi,k]指稠密跳跃连接的输入。

1.1.3 掩码鉴别器和损失函数 为了丰富融合图像在脑肿瘤病灶区域的边缘纹理细节,构建了掩码鉴别器约束掩码源图像和肿瘤边缘图像之间的差异性。预先训练了轮次为250、学习率为0.003和动量为0.9的Unet模型。融合图像经过Unet预训练模型获得粗分割肿瘤边缘图像,由鉴别器判断掩码源图像与肿瘤边缘图像的真假,用于约束肿瘤边缘图像使其接近于掩码源图像,使融合图像的肿瘤病灶边缘接近掩码源图像。

在训练阶段,总损失函数被定义为Ltotal,如式(4)所示:

Ltotal=Lpixel+λLSSIM,

(4)

式(4)中,λ表示2个函数之间的权衡指数;Lpixel和LSSIM分别表示像素损失函数和相似度损失函数,它们的计算方式分别如式(5)和式(6)所示:

(5)

LSSIM=1-fSSIM(I,O),

(6)

其中,I、O表示输入和输出图像;(i,j)表示图像中第(i,j)个像素点;H和W表示图像的长和宽;fSSIM(I,O)表示2个图像的相似性函数。

掩码鉴别器的损失LD计算公式如下:

LD=[-log2D(Im)]+[-log2(1-D(OU))],

(7)

式(7)中,Im指掩码源图像;OU指肿瘤边缘图像;D(·)指掩码鉴别器;[·]表示计算图像均值函数。

1.2 融合算法

为了更好地整合多模态图像信息,设计空间和通道融合算法能够在最大限度上整合图像信息,减少空间和通道信息冗余。融合算法的流程如图3所示。由图3可知,假设通过基于Res2Net的编码器获得的2张多尺度特征图分别为PI和PV,融合特征图PF的计算如下:

图3 融合算法Fig.3 Fusion algorithm

(8)

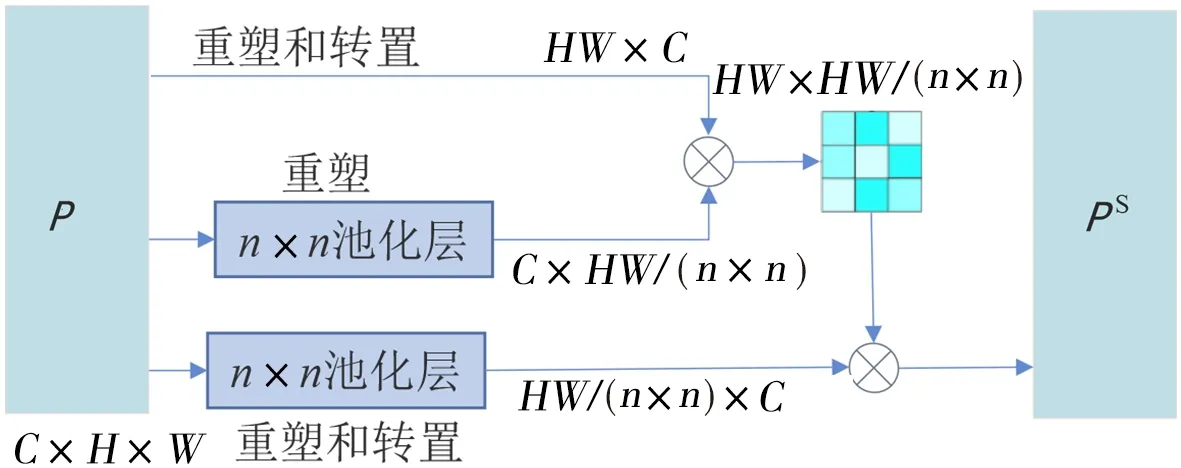

1.2.1 空间融合算法 假设特征图为P∈C×H×W,首先将其重塑和转置为PX∈HW×C,再经过n×n的池化算子得到特征图PZ∈HW/n2×C,P经过重塑和池化算子得到PY∈C×HW/n2。PX和PY进行矩阵乘法,并经过归一化函数得到空间因子HW×HW/n2,其公式如下:

(9)

(10)

(11)

(12)

(13)

采用n×n的池化算子降低计算复杂度,提高融合性能。空间融合细节如图4所示,由图4可知空间通道算法中张量的变化过程。

图4 空间融合算法Fig.4 Spatial fusion algorithm

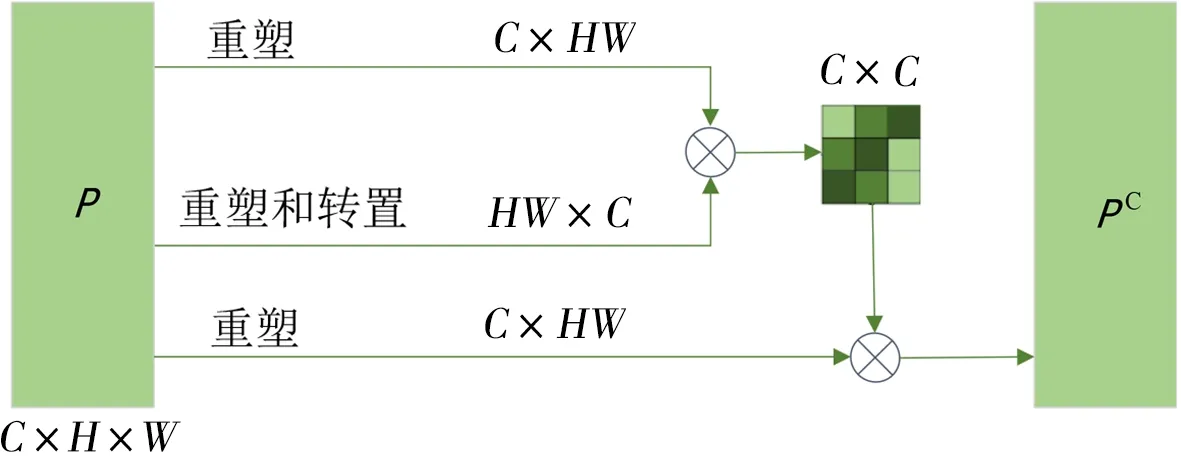

1.2.2 通道融合算法 通道融合算法过程如图5所示。由图5可知,与空间融合算法不同,通道融合是从通道数到维度对图像特征图进行整合,增强融合特征图的维度信息。假设特征图为P∈C×H×W,与空间融合算法类似,通过重塑,转置n×n的池化算子得到:PX∈C×HW、PY∈HW×C和PZ∈C×HW。通道因子C×C是由PX和PY矩阵乘法计算后通过归一化函数得到,其计算如式(14)所示:

图5 通道融合算法Fig.5 Channel fusion algorithm

(14)

(15)

(16)

(17)

(18)

1.3 训练和融合过程

Res2Net-IDCN-SCF融合算法流程描述如下:

1) 图像特征网络训练阶段。先将网络构建完成,用已配准过的数据集进行训练。用1.1节中描述的基于ResNet的编码器对图像进行特征提取,捕捉多尺度纹理和语义信息。在训练的过程中,直接将提取到的多尺度信息特征图送入交错稠密解码器之中,不进行融合的计算。从交错稠密解码器中得到的融合图像用1.3节中掩码鉴别器进行约束训练。

2) 图像压缩编码过程。对源图像进行编码并压缩多尺度特征,得到分别包含2张图像纹理特征信息的融合特征图。

3) 图像融合过程。将2张压缩得到的特征图通过1.2节的融合策略进行计算,获得1张精简整合的多尺度融合特征图。

4) 图像重构解码过程。多尺度融合特征图由交错稠密解码器重构得到融合图像。

2 实验设计与结果分析

2.1 数据集

Res2Net-IDCN-SCF算法在BraTS2021(brain tumor segmentation challenge 2021)[12]公开数据集上进行实验验证,进行T1ce和T2模态之间的融合。由于BraTS2021数据集是三维的,先将三维脑肿瘤数据切片成256像素×256像素大小的二维数据切片。使用2510个数据对网络进行训练,选择4种常见的融合网络进行对比实验。融合测试阶段是在训练集以外的数据切片中随机选取24对图像进行测试,所有评价指标是24对图像量化结果的均值。

2.2 实验设置

训练网络时基本参数是轮次为50,批量大小为4,学习率为0.001,实验采用PyTorch框架,在NVIDIA GeForce RTX 3060 GPU上实现。

2.3 对比算法和评价指标

选取的对比算法包括:1) 基于非下采样剪切波变换和参数自适应脉冲耦合神经网络(non-subsampled shearlet transform and parameter-adaptive pulse coupled neural network,NSST-PAPCNN)[13]的医学图像融合算法;2) 零学习快速医学图像融合(zero-learning fast medical image fusion,Zero-learning)[14]算法;3) 用于红外与可见光图像融合的生成式对抗网络(generative adversarial network for infrared and visible image fusion,FusionGAN)[8];4) 用于多分辨率图像融合的双鉴别器条件生成式对抗网络(dual-discriminator conditional generative adversarial network for multi-resolution image fusion,DDcGAN)[9]。

从6个维度对融合结果进行量化评估:信息熵(entropy of information,EN)、互信息(mutual information,MI)、结构相似性(structure similarity index measure,SSIM)、多尺度结构相似性(multi scale structural similarity index measure,MI_SSIM)、标准差(standard deviation,STD)、峰值信噪比(peak signal to noise ratio,PSNR)[15]。其中,EN是度量图像中信息量的指标,该值越大表示融合图像细节信息越充足。MI是用于评估2幅图像信息相似性的指标,该值越大说明融合图像的信息量越充足,融合表现越好。SSIM衡量图像之间的相似性,值越大表示融合图像与源图像越相似,有更好的融合质量。MI_SSIM更贴近视觉感知评估,是结构化信息量的度量指标。STD是衡量图像信息丰富程度的指标,值越大,图像的灰度级分布越分散,融合图像信息越丰富。PSNR度量信息与噪声之间的比值,反映图像的失真程度,数值越大,图像质量越好。

2.4 对比实验

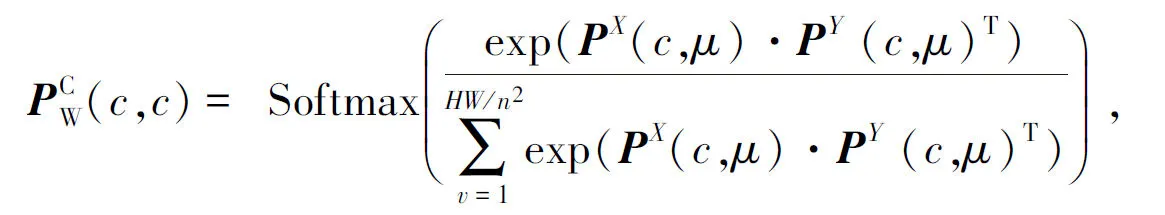

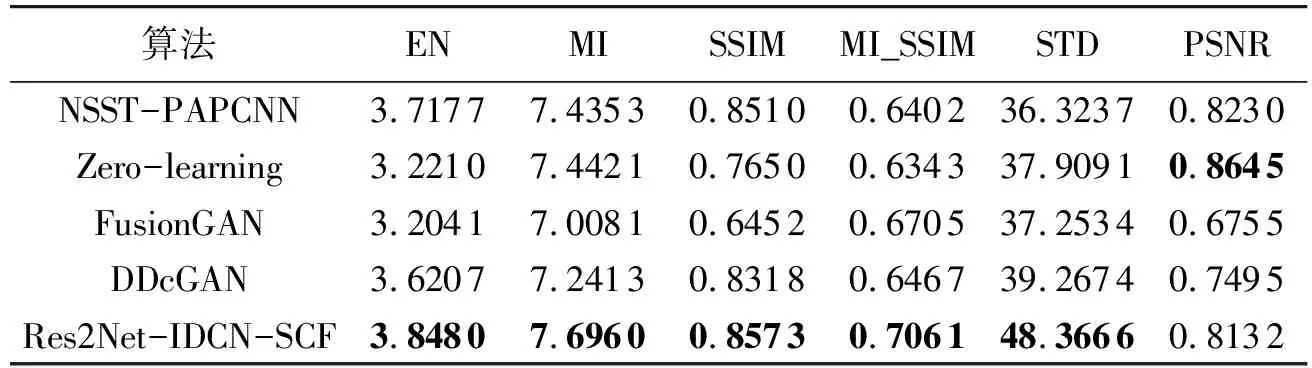

对比实验的指标结果和融合效果分别如表1和图6所示。由表1可知,Res2Net-IDCN-SCF算法在EN、MI、SSIM、MI_SSIM和STD这5个指标中有最好的表现,但PSNR弱于NSST-PAPCNN算法和Zero-learning算法。EN指标比NSST-PAPCNN算法提高了3.5%,MI指标比Zero-learning算法提高了3.4%,SSIM指标比NSST-PAPCNN算法提高了0.7%,MI_SSIM指标比FusionGAN算法提高了5.3%,STD指标比DDcGAN算法提高了23.2%。表明Res2Net-IDCN-SCF算法的融合结果包含更多源图像的结构和语义信息,图像质量更高,但图像对比度还有待提升。评价指标量化结果说明,Res2Net-IDCN-SCF算法在图像信息丰富程度上有良好的结果。图6中选择了3幅图像进行定性评估,并对病灶区域进行放大处理,右上角放大区域可明显看到肿瘤病灶区域融合情况。由图6可知,NSST-PAPCNN算法肿瘤病灶区域明显,但存在伪影,图像清晰度较低,包含来自T2图像病灶区域信息较少。Zero-learning算法有较好的融合效果,对比度较高,但病灶区域细节不够平滑。FusionGAN算法存在区块丢失效应,因此结果较差,来自源图像的语义信息少。DDcGAN算法在脑肿瘤病灶区域相较于NSST-PAPCNN算法包含更多的纹理细节信息,但仍然存在伪影,并且病灶区域清晰度不够。Res2Net-IDCN-SCF算法相较所对比的4种算法图像质量更高,伪影更少,拥有更多来自于2个模态的语义结构和纹理细节信息,并且病灶区域平滑。上述结果表明,Res2Net-IDCN-SCF算法拥有较好的融合质量。

表1 T1ce-T2 数据集融合的均值结果比较Tab.1 Comparison of mean results for fusion of T1ce-T2 datasets

图6 T1ce-T2数据集上的对比实验结果Fig.6 Comparative experimental results of T1ce-T2 datasets

2.5 消融实验

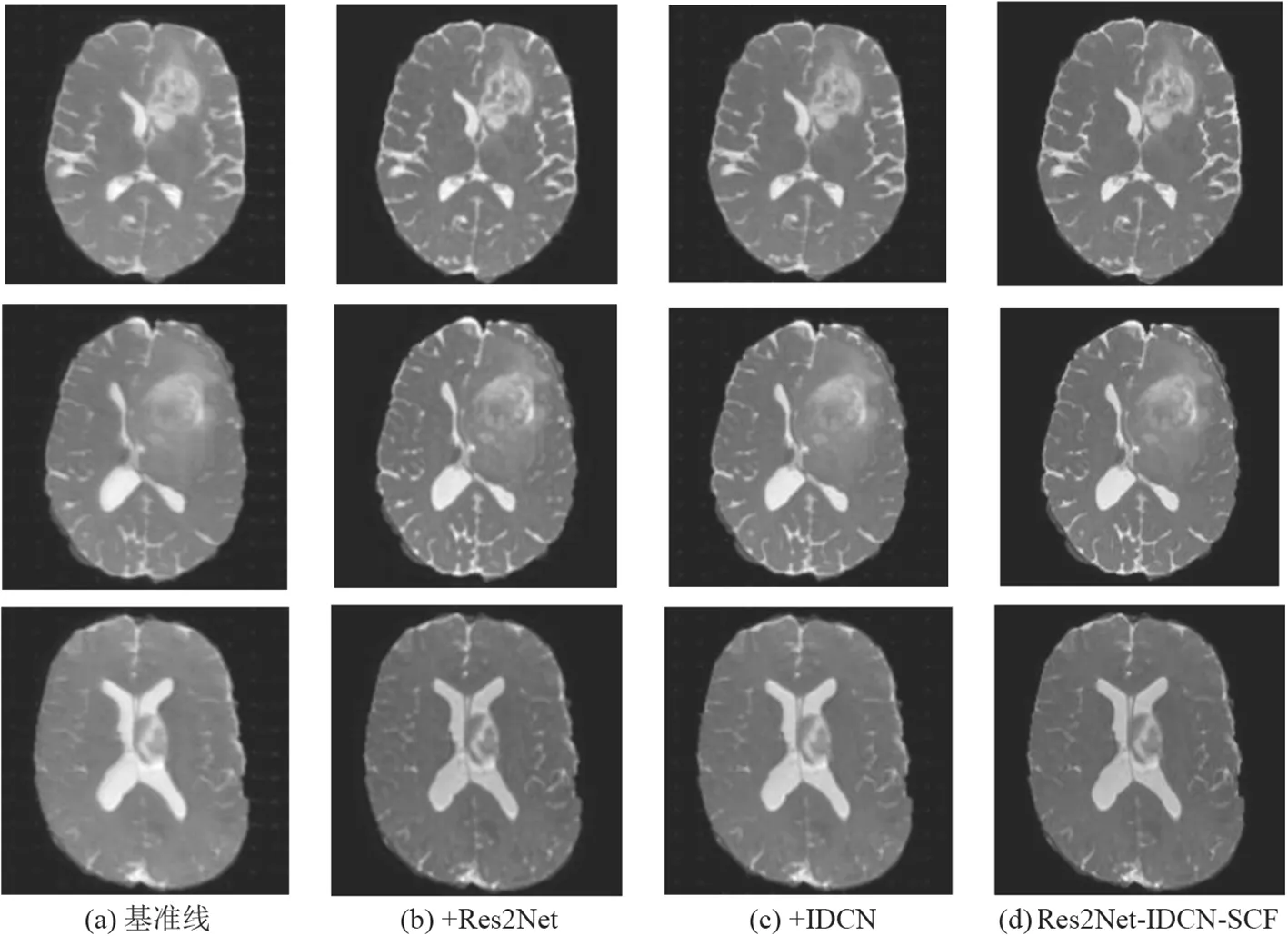

为了验证所设计模块的有效性,对Res2Net-IDCN-SCF算法进行了消融实验,结果如表2所示。由表2可知,在基准线算法中引入基于Res2Net的编码器对图像进行编码,使融合结果的EN、MI和MI_SSIM量化指标有所提升,说明基于Res2Net的编码器对图像特征等多尺度信息的提取优于基准线算法。在此基础上,为了验证IDCN的有效性,将其引入基准线。结果显示,引入IDCN后拥有更丰富的图像细节和更多的源图像信息。最后,引入SCF算法,结果表明,融合性能提升,图像信息更丰富。消融实验各个模块添加后图像融合结果如图7所示。由图7可知,增加Res2Net和IDCN模块后,图像的信息增强但平滑度下降。Res2Net在基准线基础上对信息的提取有明显提高。Res2Net-IDCN-SCF算法的图像拥有丰富的细节和清晰的图像质量。上述结果表明,Res2Net-IDCN-SCF算法拥有较好的视觉效果和指标结果。

表2 消融实验结果Tab.2 Results of ablation experiment

图7 T1ce-T2 数据集上的消融结果Fig.7 Ablation results of T1ce-T2 datasets

3 结论

针对脑肿瘤病灶边缘信息和多尺度信息提取存在的不足,提出了一种用于多模态医学图像融合的Res2Net-IDCN-SCF算法。首先,图像通过基于Res2Net的编码器提取多尺度结构信息。为了更好地整合多个模态图像的差异性,减少信息冗余,将提取到的多尺度结构信息进行空间和通道融合,更好地保留了图像的纹理结构和图像语义信息。通过交错稠密解码器减少融合特征图和源图像之间的语义差异,提高融合图像的质量。更进一步地,使用掩码鉴别器提高了融合图像脑肿瘤病灶区域的边缘信息。从实验结果来看,Res2Net-IDCN-SCF算法所处理图像质量优于所对比的其他算法,在T1ce和T2模态融合效果上可以保留更多的细节信息。评价指标EN、MI、SSIM、MI_SSIM和STD优于对比算法,Res2Net-IDCN-SCF算法融合结果具有更多的结构和语义信息。但在图像对比度方面略有缺失,后续的研究中将进一步聚焦于此。