基于后门的鲁棒后向模型水印方法

曾嘉忻,张卫明,张荣

(1.中国科学技术大学信息科学技术学院,安徽 合肥 230027;2.中国科学技术大学网络空间安全学院,安徽 合肥 230027)

0 引言

随着人工智能技术的进步,深度学习模型在许多领域的性能已经匹敌甚至超过人类,在医疗[1]、金融[2]、人脸识别[3]、自动驾驶[4]等行业得到了广泛应用,与此同时,模型版权保护也引起了人们的关注。一个训练好的高性能模型意味着高昂的数据集筹备成本和训练成本,可以视为一种价值昂贵的知识资产,但是深度学习模型非常容易被窃取并扩散[5]。因此,如何保护深度学习模型的知识产权,成为了亟需研究的问题。

研究者们将保护传统多媒体数字产品的数字水印的概念拓展到深度学习,为需要保护的模型嵌入水印。当模型拥有者怀疑某个模型涉嫌窃用,便可以通过提取隐藏在模型中的水印信息,鉴别其是否为窃用。根据验证阶段需求的不同,模型水印大致可分为两类:白盒模型水印验证时需要访问模型内部,获得模型权值等内部信息;而黑盒模型水印只需要访问模型获得输出,不需要内部信息。由于黑盒模型水印的这种特性,其应用场景更为广泛,是模型水印的主流发展方向。

黑盒模型水印方法使用后门或者对抗样本等作为水印图片加入模型训练,水印图片只有输入嵌入水印的模型才能得到指定输出,以此验证模型版权。黑盒模型水印根据水印嵌入阶段的不同,又可以分为前向模型水印和后向模型水印:前向模型水印在模型训练之初就嵌入水印;而后向模型水印在模型原始任务训练好之后再进行水印嵌入。相比前向模型水印,后向模型水印可以兼容已训练好的模型,嵌入更加灵活,需求的计算量更小,更适用于真实场景。后向模型水印的缺点是面临微调等水印擦除攻击时,鲁棒性较弱,版权认证的可靠性降低。当前的黑盒模型水印方法主要关注前向模型水印,不重视对后向模型水印的性能提升。

为提升后向模型水印的鲁棒性,分析后向模型水印相较于前向模型水印更加脆弱的原因,并提出相应的改进方案:在基于后门的黑盒模型水印框架的基础上进行优化,在后向嵌入水印的过程中引入对水印模型输出和中间层特征的约束。最后,在多个数据集和微调、剪枝等攻击下进行实验,验证所提方法的有效性。

1 相关工作

模型水印技术是随着深度学习技术发展而出现的新兴研究领域,主要建立在计算机视觉、数字水印、深度学习等研究领域的基础上。近年来,由于深度学习技术的普及和推广,保护深度学习模型安全的需求也与日俱增。本节以图像任务为主要载体,介绍近年来国内外的模型水印研究现状。

1.1 模型水印

模型水印的方法有多种,但总体而言,有一个通用的框架,即生成水印、植入水印、提取水印。首先根据身份信息和待水印模型,设计可植入模型的水印形式;然后通过训练,将水印信息嵌入模型;嵌入后,新生成的模型能够在给定输入中检验并提取水印信息,将提取的水印信息与嵌入的水印信息对比,从而完成模型所有权的验证。水印技术并不能避免模型版权的非法使用,它的目的是使侵权行为变得更容易识别,从而阻止这种行为(如作为证明所有权的证据向法庭提供)。

评价模型水印通常使用以下指标[6]:一个合格的模型水印首先需要达到一定的保真度和有效性,其中,保真度指水印任务对原任务的影响尽可能小,有效性指水印信息的提取成功率高。由于攻击者可以尝试检测并删除模型中的水印或以某种方式使它们无效,因此模型水印也应具有鲁棒性,即保证模型水印抵抗水印擦除攻击的能力。隐蔽的模型水印能够迷惑攻击者,使其无法采取针对性的方式去除、无效化或伪造水印。

从验证阶段所需模型信息量的角度进行分类,模型水印大致可以分为两类:白盒模型水印和黑盒模型水印。

白盒模型水印需要获取模型结构和权值等内部参数,通常做法是将水印信息嵌入模型内部参数,引起模型权重的定向变化,从模型中提取这种定向变化来进行水印验证[7-9]。由于白盒方法必须知道深度神经网络模型参数等具体细节才能进行水印验证,因此在实际应用中受限较大。

黑盒模型水印提取的过程中不需要访问模型内部参数,通过访问模型输出对水印进行提取。常见的黑盒模型水印方法多利用后门或对抗样本的机制。ADI 等[10]提出在黑盒场景下,利用后门技术添加水印,保护模型版权。在模型的训练或微调过程中,模型拥有者将抽象图片作为后门样本加入模型训练集,使模型在原任务上分类准确,并把抽象图片分类到指定类别。模型拥有者想要验证版权,只需要检验抽象图片分类到指定类别的成功率,以及干净图片的分类成功率即可。由于正常的模型不会在给定抽象图片的情况下输出指定类别,因此这样的特殊输出使得水印验证成立。ZHANG 等[11]提出用随机噪声、不相关样本、添加文本水印等作为不同类型的后门触发器,探讨了水印形式对水印性能的影响。CHEN 等[12]提出将模型所有者的二进制签名包含在输出激活中作为模型的水印,提升了水印容量。NAMBA 等[13]提出将后门水印对参数的影响指数加权在较大值的权重参数上,减小了后门任务对模型整体的影响。

LE MERRER 等[14]指出可以利用对抗样本构建模型水印。对抗样本的原理是:通过向原始数据添加人为的扰动,使得模型以高置信度输出错误分类[15],而模型则可以通过对抗训练调整决策边界,正确分类其中一部分对抗样本,另一部分对抗样本仍被错误分类。这种水印算法主要依赖于对抗样本在不同模型之间的迁移性,在迁移过程中,水印的准确率是否会下降是一个有待解决的问题。在没有此水印的模型上,对抗样本因为自身的迁移性也可能会以较高概率被判别错误,被误识别为水印,从而发生误报。因此,本文设计不考虑基于对抗样本的模型水印方法。

对于基于后门的黑盒模型水印,有的工作同时适用于前向模型水印和后向模型水印[10],有的工作在水印嵌入时需要已训练好的模型,属于后向模型水印[12],但这些工作都没有关注到后向模型水印相较于前向模型水印优越的应用价值和性能缺陷。

1.2 模型水印攻击

对于模型水印的攻击多围绕着鲁棒性、隐蔽性展开,但同时攻击应保持原模型的保真度(攻击者不愿意失去原模型的性能,因为需要使用去除水印后的模型进行服务)。由于本文旨在提升后向模型水印的鲁棒性,因此本节重点介绍针对水印鲁棒性的模型擦除攻击。为了方便描述,定义原有的未含水印的模型为M,模型原任务为T,水印任务为W,模型M 的拥有者O 将W 嵌入M 得到MW。

常见的模型擦除攻击主要有微调[16]、剪枝[17]等。攻击者的目标是在保持必要模型性能的情况下使模型水印无法被验证。如果攻击者拥有一个与原模型训练集规模、数据分布相当的数据集,攻击者可以重新训练一个性能相当的新模型。所以,通常假设攻击者只能使用少量、甚至不使用原模型训练样本进行模型水印攻击。微调方法不对原始模型的结构进行操作,而是直接采用带有标签的数据进行模型的重训练。模型本身包含两部分任务(水印任务W 和原任务T),而重训练仅使用T 相关的干净数据进行训练,因此,随着训练的进行,W 会被逐渐遗忘,但T会保持不变或增强(过拟合),从而使得水印W 逐渐去除。剪枝方法原本用于模型压缩,但它的原理是削减不重要参数来压缩模型结构,也能应用于水印擦除,迫使原始模型遗忘部分已有的任务(包括任务W 和任务T),攻击者同时需要使用训练数据进行任务T 的增强。事实上,由于神经网络的难以解释性,任务W 和T 激活的神经元很难区分,因此剪枝方法通常对任务T 具有较大影响,在水印W 被去除之前,原任务T 的性能已经下降到攻击者不能承受的程度。

2 基于后门的鲁棒后向模型水印嵌入方法

黑盒模型水印根据水印嵌入阶段的不同可分为前向模型水印和后向模型水印。后向水印相较于前向水印,嵌入过程更为灵活,需要的算力更低,应用场景更广,代价就是鲁棒性远弱于前向水印,难以抵御微调、剪枝等水印擦除攻击。改进后向水印的挑战在于:在模型原任务训练完成之后才进行水印图片训练,可水印空间小,水印任务难以与原任务耦合,同时激活的神经元差距较大,难以抵抗水印擦除攻击。

针对上述问题,本文在经典的黑盒后向水印嵌入框架上进行优化,在训练过程中引入输出和特征空间的双重约束,减少水印任务对原任务的影响,同时使水印任务与原任务激活的神经元相似,增强后向水印的鲁棒性。

2.1 后向模型水印嵌入框架

后向模型水印的嵌入流程如图1 所示,具体步骤如下:

图1 鲁棒的后向模型水印嵌入流程Fig.1 Robust backward model watermarking embedding process

步骤1使用干净图片训练随机初始化权值的模型,得到干净模型。

步骤2根据干净图片及其分类标签,生成水印图片并指定其标签(与原图标签不同)。

步骤3在干净模型的基础上进行再训练嵌入水印,在训练时的损失中加入输出空间约束项和特征空间约束项,直至模型收敛。

2.2 后向模型水印嵌入流程中的约束项

2.2.1 输出空间约束

后向水印任务的加入,会影响模型在原任务上的性能,即使训练时有对于干净数据分类的交叉熵损失约束,也只能保证干净数据经模型分类后logit向量的argmax 值(即分类结果)不变,而logit 向量的分布会发生改变[18],即后向水印嵌入会隐性地影响干净任务的性能。

本文约束训练好的干净模型与后向水印模型在干净数据上的性能表现,如式(1)所示:

其中:si(θ,x)表示内部参数为θ的干净模型在标签为第i类的输入x下的logit 向量输出;si(θ+δ,x)表示内部参数为(θ+δ)的后门模型在标签为第i类的输入x下的logit 输出,标签共有C类。

2.2.2 特征空间约束

基于后门的模型水印主要是通过给干净图片添加某种图形,并使模型将图片分到指定类别实现。这样的水印图片虽然与部分干净图片产生同样的分类结果,但在特征空间上的表现形式却不一致,这就意味着水印任务与干净任务激活的神经元相差较大。因此,本文在水印嵌入过程中加入特征空间的约束,使水印任务的特征分布与干净任务尽可能相似。受到JIA 等[19]提出的纠缠水印嵌入方法的启发,本文采用软最近邻丢失(SNNL)损失[20]进行约束,衡量模型学习到的干净数据和水印数据的特征表示之间的纠缠程度,如下所示:

SNNL 损失可用于测量不同组(通常是类)样本之间的距离相对于同一组内样本的平均距离。在本文中,m表示图像在水印模型上的中间层特征,y为图像类别,T为超参数,用于控制距离对SNNL 损失的影响大小。本文借助SNNL 损失,将被分类到指定类别的水印样本与类别恰好相同的干净样本在特征空间上纠缠到一起,试图去除与干净数据纠缠的水印的攻击者也会被迫牺牲干净数据的性能。

2.2.3 总约束

除了以上2 个约束项,还要考虑实现后向水印任务的损失,即限制水印模型将水印图片分类为指定类别,将干净图片分类到其正确类别的交叉熵损失(LCross-Entropy)。

最终,后向水印的损失项如下:

本文采取以下几种约束方式向模型中添加后向水印,通过调节超参α与β实现:不添加其他约束,只使用常规的交叉熵损失(后向水印基线);只添加输出约束(Llogit);只添加特征约束(LSNNL);添加双重约束(Llogit&LSNNL)。

3 实验结果与分析

3.1 实验设置

本文选用了以下4个数据集:CIFAR-10[21],CIFAR-100[21],GTSRB[22],CALTECH-101[23]。CIFAR-10数据集共有60 000张彩色图像,图像尺寸为32×32×3,分为10 个类,每类有6 000 张;CIFAR-100 数据集共有60 000 张彩色图像,图像尺寸为32×32×3,分 为100 类;GTSRB 为交通标志识别图像数据集,包括43 种交通信号,图像尺寸接近CIFAR-10 数据集;CALTECH-101 数据集包含了101 类图像,每类约有40~800 张 图像,大部分是50 张/类,图像尺寸约为300×200。本文对ResNet-18 模型[24]进行了典型的后向水印实验。

由于ADI 等[10]和ZHANG 等[11]的工作是黑盒后向水印中的经典,且在实验设置中隐含前向模型水印和后向模型水印的区分,因此将这两篇工作作为前后向水印的基线,与本文结果进行比较。本文的实验也参考了基线的实验设置:在水印注入的设置上,对于抽象型图片水印,参考ADI 等[10]的工作,使用100 张抽象图片作为水印;对于内容型图片水印,参考ZHANG 等[11]的工作,对1%的训练集添加内容型水印“TEST”并指定分类类别。在训练时,对于干净模型和前向水印模型,本文训练60 个epoch;对于后向水印模型,本文在干净模型的基础上,训练20 个epoch。超参α设置为0.5,超参β设置为0.01。使用经典的攻击设置,即微调使用RTAL(Re-Train All Layers)设置,剪枝使用基于权值的剪枝方式。

对于评价的实验指标,本文主要关注水印任务对模型的性能影响(干净任务的准确率下文称为ACC),以及水印擦除攻击下后门的鲁棒性(后门的成功率下文称为SR)。

3.2 基础后向水印与前向水印的性能比较分析

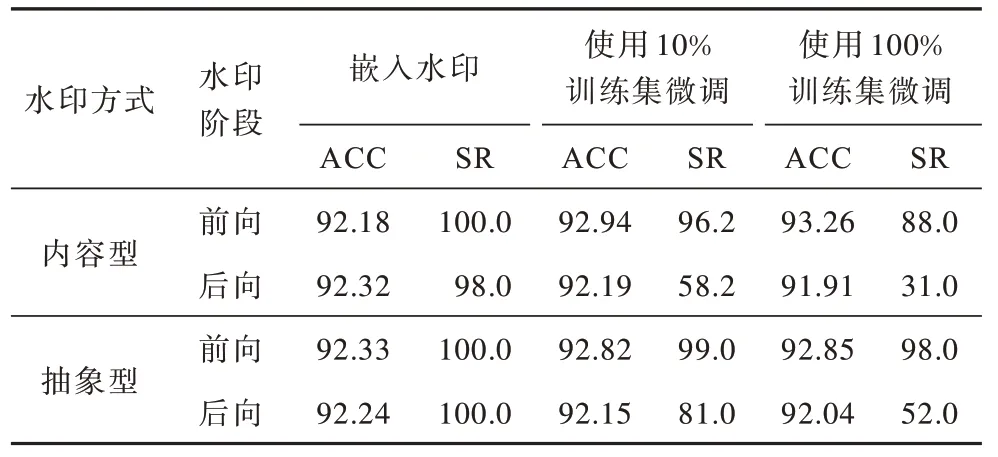

本文首先对前后向水印进行了性能上的比较,在表1 中可以看到:当没有受到水印擦除攻击时,两者在保真度和水印验证成功率上相当;而在微调攻击下,两者的模型性能下降不超过1%,部分情况下甚至性能略有提升,这是由干净数据的多次训练带来的模型过拟合导致的;后向水印的鲁棒性大幅下滑,前向水印虽然也有下滑,但幅度小于后向水印。

表1 后向水印与前向水印的基线性能比较 Table 1 The baseline performance comparison between backward watermarking and forward watermarking %

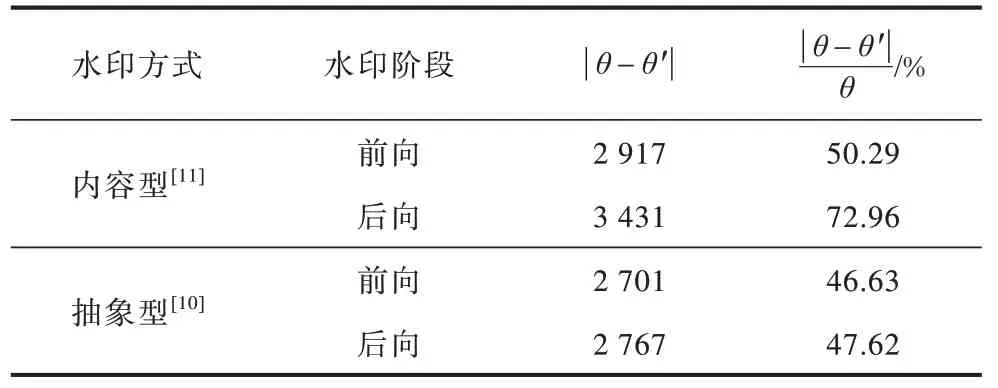

之前的研究工作[25]探讨了模型权值修改幅度与植入后门的关联,本文据此进行实验,比较了前向水印与后向水印对模型的修改。从表2 中可以看到,后向水印相对于前向水印,对模型的权值修改相对幅度和绝对幅度都更大。因此,笔者认为后向模型水印的鲁棒性弱于前向模型水印的原因可能是:对于前向水印,水印任务与权值任务一起训练,两者互相影响,当攻击者试图擦除水印时,势必影响原任务的性能,擦除水印极大地损害了模型保真度;而对于后向水印,由于其在干净模型的基础上进行权值调整,要想水印任务不过分影响干净任务的性能,模型权值的调节范围是受限的。

表2 后向水印与前向水印的权值修改幅度比较 Table 2 Comparison of weight modification amplitude between backward watermarking and forward watermarking

已有的实验证明,在后向模型水印训练过程中,添加对于模型权值的直接约束不可行(直接约束包括约束模型的绝对权值和相对权值变化),会导致后门无法成功注入,如果逐步放松对权值变化的限制,直到后门基本注入,对擦除攻击的鲁棒性也不佳。因此,本文间接地约束水印嵌入时模型的权值变化,在水印嵌入的过程中对模型的中间层特征和输出进行约束,目标是使后向水印对干净模型的权值和性能影响最小化,从而增强后向水印在水印擦除攻击下的鲁棒性。

3.3 鲁棒性分析

本文选用CIFAR-10 数据集,在抽象型图片水印和内容型图片水印的设置下,比较基线后向水印与添加了各种约束的后向水印在微调攻击、剪枝攻击和微调-剪枝(fine-pruning)攻击下的性能。

3.3.1 微调攻击下的鲁棒性分析

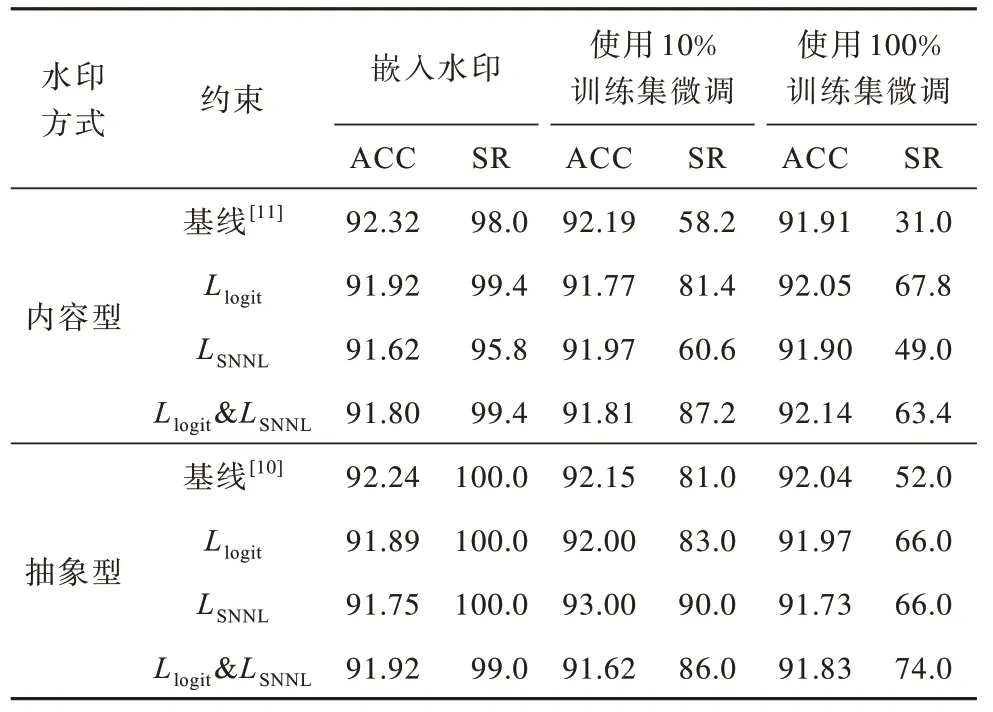

如表3 所示,只添加输出约束(Llogit)、只添加特征约束(LSNNL)和添加双重约束(Llogit&LSNNL)情况下的鲁棒性都优于基线设置(不添加Llogit或LSNNL约束)。

表3 后向水印在不同约束下的抗微调性能比较 Table 3 Comparison of performances after fine-tuning of backward watermarking under different constraints %

具体分析如下:

1)在加入logit 约束后,后门对微调攻击的鲁棒性有所提升,在微调攻击者的权限更高时(可用于微调的干净图像比例更大),logit 对鲁棒性提升得更多,这符合实验预期,模型拥有者嵌入水印时使用logit 约束,使后门模型与干净模型的logit 分布相似,从而减小了攻击者使用干净图片微调对logit分布的调整空间。

2)直接添加SNNL 损失对于抽象型水印的提升效果更加突出,笔者认为这主要是由于抽象图片在分布上与原任务图片有较大差距,SNNL 损失的加入在特征域上减小了这种差距,所以,使用部分原任务数据集微调时,难以将2 个任务触发的神经元区分,从而增强了水印鲁棒性。

3)如果同时使用2 种约束,整体而言,能够进一步提升后门对于微调攻击的鲁棒性。在内容型水印设置下,使用全部数据集微调的SR 略低于单项logit约束,这是因为2 种约束也会互相制衡,从而影响最终的性能。

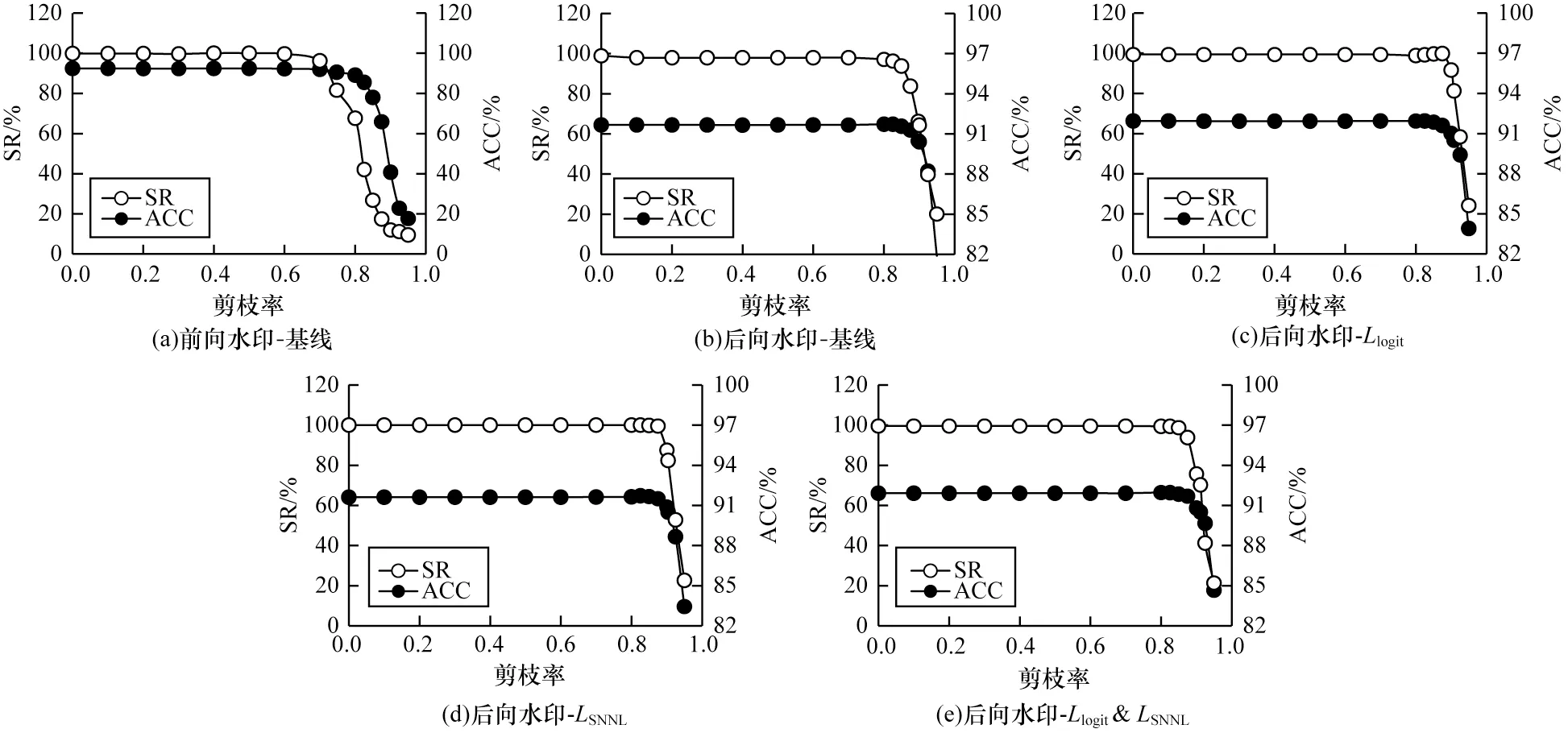

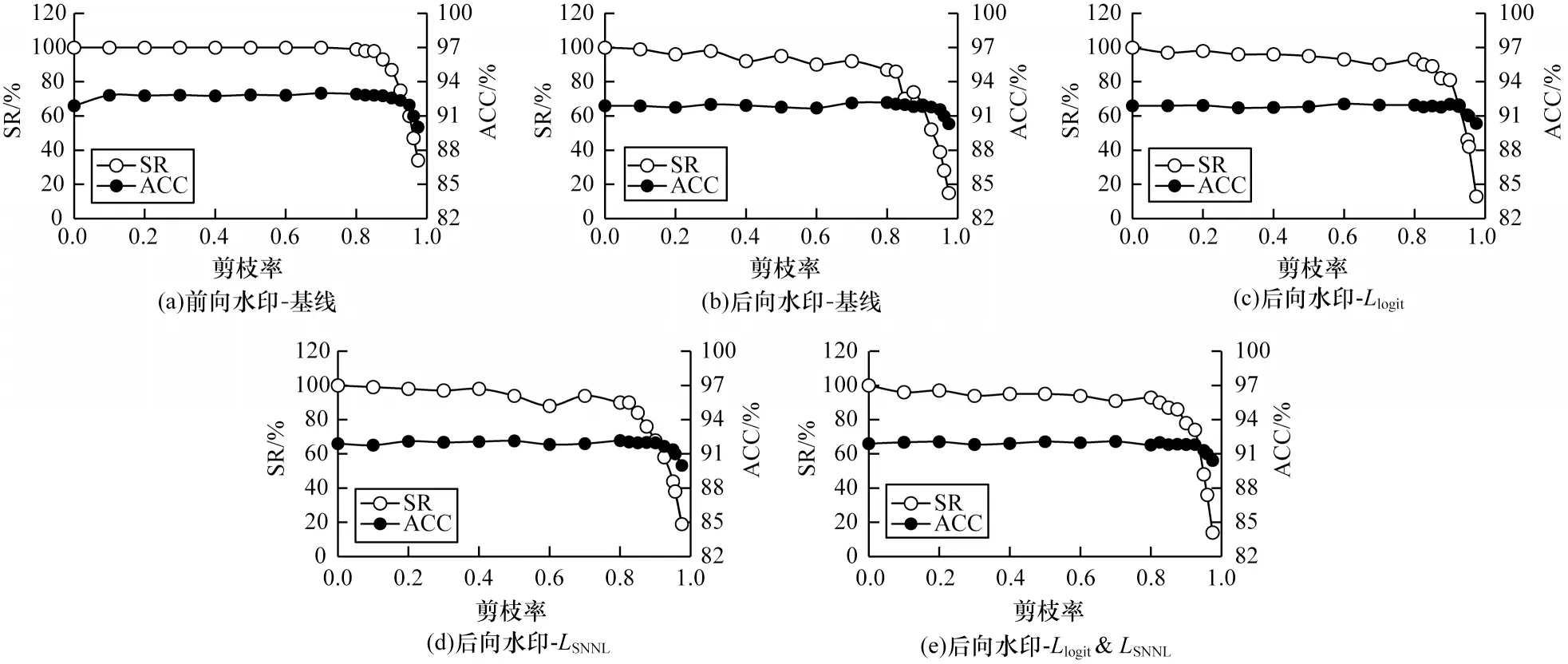

3.3.2 剪枝攻击下的鲁棒性分析

对在CIFAR-10 数据集下训练的ResNet-18 网络添加内容型水印。如图2 所示,后向水印的性能与模型原任务性能曲线基本纠缠在一起,擦除模型水印就需要牺牲一定的模型性能。当模型性能下降到90.5%时(考虑到CIFAR-10 数据集相对简单,这是一个较大的性能牺牲),后向水印基线SR 为66.2%,logit 约束下的后向水印SR 为81.2%,SNNL约束下的后向水印SR 为82.4%,即在同等强度的剪枝攻击下,加入约束的后向水印更加鲁棒。

图2 不同设置的内容型后向水印在剪枝攻击下的性能Fig.2 Performance of content-type backward watermarking with different settings under pruning attack

3.3.3 微调-剪枝攻击下的鲁棒性分析

进一步探究在更强的微调-剪枝攻击下本文方法的性能。微调-剪枝攻击参照文献[26]设置实现,微调与剪枝迭代进行,模型添加抽象型水印。实验结果如图3 所示,添加了约束的后向水印,曲线上更接近前向水印,在性能降低到91%时,前向水印基线SR 为47%,后向水印基线SR 为28%,而3 种约束下的后门水印SR 均比基线有所提升,这说明本文方法在强力的攻击设置下也能一定程度上提升后向水印的鲁棒性。

图3 不同设置的抽象型后向水印在微调-剪枝攻击下的性能Fig.3 Performance of abstract-type backward watermarking with different settings under fine-pruning attack

3.3.4 与其他同类方法的鲁棒性比较

上文将ADI等[10]和ZHANG 等[11]的工作作为后向模型水印的基线进行比较。本节将与NAMDA 等[13]的工作进行比较。在NAMDA 等提出的方法中,水印嵌入发生在后向阶段,在水印嵌入时对各层权值进行指数加权,使水印主要影响模型各层的大数值权值,以此增强水印鲁棒性。由于指数加权的性质,此方法对基于权值大小的剪枝攻击防御效果较好。该方法与本文使用双重约束方法的对比结果如表4 所示,水印设置选取内容型水印和抽象型水印,数据集使用CIFAR-10,参照NAMDA 等文中说明进行指数加权的水印嵌入,使用10%训练集进行微调攻击。从表4 中可以看出,指数加权的方法无法防御微调攻击,而本文方法在鲁棒性上更加全面,能够抵御多种攻击方式。

表4 本文方法与指数加权方法的比较 Table 4 Comparison between the proposed method and the exponential weighting method %

3.4 通用性分析

为了证明本文方法的通用性,使用CIFAR-100、CALTECH-101、GTSRB 数据集进行鲁棒性实验,嵌入抽象型水印,对比基线设置和双重约束设置下的性能。如表5 所示:在CIFAR-100 和CALTECH-101数据集下,本文的水印嵌入方式对模型的原任务性能有一定提升;在GTSRB 数据集下,模型性能有一些损失,这可能是由于GTSRB 为交通指示牌数据集,其原任务的特征空间比较简单,而本文方法引入了更复杂的约束机制,一定程度上制约了模型性能。

表5 后向水印的基线与双重约束设置在不同数据集下的性能比较 Table 5 Comparison of performances between baseline and double constraints setting of backward watermarking under different datasets %

关于鲁棒性,在CALTECH-101 和GTSRB 数据集下,本文提出的带约束的后向水印比后向水印基线都有一定的提升。考虑到CIFAR-10 数据集仅有10 个类别,另外几个数据集甚至有100 个分类,水印图片被分到指定类别的难度更大,这已经达到了比较理想的实验效果。但是对于CIFAR-100 数据集几乎没有性能,本文认为这是由于CIFAR-100 数据集不仅有100 个分类,并且每个类别只含500 张训练集图片,图像尺寸也较小,模型学习到的特征不足以支持引入多种约束来嵌入水印。

实验结果表明,本文方法对多种数据集训练出的模型都能增强其嵌入的后向模型水印的鲁棒性,是一种通用的增强水印性能的方法。

3.5 可行性分析

从复杂性和安全性2 个方面分析本文方法的可行性。

首先是算法复杂性,如上文介绍,后向模型水印相较于前向模型水印最大的优势,就是要求的计算量少、部署灵活。比如在本文的实验设置中,前向水印需要跟原任务一起训练60 个epoch,而后向水印只需要在训练好原任务模型的基础上再训练20 个epoch,实际上只需要10~15 个epoch 就能很好地嵌入水印。考虑到现在深度学习模型的结构越来越复杂,所用数据集的规模也在增大,模型原任务需要训练远不止60 个epoch,比如在文献[27]中,模型需要训练500 个epoch。在实际场景中,后向水印的计算量可能远小于前向水印。本文方法在水印嵌入时引入了2 种约束,这增加了一定的计算量。输出约束Llogit只需要对水印嵌入时的每张图片计算模型logit输出与干净模型logit 输出的L2 损失函数,几乎不影响计算量;特征约束LSNNL则需要计算同一个batch 内水印图片与干净图片在选定层的中间特征的L2 损失函数,并计算其SNNL 损失,这一定程度上增加了计算量,但考虑到后向水印与前向水印的计算量差距,本文提出的鲁棒后向模型水印嵌入方法仍是可行的。

4 结束语

本文提出一种通用的提升后向模型水印鲁棒性的方法,在添加水印的过程中加入特征约束和输出约束,通过约束使类别相同的干净图片和水印图片在水印模型上具有相似的中间层特征,同时减小干净图片在干净模型和水印模型上的输出差异。本文方法在多种数据集训练的不同模型上和不同水印攻击下表现出了泛用的对后向水印鲁棒性的提升,即使面对较为强力的水印擦除攻击,也能提升一定的性能。该方法可以应用在其他基于后门的模型水印方法中,拓宽模型水印的应用场景,提升后向模型水印的鲁棒性。本文中采用的水印设置为经典的内容型水印和抽象型水印,后续可将本文提出的鲁棒模型水印嵌入方法与隐蔽型水印结合,进一步提升后向模型水印的性能,增强对模型版权的保护。