基于AL-Transformer 的铁路客运站旅客属性识别方法

张 波

(中国铁路兰州局集团有限公司 客运部,兰州 730030)

随着我国铁路建设的快速发展和高速铁路(简称:高铁)线网的不断完善,高铁已逐渐成为人们的首选出行方式。为保障旅客的候车安全,提升旅客出行体验,铁路客运站内普遍通过工作人员实时观察旅客候车情况,尽可能地提高旅客候车舒适度。然而,铁路客运站面临着日益增长的客流量和复杂的站场形式,人工观察的方式大多是事后的补救措施,无法主动提升候车服务质量。

因此,有必要在旅客进入候车室时就自动识别到其属性信息(年龄范围、性别、帽子、眼镜、衣着、乘坐轮椅、携带物等),从而为其主动提供精准服务;增加异常行为报警的详细描述信息,辅助工作人员快速、准确锁定异常行为人员等,从而更好地保障旅客候车安全。

行人属性识别技术是为摄像头捕捉的行人图片监测其属性类别的技术[1]。早期的行人属性识别技术通常依赖人工进行属性提取,并为每个属性设计单独的分类器[2-4]。然而,客运站的复杂环境会显著降低该技术的性能。随着深度学习技术的发展,众多学者尝试使用复杂网络来解决该问题[5-8],例如,利用特征金字塔网络(FPN,Feature Pyramid Network)从多层次特征图中提取属性,结合注意力机制提取属性类别。随着Transformer 模型在计算机视觉领域的广泛应用,学者们发现其可捕获长距离依赖关系,更适合于行人属性的提取。该模型主要通过属性相关性来完成任务,然而过渡的依赖关系有时反而会降低属性定位的准确性。

综上,本文提出一种基于AL-Transformer(Attribute Localization—Transformer)模型的铁路客运站旅客属性识别方法。该方法基于掩码对比学习(MCL,Mask Contrast Learning)框架抑制特征区域相关性;通过属性空间记忆(ASM,Attribute Spatial Memory)模块获得更有辨识度、更可靠稳定的属性区域。为铁路客运站工作人员推送更有针对性的预警信息,提高旅客服务质量。

1 AL-Transformer 模型

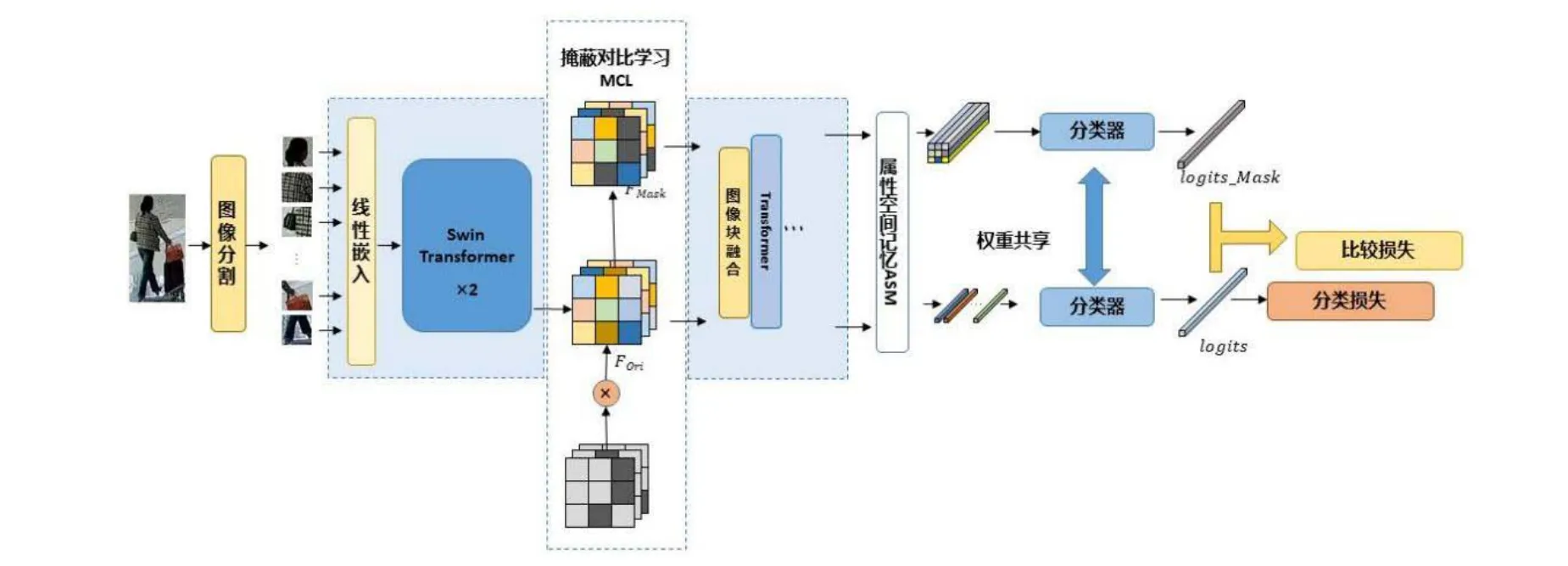

AL-Transformer 模型以Swin Transformer 为骨干网络[9],其总体架构如图1 所示。AL-Transformer 模型将给定的图像分割成不重叠的图像块;随后对每个图像块进行线性嵌入,并通过Swin Transformer 骨干提取图像特征。AL-Transformer 模型引入MCL 框架,生成随机掩码特征图FMask和原始特征图FOri,FMask和FOri通过Transformer 模型和ASM 模块,分别生成预测logits和logits_Mask。AL-Transformer 模型计算logits_Mask和logits间的比较损失并进行回归预测,改进属性定位能力。

图1 AL-Transformer 模型总体架构

1.1 MCL 框架

AL-Transformer 模型在骨干网络的基础上,加入MCL 框架,降低模型中的区域相关性对于性能预测的影响。为使AL-Transformer 模型更关注于精确的属性空间区域,MCL 框架在网络中间层完成特征掩码,通过控制特征区域间的相关性提升预测精度。

MCL 框架为每一批输入图像生成相应数量的随机FMask,随后在分类器阶段设置对比度损失函数Lcon,以评估通过随机遮掩和没有随机遮掩的预测结果间的差异,损失函数Lcon公式为

式(1)中,predMask和predOri分别为原始特征图FOri和随机掩码特征图FMask的预测结果。

1.2 ASM 模块

ASM 模块用于解决空间注意力区域偏差问题,其架构如图2 所示。

图2 ASM 模块架构

ASM 模块利用输入特征生成注意力图,选择可靠的注意力图保存在记忆器模块中,再通过注意力机制和选择器为其生成相应的属性定位信息。

ASM 模块将特征图F∈RB×C×H×W和分类器权重w∈RM×C作为输入,其中,F∈RB×C×H×W是主干网络的输出;H、W、C表示特征图的高度、宽度和通道维度;B为训练批次。M是属性的总数;A∈RB×M×H×W为输出的每个属性的注意力图,其公式为

式(2)中,Fi是主干框架的特征图;wm是第m个属性的分类器权重。

注意力图Ai,m表示不同空间区域的属性预测值,ASM 模块分别对不同属性生成相应的嵌入向量,对空间位置信息进行加权,从而改进每个属性的空间定位。再对注意力图进行归一化,用作空间加权系数,对特征进行加权池化。

1.3 损失函数

AL-Transformer 模型根据二元交叉熵损失计算分类损失Lcls,公式为

式(3)中,pi,j为分类器的预测概率;yi,j为预测结果;N为预测属性类别数。

对比损失Lcon公式为

式(4)中,probOri和probMask分别代表原始特征的预测结果和掩码特征的预测结果。

最终损失函数Loss是分类损失Lcls和对比度损失Lcon的加权总和。

2 试验验证

2.1 性能比较

2.1.1 公共图像数据库介绍

本文试验采用PETA(PEdesTrian Attribute)公共图像数据库和PAl00K(Pedestrian Attribute—100K)公共图像数据库的公开图像数据。其中,PETA 公共图像数据库包含19 000 张行人图片,图片的分辨率为17×39~ 169×365(PPI),同时,每张行人图片标注了61 个二元属性和4 个多类别属性,例如年龄、性别、服饰和配饰等[10],其图片示例如图3(a)所示;PAl00K 公共图像数据库是目前为止最大的监控场景下行人属性识别数据库。该数据库拥有100 000张行人图片,包括80 000 张训练集图片,10 000 张验证集和10 000 张测试集图片,每张行人图片被标注了26 个属性[5],其图片示例如图3(b)所示。

图3 本文采用的公共图像数据库图像示例

2.1.2 实验设置

本文基于PyTorch 框架实现铁路客运站旅客属性识别方法,并以端到端的方式进行训练,采用Swin Transformer 作为骨干网络提取行人图像特征。本文将输入的行人图像尺寸统一调整为256×192 像素,并采用随机水平镜像、填充和随机裁剪的方式进行图像增强。此外,本文采用Adamw 训练策略,设置衰减权重为0.000 5、初始学习率为0.000 1、批处理大小为64、训练阶段的总迭代周期为50、动量系数为0.999 8、标签平滑系数为0.2。

2.1.3 性能比较

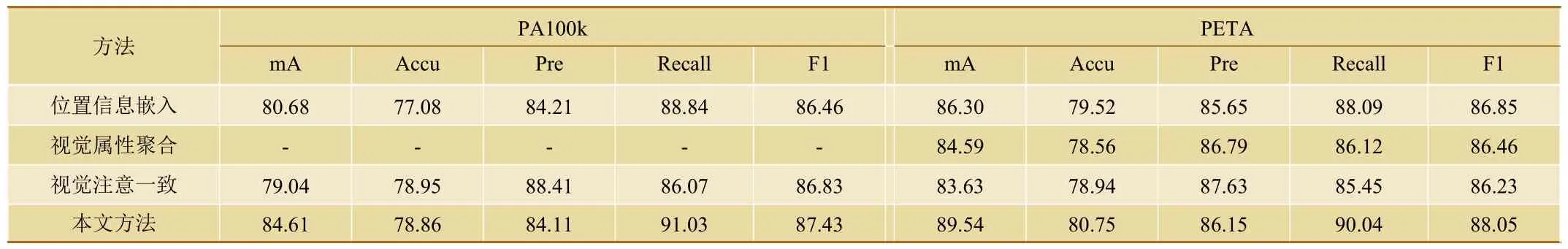

本文采用平均准确率(mA)、准确率(Accu)、精确率(Prec)、召回率(Recall)和 F1 值作为评价指标[11],基于PETA 和PA100K 这2 个公共图像数据库,与位置信息嵌入、视觉属性聚合和视觉注意一致等3 种常规算法进行性能比较。

由表1 可知,AL-Transformer 模型在PETA 和PA100K 公共图像数据库上实现了更好的性能。与采用ResNet101 作为骨干网络的视觉属性聚合模型相比,本文方法在PETA 公共图像数据库上的mA 和F1 性能分别提高了4.95%和1.59%。与位置信息嵌入模型等基于定位的方法相比,本文方法在2 个公共图像数据库上的mA 性能分别提高了3.93%和3.24%。本文方法在大多数性能指标上显著优于视觉注意一致方法[12]。

表1 多种方法的性能比较

2.2 可视化验证

如图4 所示,在PA-100K 公开图像数据库的测试集上对本文方法和Swin Transformer 网络关注的属性区域进行了可视化验证。其中,绿色边框为Swin Transformer 网络的属性注意力图;红色边框为本文方法的属性注意力图。与Swin Transformer 网络相比,本文方法有助于为每个属性定位与其相关的区域,例如:在图4 中的行人2 和行人3 中,当识别到属性“眼镜”时,本文方法更好地关注到了头部区域。可视化结果表明,本文方法可有效改善每个属性的空间位置。

图4 本文方法与Swin Transformer 网络的属性注意力图可视化展示

2.3 消融试验

本文通过消融试验来验证ASM 模块和MCL 框架对AL-Transformer 模型性能的影响,试验结果如表2 所示。

表2 在PETA 和PA100K 上的消融实验

(1)Swing Transformer 主干网络的属性定位精度较差,识别精度较低,证明算法在没有正确的注意区域的情况下,缺乏对属性语义特征的辨别能力,并包含更多噪声。

(2)相比于只使用Swing Transformer 主干网络,添加ASM 模块可使在PA100K 和PETA 公共图像数据库的mA 性能分别提升1.18%和2.06%,这是因为,ASM 模块通过属性预测得分生成可重复使用的属性空间注意力图,指导属性空间特征融合,提高属性定位精度。

(3)在Swing Transformer 主干网络上引入MCL框架,可在行人图像上生成随机遮挡,评估其预测结果与正常输入预测结果的差异。通过抑制区域相关性来提高属性定位能力,相比于只使用Swing Transformer 主干网络,引入MCL 框架后,在PA100K 和PETA 公共图像数据库的mA 性能分别提升了0.39%和0.47%。

(4)本文方法的mA 性能指标在PA100k 和RETA 公共图像数据库上分别比只使用Swing Transformer 主干网络提高了1.79%和2.34%。

2.4 白银南站现场验证

基于AL-Transformer 模型的铁路客运站旅客属性识别方法已在中国铁路兰州局集团有限公司白银南站试用。

(1)针对安检区域采集的图像,通过本文方法可自动识别进站人员的结构化信息,如性别、年龄范围、穿戴物品(帽子、眼镜、背包、短袖、长外套、长裤、短裤、裙子、连衣裙)、衣物颜色、旅客所在位置/区域、是否携带轮椅婴儿车折叠自行车等特征。

(2)根据旅客的上述属性特征进行主动服务,例如:针对坐轮椅的旅客,可及时将信息下发给附近区域的车站工作人员,对其进行重点关注;针对携带折叠自行车的旅客,可及时将其信息推送给站台和候车厅内相关值班人员。

(3)提升旅客描述颗粒度。针对视频分析系统中识别出来的异常行为人员,可提升报警信息的精确性,进一步细化报警信息,例如,细化内容为:身着红色衣服的长发女性,在1 站台距离南端口大约200 m 处,出现越线行为等。从而,使车站工作人员及时发现异常行为人员,有效阻止事态发展。

3 结束语

本文提出了一种基于AL-Transformer 模型的铁路客运站旅客属性识别方法,该方法在 Swing Transformer 主干网络的基础上,通过融合MCL 框架和ASM 模块来精准选择属性信息的相关区域,从而更准确地获取旅客的结构化信息,为工作人员推送更加精准的报警信息,进一步提升铁路客运站的旅客服务质量。