面向在线顾客点评的属性依赖情感知识学习

徐学可,谭松波,刘 悦,程学旗,吴琼

(1. 中国科学院计算技术研究所,网络数据科学与技术重点实验室,北京 100190;2. 中国科学院大学,北京 100190)

面向在线顾客点评的属性依赖情感知识学习

徐学可1,2,谭松波1,刘 悦1,程学旗1,吴琼1

(1. 中国科学院计算技术研究所,网络数据科学与技术重点实验室,北京 100190;2. 中国科学院大学,北京 100190)

该文研究属性依赖情感知识学习。首先提出了一个新颖的话题模型,属性观点联合模型(Joint Aspect/Opinion model, JAO),来同时抽取评论实体属性及属性相关观点词信息。在此基础上,对于各个属性,构造属性依赖的词关系图,并在该图上应用马尔科夫随机行走过程来计算观点词到少量褒、贬种子词的游走时间(Hitting Time),进而估计这些词的属性依赖的情感极性分值。在餐馆点评数据上的实验表明所提出的方法能有效抽取属性相关观点词,同时有效估计其属性依赖的情感极性分值。

顾客点评;属性观点联合模型;游走时间;属性依赖情感知识

引言

随着Web 2.0的迅猛发展,越来越多的顾客通过Amazon、京东等在线电子商务平台对各种产品或服务发表个人观点。这些在线顾客点评中蕴含着巨大的商业价值。同时由于其爆炸式的增长,我们迫切需要情感分析工具,来自动高效地抽取、分析及归纳其中的情感信息[1-11]。通常而言,顾客总是针对评论实体的特定属性(aspect)(如餐馆的环境、服务等)发表观点;另一方面,不同的用户往往关注不同的属性。因此面向点评的情感分析应该细化到属性层次。在属性层次情感分析应用中,高质量的情感知识资源起着基础性作用[12]。然而由于顾客情感表达往往具有属性依赖性[12-13],通用情感知识往往并不适合,属性依赖(aspect-dependent)的情感知识有助于属性层次情感分析应用,具体而言: 针对特定属性,顾客通常使用专门的观点词来传达情感。例如,人们使用“舒适”、“浪漫”来形容餐馆的环境,使用“友好”、“热情”来描绘餐馆服务。相对于通用观点词,这些专属的观点词可以帮助人们从评论文本中抽取属性相关的更有意义的情感信息[13]。

观点词的褒贬情感极性往往是属性依赖的。同个观点词在描绘不同属性时,往往传达不同的情感极性。例如,在酒店评论中,人们喜欢房间“大”,却厌恶噪音“大”。此外,很多观点词仅仅对特定属性有情感极性,如“private”一般来讲是中性的,但对于餐馆的环境来说,却是褒义的。识别属性依赖的情感极性有助于属性层次情感分类任务[12]。

因此,本文研究属性依赖情感知识学习,也就是说,我们从给定领域的顾客点评(如餐馆点评)中抽取顾客经常点评的重要实体属性;对各个属性,抽取属性相关的观点词,同时估计其属性依赖的情感极性分值。针对这一任务,本文提出了一个两阶段方法。在第一个阶段,我们对LDA(Latent Dirichlet Allocation)[14]模型进行扩展,提出了一个新颖的话题模型,属性观点联合模型(Joint Aspect/Opinion model, JAO),来同时抽取实体属性及属性相关观点词信息。相对于现有模型[13],JAO不需要任何领域知识或者人工标注数据,具有更好的领域适应性。在第一阶段基础上,对于各个属性,我们构造属性专属(aspect-specific)的词关系图,在该图上,应用马尔科夫随机行走过程来计算观点词到褒、贬种子词的游走时间(Hitting Time)[15],进而估计观点词的属性依赖情感极性分值。相对于现有方法,我们方法仅仅需要浅层次的词共现信息,不需要深层自然语言处理[12]或者人工提供的信息[16],因而具有更高的语言独立性和领域适应性。

1 相关工作

1.1 属性抽取

部分工作抽取点评中的评价对象作为属性。抽取方法主要包括NLP[9,17]、Data Mining[17]、基于模板的方法[6]、基于规则的方法[18]等。

近年来,统计话题模型如PLSA(Probabilistic Latent Semantic Analysis)[19]、LDA[14]及其变种在属性抽取中得到广泛应用。在这些工作中,属性视为隐含话题,表示为词空间上的概率分布。这样所抽取的每个属性具有完备一致的语义表示。 Titov 等人[20]提出多粒度的话题模型(MG-LDA),利用句子滑动窗口层次的词共现信息,从产品点评中抽取局部话题(local topics)以对应实体的不同属性。Ling等人[21]用少量的关键词来预定义属性,分别利用Dirichlet 先验或正则约束来引导属性的抽取,使得抽取的属性与预定义属性对齐。不同于这些模型,我们提出的JAO模型不仅抽取属性,同时能抽取属性相关观点词。

1.2 属性情感知识学习

Brody 等人[16]提出了一个两阶段方法来学习属性情感知识。首先,采用Local LDA模型抽取属性。然后抽取修饰属性相关名称的形容词作为观点词,利用情感极性图的标签扩散方法学习这些观点词的属性依赖情感极性分值。不同于他们的方法,我们在第一阶段同时抽取属性及属性相关观点词。MaxEnt-LDA模型[13]是第一个同时抽取属性及属性相关观点词的一体化模型。该模型整合了一个使用标注数据学习的最大熵分类器来区分观点词跟客观词,但并没有进一步考虑观点词的情感极性。Lu等人[12]提出了基于优化学习框架的属性依赖情感极性学习方法。其优化目标函数中整合了多种关于情感极性的约束知识。但该方法依赖通常难以获得的情感等级评分等人工给定信息。此外该方法中属性是预先定义的,并且表示为人工指定的少量关键词。所有这些限制了该方法在不同领域的应用。

1.3 其他相关工作

还有不少工作虽然不是直接针对属性情感知识学习,但也与本文工作相关。Hassan等人[22]考虑利用随机行走计算不考虑任何属性的通用情感极性。由于许多观点词的褒贬情感极性依属性不同而变化,该方法不可能准确反映这些观点词的情感极性。此外,该方法利用WordNet这个英语本体知识库来构造词关系图,这限制了该方法在其他语言上的应用。Lin等人[23]提出了JST模型,针对不同情感(褒或贬)抽取相应情感倾向的话题。Jo等人[24]提出ASUM模型,来对JST进行了改进,使得抽取的话题对应于实体的属性。类似JST,ASUM没有显式地学习属性相关的情感知识,而是针对不同情感(褒或贬),抽取带相应情感倾向的属性,所抽取的情感倾向的属性没有显式地区分观点与客观信息,而是二者高度混杂。

2 属性观点联合模型

2.1 模型描绘

传统LDA模型主要利用文档层次的词共现信息来抽取全局性的隐含话题。由于一篇评论文档往往涉及到实体的多个属性,所抽取话题往往不能对应于属性[20]。由于一个短句往往只涉及一个属性[25]。因此为了让抽取的话题对应于属性,我们可以利用短句层次的词共现信息。然而,直接在短句集合上进行挖掘,往往受到短句数据稀疏性影响。为此,我们引入虚拟文档(Virtual Document),每个虚拟文档对应一个词,我们将出现该词的所有短句连接构造相应的虚拟文档。我们的模型应用到虚拟文档集上而不是短句集或点评文档集上。这样,我们就可以充分利用短句层次词共现信息,同时克服短句的数据稀疏性问题,来更好地抽取属性。除了抽取属性信息,我们的模型进一步整合观点词典知识来显式地区分观点词与客观词, 进而抽取属性相关观点词。

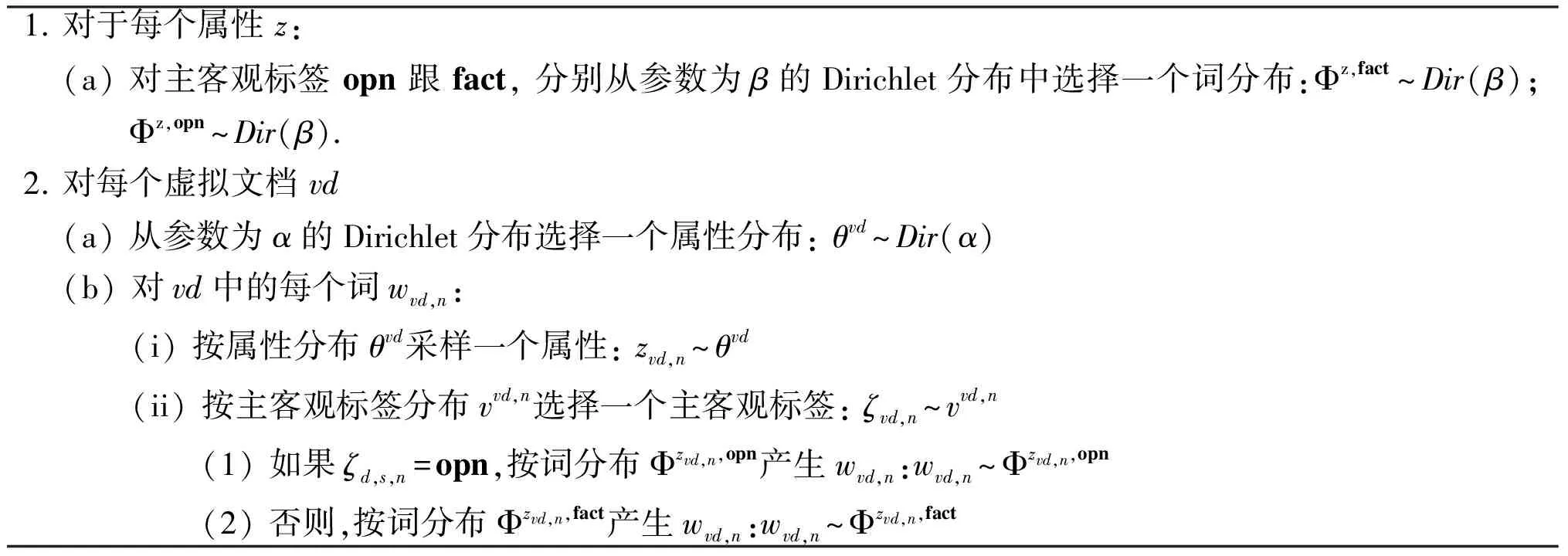

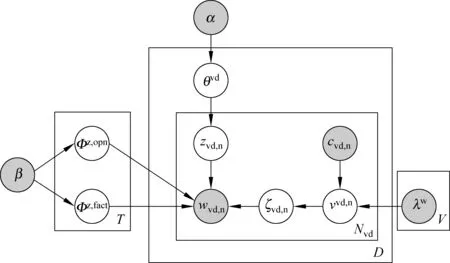

给定特定领域顾客点评集,其中点评中每个短句视为一个词序列,我们可以构造D个虚拟文档,每个虚拟文档视为相应短句的词序列连接构成的一个大词序列,而每个词是一个词典中的一个项目,这里词典中包含V个词,分别记为w=1,...,V。虚拟文档vd中的第n个词wvd,n与两个变量关联: zvd,n和ζd,s,n。其中,zvd,n表示属性;ζd,s,n为主客观标签(subjectivitylabel),表示该词是传达情感(褒或贬)的观点词(ζd,s,n=opn)还是不传达情感的客观词(ζd,s,n=fact)。根据JAO模型,虚拟文档集的产生过程如下。

1.对于每个属性z:(a)对主客观标签opn跟fact,分别从参数为β的Dirichlet分布中选择一个词分布:Φz,fact~Dir(β);Φz,opn~Dir(β).2.对每个虚拟文档vd(a)从参数为α的Dirichlet分布选择一个属性分布:θvd~Dir(α)(b)对vd中的每个词wvd,n:(i)按属性分布θvd采样一个属性:zvd,n~θvd(ii)按主客观标签分布vvd,n选择一个主客观标签:ζvd,n~vvd,n(1)如果ζd,s,n=opn,按词分布Φzvd,n,opn产生wvd,n:wvd,n~Φzvd,n,opn(2)否则,按词分布Φzvd,n,fact产生wvd,n:wvd,n~Φzvd,n,fact

图1 虚拟文档集产生过程的图形表示

2.2 如何区分观点词跟客观词

(1)

这样,主客观标签ζvd,n的赋值很大程度上由wvd,n是否出现在观点词典中决定。我们的方法虽然简单,但效果很好,实验表明优于需要标注数据的MaxEnt-LDA模型[13]。

值得注意的是,我们的模型可以通过将不同来源的知识(如观点词典、观点表达语法模式)应用到词wvd,n的上下文特征cvd,n来设置νvd,n,来更好识别观点词。这是我们将来工作的重点。

2.3 模型参数估计

我们采用collapsedGibbssampling[26]方法来对所有zvd,n及ζvd,n变量的赋值进行后验估计。根据collapsedGibbssampling,变量赋值按一个给定所有其他变量赋值及观察数据下的条件概率分布依序选择产生。这里,zvd,n和ζvd,n的赋值根据公式(2)的条件概率分布联合选择产生:

(2)

其中w是虚拟文档集的总词序列;T是事先指定的属性个数;z及ζ分别是这个词序列(除了vd中第n个词外)上词的属性及主客观标签赋值序列;是vd中词的个数。是vd中词被赋值为属性t的次数。)w上任何词(或者词w)赋值为属性t及主客观标签l的次数。以上所有次数统计都排除vd的第n个词。

(3)

其中Φt,fact体现了属性t的客观语义,而Φt,opn中的高概率词是属性t相关观点词。

3 情感极性分值学习

给定一个属性,我们首先构造属性专属的词关系图;然后计算观点词到少量褒、贬种子词的游走时间来估计这些词的属性依赖情感极性分值。

3.1 词关系图构造

(4)

这里|S|为语料中子句的总数;cz(wi)出现词i的所有短句的带权个数和;cz(wi,wj)为同时出现词i及j的所有短句的带权个数和。 每个“个数”的权重为相应短句的属性相关度。 短句s的属性相关度按公式(5)计算。

(5)

3.2 游走时间计算

(6)

(7)

对于上式的第一项:

(8)

(9)

显然对于i∈S有hz(i|S)=0。最终我们得到计算游走时间的如下线性系统:

(10)

为了计算情感极性,我们分别有褒、贬种子观点词集:S+及S-。这里S+及S-来源于文献[24]。相应的,给定图中的一个词i,我们可以分别有如下游走时间:hz(i|S+)及hz(i|S-)。这里hz(i|S+)值越低,表明词i跟褒义种子观点词语义距离越小,因而也倾向于褒义。对于hz(i|S-)也同理。

最终我们计算属性依赖情感极性分值如下:

(11)

该值靠近0是表明词i相对属性z传达贬义极性,靠近1表明褒义。总的情感极性计算流程如下:

1 对每个词,初始化hz0(i|S+)=0,hz0(i|S-)=02 迭代执行以下步骤,直到收敛2.1 对于每个图中的词(非褒义种子词)i,i∉S+,计算:hzt+1(i|S+)=∑j∉S+Wzi,j×hzt(j|S+)+13 迭代执行以下步骤,直到收敛3.1 对于每个图中的词(非贬义种子词)i,i∉S-,计算:hzt+1(i|S-)=∑j∉S-Wzi,j×hzt(j|S-)+14 令hz(i|S+)及hz(i|S-)为最终收敛游走时间值,则每个词的情感极性分值计算如下polarity(z,i)=hz(i|S-)hz(i|S+)+hz(i|S-)

4 实验结果及分析

我们使用一个公开的餐馆点评集[27]。该数据集包含从CitySearch网站采集的52 264篇顾客点评。该数据集已经做了包括句子分割、词性标注等预处理。对每个句子我们根据冒号和逗号进一步分割,得到短句,然后进一步去除停用词。最终每个短句都转化为带词性标注的词序列。如 "the quality is good" 变换为 "quality_noun good_adj"

4.1 JAO评估

为了进行JAO的学习,我们需要构造虚拟文档。我们仅仅选择点评集中出现次数不少于20次的形容词、名词、动词及副词来构造虚拟文档。出现次数过少的词对应的虚拟文档往往没有充分的共现信息;而其他词性的词往往是一些不具备实义的没有属性区分能力的功能词。对于每个选择的词,我们把出现该词的所有短句的词序列连接,构成相应虚拟文档的词序列。我们执行100轮Gibbs sampling迭代。JAO的参数设置如下: 根据文献[16],属性个数T设置为14;对于超参数,按照现有研究的惯例[26]设置α=50/T及β=0.1,没有针对我们的数据进行专门调式。实验中采用的观点词典(见2.2节)来源于两个公开的知识库:MPQASubjectivityLexicon*http://www.cs.pitt.edu/mpqa/与SentiWordNet*http://sentiwordnet.isti.cnr.it/

4.1.1JAO结果实例

表1给出了JAO在餐馆点评集上的结果实例。对于每个属性,我们按照Φt,fact及Φt,opn(见式(3))分别列出了排序靠前的客观词及观点词。这里我们仅仅列出了主要属性的结果,忽略一些类似的或者比较琐碎的属性。从表中我们可以发现我们的模型能有效挖掘顾客经常评论的主要餐馆属性信息,如服务, 环境等。对于各个属性,所抽取的客观词能很好的描绘该属性的语义。更重要的是,大体上, 所抽取的属性相关观点词与相应属性紧密相联,具有很好的属性区分能力,同时能对该属性提供非常有意义的情感信息。

表1 JAO运行实例(为了增加可读性我们去除了词性标注,属性相关观点词加标记*)

4.1.2 与MaxEnt-LDA比较

MaxEnt-LDA模型[13]是第一个抽取属性及属性相关观点词的一体化模型。该模型与JAO模型完成同样地任务。 原文给出了MaxEnt-LDA在相同的餐馆点评集上的运行实例,总共给出了四个属性(“Food”, “Staff”, “Order Taking” 及“Ambience”) 上的结果。 我们请两个标注人员来人工判别观点词是否跟相应属性紧密相联。表1给出了其中一人的评估结果(以* 标记属性相关观点词)。平均二者结果,MaxEnt-LDA所挖掘观点词仅仅52.5%确实是属性相关观点词,而JAO在对应的4个属性上的结果是约80%。这表明JAO能更有效的抽取属性相关观点词。此外MaxEnt-LDA整合了一个预先使用标注数据学习的最大熵分类器来区分观点词跟客观词,我们的模型并不需要标注数据,因而具有更好的领域适应性。

4.1.3 自动定量评估

直觉上,一个观点词跟某个属性的关联程度可以由多大程度上仅仅根据该观点词就能推断出相应的属性来度量。因此,我们可以通过利用属性相关观点词进行属性识别,来更加客观准确评估JAO的属性相关观点词抽取性能。餐馆评论数据包含了大概3 400个带属性信息的人工标注句子。这里候选属性集包括8个人工定义属性{"Staff", "Food", "Ambience", "Price", "Anecdote", "Misc"}。参考文献[13]的做法,我们从中选择顾客经常评论的3个重要属性: "Staff", "Food", "Ambience";忽略其他语义信息不明确的属性如"Misc"。

具体而言,对于一个人工定义属性a,我们根据自动学习的属性观点模型与句子语言模型的负KL距离来对所有标注句子进行排序。我们利用排序位置N上的准确率作为性能度量指标。我们这里句子语言模型由基于Dirichlet的极大似然估计方法学习。而对于a,相应的属性观点模型如下

(12)

这里Ta为JAO自动学习到的对应到a的属性集*可能有多个JAO自动挖掘的属性对应到一个人工属性,如“Food-Meal”,“Food- Bakery”等对应到人工定义属性“Food”。这是由于JAO能有效抽取细粒度的属性。;VO为观点词典。对非观点词,我们将概率值设为0。这样我们就可以只利用观点词来进行属性识别。

作为比较,我们考虑以下方法估计属性观点模型:

Gen. 我们用通用观点模型作为属性观点模型。每个观点词的概率值均等,不区分是否属相相关。

Bol. 我们首先选取标注为相应属性的句子,然后利用Bol词权重计算模型,来计算每个观点词的在这些句子中的权重,反映该词的属性区分能力,进而推断该词在属性观点模型中的概率值。值得注意的是Bol直接利用了标注数据及一个高效的权重计算模型Bol[28]来进行训练,而所用标注数据同时用来测试。因而Bol是个非常强的方法。可以作为无监督方法(比如我们方法)的所能达到的性能的上界。

此外,由于MaxEnt-LDA学习所需的标注数据不公开,我们没办法利用MaxEnt-LDA学习属性观点模型来进行比较。

图2给出了,在三个属性上,不同方法的准确率(Precision)随排序位置N的变化曲线。我们看到,我们的方法远远优于Gen,同时非常接近Bol, 甚至

图2 准确率(Precision)随排序位置N的变化曲线

在staff属性上超过Bol;同时当N较小时,准确率非常高。从中验证了我们的方法所抽取观点词跟相应属性紧密联系。

4.2 情感极性分值评估

4.2.1 结果实例

表2给出了属性依赖情感极性学习的实例,从中我们可以看出我们的基于游走时间的方法可以有效学习属性相关观点词依赖于特定属性的情感极性。例如,“heavy”对于MainDishes来说口味过重,是贬义词;“private”一般来讲是中性的,但对于餐馆的气氛属性来说,却是褒义的。

表2 属性依赖情感极性学习的实例

4.2.2 自动定量评估

Brody等人[16]针对餐馆点评数据集构造了属性依赖情感极性分值的答案数据,该数据涉及8个标注属性(见表3),对于每个属性,有一系列属性相关的形容词,每个形容词都由人工标注了专属的情感极性分值,范围为从-2到2。为了利用该数据对属性依赖的情感极性分值学习进行定量评估,我们人工地将每个标注属性对应到一个JAO自动学习的属性,利用该自动属性信息,构造词关系图,进而学习情感极性分值。

作为基准(baseline),我们采用不考虑属性的游走时间方法,也就是在构造词关系图时,利用经典的逐点互信息方法来计算词之间的关系权重。

属性依赖情感极性学习的相关工作包括: Brody等人[16]利用基于情感极性图的标签扩散方法,判别属性依赖的情感极性。 Lu等人[12]提出了优化学习的属性依赖情感极性学习框架。但该方法依赖人工标注信息,如情感等级信息。而我们的数据中并没有此类信息,不能采用该方法做比较。因此我们这里只采用Brody的方法作为基准(记做Brody)。

在表3中,Kendall’s tau 指标来度量根据不同自动方法产生的情感极性分值排序与跟人工分值给出的排序的吻合程度。表中Brody+是在Brody基础上引入人工标注信息的变种[16],因而性能更好。Brody跟Brody+的结果直接来源于原文[16]。

1) 我们的方法在几乎在所有属性上显著优于ASUM, 这是由于ASUM本身不是直接针对情感知识学习,因而并不能很好学习观点词的情感极性。

2) 平均来看,我们的方法显著优于Brody跟Brody+。此外,我们的方法仅仅需要浅层的共现信息,不像Brody和Brody+需要进行深层自然语言处理,因而具有更高的效率和语言独立性。

3) 我们方法相对于Brody及Brody+在不同属性上性能非常稳定。这是由于我们的方法充分利用全局性词关系信息,克服数据稀疏性问题,从而获得更可靠情感极性分值。

4) 我们的方法在不同属性上几乎一致优于不考虑属性的游走时间方法(除了属性Drinks*这是由于“Drinks”属性的评论经常与其他属性的混杂,因而不能有效地从语料中挖掘。我们仅仅从自动挖掘的属性中选择尽可能相关的对应到“Drinks”),这表明考虑在构造词关系图时利用属性偏移的逐点互信息方法来计算词之间的关系权重能获得更加准确的属性依赖的情感极性分值。

表3 不同方法在Kendall’s tau 指标上的比较

5 小结与展望

本文研究属性依赖情感知识学习,提出了属性观点联合模型及基于游走时间的情感极性计算方法。相比现有方法,我们的方法不依赖领域知识、人工标注及深层次的自然语言处理,因而具有更好的效率和领域适应性。在将来,对于JAO,我们计划整合更多来源的各种知识来更好识别观点词。目前对于情感极性学习中的词关系图构造,我们目前主要利用共现信息来度量词之间的关系。将来计划引入更多的知识, 来更好地度量词关系。

[1] 黄萱菁, 张奇,吴苑斌. 文本情感倾向分析[J]. 中文信息学报,2011, 25(6):118-126.

[2] 姚天昉, 程希文, 徐飞玉, 等. 文本意见挖掘综述[J]. 中文信息学报, 2008, 22(5):71-80.

[3] 赵妍妍, 秦兵, 刘 挺. 文本情感分析[J]. 软件学报, 2010, 21(8):1834-1848.

[4] 周立柱,贺宇凯,王建勇.情感分析研究综述[J].计算机应用,2008,28(11):2725-2728.

[5] 吴琼, 谭松波, 程学旗.中文情感倾向性分析的相关研究进展[J]. 信息技术快报, 2010,8(4):16-38.

[6] 宋晓雷, 王素格, 李红霞.面向特定领域的产品评价对象自动识别研究[J]. 中文信息学报, 2010, 24(1): 89-93.

[7] 杨源, 马云龙, 林鸿飞. 评论挖掘中产品属性归类问题研究[J]. 中文信息学报,2012, 26(3):104-108.

[8] 徐琳宏, 林鸿飞, 赵晶. 情感语料库的构建和分[J]. 中文信息学报,2008, 22(1):116-122.

[9] 刘鸿宇, 赵妍妍, 秦兵, 等. 评价对象抽取及其倾向性分析[J]. 中文信息学报,2010, 24(1):84-88.

[10] 李寿山, 黄居仁. 基于Stacking组合分类方法的中文情感分类研究[J]. 中文信息学报,2010, 24(5):56-61.

[11] 谢丽星, 周明, 孙茂松. 基于层次结构的多策略中文微博情感分析和特征抽取[J]. 中文信息学报,2012, 26(1):73-83.

[12] Yue Lu, Malu Castellanos, Umeshwar Dayal, et al. Automatic Construction of a Context-Aware Sentiment Lexicon: An Optimization Approach[C]//Proceedings of WWW’11, 2011.

[13] Wayne Xin Zhao, Jing Jiang, Hongfei Yan, et al. Jointly modeling aspects and opinions with a MaxEnt-LDA hybrid[C]//Proceedings of the 2010 Conference on Empirical Methods in Natural Language Processing, 2010: 56-65.

[14] David M Blei, Andrew Y Ng, Michael I. Jordan. Latent Dirichlet allocation [J]. Journal of Machine Learning Research, 2003,3(3): 993-1022.

[15] Qiaozhu Mei, Dengyong Zhou, Kenneth Church. Query suggestion using hitting time[C]//Proceedings of the 17th ACM conference on Information and knowledge management (CIKM ’08), 2008.

[16] Samuel Brody, Noemie Elhadad. An unsupervised aspect-sentiment model for online reviews[C]//Proceedings of Human Language Technologies: The 2010 Annual Conference of the North American Chapter of the Association for Computational Linguistics (HLT ’10), 2010.

[17] Minqing Hu, Bing Liu. Mining and summarizing customer reviews[C]//Proceedings of SIGKDD,2004: 168-177.

[18] L Zhuang, F Jing, X Zhu. Movie review mining and summarization[C]//Proceedings of CIKM ’06, 2006: 43-50.

[19] Thomas Hofmann. Probabilistic latent semantic indexing[C]//Proceedings of SIGIR ’99, 1999: 50-57.

[20] I Titov, R McDonald. Modeling online reviews with multi-grain topic models[C]//Proceeding WWW ’08,2008: 111-120.

[21] X Ling, Q Mei, C Zhai, et al. Mining multi-faceted overviews of arbitrary topics in a text collection[C]//Proceeding of the 14th ACM SIGKDD, 2008:497-505.

[22] A Hassan, D Radev. Identifying text polarity using random walks[C]//Proceedings of the 48th Annual Meeting of the Association for Computational Linguistics (ACL ’10), 2010:395-403.

[23] C Lin, Y He. Joint sentiment/topic model for sentiment analysis[C]//Proceedings of the 18th ACM conference on Information and knowledge management (CIKM ’09), 2009: 375-384.

[24] Yohan Jo, Alice H. Oh. Aspect and sentiment unification model for online review analysis[C]//Proceedings of the fourth ACM international conference on Web search and data mining (WSDM ’11).2011: 815-824.

[25] J Zhu, H Wang, B. K. Tsou, et al. Multi-aspect opinion polling from textual reviews[C]//Proceeding of CIKM ’09, 2009: 1799-1802.

[26] Thomas L Griffiths, Mark Steyvers. Finding scientific topics [J]. Proceedings of the National Academy of Sciences,2004, 101(Suppl 1): 5228-5535.

[27] Gayatree Ganu, Noémie Elhadad, Amélie Marian. Beyond the stars: Improving rating predictions using review text content[C]//Proceedings of International Workshop on the Web and Databases, 2009.

[28] Ben He, Craig Macdonald, Jiyin He, et al. An effective statistical approach to blog post opinion retrieval[C]//Proceeding of CIKM 2008, 2008: 1063-1072.

Learning Aspect-Dependent Sentiment Knowledge for Online Customer Reviews

XU Xueke1,2,TAN Songbo1,LIU Yue1,CHENG Xueqi1,WU Qiong1

(1. Institute of Computing Technology, Chinese Academy of Sciences, Beijing 100190, China; 2. University of Chinese Academic of Sciences, Beijing 100190, China)

This paper addresses the problem of learning aspect-dependent sentiment knowledge. Specifically, a novel topic model, called Joint Aspect/Opinion Model (JAO), is proposed to detect aspects and aspect-specific opinion words simultaneoasly in an unsupervised manner. Then, we propose to infer aspect-dependent sentiment polarity scores for these opinion words based on the hitting times from the words to a handful of positive/negative seed words, by applying Markov random walks over an aspect-specific word relation graph. Experimental results on restaurant review data show the effectiveness of the proposed approaches.

online customer review; joint aspect/opinion model; hitting time; aspect-dependent sentiment knowledge

徐学可(1983—),博士,助理研究员,主要研究领域为Web观点检索与挖掘、文本分类及自然语言处理。E⁃mail:xuxueke@software.ict.ac.cn谭松波(1978—),博士,副研究员,主要研究领域为情感分析,文本分类,机器学习等。E⁃mail:tansongbo@software.ict.ac.cn刘悦(1971—),博士,副研究员,主要研究领域为信息检索,社区挖掘与分析,分布式计算等。E⁃mail:liuyue@ict.ac.cn

1003-0077(2015)03-0121-09

2012-05-07 定稿日期: 2012-07-09

国家高技术研究发展计划(863计划)项目(2010AA012502、2010AA012503);国家自然科学基金资助项目(60933005、60903139、61100083)

TP391

A