对角神经网络陀螺随机误差建模研究

杨益兴

(海军驻中国船舶重工集团公司第七〇一研究所军事代表室,湖北 武汉430064)

0 引 言

陀螺仪作为惯性导航系统的核心器件之一,其精度直接决定惯性导航系统的性能,故对陀螺仪误差的研究具有非常重要的意义。陀螺仪的误差可分为系统性和随机性两大类。对于系统性误差,可根据其规律进行相应的标定来补偿;而随机性误差是由陀螺内部和外部的干扰引起的一种随机误差,它受各种不确定因素的影响,不能进行离线的标定,是惯性元件的主要误差源之一。随着对随机误差理论的研究,产生了多种分析陀螺随机误差的方法,如Allan 方差、ARMA、小波理论、神经网络等方法都被应用到随机误差分析中,并取得一定成果[1-7]。

对于陀螺的随机误差模型,通常假设其为白噪声与有色噪声的组合[8]。这种假设把白噪声从随机误差中分离出来,符合Kalman 滤波器的驱动要求,同时利用微分方程描述有色噪声,便于实现在线估计与补偿,但这种方法的缺陷也非常多[9]。ARMA 方法基于时间序列数据,建立差分方程。利用ARMA 方法对陀螺随机误差进行建模可以达到较理想的效果。模型检验通过后,接受在置信区间内残差为白噪声的假设,便于误差的滤波补偿。但陀螺的随机误差呈现一定非线性特性,而ARMA 模型是一种离线的线性模型,其处理的数据须为平稳时序数据,且还需事先判定模型的阶次等[10],操作比较复杂。当模型发生变化时,ARMA 又需重复操作上述过程。

神经网络具有任意非线性映射的能力,可对未知系统进行数学建模。神经网络的时序建模广泛采用外递归神经网络,其思想是借鉴ARMA 建模方法,利用神经网络来代替ARMA 模型。不同于外递归网络,对角递归神经网络(DRNN)[11]是一种局部内递归神经网络。DRNN的内递归特性使其具有很好的动态特性,能实现动态的非线性映射,同时DRNN 不必像ARMA和外递归神经网络一样,必须判定模型的阶次;DRNN的局部递归特性使其拥有更少的权值,从而减少了它的训练时间,有更好的实时性。本文应用DRNN 对光纤陀螺的随机误差进行建模分析,网络利用LMBP算法进行训练,并与ARMA 方法和外递归BP 网络所建模型进行对比。仿真并对随机误差进行预测,验证模型的有效性,并证明了利用DRNN 建模更加有效。

1 对角递归神经网络

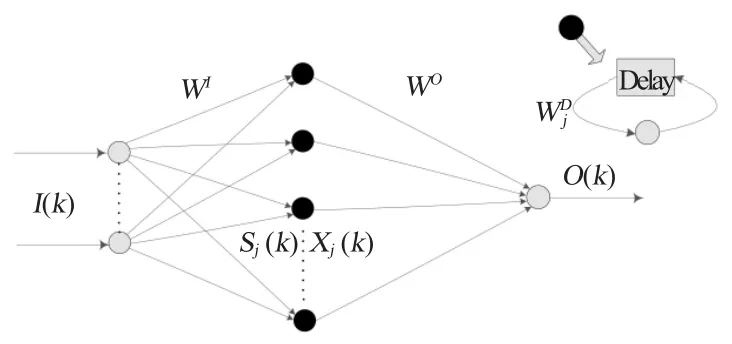

对角递归神经网络(Diagonal Recurrent Neural Network,DRNN)是一种内部递归神经网络,其特点是隐层神经元有自我延迟反馈。DRNN 是Elman 递归网络的一种简化形式,它隐层的神经元只接收自己的延迟反馈,与其他同层神经元没有反馈连接。因此,相比Elman 这种全局反馈递归网络,DRNN 具有更简单的结构,网络有更好的实时性能与学习速度,且仍能实现动态映射。DRNN的网络结构如图1所示。

图1 DRNN 结构图Fig.1 The structure of DRNN

DRNN 有3 层网络,设输入神经元为n个,隐层神经元为h个,输出神经元为1个。其数学描述如下:

式中:I(k)为网络输入;O(k)为网络输出;Sj(k)和Xj(k)分别为隐层第j个神经元的输入与输出;下标为0的代表偏置输入,这里取值为1;WI为输入层到隐层的权值矩阵与偏置值;WO为隐层到输出层的权值矩阵与偏置值;为隐层第j个神经元自递归的权值与偏置值;隐层神经元激活函数f(x)取S 函数,输出神经元激活函数取线性函数。

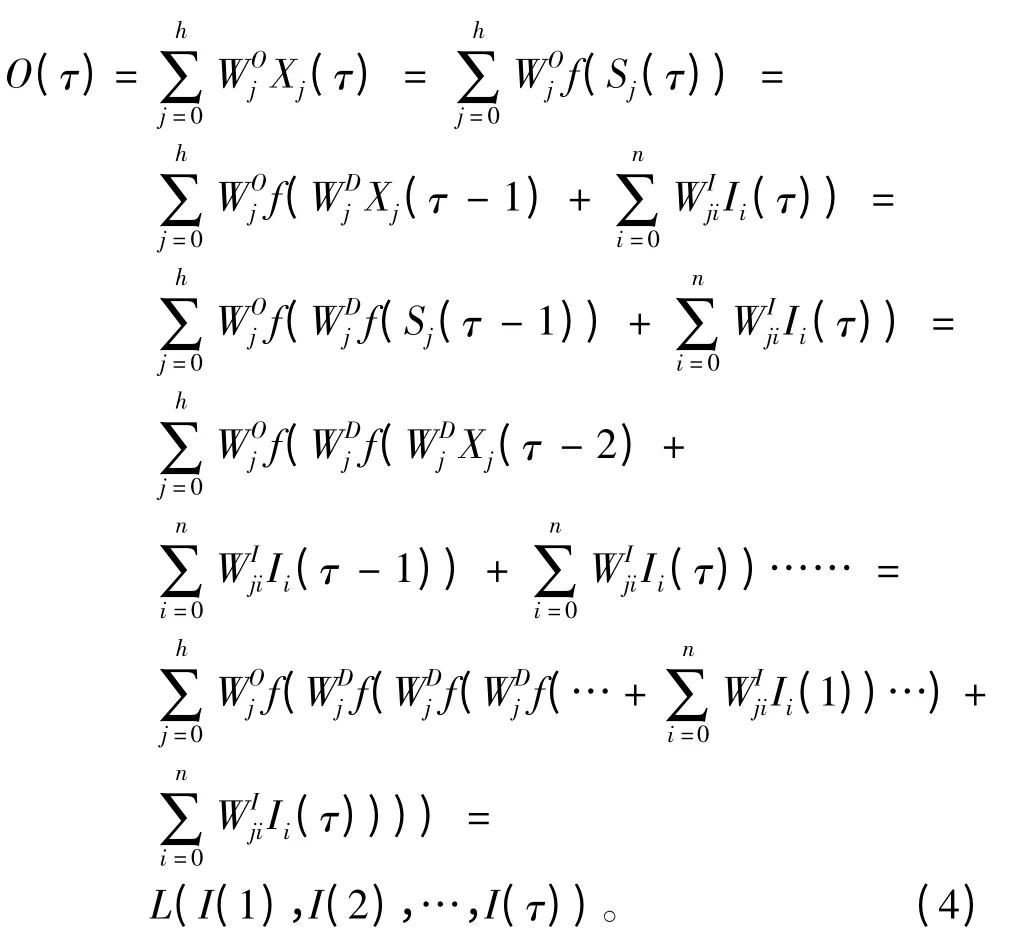

利用神经网络对时间序列数据进行建模已有应用,其主要思想是仿照ARMA 模型方法进行非线性的建模[12],具有延迟的外部递归神经网络非常好地体现了这一特点。DRNN 作为具有延迟的内递归神经网络,同外递归神经网络一样可以实现时间序列建模预报[13],并且不需要事先知道模型的阶次,其简要证明如下:

设有时间序列{x(1),x(2),…,x(t)},预测任意τ(τ=1,2…t)时刻,相对应网络输出为O(τ),有如下公式

2 DRNN的训练算法

利用BP算法扩展形成的通过时间的反向传播(BPTT)算法对递归神经网络进行训练。同BP算法一样,BPTT算法基于梯度下降法,具有局部收敛和收敛速度慢等缺陷。为了加速BP算法的收敛,已有许多方法对BP算法进行改进。这方面的研究大致可分为2 类:一类为启发式信息技术;另一类则集中在数值优化技术上,如LM算法。LM算法为牛顿法的变形,它最小化那些作为其他非线性函数平方和的函数[14]。引入LM算法优化网络的训练会比BP算法有更快的收敛速度。本文采用适用于DRNN的LMBP算法为训练算法。

2.1 LM算法

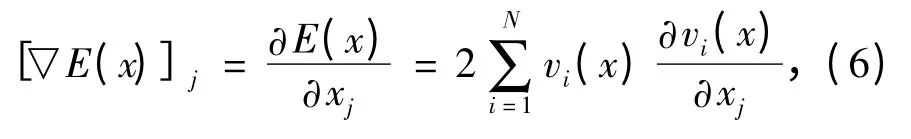

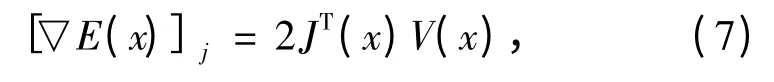

对于性能指数函数

其第j个梯度分量

可以写成矩阵形式有

其中J(x)s 为雅可比矩阵。如下式:

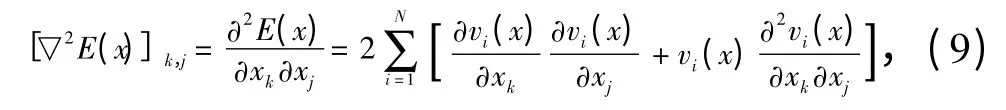

E(x)的Hessian 矩阵的第(k,j)个元素有如下式

E(x)的Hessian 矩阵可表示为:

优化性能指数的牛顿法如下:

把式(7)、式(10)代入式(11)可得Gauss-Newton 方法:

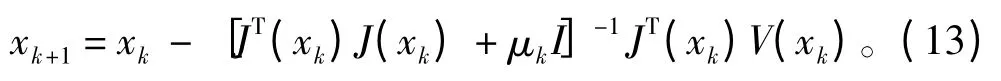

其中,矩阵H=JTJ 不一定可逆,可用G=H+μI代替。只要对于H的任意特征值λi,有λi+ μ >0即可使G 可逆。至此,可以导出LM算法如下:

其特点是:μk下降到0 时,算法变成Gauss-Newton法;当μk增加时,类似与有较小学习速度的最速下降法。

在开始时,μk取小值,若某一步不能使E(x)减小,则将μk乘以一个大于1的数θ,重复操作这一步;如果E(x)减小,则μk在下一步被除以θ,可提高收敛速度。

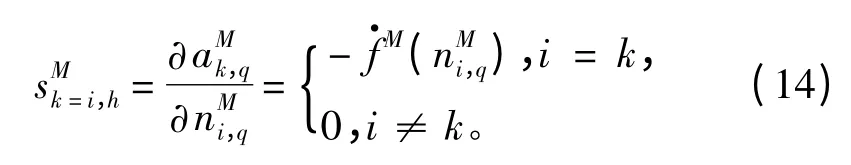

LM算法同BP算法,都利用敏感度进行反响的传播进行逆推计算来更新权值,所用方法也是相同的。其不同之处在于最后一层的敏感度计算上。对于LM算法,其最后一层的敏感度为

式中:M 为最后输出层;a 为当前层的神经元输出;n为当前层神经元的输入;的定义同BP算法。

所以相对于输入I(k),其对应的输出O(k)计算得到后,LMBP算法的反向传播被初始化为

2.2 DRNN的LMBP算法

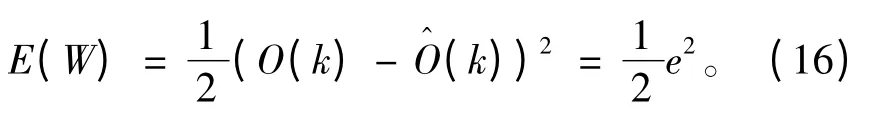

对于DRNN 网络,其结构如上所述,数学描述如式(1)~式(3)所示。取性能函数为均方误差之和,即

其中Pj(k)和Qij(k)如下式

式(16)~式(22)可以求得雅可比矩阵,应用到LM算法内,即可得到DRNN 网络的LMBP算法。其算法步骤如下:

1)初始化DRNN,选择适当的初始参数,取适当的μk和θ;

2)带入新样本到网络,计算出误差与性能函数;

3)计算出雅可比矩阵,并按式(15)初始化敏感度,然后递归计算敏感度;

4)按式(13)进行权值计算;

5)用步骤4 计算的权值再次求性能函数:如果性能函数减小,则让μk除以θ,并按计算值更新权值,转到第2 步接着训练;如果新计算的性能函数没有减小,则让μk乘以θ,转到第4 步计算,然后按顺序执行算法。

当性能函数到达目标值时或者梯度的模小于给定值,算法被认为收敛。

3 基于DRNN的陀螺随机误差建模

陀螺的随机误差建模有2 种形式:机理分析建模和基于输入输出关系的序列数据分析建模。对于序列数据建模,常用方法有ARMA和Allan 方差等,它以实验实测数据为基础进行建模分析,然后进行相应补偿。ARMA 方法已经有很多的研究应用,但ARMA 有其固有的局限性,在建模前需要平稳化的相关操作,建模时必须定阶等,并且一旦模型发生变化,必须重新进行定阶计算并验证。神经网络具有任意非线性映射的能力,理论上可处理非平稳的时间序列,对角递归神经网络(DRNN)更是不需要假定模型的阶次等优点。鉴于这些原因,本文利用DRNN 对陀螺的随机误差进行建模。

本文以某型号光纤陀螺的静态实验数据为基础,数据采集频率为1 Hz,采集7 h数据。取陀螺X 轴处于稳定运行状态的7 200~21 600 s的零漂数据,如图2所示。对原始数据进行自相关与互相关分析,如图3所示。

图2 预处理后实测数据Fig.2 The measured data with pretreatment

图3 陀螺随机误差自相关、互相关分析Fig.3 Gyro random error autocorrelation and cross-correlation analysis

陀螺输出数据表现出了较强的自相关特性,有周期性的噪声干扰;互相关也有明显的拖尾现象。对数据进行平稳化处理,模型的定阶等处理都比较麻烦。

采用本文所讨论的DRNN 对陀螺的随机误差进行建模,用DRNN的LMBP算法进行训练。在本DRNN 网络中,以k 时刻的误差数据和k-1 时刻的网络估计值作为网络输入,来预测k+1 时刻的输出。所采用的DRNN 为3 层结构网络:输入神经元2个,输出神经元1个;通过多次训练,确定隐层的神经元个数,取20个隐层神经元。取前500个数据对网络进行训练,然后用其后的2 000 组数据进行模型验证,训练后部分跟踪数据,效果如图4所示。

对拟合的残差进行分析,发现残差均值为1.494 6E-005,残差方差为0.001 027,对残差进行白噪声验证,在置信区间接受白噪声假设。利用训练好的网络进行预测,取其前150 组预测数据,效果如图5所示。

为了进行对比,对数据进行平稳化处理等操作,然后利用ARMA 方法对随机误差进行建模,采用陀螺ARMA 建模最适用的ARMA (2,1)模型(AIC准则选取),对残差进行白噪声检验,结果接受白噪声假设,模型适用并进行数据预测。然后根据ARMA 模型选取的阶次,建立外递归BP 网络,同样进行随机误差数据的建模训练。外递归BP 网络的隐层神经元个数同DRNN。对残差进行检验,结果接受白噪声假设并用训练好网络进行预测。这2组对比实验采用的建模数据和预测验证数据与DRNN的完全相同。ARMA (2,1)前150 组预测效果如图5所示,外递归神经网络效果图不易直观得出结论及进行定量分析(见表1)。

图4 DRNN 预测效果图Fig.4 The prediction effects of DRNN

图5 ARMA (2,1)预测效果图Fig.5 The prediction effects of DRNN ARMA (2,1)

通过均值、方差对这3 种方法进行量化对比,结果如表1所示。从表1 可发现,DRNN 建模效果明显好于ARMA (2,1)模型;较外递归BP 网络,DRNN 建模效果亦有提升。

表1 三种建模方法效果对比Tab.1 Comparative effects of three modeling methods

4 结 语

本文使用对角递归神经网络(DRNN)对陀螺的随机误差进行建模。由于DRNN 作为一种局部内递归神经网络,比全局递归神经网络拥有更少的训练参数,从而能利用更少的时间完成对网络的训练,具有更高的效率;相比常规的外递归神经网络建模,不必假设模型阶次,输入层拥有更少的神经元;相比于ARMA 建模方法,DRNN的优势明显:DRNN建模更加简单直观;不用像ARMA 那样假定模型的阶次,其内递归特性使其可以只用2个输入神经元即可。MatLab 仿真结果表明,相比ARMA 建模和外递归神经网络建模,DRNN 可以更加精确有效的进行陀螺随机误差建模,拥有更好适用性。

[1]NASER E S,HOU Hai-ying,NIU Xiao-ji.Analysis and modeling of inertial sensors using allan variance[J].IEEE Transactions on Instrumentation and Measurement,2008,57(1):140-149.

[2]李颖,陈兴林.ARMA 模型辨识及其在光纤陀螺漂移建模中的应用[J].系统工程与电子技术,2008,30(9):1752-1754.

[3]卢海曦,夏敦柱,周百令.基于遗传小波神经网络的MEMS 陀螺误差建模[J].中国惯性技术学报,2008,16(2):216-219.

[4]谈振藩,张勤拓.MEMS 陀螺误差辨识与补偿[J].传感器与微系统,2010,29(3):39-41.

[5]何志昆,王雪梅.激光陀螺随机误差的非参数建模与滤波[J].航天控制,2009,27(5):24-27.

[6]梁莹,谈振藩,张庆,等.一种光纤陀螺随机漂移的高精度建模方法[J].哈尔滨工程大学学报,2009,30(11):1251-1255.

[7]李佳桐,张春熹,张小跃,等.光纤陀螺随机漂移的建模与滤波[J].现代电子技术,2013,36(2):129-131.

[8]武汉大学测绘学院测量平差学科组.误差理论与测量平差基础[M].武汉:武汉大学出版社,2005.

[9]韩松来.GPS和捷联惯导组合导航新方法及系统误差补偿方案研究[D].长沙:国防科技大学,2010.

[10]王振龙.应用时间序列分析(第二版)[M].北京:中国统计出版社,2010.

[11]KU Chao-chee,KWANG Y L.Diagonal recurrent neural networks for dynamic systems control[J].IEEE Transactions on Neural Networks,1995,6(1):144-156.

[12]CHNG E S,CHEN S,MULGREW B.Gradient radial basis function networks for nonlinear and nonstationary time series prediction [J].IEEE Transactions on Neural Networks,1996,7(1):190-194.

[13]王科俊.神经网络几个理论问题的研究及其在船舶横摇运动建模与预报中应用[D].哈尔滨:哈尔滨工程大学,1995.

[14]戴葵,译.神经网络设计[M].北京:机械工业出版社,2002.