目标跟踪器性能评估方法研究进展

王全宁,周 进,雷 涛,唐自力

(1.中国科学院光电技术研究所,四川 成都 610209; 2.中国科学院大学,北京 100049;3.中国华阴兵器试验中心,陕西 华阴 714200)

0 引 言

运动目标跟踪是计算机视觉领域的研究热点,各种跟踪算法层出不穷。由于外部环境的复杂性和目标本身的多变性,如光照变化、遮挡、相机抖动、目标尺寸变化、目标姿态变化以及相似干扰等,跟踪器易丢失目标。针对这些影响因素,分析跟踪器的跟踪性能,可以帮助人们更好地了解和选用跟踪算法。

跟踪算法的模型不同、原理各异,目的是当视频序列初始帧中给出目标的初始状态后,能估计后续帧中该目标的状态。而性能评估的目的是对算法所估计的目标状态的准确性做出判断和评价,它与算法的工作原理和模型更新机制无关。在早期的各种跟踪算法研究文献[1-2]中,算法性能测试缺乏公开的标准测试平台,并且使用的评估测量方法和测试数据集各异,无法直接分析、比较各算法性能的优劣性。过去的十几年间,在跟踪算法评估领域,一些用于跟踪算法性能评估的测量方法、测试数据集逐渐得到人们的认可。发展到现在,出现了专业的测试评估项目,这些项目提供了标准严格的测试平台。如今,算法对比验证工作越来越多地使用专业的评估方法来增强算法性能的说服力,或者选择专业的测试平台进行评估测试,与其他算法直接进行比较,还有以目标跟踪挑战赛的形式来比较具体算法的性能。专业的评估项目和其包含的评估测试平台是目前跟踪算法评估的最权威的选择。

评估方法、数据集和评估项目是性能评估发展的3个要素。

1)选择合适的评估方法是性能评估的基础。跟踪算法根据目标数量的不同,可分为单目标跟踪和多目标跟踪;根据目标的尺寸,可分为点目标跟踪、面目标跟踪和扩展目标跟踪;根据跟踪场景的不同,又可分为简单场景下的跟踪和复杂场景下的跟踪等。按照待评估算法的特点选择恰当的评估方法才能保证评估的准确性和算法间的可比性。

2)不同场景下测试序列构成的数据集是性能评估的重要一环。这些序列一般都会附带人工标注的目标相关信息,如每帧中目标的尺寸、位置及数量等,以便于评估和对比算法性能。

3)专业的评估项目是性能评估的重要组成。评估项目系统地研究解决评测问题,所建立的评估平台可以为算法对比提供条件和环境,极大地推动了跟踪算法的发展。

本文针对单目标、多目标及面目标跟踪算法的性能评估进行研究,从3个方面——评估测量方法、数据集、评估项目展开介绍。

1 评估方法

在计算机视觉的目标检测和分类、光流计算、自动分割领域已经有了广为接受的协议,但对跟踪特性的评估仍然没有统一的协议。虽然在跟踪评估方面已取得了一些成果[3-5],但它们有些是使用一种单一测量方法评估跟踪器某方面的一项指标,不能获得跟踪器的整体性能;有些是使用一整套方法评估跟踪器多个方面的性能,通过这种方法,评估结果会有多个指标,使得在比较跟踪器性能时变得更为复杂。典型的跟踪算法评估框图如图1所示。

图1 典型算法评估框图

在早期的评估测量方法中,部分学者侧重于关注视频序列的空间信息,比如,评估目标在某一帧的位置的正确性[6],还有学者从时间角度出发,评估跟踪器长时间连续有效跟踪的能力[7]。目前,将时间和空间信息相结合的评估方法成为了一个广受关注的方向。

1.1 评估方法的分类

常用的评估测量方法有2种,一种是跟踪结果与GT比较的评估测量方法,另外一种是无GT的评估方法[8-11]。无GT的评估方法根据帧间目标外观、轮廓相似性和帧间轨迹平滑性等信息评估目标跟踪效果。这种方法在目标外观或运动信息连续、缓慢的情形下有效,在光线、目标的方向或速度发生突然变化的场景下通常会失败。

多数评估方法将算法跟踪结果与GT相比较,使用以中心误差、区域重叠度为基础的各种指标。

1.2 单目标与多目标评估特点

单目标跟踪通常给出初始帧中目标的状态信息(如位置、尺寸等),然后由该目标相关信息自动估计后续帧中的状态。多目标的跟踪需要解决在连续帧中,对部分甚至全部目标错误跟踪或混淆跟踪的问题。许多文章[5,7,12-13]致力于解决多目标跟踪场景下的性能评估问题。与单目标跟踪评估相比,多目标跟踪的评估除了考虑鲁棒性和精度问题外,关键是对多个目标做标签,统计跟踪过程中前后帧标签的对应关系是否正确。

1.3 评估准则

1.3.1 中心位置误差

定义长度为N的序列中目标状态为:

(1)

其中,Xt∈R2表示目标的中心,Rt表示目标在t时刻时的区域。区域通常用矩形框来描述。每帧的中心位置误差[13-14]测量了目标预测中心和实际GT中心间的差别。

(2)

中心位置误差测量方法每帧只需要一个点,因此可以使人工标注过程产生的影响最小。整个序列的中心位置误差可以表示成平均误差和均方根误差的形式:

(3)

(4)

该方法的缺点是对人工标注的中心位置敏感,并且会忽略目标的尺寸大小,不能反映出跟踪失败与否。对此,文献[15]提出使用归一化的中心误差测量方法。这种方法可以去除目标尺寸对评估的影响,但当跟踪发生漂移时,归一化后的测量距离不能反映二者的真实距离,存在一定缺陷。

1.3.2 区域重叠度

PASCAL准则[16]中使用了测量区域重叠度的方法,计算跟踪算法结果的目标框与GT边界框之间的重叠面积,公式如下:

(5)

与中心误差测量方法相比,这种方法可以兼顾目标位置和尺寸,当跟踪产生漂移时,若重叠度低于预设阈值,则证明跟踪失败。区域重叠度的测量方法通常使用50%的阈值[17]。但该阈值的设定缺少理论依据,具有一定的参考价值,但并不精确。如图2所示,2个矩形框,外侧为GT矩形框,内侧为跟踪框,此时重叠度为49.8%,低于区域重叠度方法的阈值,但是实际上跟踪效果良好。

图2 跟踪结果与GT对比

1.3.3 基于阈值的测量方法

当跟踪成功时,即跟踪结果与GT重叠度高于预设阈值时,表示为true positive (TP);将非目标判断为目标,则表示为false positive (FP);未发现或定位目标可表示为false negative (FN)。由此衍生出以下常用测量指标。

测量跟踪精度的指标精确率(Precision)[1]和召回率(Recall)[1,12]公式如下:

(6)

(7)

Precision/Recall曲线一般是以召回率(Recall)为横坐标,精确率(Precision)为纵坐标。

F值(F-measure)[18]在PR空间[19]上描述分类性能的特性,在跟踪算法基于检测时有重要作用:

(8)

也可以写成:

(9)

TP率(也称检测率)tp、FP率fp、误警率fa和特异性sp公式如下:

(10)

(11)

ROC曲线(Receiver Operating Characteristic curve)及其线下面积AUC(Area Under Curve)源于目标检测领域。ROC曲线是以TP率为纵轴,FP率为横轴,实现最优分类参数的选择。AUC范围在0~1之间,AUC描述了分类器正例高于负例的概率。在目标跟踪领域的测量方法中,结果分为3种情形:TP、FP、FN,缺少TN,因此不便于使用ROC曲线。对此,文献[20]中提出了一种改进的评估方法,以坐标系的纵轴为TP率,横轴以误警率fa替代fp,使用多个重叠度阈值来确定跟踪结果与GT的关系。

1.3.4 基于目标的测量方法

PBM(Position-Based Measure)是基于位置的测量方法,计算GT中心和跟踪结果TO中心位置的距离均值。Th(i,t)定义为:

Th(i,t)=(width(GTi(t))+Height(GTi(t))+

width(TOi(t))+Height(TOi(t)))/2

(12)

若第t帧中GTi(t)和TOi(t)部分重叠,则D(i,t)定义为:

D(i,t)=ManhattanDistance(C(GTi(t)),C(TOi(t)))

(13)

C(x)表示x的中心。若GTi(t)和TOi(t)完全不重叠,D(i,t)定义为Th(i,t)。PBM定义为:

(14)

整个序列上的PBM定义为平均PBM[10]。

SBM(Size-Based Measure)是计算尺寸信息的方法,SBM数值越高,目标跟踪尺寸与实际尺寸越相近,算法的效果越好。Size_gttoi定义为第i个目标的GT和TO边界框尺寸之间的区别大小。

(15)

其中,GTi(t)为第t帧中目标i的边界框,TOi(t)为第t帧中跟踪结果i的边界框,Size(x)为x的尺寸。

(16)

其中,N代表目标的数目。

SFDA(Sequence Frame Detection Accuracy)是基于面积的测量方法[12],GT和TO是一一对应关系。

FDA(t)为第t帧的帧检测精度。

(17)

其中,NGT和NTO分别是GT目标和跟踪结果的边界框数量。

(18)

其中,Nmapped表示GT和TO之间一一对应关系的最大值。

SFDA测量整个序列的FDA(t)值。

(19)

1.3.5 跟踪长度

跟踪长度[19]统计从第一帧开始到跟踪失败期间成功跟踪的帧数,也是常用方法之一。跟踪失败的标准可以通过人为干预,即人为观察跟踪情况,判定失败与否;也可以通过重叠度方法,设置阈值,对有效跟踪长度进行自动判定。

1.3.6 跟踪失败率

跟踪失败率对整个跟踪过程进行统计,跟踪成功与否可以由跟踪结果与GT的重叠度阈值决定,阈值设得低一些,则统计的失败帧数会减少。当跟踪失败时,在失败处经过人工初始化后继续跟踪,记录每一帧人工干预的次数。这种方法可以反映真实场景下跟踪器在整个序列上的性能。与跟踪长度的方法相比,跟踪失败率可以充分利用整个序列的图像,即使开始时跟踪错误也并不会影响后续的评估。图3是对某跟踪算法数据的分析,横轴为帧序号,纵轴为重叠度,低于图中横线重叠度50%时,人工干预5次的结果。

图3 跟踪与重叠度阈值关系分析

1.3.7 度量指标的选取

通常情况下,跟踪算法输出结果包含每一帧中目标位置和尺寸2个方面基本信息,算法评估可以选取区域重叠度和中心位置误差2个基本测量指标。区域重叠度相比中心位置误差更为常用,原因在于,区域重叠度既能反映每一帧中的目标跟踪精度,又可以反映跟踪成败与否;中心位置误差由于受目标尺寸变化的影响,只能反映每一帧中的跟踪精度这一方面的信息。

基于阈值的测量方法是在整个序列的角度统计目标整体跟踪精度,这种方法同时适用于单目标跟踪和多目标跟踪评估。基于目标的测量方法分别计算目标距离、尺寸、重叠面积方面的信息,使用时往往需要相互参考,由此得到的评估结果才能全面准确,其中PBM和SBM适于单目标跟踪评估,SFDA更适用于多目标跟踪评估。

在算法评估过程中需要结合评估需求及评估指标特点灵活选用。

1.4 评估结果的可视化

1)图表。以图表的方式,如折线图和柱状图,可以清晰直观地说明性能评估结果。文献[15-16]以图表形式展示连续序列中的中心误差测量结果。而当多个跟踪器在一个图表中比较时,比如跟踪器之间性能相近,图表变得杂乱,直观性下降。同时图表信息还可以展示重叠度等测量结果。

2)排名。计算跟踪器某方面或整体性能的得分,如抗干扰、遮挡、形变、尺度变化的能力方面,根据性能高低排序,利用表格实现可视化。

2 数据集

大多数算法选择在公共可用的数据集上测试结果。理想的基准数据集需要对目标真值标记标签,均匀覆盖真实世界中各种对跟踪具有挑战性的因素。数据集中各种挑战性因素,包括遮挡、相似背景干扰、目标姿态变化、光照变化、尺度变化等。人工进行标注时,过程繁琐、工作量大,制作一个大规模的综合的基准数据集需要付出巨大的努力。因此目前多数数据集缺乏相应的完整的目标标注信息。

2.1 数据集的GT标注方法

目标标注的质量直接影响评估的结果。对于不同的视频序列,目标的特征差异巨大、信息量不同,没有通用的标注方法。针对目标的特征,可能会选择矩形、圆形、椭圆形等几何图形标注框,在最大程度包含目标全部特征的同时,尽可能减少掺杂背景的干扰。有多个目标时,为每个目标贴上唯一的标签,有利于准确评估该算法的跟踪能力。

目前,有很多可用的标注工具,如Anvil、VideoAnnex、ViPER等。

1)Anvil提供基于用户定义的可多层标注的编码方式。通过编码,用户可以从时间序列上看到多个编码后颜色不同的跟踪部分。Anvil如今被用在人机交互、语言学、动物行为学、人类学、电脑动画、海洋学等领域。

2)VideoAnnex标注工具帮助用户使用MPEG-7元数据标注视频序列。视频序列的每一个视频片段被标注为静态画面描述、关键目标描述和事件描述。这些信息会以MPEG-7方式的描述存储到输出的XML文件中。

3)ViPER使用元数据标注视频,主要是作为性能评估的GT使用,产生的信息包括拍摄日期、内容关键字、具体特征等。它可以标注人物在画面中的位置,标注形状包括点、矩形框、椭圆等方式。为了保证GT的质量,通常要对整个数据集10%的内容进行双倍标注和核对工作。

此外,在亚马逊劳务外包平台(Amazon Mechanical Turk,AMT)上,标注任务可以在线有偿地交给其他人去完成,约有50万注册用户按照任务发布者的要求来进行数据集标注工作,这种方式大大减轻了科研人员的负担。CrowdFlower也是类似的网络平台,用户在上面发布工作内容和要求后,相关人员按照要求进行处理。

2.2 常用的数据集

OTB-2013[21](又称OTB-50)和OTB-2015[21](又称OTB-100)是广泛应用的跟踪数据集,包括运动模糊、旋转、光照变化、尺度变化、形变、遮挡、背景干扰等11个属性。每个序列都有相应的GT数据,记录目标的位置和尺寸信息。2个数据集中各含有25%的灰度序列,75%的彩色序列。

VOT数据集依托于VOT竞赛,每年会有更新,其中部分序列和OTB数据集重合。如VOT2017对所有序列的GT重新进行了标定,精确到像素级,之后拟合成矩形框。总体上,跟踪难度大于OTB数据集。

CAVIAR数据库[22]共有超过80个室内视频片段,视频拍摄角度:INRIA入口大厅视角、商场购物正面视角以及商场购物走廊视角。数据集包括人们步行、相遇、购物、打架、进出商场等行为,它对每个移动目标使用边界框标注,对没有移动的行人不加以标注。

i-LIDS数据集是在英国政府支持下的视频监控分析项目中产生的,包含4个场景:泊车、被丢弃的包、在一个受限制区域步行和门口的监控。由于视频长度超过24小时,这些视频没有进行全部的标注标签工作。

PETS[23]是一个对跟踪和监视进行性能评估的项目。提供2个数据集:1)ARENA数据集是用来保护关键移动资产的多传感器数据集;2)P5数据集主要解决多传感器监视的问题,以确保核电站周边的安全。数据集包括低级视频分析(检测、跟踪),中级分析(原子事件检测)和高级分析(复杂的“威胁”事件检测)的各种任务。ARENA和P5数据集分为3种类型的场景:“正常”,“警告”,“报警”。视频自2000年开始收集以来,现在一共有几十个,其中大多数视频手工标注了边界框。

ETISEO[24]数据集从一个被固定的相机角度获取包含80个各种各样的室内和室外视频场景片段。标注的真值主要包含高级信息,如:边界框、目标类型、事件类型等。该数据集适于跟踪、分类和时间识别。

MIT Traffic Data Set数据集是为行为分析和拥挤场景研究而建立的。它包含90 min静止拍摄的交通视频序列,分为20个片段。

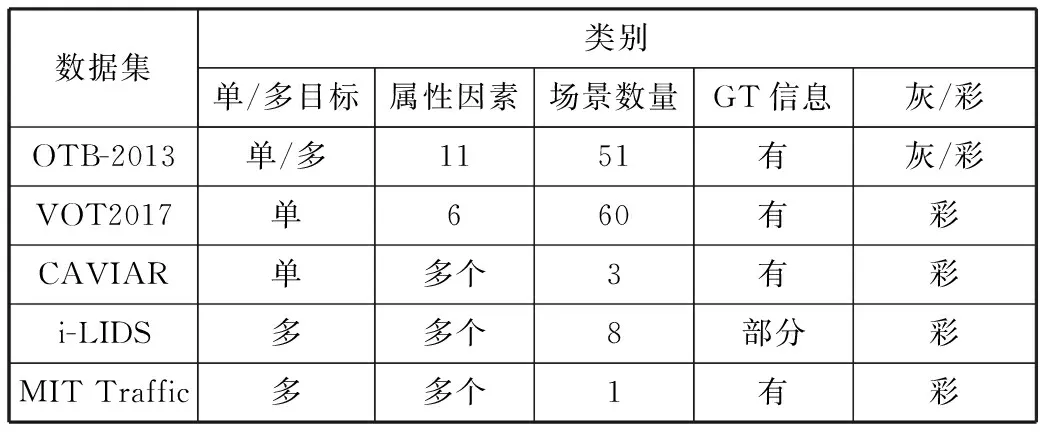

表1列出了部分数据集,包含单目标/多目标、影响跟踪的属性的数量、包含场景的数量、有无GT信息、序列为灰色/彩色5个方面的内容。

表1 部分数据集信息

数据集类别单/多目标属性因素场景数量GT信息灰/彩OTB-2013单/多1151有灰/彩VOT2017单660有彩CAVIAR单多个3有彩i-LIDS多多个8部分彩MIT Traffic多多个1有彩

3 评估项目

为评估视频跟踪算法的性能,产生了许多评估项目。评估项目在同一平台下采用相同的实验方法对跟踪结果进行评估。知名的评估项目有PETS、CVACE、CREDS、CLEAR、ETISEO和AVIAR等。这些研究项目提供不同跟踪难度的视频序列,并且对其中部分序列进行标注。评估项目会发现视频检测跟踪算法处理过程中的问题,提出算法性能表现若令人满意时需满足的条件。

3.1 VOT

Visual Object Tracking Challenge(VOT)是视觉跟踪领域重要的测评平台。VOT竞赛对复杂场景下无目标外观预学习的单目标短时跟踪算法进行一个可重复性的测评,同时也会讨论评估方法和跟踪算法的进展。目前VOT竞赛已经举办了5届,每年测试序列都会更新,标注精度也会提高,因此VOT竞赛难度远超其他数据集上的竞赛。VOT主要使用平均重叠期望、准确率、鲁棒性3个指标进行评估。

3.2 Object Tracking Benchmark

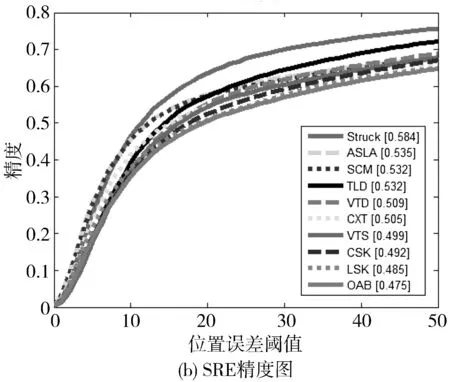

Object Tracking Benchmark[21]建立了一个代码库和测试数据集,代码库包括了大部分公开可获得的跟踪器,并统一了输入输出格式,便于性能评估,目前有29个跟踪算法。测试数据集使用上述OTB-2013和OTB-2015。它使用2个评价指标:中心位置误差和重叠度。3种评价方式,分别是One-Pass Evaluation(OPE)一次评测(初始帧给定GT,算法测试);Temporal Robustness Evaluation(TRE)时域鲁棒性评测(有时间干扰,任意帧开始跟踪测试);Spatial Robustness Evaluation(SRE)空域鲁棒性评测(初始帧GT有干扰,算法测试)。

3.3 PETS

国际跟踪和监控绩效评估研讨会(PETS)已成功举办了十多年,主要关注多目标跟踪和事件识别等先进的原创算法。以2015年为例,PETS2015是由欧盟资助的项目:Privacy Preserving Perimeter Protection Project(P5),讨论多传感器监控在关键基础设施保护方面的应用。PETS目标是通过提供评估数据集和指标来评估视觉跟踪和监视算法,促进计算机视觉技术的检测和跟踪。

3.4 ETISEO

ETISEO是一个视频监控系统的性能评估项目。给定一个视频处理任务(如:目标检测、分类、跟踪和时间识别)和一类场景(如:道路),ETISEO可以评估对应的视频处理算法。该项目致力于研究算法和视频特征间的关联,为特定算法挑选合适的场景特征,并且指出算法的缺点,以便进一步改进算法。

ETISEO处理一些经过详细说明和分类过的视频。比如从至少3方面研究阴影问题:1)统一无彩色背景模型下的不同强度等级的阴影;2)背景颜色和语义信息不同时相同强度等级的阴影;3)不同波长的光照度下的阴影。ETISEO针对某一问题,对所使用的视频序列难度进行分级,以便进行细致研究。ETISEO提供自动评估工具,分析算法性能。

3.5 VACE

VACE主要研究视频情报内容的自动分析。如今,视频数量和规模不断剧增,需要一种鲁棒性的自动化的视频工具分析情报。此外,还有军事方面对操作要求实时性的需求。视频在内容、空间和时间上都含有丰富信息,可以提取事件的动态信息,而图像上只能提取静态信息。为获取有用的情报,通常需要花费大量时间手工提取、标注和分析不断增多的视频内容。而VACE所要研究的技术将提升视频自动化分析的有效性。VACE的目标是自动化挖掘视频信息的精确度达到人类的水平,速度达到实时性要求。

3.6 评估项目比较

PETS、ETISEO、VACE都是视频监控系统,PETS和VACE倾向于高层次事件分析,主要目的是跟踪性能评估、视频分析和内容提取等;ETISEO从算法开发者角度出发,针对特定场景,研究视频特征和算法间的依赖关系,指出算法的不足;而PETS和VACE主要以终端用户角度给出分析结果。

4 实验分析

传统的评估方法采用OPE测试,即给定起始帧GT位置后,跟踪器开始运行至序列末尾,分析其性能。但是初始化的位置不同或者起始帧的变化都有可能影响跟踪结果。

本实验使用Core i5的PC机,运行软件Matlab2014。在Object Tracking Benchmark[21]测试平台上评估25种典型算法[21]。测试数据集为OTB-2013。使用基于位置误差度量的精度图和基于重叠度度量的成功率图进行OPE、SRE和TRE测试。在评测中,TRE的实现是对给定的视频序列选取8帧不同的图像作为初始帧,给定GT位置,跟踪器在这8种不同的初始帧情况下分别运行至序列末尾,并对这8种情况的数据进行综合统计。SRE是通过移动和缩放初始帧中的目标GT位置,观察GT位置变化对跟踪结果的影响。该评测使用了8个空间移位(上、下、左、右、左上、右上、左下、右下)和4个缩放尺度(0.8,0.9,1.1,1.2),其中空间移位不改变GT框缩放尺寸、缩放尺度不改变GT框空间位置。测试结果(性能排名前10算法)如图4所示。

图4 TRE、SRE、OPE成功率和精度

从图4可以看出,除了OPE成功率测试中,SCM比Struck性能高2.6%外,Struck均排名首位,说明Struck算法具有较高的鲁棒性。整体来看,在成功率和精度2个方面,TRE的平均性能均高于OPE,原因是当初始帧不是第一帧时,测试序列的长度变短,通常跟踪器在较短的序列上表现更好;而SRE的平均性能低于OPE,初始化时信息的不准确导致算法在跟踪过程中引入了更多的错误,降低了跟踪准确性。

与OPE测试相比,TRE和SRE测试分别分析了初始化时时间和空间信息的变化对跟踪算法的影响。以图中ASLA算法为例,OPE精度图中,ASLA性能评分排名第八,而在TRE和SRE精度图中,排名却分别上升了3位和6位,同样,在成功率图中,与OPE相比,TRE和SRE排名也有不同程度的上升。说明OPE测试中结果偶然性较大,不能很好地描述算法真实性能。

本例作为评估过程中考虑时空因素对算法影响的一种方法,说明OPE测试结果易受初始化信息的影响,而采用时空结合的测试结果更为接近算法的真实性能,使得评估结果更为准确可靠。同时可以看出,在同一测试平台上采用相同的测试指标、序列对不同算法进行测试,评估结果更具说服力。

5 结束语

本文从评估方法、数据集和评估项目3个主要方面,对性能评估的现状作了整体的介绍。总体来看性能评估方法始终与跟踪算法发展同步。早期的跟踪算法性能较弱,只需要采用难度较小的测试序列,评估指标较为单一。近些年随着各种优秀跟踪算法的不断涌现,以及性能的大幅提升,原有的零散的测试序列已经难以准确区分和比较算法间的性能,因此出现了测试场景更为全面,跟踪难度等级更多,标注更为精准的测试序列,最大程度地体现各种现实场景,评估指标也更为多样,力图充分挖掘跟踪算法结果输出信息,从多个方面和角度反映算法的性能。专业的性能评估项目及评估测试平台对跟踪算法的蓬勃发展起到了重要的作用。

与此同时,性能评估还存在一些亟待解决的具体问题,比如:对测试序列内场景复杂度的分析不足,算法在测试的过程中,因素间的互相关作用对算法的影响往往超乎想象,此时,若简单地将跟踪失败归结于某一个因素的影响是不合理的;其次,多数评估方式未能充分利用完整帧序列信息,算法在某一帧跟踪失败后,会造成后续帧中一系列的错误跟踪位置,这些后续的帧序列没有得到合理使用。这些问题可以分别通过对序列中影响因素精细化标注以及序列帧分段测试、重新初始化等方式解决。

目前,性能评估方法得益于跟踪算法研究的大幅进步,正处于快速发展且不断完善的阶段。整体发展趋势主要体现在以下方面:

1)针对各类跟踪算法建立一套完整的评估指标体系,面对不同测试对象,指标的选取以及权重的分配将更为合理、规范。

2)基准数据集的有限性限制了跟踪算法的研究重点,围绕有限的数据集,针对性地提高算法性能,背离了数据集创建的初衷。数据集将定期更新,呈现动态化发展趋势,另一方面,生成大规模仿真数据集对算法进行定量分析将成为一个研究方向。

3)跟踪算法评估流程趋于标准化,包括实验方法、性能要求、实验流程等,以使评估达到便捷、高效、准确的目的。

综上所述,跟踪算法性能评估是一个极具意义的研究热点,一方面,在跟踪算法各种评估需求的牵引下,评估方式会不断改进;另一方面,规范化的评估方式又将极大推动跟踪算法的进步。

参考文献:

[1] 张泽旭,李金宗,李冬冬. 一种鲁棒性的光流算法研究[J]. 电子学报, 2003,31(12):1851-1855.

[2] Nouar O D, Ali G, Raphael C. Improvedobject tracking with Camshift algorithm[C]// IEEE International Conference on Acoustics, Speech and Signal Processing. 2006,2.

[3] Antani S, Crandall D, Narasimhamurthy A, et al. Evaluation of methods for detection and localization of text in video[C]// Proc. Int’l Workshop Document Analysis Systems. 2000:507-514.

[4] Hua Xiansheng, Liu Wenyin, Zhang Hongjiang. Automatic performance evaluation for video text detection[C]// IEEE International Conference on Document Analysis and Recognition. 2001:545-550.

[5] Smith K, Gatica-Perez D, Odobez J, et al. Evaluatingmulti-object tracking[C]// IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR). 2005,3:36.

[6] Collins R, Zhou Xuhui, Seng K T. An open source tracking testbed and evaluation Web site[C]// IEEE International Workshop on Performance Evaluation of Tracking and Surveillance. 2005:17-24.

[7] Black J, Ellis T, Rosin P. A novel method for video tracking performance evaluation[C]// IEEE Joint Int. Workshop on Visual Surveillance and Performance Evaluation of Tracking and Surveillance. 2003:125-132.

[8] Han B, Hamm J. Qualitative tracking performance evaluation without ground-truth[C]// 2015 IEEE Winter Conference on Applications of Computer Vision (WACV). 2015:55-62.

[9] Sanmiguel J C, Cavallaro A, Martinez J M. Adaptive online performance evaluation of video trackers[J]. IEEE Transactions on Image Processing, 2012,21(5):2812-2823.

[10] Spampinato C, Palazzo S, Giordano D. Evaluation of tracking algorithm performance without ground-truth data[C]// IEEE International Conference on Image Processing. 2012:1345-1348.

[11] Wu Hao, Sankaranarayanan A C, Chellappa R. In Situ evaluation of tracking algorithms using time reversed chains[C]// 2007 IEEE Conference on Computer Vision and Pattern Recognition. 2007:1-8.

[12] Kasturi R, Goldgof D, Soundararajan P, et al. Framework for performance evaluation of face, text, and vehicle detection and tracking in video: Data, metrics, and protocol[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2008,31(2):319-336.

[13] Ross D A, Lim J, Lin R S, et al. Incremental learning for robust visual tracking[J]. International Journal of Computer Vision, 2008,77(1-3):125-141.

[14] Babenko B, Yang M H, Belongie S. Robust object tracking with online multiple instance learning[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2011,33(8):1619-1632.

[15] Ji Hui, Ling Haibin,Wu Yi, et al. Real time robust L1 tracker using accelerated proximal gradient approach[C]// IEEE Conference on Computer Vision and Pattern Recognition. IEEE Computer Society. 2012:1830-1837.

[16] Everingham M, Gool L, Williams C K, et al. The Pascal visual object classes (VOC) challenge[J]. International Journal of Computer Vision, 2010,88(2):303-338.

[17] Zhang Kaihua, Zhang Lei, Yang Ming-Hsuan. Real-time compressive tracking[C]// European Conference on Computer Vision. Springer-Verlag, 2012:864-877.

[18] Lazarevic-Mcmanus N, Renno J R, Makris D, et al. An object-based comparative methodology for motion detection based on the F-measure[J]. Computer Vision & Image Understanding, 2008,111(1):74-85.

[19] Kwon J, Lee K M. Tracking of a non-rigid object via patch-based dynamic appearance modeling and adaptive Basin Hopping Monte Carlo sampling[C]// 2009 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR 2009). 2009:1208-1215.

[20] Hall D, Nascimento J, Ribeiro P, et al. Comparison of target detection algorithms using adaptive background models[C]// IEEE International Workshop on Visual Surveillance andPerformance Evaluation of Tracking and Surveillance. 2005:113-120.

[21] Wu Yi, Lim J, Yang M H. Online object tracking: A benchmark[C]// IEEE Conference on Computer Vision and Pattern Recognition. 2013:2411-2418.

[22] EC’s Information Society Technology. CAVIAR:Context Aware Vision Using Image-based Active Recognition[EB/OL]. http://homepages.inf.ed.ac.uk/rbf/CAVIAR, 2017-12-04.

[23] Young D P, Ferryman J M. PETS metrics: Online performance evaluation service[C]// IEEE International Conference on Computer Communications and Networks. 2005:317-324.

[24] Nghiem A T, Bremond F, Thonnat M, et al. ETISEO, performance evaluation for video surveillance systems[C]// IEEE Conference on Advanced Video and Signal Based Surveillance. 2007:476-481.