基于流量预测的低功耗有损网络节点缓存系统设计

任立胜,陈红红,郭艳光

(内蒙古农业大学 计算机技术与信息管理系,内蒙古 呼和浩特010018)

0 引言

网络缓存是存在于网络用户与网络服务器之间的数据缓冲机制,其基本应用思想是将长期访问的信息文档放置在用户主机附近,以便于后续的访问请求能够从本地服务器或客户主机中直接获得数据信息,从而避免不必要的远距离访问连接。网络缓存处理通过信息本地化分配实现对数据参量的快速浏览。一方面,可在提供本地用户服务的同时,缩小由广域网与服务器连接行为造成的物理延迟效果,加快本地响应的实际速度水平;另一方面,缓存处理能够屏蔽广域网节点的非暂时不可用性,使得网络应用环境逐渐趋于稳定[1-2]。

在互联网处理平台中,由于已接入Internet用户数量的持续增加,网络内部的固有延迟时间会随之延长。为解决此问题,Redis型信息缓存系统通过上层处理接口与下层分布式数据库直接相连的形式,抑制服务器集群的应用扩展性,再借助Redis请求指令,实现对节点缓存组织的统一化调度。但与此系统匹配的固有延迟水平始终难以达到理想化数值标准,易造成单位时间内转存流量数据信息总量的持续下降。为避免上述情况的发生,设计基于流量预测的低功耗有损网络节点缓存系统,在通信协作器、文档替换器等多个硬件设备元件的支持下,建立一致性哈希算法,再联合多级服务器缓存行为,实现对系统应用环境的完善与维护。

1 低功耗有损网络节点缓存系统硬件设计

低功耗有损网络节点缓存系统的硬件执行环境由网络缓存拓扑框架、通信协作器、文档替换器三部分共同组成,具体搭建方法如下。

1.1 网络缓存拓扑框架

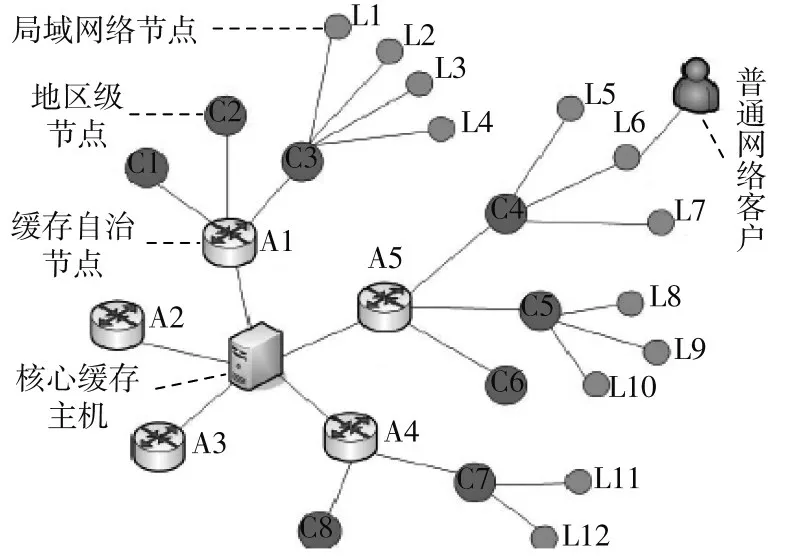

网络缓存拓扑框架是低功耗有损网络节点缓存系统设计的硬件执行基础,由局域网络节点、地区级节点、缓存自治节点以及核心缓存主机等多个应用设备元件共同组成。其中:局域网络节点的实际接入数量相对较多,能够根据待预测流量信息的实际输入水平,更改与节点相关的应用连接行为;地区级节点始终与缓存自治节点相连,可在适应系统主机缓存行为的同时,确定流量信息预测的指令作用范围[3-4];核心缓存主机能够感知普通网络用户的实际信息消耗需求,并在不违背信道传输需求的前提下,实现对待缓存数据参量的统一规划与调度。图1为网络缓存拓扑框架结构图。

图1 网络缓存拓扑框架结构图

1.2 通信协作器

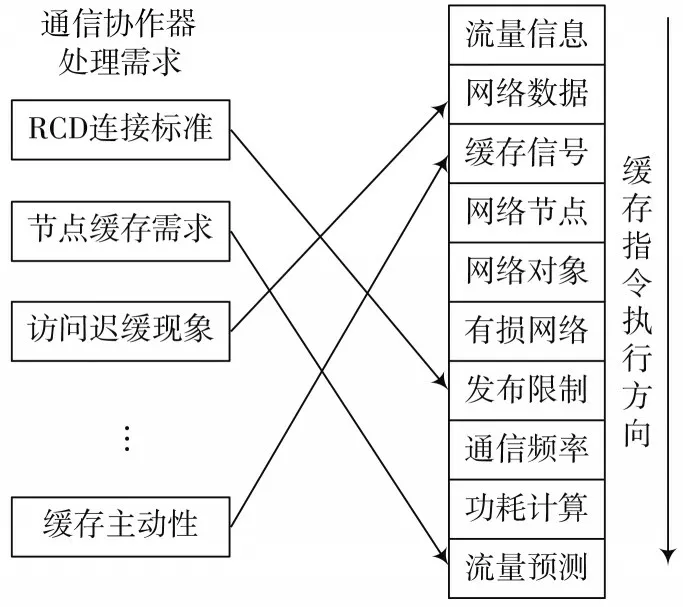

通信协作器采取RCD型连接标准,处理低功耗有损网络中的节点缓存需求,从而解决因客户机访问迟缓现象造成的流量预测准确性下降问题。这种模块连接形式充分利用了低功耗有损网络的节点缓存主动性,由于流量预测行为具有较强的数据处理能力,可直接针对散乱的应用信息参量进行整合与调试,因此,模块主体可在精准访问缓存主机的同时,为下级文档替换器提供大量的可接入节点[5-6]。随着流量预测数据被访问次数的增加,通信协作器中会生成多项连贯的信息缓存表单结构,在低功耗有损网络对象发生改变的情况下,模块的通信频率会出现适度的振荡变化,当完全消除网络节点之间的发布限制作用后,协作器主机的执行能力才会逐渐趋于稳定。图2为通信协作器连接原理示意图。

图2 通信协作器连接原理

1.3 文档替换器

文档替换器的基本应用思想为:从网络客户端获取发送请求的数据对象,判断被请求的对象在待缓存节点中是否留有原对象副本:如果有,主机根据缓存信息的低功耗有损参量值判断其是否具有应用价值,若有价值,表示缓存指令中流量预测信息能够直接反馈给客户端,若没有价值,表示缓存指令中没有流量预测信息能够直接反馈给客户端[7-8];如果待缓存节点中未留有原对象副本,表明主机处理结果缺失,低功耗有损网络需要从服务器中取回原始的网页信息,并根据缓存剩余空间的实际数值水平,确定现有信息替换标准是否能够满足流量预测数据的实际缓存需求。表1为文档替换器连接原理。

表1 文档替换器连接原理

2 低功耗有损网络节点缓存系统软件设计

在硬件执行环境的基础上,按照一致性哈希算法建立多级服务器缓存、缓存置换策略设置的处理流程,实现系统软件执行环境的搭建,将硬件设计与软件设计相结合,完成基于流量预测的低功耗有损网络节点缓存系统设计。

2.1 一致性哈希算法

在低功耗有损网络节点缓存系统中,一致性哈希算法由流量信息输入节点、数据查询节点以及空节点三部分共同组成。在流量预测原理的作用下,网络输入端主机可与流量信息输入节点(Key)直接相连,一般情况下,一个完整的哈希组织中最少包含三个完全独立的输入节点成分,且必须分属于不同的数据传输模块之中。数据查询节点(Node)附属于流量信息输入节点下部,后者可根据待缓存信息的输入形式,将数据参量转存至既定应用模块中,从而实现对网络固有延迟时间的有效控制[9-10]。缓存系统并不会对空节点数量级水平进行严格限制,基本可在1~3个之间保持变动接入状态。图3为一致性哈希处理原理示意图。

图3 一致性哈希处理原理

2.2 多级服务器缓存

多级服务器缓存是处理低功耗有损网络中流量预测信息间调度关系的必要处理流程,分为网络缓存、应用端缓存以及客户端缓存三个环节[11-12]。其中:网络缓存可根据流量预测主机的实际执行能力,确定待缓存数据可至的实际传输范围;应用端缓存具备较强的信息读取能力,可有效解决流量预测指令实施过程中的数据处理瓶颈,从而缓解因信息过度累积而造成的网络拥堵情况[13];客户端缓存的执行能力最强,可直接以系统数据库作为应用操作对象,在调整已存储信息参量的同时,将待缓存的信息结构体整合成数据包应用形式,进而解决因节点过量占据而造成的功耗利用率过大的问题。图4为多级服务器缓存处理流程图。

图4 多级服务器缓存处理流程图

2.3 缓存置换策略

缓存置换策略是基于流量预测低功耗有损网络节点缓存系统设计的末尾处理环节,可在已知多级服务器缓存目标的同时,确定系统数据库的实际存储能力,从而缩短流量预测信息在系统中的传输消耗时长[14-15]。假设λ代表与流量预测信息相关的数据缓存系数,在既定的数据缓存周期内,该项物理指标的数量级水平可直接影响最终的置换策略行为。pˉ代表阶段性时间内低功耗有损网络所承担的缓存数据信息均值,一般情况下,该项物理指标的表现数值越大,最终计算所得的缓存置换策略应用级水平也就越高[16-17]。联立上述物理量,可将系统缓存置换策略表示为:

式中:f代表与流量预测信息相关的数据信号存储权限;β代表网络数据信息的低功耗执行标准;y代表信息传输周期。在流量预测理论的支持下,实现低功耗有损网络节点缓存系统的顺利应用。

3 系统应用能力检测

为验证基于流量预测低功耗有损网络节点缓存系统的实际应用价值,设计如下对比实验。在客户端主机周围设置多台网络计算机设备,利用数据对抗性原理,将其设计成星型连接形式。实验组主机搭载基于流量预测的低功耗有损网络节点缓存系统,对照组主机搭载Redis型信息缓存系统,将实验组控制主机、对照组控制主机同时接入星型应用体系中,在既定实验时间内,分析各项实验指标的具体变化情况。

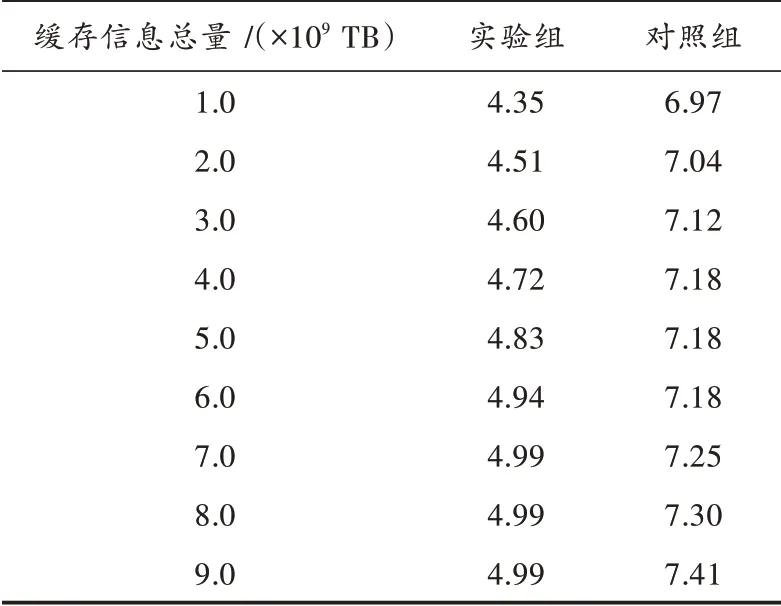

网络固有延迟、流量数据信息总量均能反映缓存处理主机所具有的数据调配能力,一般情况下,延迟时间越短、数据信息总量越大,缓存处理主机的数据调配能力也就越强,反之则越弱。实验结果详情如表2,表3所示。

表3 流量数据信息总量对比 ×1011 TB

分析表2可知,随着缓存信息总量的增大,实验组网络固有延迟时间呈现先上升再稳定的变化趋势,全局最大值达到4.99 ms,且在缓存信息总量处于7.0×109~9.0×109TB之间时,该数值结果始终保持不变。对照组网络固有延迟时间则保持两端上升中间稳定的变化趋势,全局最大值达到7.41 ms,网络固有延迟时间始终高于实验组水平。综上可知,随着基于流量预测节点缓存系统的应用,网络固有延迟时间得到了有效控制,可大幅增强缓存处理主机所具有的数据调配能力。

表2 网络固有延迟对比 ms

分析表3可知,若以15 min作为一个单位时长,随着实验次数的增加,实验组流量数据信息总量始终保持持续性上升的变化趋势,全局最大值达到8.20×1011TB。对照组流量数据信息总量则在小幅下降趋势后,开始逐渐趋于稳定,全局最大值仅能达到5.33×1011TB,远低于实验组极值水平。综上可知,随着基于流量预测节点缓存系统的应用,单位时间内的流量数据信息总量不断提升,可对缓存处理主机所具有的数据调配能力起到适当的促进作用。

4 结语

在流量预测原理的作用下,低功耗有损网络节点缓存系统联合网络缓存拓扑框架、通信协作器与文档替换器,在建立一致性哈希算法的同时,维持多级服务器的缓存应用关系,再借助缓存置换策略,实现对基本网络环境的维护。对比实验结果显示,与Redis型信息缓存系统相比,新型缓存系统的网络固有延迟时间更短,而单位时间内可存储的流量数据信息总量却更大,可有效解决因Internet用户数量递增而造成的网络固有延迟增加的问题,实现对流量数据信息的及时缓存处理。