稀疏统计学习及其最新研究进展综述①

张红英, 董珂臻

西安交通大学 数学与统计学院,西安 710049

稀疏性是高维空间中信号或者数据的普遍内蕴属性,意谓可以仅用少数位于低维子空间的参数(特征变量)近似表示高维空间的复杂物理过程.例如,在压缩感知领域,图像可用小波基线性表示并得到表示系数,保留较大系数,对较小系数赋值为0,可得到图像的近似表示.通过此近似表示对图像进行复原,基本可以恢复原图[1].因此,图像可通过少数系数(特征变量)近似线性表示,称为图像的稀疏表示.稀疏性广泛存在于高维数据特征选择、稀疏信号恢复以及众多其他问题[2-4]之中.这些问题具有共同特点: 在数据生成过程中,特征变量的数量大于采样数量.具有这样特点的问题被称为高维统计分析问题.稀疏统计学习正是处理这类问题的有效方法.

近10年来,深度学习在人脸识别、语音处理和文本分析等领域获得空前成功,在众多任务上均达到接近甚至超越人类的性能表现.然而,大量的网络参数会带来训练代价巨大、容易过拟合等问题,网络的黑箱特性也导致模型可解释性较弱.稀疏统计学习固有的约简特性和强可解释性,提供了解决上述问题的一种可能.将稀疏统计学习与深度学习结合,成为受到广泛关注的热点领域.相关研究大致可以分为基于稀疏建模的深度学习方法和数据驱动的稀疏统计分析方法.前者通过稀疏建模的思想与方法,进行深度神经网络架构和算法的设计.后者则利用深度神经网络的强大表示能力,通过深度神经网络学习特征表示,并应用于稀疏统计学习模型.越来越多的研究集中于该领域,并获得了令人欣喜的成果.

本文从经典的稀疏统计学习方法出发,回顾经典的稀疏回归分析方法,并对深度神经网络与稀疏统计学习相结合的研究进行简要综述.

1 稀疏回归分析

回归分析方法作为统计数据分析强有力的工具之一,一直是统计学的研究热点,同时也被广泛应用于自然科学及社会科学的各个领域.回归分析旨在描述输出变量与特征变量的关系,并进行统计建模和推断.近年来,随着计算与数据采集能力的持续提高,高维数据逐渐成为回归分析的重要对象.为得到正定解,在高维数据回归分析中,一般使用基于稀疏性假设的正则化框架.本节将在正则化框架下,综述稀疏回归分析的各类模型.

1.1 正则化框架

(1)

模型(1)称为统计学习的正则化框架,其中L(·)是损失函数,P(·)是正则项,λ是正则化参数.特定的正则化框架会使模型的解具有正定性、光滑性和稀疏性等性质,从而提高了模型的精度和可解释性.不同的方法常根据不同的先验信息选择不同的损失函数和正则项.

1.2 稀疏回归分析中的变量选择

稀疏性假设是针对高维数据进行统计建模和分析的重要手段.稀疏性假设意指在统计模型中,仅少数特征变量对输出产生重要影响.基于稀疏性假设,稀疏回归分析旨在基于回归分析框架对高维数据进行统计建模、分析和推断.

因仅少数特征变量产生重要影响,变量选择便成为稀疏回归分析中的关键问题.最优子集选择[5]则是最直接的变量选择方法.

对于多元线性回归模型

y=Xβ+ε

(2)

其中X=(x1,x2,…,xp),β=(β1,β2,…,βp)T,ε是随机噪声.最优子集选择在所有包含m(0≤m≤p)个变量的模型中,选择拟合效果最好(残差最小)的一个.

最优子集的选择可以被纳入统计学习的正则化框架,可以被看作是基于L0-正则项的最小二乘模型.假设‖β‖0是向量β的L0-范数,其中L0-范数表示向量β中的非零元素个数,则基于L0-惩罚的最小二乘估计准则为

(3)

当‖β‖0=m时,模型(3)的解等价于最优子集选择的结果.求解模型(3)是NP-难问题[6],已知算法均无法在多项式时间内有效解决.因此,求解过程通常需要进行近似.值得指出的是,一些准则例如AIC准则[7]、BIC准则[8]、HQIC准则[9]等也是L0-正则化模型.

1.3 基于凸正则项的稀疏回归分析

求解模型(3)的NP-难问题,一个重要方法就是利用正则化框架进行松弛处理.

Tikhonov正则化方法通过利用控制函数光滑性的惩罚项解决积分方程不可解或者有无穷多解的问题,是一种标准的求解非适定积分方程的方法.以求解逆问题的观点来看,岭回归模型可以认为是Tikhonov正则化方法的特例[10],其形式为

(4)

模型(4)用L2-正则项代替模型(3)中的L0-正则项,具有解析解,并具有收缩性质,即迫使参数β的所有元素趋向于0,却不恰等于0.因此,模型(4)不具有变量选择性质,且在参数较大时会带来偏差.

文献[11]提出了基于线性回归模型的非负绞刑模型.该模型可看作3个步骤:

(ii) 求解模型

(5)

非负绞刑模型具有变量选择性质,并且可以得到比最优子集选择和逐步选择方法更加稳定的解.

受到非负绞刑模型的启发,文献[12]提出了Lasso模型.该模型使用L1-正则项替代最优子集选择中的L0-正则项.几乎在同一时期,L1-正则项同样被用于信号处理领域的基追踪方法[13].基于L1-正则项的Lasso模型具有形式

(6)

Lasso惩罚具有变量选择性质,且是L0-范数的最紧凸松弛,在特定条件下,两者的解完全等价.大量的研究显示,基于L1-正则项的Lasso模型具有强可解释性、统计有效性[14]和计算高效性等良好性质,因此得到了广泛关注和应用.

Lasso模型在变量选择过程中,通过对全部特征变量的系数施加相同程度的惩罚进行系数收缩,以达到将与响应变量无关的冗余变量压缩为0的目的.然而,这会使得与响应变量相关的目标变量的系数也受到相同程度的压缩,导致回归系数的估计是有偏的.

为得到无偏或者近似无偏的估计,文献[15]提出了自适应Lasso模型.自适应Lasso模型具有形式

(7)

其中,w∈Rp是已知的权重向量.自适应Lasso模型采用重新加权的L1-范数,能够修正Lasso模型的过度估计,并且具有Oracle性质.

Lasso模型的另一个缺陷是无法妥善处理特征变量间具有高相关性的数据.当一组特征变量两两之间相关性很高时,Lasso模型倾向于只选择其中任意一个; 当n

(8)

当特征变量高相关时,弹性网模型会使这些变量的系数趋向于相同,因此,弹性网模型可以选到全部相关的特征变量.

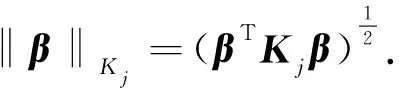

另一种研究特征变量间相关性的方法是利用其组结构,将特征变量分组,研究不同组的特征变量与输出之间的关系.组Lasso模型[17]就用来解决此类问题,其形式为

(9)

当某个组在组Lasso模型拟合中被选中时,该组中的所有系数均不为0,因此无法处理组内个别目标变量的回归系数不为0的情况.为了实现组内稀疏性,稀疏组Lasso模型[18-19]对组Lasso模型进行了改进,其形式为

(10)

其中λ1,λ2≥0.模型(10)可以同时实现组间与组内稀疏性.当λ1=0时,模型(10)退化为组Lasso模型; 当λ2=0时,模型(10)退化为Lasso模型.

Lasso模型无法处理连续变量数据.为克服这个缺陷,融合Lasso模型[20]对Lasso模型进行了扩展,其具体形式为

(11)

其中λ1,λ2≥0,Bβ=[β1-β2,β2-β3,…,βp-1-βp]T.模型(11)通过促使相邻系数趋于相同以保证获得稀疏解以及数据的局部连续性.

除了上述参数回归模型之外,一些基于稀疏正则化框架的非参数模型也得到了广泛研究.非参数回归往往受到“维数灾难”的困扰,因此近似方法对于该类模型至关重要.加法模型正是此类近似方法,该模型为

(12)

通过在加法模型上应用Lasso惩罚,文献[21]提出了稀疏加法模型

(13)

任何非参数方法均可以用于拟合模型(13).Backfitting算法[22]同样适用于计算模型(13).

1.4 基于非凸正则项的稀疏回归分析

L0-正则化模型中L0-范数是向量中非零元素的个数,为非凸非连续函数.因此,L0-正则化模型是基于非凸正则项的稀疏回归模型.

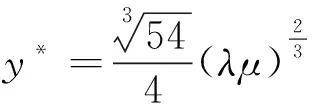

文献[23-25]发现Lasso估计需要在特定条件下才具有较好的变量估计和选择特性,且即使在这些条件下,Lasso估计仍存在偏差.为克服上述缺陷,可采用非凸的0 (14) 文献[26]提出了bridge回归模型 (15) 其中0<γ.模型(15)搭起了最优子集选择与岭回归之间的桥梁.当0<γ<1时,正则项是非凸的,其等价于0 (16) (17) (18) 其中 且 (19) (20) 使得D=DZ+E.模型(20)利用增广拉格朗日乘子方法(ALM)[40]和Half阈值算子进行求解. (21) 并提出了求解的迭代算法,同时证明了其收敛性. (22) EKh和Ekv分别表示水平方向和竖直方向的运算. (23) 使得R=S+T,T=Z+C.其中 ⊙是张量核范数[46],表示张量秩的最紧凸松弛.模型(23)通过基于交替方向最小化(ADM)[47]的增广拉格朗日乘子法(ALM)进行优化求解[40]. 鉴于非凸正则项的显著优势,除0 (24) 其中,pλ(βi)的形式为 (25) 其中λ≥0,a>2.SCAD正则项可以产生具有Oracle性质的估计. 文献[49]提出了极小极大凹正则项(MCP),其形式为 (26) 其中a>1.模型(26)理论上近似无偏,且具有Oracle性质. SCAD和MCP均为Folded Concave惩罚函数,分别是软阈值方法和硬阈值方法的拓展.SCAD是连续的,但MCP不连续. 过去10年,深度神经网络的研究取得了空前的成功,尤其在图像、语音、文本等任务上表现出色.深度神经网络研究的成功极大地拓宽了处理高维数据方法的边界,提高了处理能力.然而,现代深度神经网络在训练和应用中通常被当作“黑箱”,其内部原理依然不清晰,可解释性较差,因而无法严格保证模型性能.另外,现代深度神经网络参数量巨大,训练过程需要大量训练数据.这使得深度神经网络训练过程中的计算消耗巨大,常需要庞大的计算资源支持,效率较低. 作为处理高维数据的经典方法,稀疏统计分析方法依据统计理论和不同先验信息建模,通常有较强的可解释性.同时,稀疏统计分析方法并不依靠大量训练数据,求解过程也仅需要少量迭代便能达到较好性能,因而计算消耗较小,效率较高.如何将稀疏统计分析方法与深度神经网络结合起来,使模型兼具两种方法优点,逐渐成为广受关注的热点问题. 已有研究大致可以分为两个方向: 基于稀疏建模的深度学习方法和基于数据驱动的稀疏统计分析方法.本节将针对这两方面的相关方法进行综述. 基于稀疏建模的深度学习方法通过稀疏统计分析方法进行数据建模,并据此进行深度神经网络架构和算法的设计.此类方法通常包含深度神经网络展开、神经网络剪枝、神经网络架构搜索等主题.本文以深度神经网络展开为例进行介绍. 深度神经网络展开是基于稀疏建模的深度学习方法的典型代表.深度神经网络的架构通常需要交替地进行线性和非线性的变换,其中非线性变换借由ReLU等激活函数完成.此类结构与稀疏统计学习模型中的阈值迭代算法十分类似,其中阈值算子可以看作激活函数.鉴于这种联系,将稀疏编码算法展开成为神经网络的深度神经网络展开方法逐渐受到关注. 早期的深度网络展开方法可以追溯到文献[50]的工作,为了提高稀疏编码算法的计算效率,提出了一种端到端的学习方法(LISTA).该算法将求解稀疏编码问题的ISTA迭代算法[51]的每一步迭代看作循环神经网络的一层,由此得到一个多层循环神经网络,通过学习参数,自动地学得字典和稀疏编码. 稀疏编码问题的目标是求解模型(27)的稀疏编码: (27) 其中λ>0,W∈Rn×m是过完备字典.ISTA迭代算法是求解稀疏编码模型(27)的常用方法之一.其迭代过程为 (28) 其中Sλ是逐元素的软阈值算子,其在每个元素上定义为 Sλ(x)=sign(x)·max{‖x‖-λ,0} (29) xl+1=Sλ{Wtxl+Wey}l=0,1,… (30) 仔细观察公式(30)可以发现,ISTA迭代算法的每一步迭代中,输入xl经过线性变换和软阈值算子,得到新的xl+1.这可以看作深度神经网络中的一层,其中软阈值算子对应于神经网络中的激活函数.执行L步迭代相当于连接了L层的深度神经网络.基于此,LISTA将ISTA展开为深度神经网络,其训练损失函数为 (31) LISTA通过将稀疏编码算法展开为深度神经网络,以一种可学习的方式获得了稀疏编码问题的解.该模型基于稀疏编码算法,有着强可解释性.同时,该模型在计算效率上有着显著的优势.实验表明,在达到同一精度的条件下,该模型比某些经典ISTA方法快将近20倍. 此外,其他针对稀疏编码问题的算法同样可以被展开为深度神经网络.例如,文献[52-54]将ADMM算法展开为神经网络,文献[55-57]将近端梯度下降算法展开为深度神经网络,均获得了不错的表现. 除了深度神经网络展开外,稀疏统计学习方法在深度学习的其他方面也有着广泛的应用.例如,神经网络正则化方法Dropout[58]因其可诱导核范数[59-61]而可被看作探索网络稀疏结构的方式之一; 深度神经网络的初始化权重方法[62]、特征标准化方法[63]等训练方法看作稀疏信号恢复或低秩矩阵恢复算法中的等距约束性质[64],从而保证模型的性能表现. 实际应用中,稀疏统计分析方法常依赖于手工得到的低阶特征,表示能力有限.特征表示的好坏往往对模型性能有着重要影响.基于数据驱动的稀疏统计分析方法通常建立在传统稀疏统计分析模型基础之上,利用深度神经网络强大的特征表示能力,学习数据的高阶特征,并应用于稀疏统计分析方法之中,以提升模型性能. 深度哈希学习便是数据驱动的稀疏回归分析模型的应用之一.文献[65]提出了深度语义排序模型(DSRH),将深度卷积神经网络整合到哈希函数中,共同学习特征表示及哈希函数,并保持特征表示与哈希编码之间的相似性,摆脱了手工特征语义表示能力的限制.同时,该方法利用编码多层次相似度信息的排序表来指导深度哈希函数的学习.文献[66]提出了深度监督哈希模型(DSH),该模型基于卷积神经网络框架设计,将成对的图像(相似或者不相似)作为训练输入以学习近似离散的二元哈希编码表示. 相比于含有两阶段过程的深度哈希学习方法,端到端的深度哈希学习方法以其能大幅提高所学哈希编码的表示能力而受到广泛关注.文献[67]将卷积神经网络引入哈希学习方法,提出了一种深度监督哈希学习方法(DPSH).模型首先通过网络学习图像的特征表示,然后将此特征表示通过哈希函数映射为哈希编码.模型以端到端的方式,通过衡量成对标签相似性的损失函数同时学习特征表示和哈希编码.为了进一步探索标签信息,文献[68]在DPSH基础上增加了一个判别项用以更新二值编码.文献[69]利用锚点图设计出深度监督哈希学习方法(DAGH),可以更加高效地获得哈希编码.模型通过构建样本锚点子集,并建立锚点与哈希编码之间联系的方式达到提高计算效率的目的. 深度典型相关分析也是数据驱动的稀疏多元分析方法的代表之一.文献[70]提出了早期的深度典型相关分析方法(Deep CCA).该方法先用深度神经网络分别求出两个视图的投影向量,然后通过最大化两个投影向量的相关性进行求解.Deep CCA在训练过程中需要将全部训练数据作为一个批次,因此不能应对大规模的数据.为解决该问题,文献[71]提出了随机Deep CCA(SDCCA).该模型将神经网络参数训练嵌入交替最小二乘方法,以适应小批次随机优化.文献[72]针对多模态数据,提出了基于深度典型相关分析的处理方法DCCA.该模型利用深度全连接网络学习文本数据的特征,并利用卷积神经网络(CNN)学习图像数据的特征.随后两个模态的数据被当作两个视图的数据矩阵输入典型相关分析框架.深度自编码器同样被用于典型相关分析.文献[73]基于CCA框架提出了深度典型相关自编码器(DCCAE),将典型相关分析与深度自编码器进行结合,达到了更好的性能.文献[74]提出了相关神经网络(CorrNet)以进一步描述重构误差.该模型可以利用已存在的一个视图准确恢复另一个视图. 大数据时代,作为传统统计学习经典方法的稀疏统计学习,在高维数据处理领域发挥着举足轻重的作用,基于稀疏假设的正则化框架带来了大量高效的高维数据处理方法.同时,随着深度学习的革命性进展,结合稀疏统计学习与深度神经网络以兼取两种方法优点的研究也日趋受到重视.本文综述了稀疏统计学习中的经典模型,简要介绍了传统稀疏统计学习与现代深度学习相结合的研究进展.然而,目前针对此类结合的研究还有巨大的探索空间,接下来,对未来研究方向提出一些展望: 1) 由于传统优化理论与算法的局限性,目前稀疏统计学习的研究多集中于求解凸目标函数.但实际应用中频繁遇到损失函数和正则项非凸的情形.同时,非凸正则项通常具有更好的统计性质.因此,对于含有非凸损失和非凸正则项的模型,包括算法的设计与收敛性的证明,都是值得进一步研究的方向. 2) 由于传统的稀疏统计学习方法通常基于最小二乘损失,其数据服从高斯分布.然而,现实应用中数据常常并不服从高斯分布.同时,高斯分布对异常点敏感的特性也限制了它的应用.因此,探索基于更加鲁棒的损失函数的稀疏统计学习方法,例如基于分位数回归的稀疏统计学习方法等也值得进一步的研究. 3) 深度网络展开方法的研究目前也集中于具有凸性的稀疏编码方法.对带有非凸正则项的稀疏编码算法进行展开,包括算法效率和性能的研究,还需要更进一步的探索.另外,深度网络展开方法的理论研究还很初步,其性能表现也有进一步提升的空间,这些均为需要进一步研究的问题. 4) 传统稀疏统计学习的建模往往嵌入了数据本身的先验信息,大量的经典方法在理论和性能上都有着不错的表现.同时,针对不同数据、不同问题的新型深度神经网络也不断涌现出来.探索更适合特定问题的深度神经网络特征表示与传统稀疏统计算法的结合,最大限度地发挥两种方法的优点,也是值得进一步研究的方向.

2 深度稀疏统计分析

2.1 基于稀疏建模的深度学习方法

2.2 基于数据驱动的稀疏统计分析方法

3 总结