教育领域人工智能基准测试:跨学科中文大型语言模型的综合评估

王 野

(南宁师范大学 计算机与信息工程学院,广西 南宁 530299)

随着ChatGPT 模型的发布[1],大型语言模型在文本生成、问答、摘要等领域为整个世界的技术和应用带来了巨大的推动。当前,国内的中文大型语言模型也迅速跟进,阿里巴巴、清华大学等科技公司与研究院校纷纷推出了各自有代表性的中文大型语言模型,为教育教学的数字化转型提供了有力的帮助。同时,以ChatGPT 为主导的大型语言模型在教育教学的自动评价技术中开始广泛应用[2]。例如,Moore 等[3]利用ChatGPT 3 在化学教育教学中对学生的学习成绩进行了智能评估,并根据评估结果提出不同的专业与指导建议;Shen 等[4]在数学的教育教学中,利用大型语言模型来生成数学题目;Bernius 等[5]在整个课程中都利用大型语言模型来评价与评估学生的学习成绩,准确率达到了92%,被教师普遍接受;Zhu 等[6]建立了地理学科在线课程的形成性反馈系统,反馈系统采用自动评分技术来评估学生的表现;Reham等[7]通过人工智能对学生的学习结果进行自动评价,取得了较好的效果。而大型语言模型在自动化的教学评价中不只针对学生个体,也可以大规模地进行问题的自动生成与回答,如Qu 等[8]利用大型语言模型来生成高质量的学科题目,同时生成答案讲解,这在问题与答案的生成任务上取得了很大的突破;在英语学科上,Dijkstra 等[9]利用大型语言模型自动生成总结性反馈和评分测试;Jia 等[10]尝试通过使用各种机器学习和深度学习模型检测不同的特征来评估同行评审,最终利用先进的预训练语言模型更好地完成了同行评审的评估。

综上可看出,从国际上来说,大型语言模型在教育教学领域的应用十分广泛。中文大型语言模型已经步入了新的发展阶段,但其在教育教学应用中的真实效果仍需进一步验证,其潜在的局限性和进一步的优化方向也值得深入探索。本文基于特定数据集对中文大型语言模型的自动评估能力进行实验与测试,来验证中文大型语言模型的推理能力,并进一步说明中文大型语言模型对教育教学自动评估的应用与影响。

一、开源中文大型语言模型

为了更好地验证中文大型语言模型在教育教学领域的表现,本文以模型的训练数据、参数规模与设计架构为依据,从业界和学术界具有重要影响力的中文大型语言模型中筛选出11 个具有代表性的中文大型语言模型。具体如下:

(一)BELLE

BELLE[11]由链家科技公司于2023 年3 月底发布,旨在推进中文对话大模型开源社区的建设,并致力于让每一位用户都能够获得属于自己的、效果优良的指令驱动语言模型。其核心目的是降低大型语言模型,尤其是中文大型语言模型的研究和应用难度。BELLE 不仅专注于大语言模型的预训练,而且还关注基于开源预训练的大语言模型,使每位用户能获得具备高效指令表达能力的定制模型。BELLE 项目持续提供指令训练数据、相关模型、训练代码及应用场景,同时还持续评估不同的训练数据和算法对模型表现的影响。

(二)MOSS

MOSS[12]是由复旦大学开发的一个高级聊天模型,于2023 年4 月正式上线。该模型支持中英双语和多种额外功能,有160 亿参数,并且可以在不同类型的高级显卡上运行。它在大量的中英文数据和代码上进行了预训练,因此非常擅长理解语言和代码。该模型还经过了特殊训练,以支持复杂的多轮对话和多种应用。

(三)通义千问

(四)Jiangziya

Fengshenbang-LM[15](封神榜大模型系列)在2023 年5 月中旬由IDEA 研究院认知计算与自然语言研究中心主导发布,旨在成为中文大型语言模型和认知智能的基础设施,以解决当前中文研究资源严重缺乏和研究进展滞后的问题。此体系是一个以中文驱动的基础生态系统,包括预训练大模型、特定任务的微调应用、基准和数据集;目标是构建一个全面、标准化、以用户为中心的生态系统;还包括多模态、特定领域等任务。IDEA研究院提供了微调好的相关模型,使得计算资源有限的用户也能轻松地使用。

(五)ChatGLM 2

清华大学在2023 年6 月发布了第二代中文大语言模型ChatGLM 2[16]。ChatGLM 2 在初代模型的基础上全面升级,在多个数据集上的性能大幅提升;此外,该模型还利用Flash Attention[17]技术,将其上下文长度从2K 扩展至32K,为了支持更长的上下文,推出了ChatGLM2-6B-32K 模型,并使其大大加快了推理速度。

(六)InternLM

上海人工智能实验室与商汤科技公司在2023年6 月联合推出了InternLM[18],别称“书生·浦语大模型”,展现了一套包含70 亿参数的基础模型及对话模型,使用了上万亿高质量的语料来构建。该模型支持8K 的语境窗口长度,这不仅允许更长的语句输入,而且提供了较强的推理体验。InternLM 设计了通用工具的调用功能,从而为用户提供了一个灵活、自助的流程搭建平台。为了支持模型的预训练,InternLM 提供了一个轻量化的训练框架。

(七)YuLan

YuLan-Chat[19]是由中国人民大学高瓴人工智能学院的师生联合开发的。这一系列模型在2023年6 月发布,它专为聊天设计,名字“玉兰”(YuLan)灵感来源于中国人民大学的校花。该系列模型在LLaMA[20]的基础上进一步进行了中英双语的预训练与指令微调。该模型具有优化语言的能力,用中文词语扩展了英文数据集的原始词表,增加了问答上下文的长度。同时,该模型还构建了高质量的双语指令,从而可以更加高效地响应用户问题。

(八)BayLing

百聆(BayLing)[21]是由中国科学院计算技术研究所的自然语言处理研究组研发的大规模语言模型,于2023 年6 月发布。该模型的特点是增强了中英生成、指令响应和多轮交互能力,可以在16GB 显存的消费级显卡上运行,协助用户进行翻译、写作、创作和提供建议。BayLing 利用了LLaMA 作为其基础模型,通过自动构建的交互式翻译指令进行调优。

(九)Aquila

悟道·天鹰[22](Aquila)语言模型由智源研究院在2023 年6 月发布,为首个结合中英双语知识、遵循国内数据合规并支持开源商用许可的语言大模型。该模型基于中英文高质量语料进行从零训练,中文数据占比约为40%,确保在预训练阶段获得原生中文知识,而非依赖翻译。Aquila 模型的中文数据来源于智源研究院多年积累的数据集,主要包含1 万多个中文互联网站源(其中99%为国内源)以及国内权威机构提供的高质量中文文献和书籍。与此同时,此模型的训练数据还在不断地增长。

(十)Baichuan

百川智能于2023年7月发布了一个名为Baichuan-13B[23]的开源中文语言模型。这个模型的数据量是目前最大的,训练了1.4 万亿个词片段,比LLaMA-13B[20]多了40%。它还支持中英双语,并使用了先进的位置编码技术,对于开发者来说,这是一个非常强大的工具。而Baichuan-13B-Chat版本则是专门为与用户对话而设计的,易于用户在客户端部署。

3)力学模型和有限元分析结果表明支架的薄弱环节为伸缩梁、顶梁和护帮板,特别是伸缩梁比较脆弱,在超前支架的结构工程设计时应予以重视。

(十一)XVERSE

元象科技公司在2023 年8 月初推出了名为XVERSE-13B[24]的大型语言模型,它支持40 多种语言,如中文、英文、俄文和西班牙文等。这个模型采用了标准的Transformer 网络结构,基于1.4万亿的特征数据进行训练,能够同时处理多种语言。

二、实验设计

本实验以GAOKAO-Bench[25]数据集为基准,对以上11 个大型中文语言模型的推理能力进行评估与测试。

(一)实验工具

显卡型号:Geforce RTX 3080 Ti * 1。

编程语言:Python 3.8,PyTorch 1.9。

(二)数据集

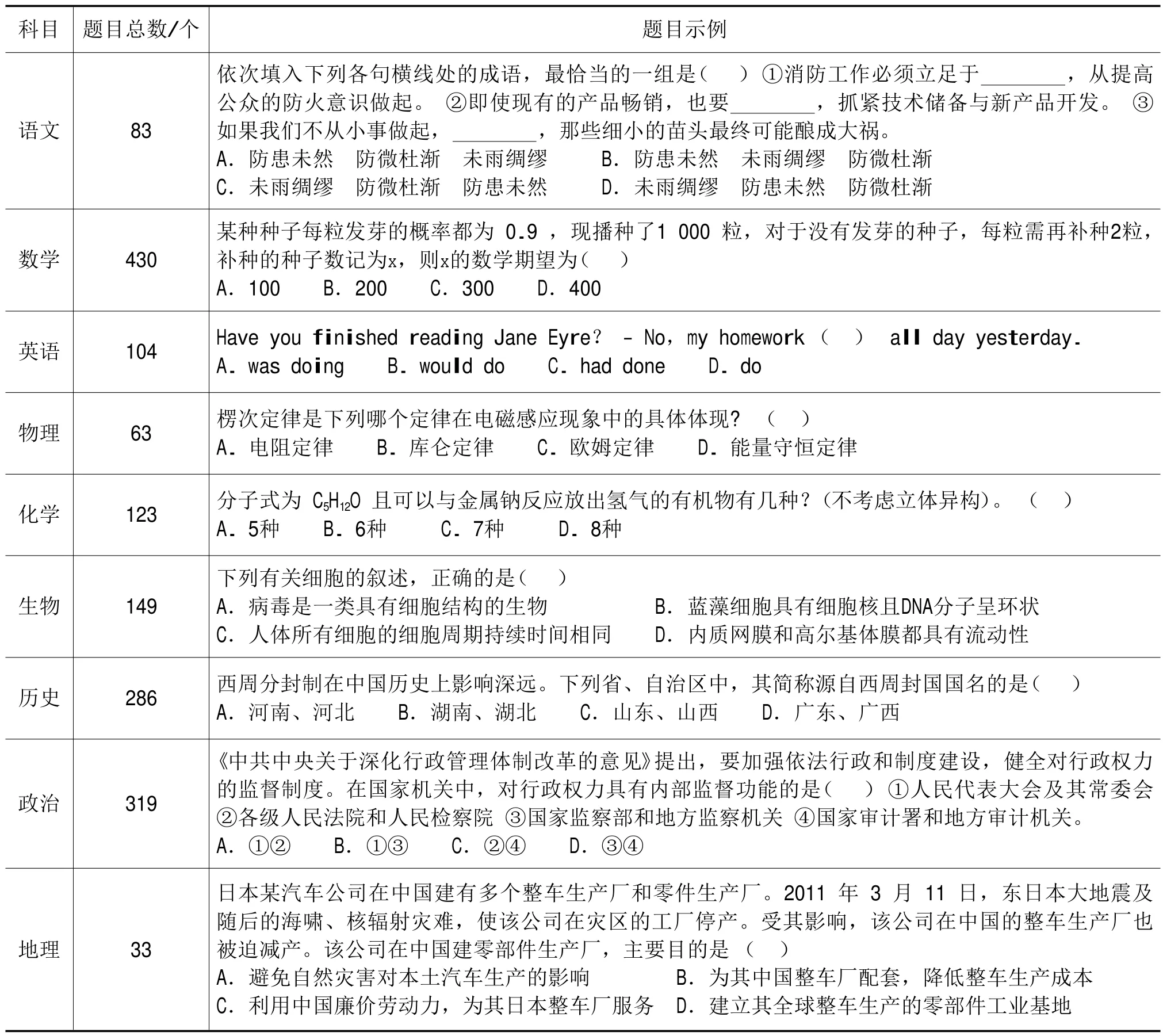

GAOKAO-Bench 数据集收集了2012—2022 年全国高考卷的题目,涵盖了广泛的学科领域。GAOKAOBench 包含2 811 个题目,其中选择题1 781 题、填空题218 题、解答题812 题,多样的题目分布可以较为客观地评估模型在不同题型上的表现,如表1 所示。

表1 数据集分布情况

(三)评估指标

其中:TAVe表示所有学科的平均得分。Rcorrect,i取每一个学科的正确率,SFull表示该学科满分,n 表示学科总数。

Rcorrect,i表示第i 个学科的正确率,Scorrect表示该学科的正确得分,Tpossible,i表示第i 个学科的总可能得分。

三、结果与分析

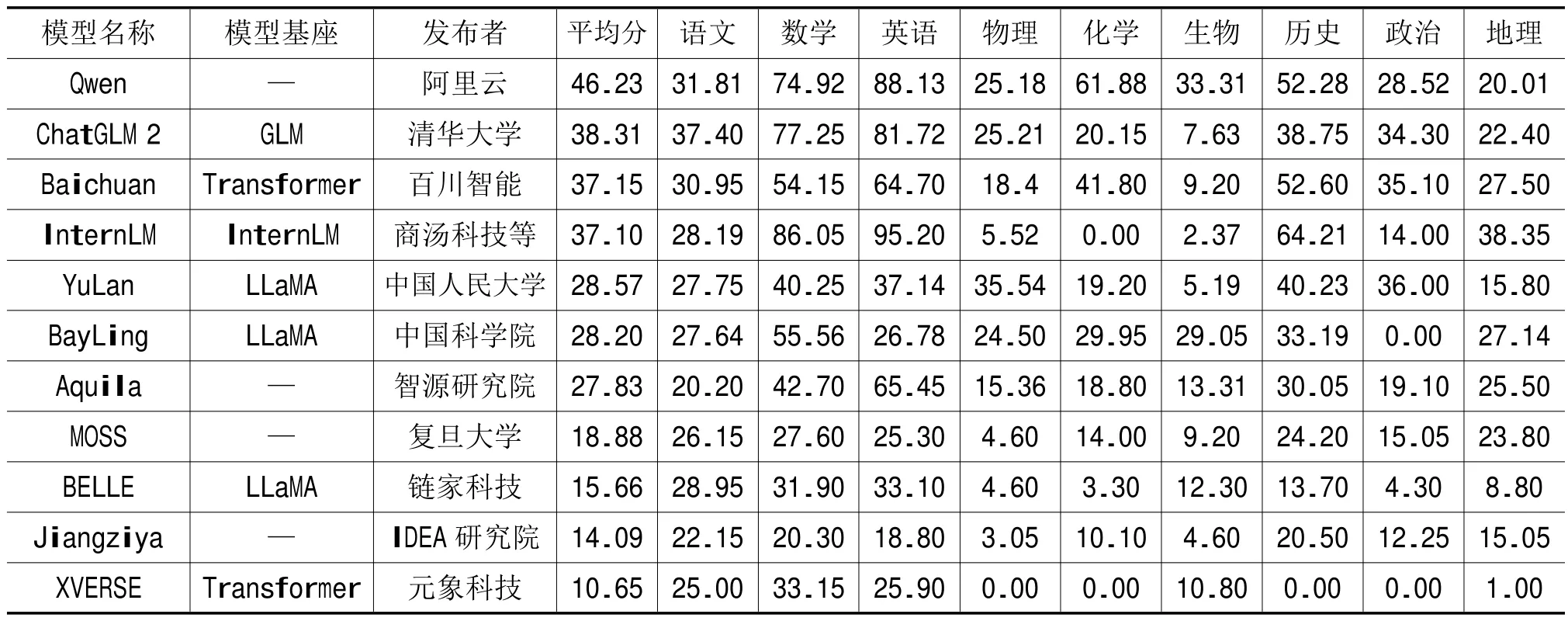

根据以上实验设计,本文基于GAOKAO-Bench数据集,在9 个不同学科的基础上,对当前国内流行的11 个开源中文大模型进行了准确率评估实验,得到评估结果,见表2。

表2 11 个开源中文大模型评估结果

(一)整体表现

阿里云发布的Qwen 模型得分最高,平均分为46.23,其次是清华大学发布的ChatGLM 2 模型,其平均分为38.31。商汤科技等联合发布的InternLM 模型在英语和数学上则较高。Baichuan 模型的平均分为37.15,表现与InternLM 相当,尤其在历史和政治方面表现较好。中国人民大学发布的YuLan 模型与BayLing 模型分别在政治和地理学科上表现较为优秀。

(二)学科表现

在英语学科中,商汤科技等联合发布的InternLM 模型展现了类似母语者的能力,获得了高达95.20 的得分。相比之下,Moss 和Jiangziya的表现较为不足,分别获得了25.30 和18.80 的分数。这可能暗示着这两个模型在英语学科的训练数据相对较少,或者其模型结构不太适应英语学科。在数学学科中,ChatGLM 2 模型和InternLM模型展现了出色的表现,得分分别为77.25 和86.05;可能因为两者接受了大量数学题目的训练,或者模型结构可以很好地理解数学逻辑。对于科学学科如物理、化学和生物,大部分模型的表现都比较弱。在人文学科,如历史、政治和地理中,InternLM 模型在历史上取得了64.21 的高分,远高于其他模型。这可能表明它在历史学科的训练数据相对丰富。而大多数模型在政治上的表现都相对较弱,如BayLing 和XVERSE 的得分都为0。

总结来说,这些模型在不同的学科上存在显著的性能差异,这可能是由于它们的训练数据、模型结构或算法优化策略不同。语言模型为了在各自擅长的学科上有着更好的表现,研究者们在未来的模型开发中可能需要考虑更多针对特定学科的优化策略和训练方法。

(三)模型基座

像Qwen 和Aquila 这样的模型并没有采用明显的预训练模型或基座,这可能是因为它们采用了自定义或混合的预训练模型。从结果来看,Qwen 的表现最佳,这显示,完全自定义的模型也可能取得出色的成绩。唯一使用了GLM 预训练基座的模型是ChatGLM 2,在所有的模型中它取得了较高的平均分,也表明了采用GLM 预训练模型可能带来较好的效果。InternLM 是唯一一个使用InterLM 预训练模型的模型,虽然它在综合平均分上排名第4,但它在英语和数学这两门学科上的表现超过了其他所有模型。Baichuan 和XVERSE 都使用了Transformer 预训练模型,但表现相对较弱。在此,本研究不能仅根据这一点来评估Transformer 预训练模型的性能,因为模型的表现受许多因素的影响,包括数据质量、模型调优和特定任务的适应性等。有3 个模型YuLan、BayLing 和BELLE 采用了LLaMA 预训练模型,它们的平均分在中等到低分之间,但在个别学科上表现相对较好,表明使用LLaMA 预训练模型可能在特定学科上取得较好的表现。

(四)发布者

阿里云发布的Qwen 模型在所有模型中得分最高,突显了大型科技公司在人工智能和自然语言处理方面的优势。清华大学发布的ChatGLM 2 模型以及由上海人工智能实验室与商汤科技联合发布的InternLM 模型也有出色的表现,彰显了学术研究和工业界合作对于推动这个领域发展的重要性。InternLM 在英语和数学上表现卓越,这可能反映了商汤科技等单位在技术和应用研究方向的主攻点。作为新兴的模型如XVERSE,虽然总体得分并不高,但其开源模型也在一定程度上推动了中文大型语言模型的发展。因此,大企业、研究机构和新兴公司都在人工智能与教育交叉领域发挥着重要的作用。

四、总结与展望

(一)总结

1.中文大型语言模型的自主创新能力问题

大型语言模型在不同语言的基础上工作时展现了不同的推理能力。相较于英文数据,中文数据的开源程度较低,导致中文数据集的规模相对较小。此外,英文作为科研主流语言,在学术界和工业界都得到广泛应用,积累了大量高质量的语料数据,这为英文自然语言处理的研究提供了极大的优势。尽管中文大型语言模型在教育领域有一定的应用价值和潜力,但大多数中文大型语言模型的核心算法和架构往往直接借鉴或修改来自国外研究者和机构发布的模型,如GPT[26]、BERT[27]和T5[28]。在本研究中,如表2 所示,LLaMA 模型基座在不少中文大型语言模型中被投入应用。这意味着,在算法和应用层面,中文大型语言模型依然在英文大型语言模型的基础上工作,并有一定的依赖性,这可能对未来中文大型语言模型在教育领域的应用产生一定的制约。所以,对于我国来说,建立自己的中文大型语言模型极为重要。

2.中文大型语言模型在某些学科上的推理能力问题

通过对11 个不同来源的中文大型语言模型进行跨九大学科的综合评估,研究发现:每个模型均有薄弱的学科。例如,大多数模型在自然科学上的推理能力都相对较弱。原因可能是供中文大型模型训练的数据集较为稀少,截至本文编写结束(2023 年8 月30 日),教育领域中已经开源的中文大型语言模型数据集相对较少,而专门针对单一学科进行训练的数据集更为稀有。笔者认为,为了提高中文大型语言模型在某些薄弱学科上的推理能力,可以专门使用单一学科的数据集进行微调与迁移学习,如在数学学科,就有专门的训练数据集GSM8K 和Math[29-30];而在物理学科,有供模型训练的数据集PIQA[31]。综上,针对中文大型语言模型在不同学科上的表现差异,未来的研究需要有针对性地对不同学科的教学内容和目标进行分类、策略调整及优化。

3.中文大型语言模型的透明度与伦理问题

在实验过程中,研究发现部分公司的中文大型语言模型尚未开源,如百度公司的中文大型语言模型文心一言。这些公司有更多的资源来开发和优化模型,但由于商业利益,可能不愿意公开模型的完整细节。这并不利于中文大型语言模型的整体发展与进步,更严重的后果可能会导致伦理问题。一方面,在国内中文大型语言模型的研究中,需要强化模型的透明度和可解释性,比如采用开源或第三方审计的方式,从而增加模型决策逻辑的可审查性;另一方面,在此背景下也应当建立全面的伦理指导原则和治理框架,这样不仅能提高模型在教育评估和个性化教学中的准确性和可靠性,还有助于构建一个更加公平、透明和责任明确的大型语言模型应用生态环境。

(二)展望

文章通过综合评估11 个不同来源的中文大型语言模型,揭示了模型在不同学科上的推理能力及存在的不足。由于数据和算法的局限,以及资源和透明度缺乏等问题,中文语言模型在教育应用方面还面临多重挑战。然而,机会总是与挑战并存的。面对这一情况,相关领域的研究者要采取多元化的策略来应对,如提高中文大型语言模型的推理精度、数据多样性和公开透明度等。这些模型有望在未来的教育自动评估、个性化教学和课程设计等领域发挥更加重要的作用。期待这些新技术不仅能推动教育的数字化转型,同时也能在更加广泛的社会文化层面产生深远的影响。