子图增强的实时同名消歧

韩天翼,程欣宇,张帆进,陈 波

(1.贵州大学 公共大数据国家重点实验室,贵州 贵阳 550025;2.贵州大学 文本计算与认知智能教育部工程研究中心,贵州 贵阳 550025;3.清华大学 计算机科学与技术系,北京 100084)

0 引言

同名消歧旨在确定文献中具有歧义的作者姓名的具体指代对象。随着科技与信息产业的高速发展,各个领域的研究论文与专利发表数量急剧增加,导致了大量作者同名问题以及指代不明的情况。因此,针对同名作者的消歧成为确保谷歌学术(1)https://scholar.google.com/、中国知网(2)https://www.cnki.net/、AMiner(3)https://www.aminer.cn/等在线学术平台正常运行的关键环节,消歧的准确性对专家发现、学术评估等相关下游任务具有重要意义。同名消歧属于命名实体消歧的范畴[1],其消歧对象为具有歧义的作者姓名。尽管同名消歧问题已经研究了数十年[2-5],但目前还远没有彻底解决。这导致部分学者需要时常地向谷歌学术反馈消歧有误的论文(4)https://harzing.com/blog/2017/02/web-of-science-to-be-robbed-of-10-years-of-citations-in-one-week,否则论文的统计指标(如被引用数等)会受到噪声影响。

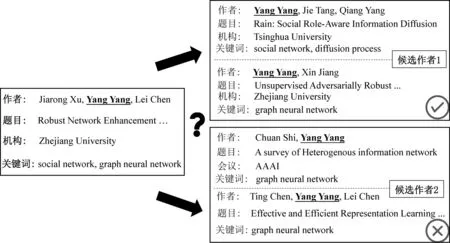

以往的同名消歧相关研究主要聚焦在冷启动问题,即如何将一批具有相同作者姓名的论文划分为多个归属于不同作者的论文簇[3-4,6]。该问题通常用于从零构建同名学者档案。当前学术平台经过长期运营已经建立起大量学者档案。截止2023年3月,在线学术平台AMiner从多个数据源累计整合了超过1亿名专家学者的档案和3.3亿篇文献,而且平均每个月约有75万篇新论文入库。学术平台不仅需要收录新增的论文,还需要将论文与现有平台作者进行匹配关联。然而,相同的姓名并不能代表唯一的作者,一篇新增文献中的作者姓名可能对应到平台中多位同名作者。如图1所示,对于新论文中作者名“Yang Yang”,平台已存在多位同名的作者档案,实时同名消歧需要将新论文准确地分配给众多同名候选作者中的正确作者。图中候选作者1的中文姓名为“杨洋”,候选作者2的中文姓名为“杨阳”,两位候选作者的已发表论文均含关键词“graph neural network”,其中候选作者1的论文机构使用过“Zhejiang University”并与新论文的标题具有共现词汇“Robust”,候选作者2的论文曾出现新论文的共同作者名“Lei Chen”,可以看到两位候选作者与新论文均有较多的匹配信息,即使通过人工也很难有把握消歧准确。故如何充分利用论文与候选作者的信息以获取更有判别力的消歧特征是一个难点。

图1 实时同名消歧

随着科研人数不断增长,同名消歧问题变得越来越具有挑战性。首先,像图1中具有相同姓名且研究相同领域的作者逐渐增多,这将导致实时消歧任务变得愈发复杂。例如,AMiner中有超过6 000个名叫“Yang Yang”的学者,在清华大学就读或就职过的名叫“杨洋”的学者已经超过40个。这使得不同候选作者之间易混淆的相似属性增多。其次,仅使用语义作为特征的实时消歧方法很容易将论文误分。例如,待消歧论文可能与多名候选作者在文章内容上语义相似度较高。在以往的实时同名消歧方法中普遍缺乏待消歧论文与候选作者间结构信息的挖掘与利用。然而,论文和作者的结构信息中可能蕴含着更丰富的匹配信息。例如,同一作者的不同论文的引文网络结构可能类似。因此,本文尝试通过引入子图结构信息来进一步提升实时同名消歧任务的准确度。

传统的同名消歧方法根据待消歧人名的属性信息和文章内容设定具体规则来区分不同作者实体;冷启动同名消歧方法主要利用文章本身内容与文章之间的共同作者、共同机构等结构信息将任务处理为聚类问题;而对于实时同名消歧,相关研究分为基于语义信息与基于结构信息两类方法。在基于语义信息的方法中,一类方法通过特征工程提取出待消歧论文与候选作者档案在标题、关键词、机构等多方面的共同信息来进行消歧,另一类方法基于度量学习等有监督方法来学习论文与作者的嵌入向量以用于消歧;在基于结构信息的方法中,通常将所有候选作者及相关邻居节点(如论文等)构建一张大图,对于每篇新增的论文节点,均需要重构大图并重新训练嵌入向量。已有的实时同名消歧方法获取结构信息的效率较低,所需要的计算开销随着大图规模的扩大而逐步增长。

因此,本文旨在解决实时同名消歧任务中的两个问题,一是如何设计一种高效的归纳式学习(Inductive Learning)的模型,能够在每新增一篇待消歧论文时,直接获得该文与各位同名候选学者之间的结构特征,同时考虑到学者在不同阶段所研究的领域以及所处的机构可能存在的差异,要求模型能实现待消歧论文与候选学者之间的细粒度匹配;二是如何将语义与结构两方面信息进行有效的融合,以实现对更复杂场景的实时消歧,并获得更优秀的消歧效果。本文提出了子图结构增强的实时同名消歧模型RND-all(Real-time Name Disambiguation Integrating All The Information),首先分别对待消歧论文和候选作者构建自我中心网络(Ego Network),利用图注意力网络对中心节点与邻居节点特征进行加权聚合来捕获局部图的结构信息,然后对论文子图与作者子图进行细粒度交互,并采用径向基核函数(Radio Basis Function Kernel,RBF)计算待分配论文与候选作者的图相关性特征,最后,通过集成学习的方法将结构信息与语义信息进行融合。本文所提模型在WhoIsWho实时同名消歧数据集中取得最好结果,相比最优的基线方法CONNA[7]在HR@1、HR@3和MRR上分别提高3.99%、1.24%和2.5%。RND-all在同名消歧基准WhoIsWho实时消歧任务测试集上效果目前排名第一(5)截至2023年3月25日,RND-all在WhoIsWho实时同名消歧子任务排行榜上排名第一已持续1个月。详见http://whoiswho.biendata.xyz/#/。

本文组织结构安排如下: 第1节介绍同名消歧以及图神经网络的相关工作;第2节提出实时同名消歧的相关定义;第3节和第4节介绍端到端提取结构信息的框架和使用子图增强的实时同名消歧模型;第5节为实验结果分析;第6节总结全文。

1 相关工作

1.1 同名消歧研究

同名消歧问题主要分为两个子问题进行研究,即冷启动同名消歧与实时同名消歧。

冷启动同名消歧对应于学术平台创建初期,此时需要将收集的大量论文进行划分,使得划分后同一组内的论文属于同一个现实作者,不同组的论文属于不同的现实作者,故冷启动消歧常定义为聚类问题。Huang等人[3]采用Blocking方法将具有同名作者的待消歧论文聚合为簇,之后使用支持向量机学习簇内各论文间的距离关系,最终利用DBSCAN对簇内论文进行聚类。Louppe等人[4]基于论文之间的相似度采用半监督的层次聚类进行消歧。Tang等人[8]通过待消歧论文间引用关系、共同作者名、共同会议名等信息构建五维消歧特征后利用隐马尔可夫随机域实现对不同作者的区分。Zhang等人[9]构建作者-作者、论文-作者、论文-论文三种图,利用学习的图嵌入向量进行聚类。陈晨等人[10]使用谱聚类对社会网络中的人名聚类,并引入模块度阈值作为网络停止划分的条件。Subramanian等人[11]将8个主流同名消歧数据集整理为S2AND数据集,并发现在此数据集下训练的冷启动同名消歧算法具有更好的泛化能力。

当前谷歌学术、AMiner等在线学术平台已经建立起大量学者档案,所面临的最大挑战是如何将姓名上具有歧义的新论文准确而又高效地分配给对应作者,即实时同名消歧。此任务需要依据新入库的待消歧论文与已有的各个同名候选作者的相关特征做出分配判断。Zhang等人[6]通过度量学习的方式得到论文与作者的嵌入向量,通过论文与各作者向量在表征空间的距离来确定所要分配的作者。Dong等人[12]利用作者与待分配论文之间共同机构、共同会议、共同作者等关系构建异质图,并使用随机游走将待消歧论文与候选作者表示为嵌入向量,Zhang等人[13]则预先使用门控循环单元(Gate Recurrent Unit,GRU)得到论文的语义嵌入向量,之后在论文与作者的关系网络上使用随机游走以捕获结构特征,最后将论文与作者表示为低维稠密的向量用于实时消歧任务。Zhao[14]在KDD Cup提出使用特征工程构建文本特征搭配梯度提升决策树(Gradient Boosting Decision Tree,GBDT)的方法对论文做出分类预测。Chen等人[7]使用预训练模型BERT[15]对待消歧论文以及候选作者每篇论文在各属性下进行细粒度的相似度计算,将丰富的语义特征用于消歧。Li等人[16]则提出了统一冷启动与实时消歧的方法,首先将共同作者名出现次数多的论文构建出高精确率的论文簇,再根据新增论文与各论文簇的语义相关性,按照合并作者节点的方式进行实时消歧。

可见,解决同名消歧的方法主要分为基于文献语义特征的同名消歧和基于文献结构特征的同名消歧。融合语义特征和结构特征的同名消歧方法具有较优的研究意义。

1.2 图神经网络

图神经网络(Graph Nerual Network,GNN)已被广泛应用于社交网络、化学分子结构、知识图谱等拓扑结构的研究中,其核心思想是利用边的信息对节点信息进行聚合从而生成新的节点表示。Niepert等人[17]通过将图中的节点组织为序列并使用卷积网络以获得具有结构信息的节点表示,Kipf等人[18]基于空域与频域的转换关系提出图卷积网络(Graph Convolutional Networks,GCN),使用一阶切比雪夫多项式实现空域卷积的效果。Velickovic等人[19]提出图注意力网络(Graph Attention Networks,GAT),采用注意力掩码将注意力机制引入图神经网络模型,使得模型能够准确灵活地计算邻居节点之间的权重,并通过多头的方式进一步提升模型的泛化能力。

本文针对实时同名消歧的特点,对待消歧论文与候选作者分别构建自我中心网络,采用图注意力网络来聚合节点特征以获取结构层面的信息。

2 相关概念与定义

定义1 论文一篇论文p由多个属性构成,例如标题、摘要、作者姓名等,即p={x1,…,xF},xf∈p代表论文中第f种属性。F指论文中属性的个数。

定义2 作者一名作者a由该作者所发表的n篇论文组成,即a={p1,…,pn},其中所有论文均由多个属性构成。

定义5 实时同名消歧给定一篇要对作者名na进行消歧的论文pna以及姓名na对应的候选作者集合Ana,假设pna中的作者名na所对应的正确作者a+∈Ana,其余作者a-∈Ana。则该问题需要学习一个评分函数Ψ,满足,如式(1)、式(2)所示。

其中,函数Ψ的输入为待消歧论文和任意候选作者,输出一个实数的相似度得分,Ψ需满足待消歧论文pna与正确作者的相似度得分大于pna与其他作者的相似度得分。最终会将待消歧论文分配给Ψ打分最高的作者。

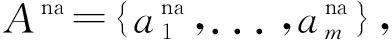

3 子图结构特征提取框架

本文提出一种端到端的子图结构特征提取框架,用于计算待消歧论文与各候选作者的图相关性特征。框架由包含编码层、聚合层、交互层的子图信息交互模块和包含归一化层和排序层的特征增强模块组成。框架如图2所示,黑色实心箭头为特征生成过程,空心箭头为训练阶段损失的传播过程。

图2 子图结构特征提取框架

3.1 子图信息交互模块

子图信息交互模块用于获取待消歧论文子图与候选作者子图之间的细粒度交互信息。此模块首先通过编码层对图中各节点的特征进行初始化,然后在聚合层对各节点特征进行加权聚合与更新,最后在交互层获取论文子图与各作者子图的相似度信息。

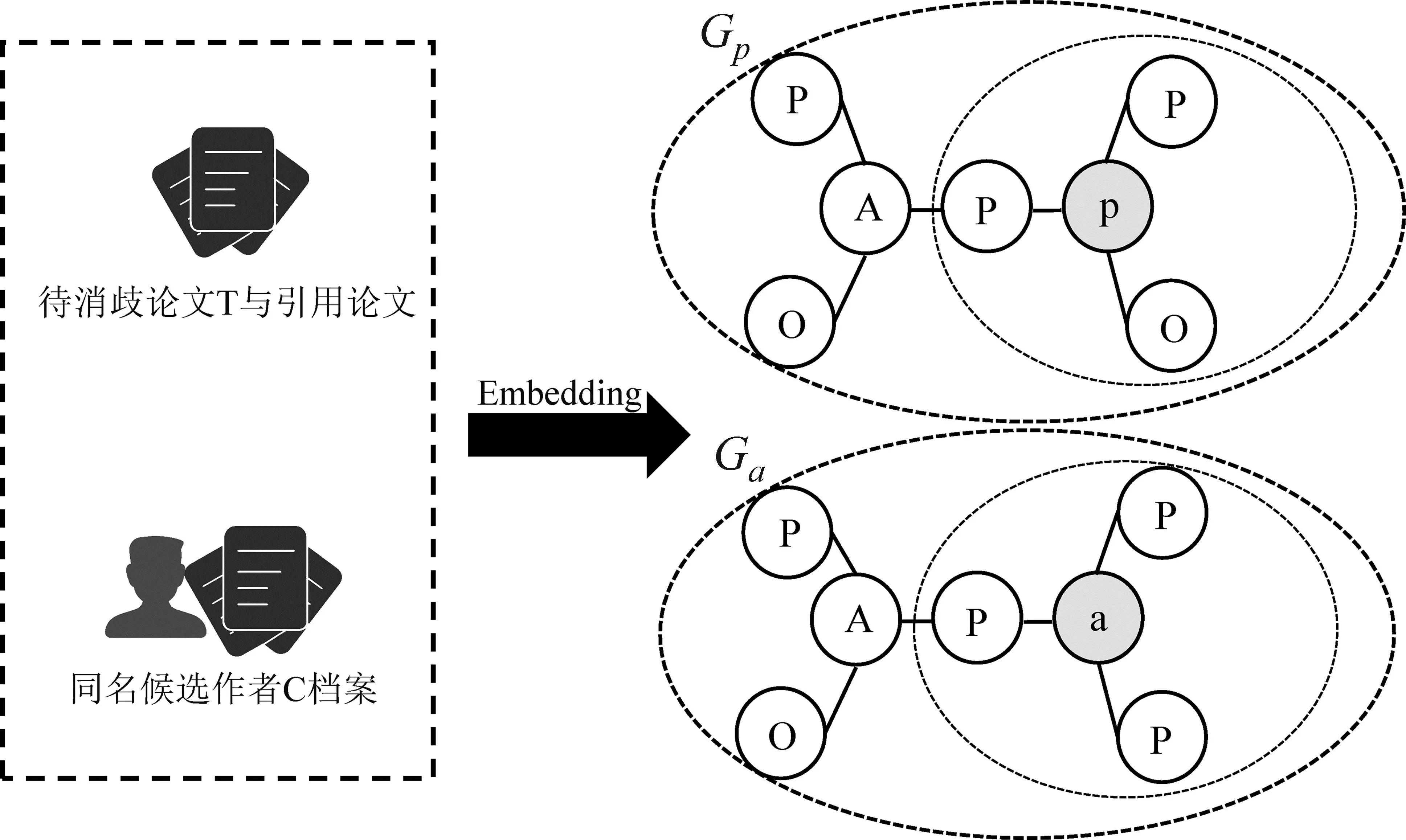

如图3所示,P、A、O分别指论文节点、作者节点以及机构节点,图中为待消歧论文p与一名候选作者a所构建的论文子图Gp与作者子图Ga。对论文子图Gp,p的一阶邻居为论文中待消歧作者的机构名称以及待消歧论文所引用的论文,考虑到无法假定p中其余作者姓名确定对应的真实作者,故p的一阶邻居中不含其余共同作者信息。p的高阶邻居为引用论文的作者的论文以及其机构名称。考虑到距离待消歧论文越远,数据噪声越多,故最大扩展到三阶邻居。对作者子图Ga,使用候选作者a的已发表论文作为a的一阶邻居,若已发表论文存在其余已经消歧完的共同作者,则该共同作者的论文和机构信息作为作者a的高阶邻居,同理,最大扩展到三阶邻居。子图信息交互模块通过对比待消歧论文子图Gp与各个候选作者子图集合GA={Ga1,Ga2,…,Gam}来捕捉待消歧论文与候选作者的结构信息。

图3 待消歧论文子图与候选作者子图

编码层首先对包含待消歧论文子图以及各个候选作者子图的图G内各类节点特征进行初始化。对于图中的论文和机构节点,模型提取各篇论文的标题、摘要、关键词拼接为字符串s,以及提取单独的机构名作为字符串o,两类文本记作S=(s1,s2,…,sln)和O=(o1,o2,…,olm),随后模块利用学术论文预训练模型OAG-BERT[20]对两类文本进行编码,得到嵌入向量矩阵XS=(xs1,xs2,…,xsln)和XO=(xo1,xo2,…,xolm),其中,ln、lm指图G中论文与机构的数量,x∈Rd,d为编码后特征维度。对于作者a={p1,p2,…,pn},则直接使用该作者已发表论文的嵌入向量的平均作为作者节点初始特征。

聚合层使用图注意力网络对待消歧论文子图以及各个候选作者子图进行相邻节点间注意力互相关系数的计算以及子图节点特征的更新。节点特征先由可训练的共享权重矩阵W∈Rd×d进行线性变换,然后经θT∈R2d对自身与相邻节点特征进行自注意力操作,最后经LeakyReLU计算出两节点间的注意力相关性权重。为了便于不同节点间权重的比较与计算,使用softmax进行权重归一化,节点i与相邻节点j的注意力互相关系数αij,计算如式(3)所示,其中,||表示拼接操作。

(3)

节点i的邻居节点特征同样使用共享权重W进行变换,然后各节点根据对应的注意力互相关系数进行加权求和,通过非线性变换φ计算节点i的聚合特征,计算如式(4)所示。

(4)

GAT采用多头注意力机制,通过集成多组参数下的聚合特征来增强模型表达的鲁棒性。式(5)中Wk为第k组线性变换权重,αk代表第k组注意力互相关系数。

(5)

交互层对图G中特征聚合后的论文子图与各作者子图进行细粒度交互。考虑到一位学者在不同时期的研究领域以及所处机构可能不同,则待消歧论文可能与正确作者仅有几篇论文内容相似,所以交互层应该关注更细致的相似度匹配信息而不能将子图粗化为一个向量。

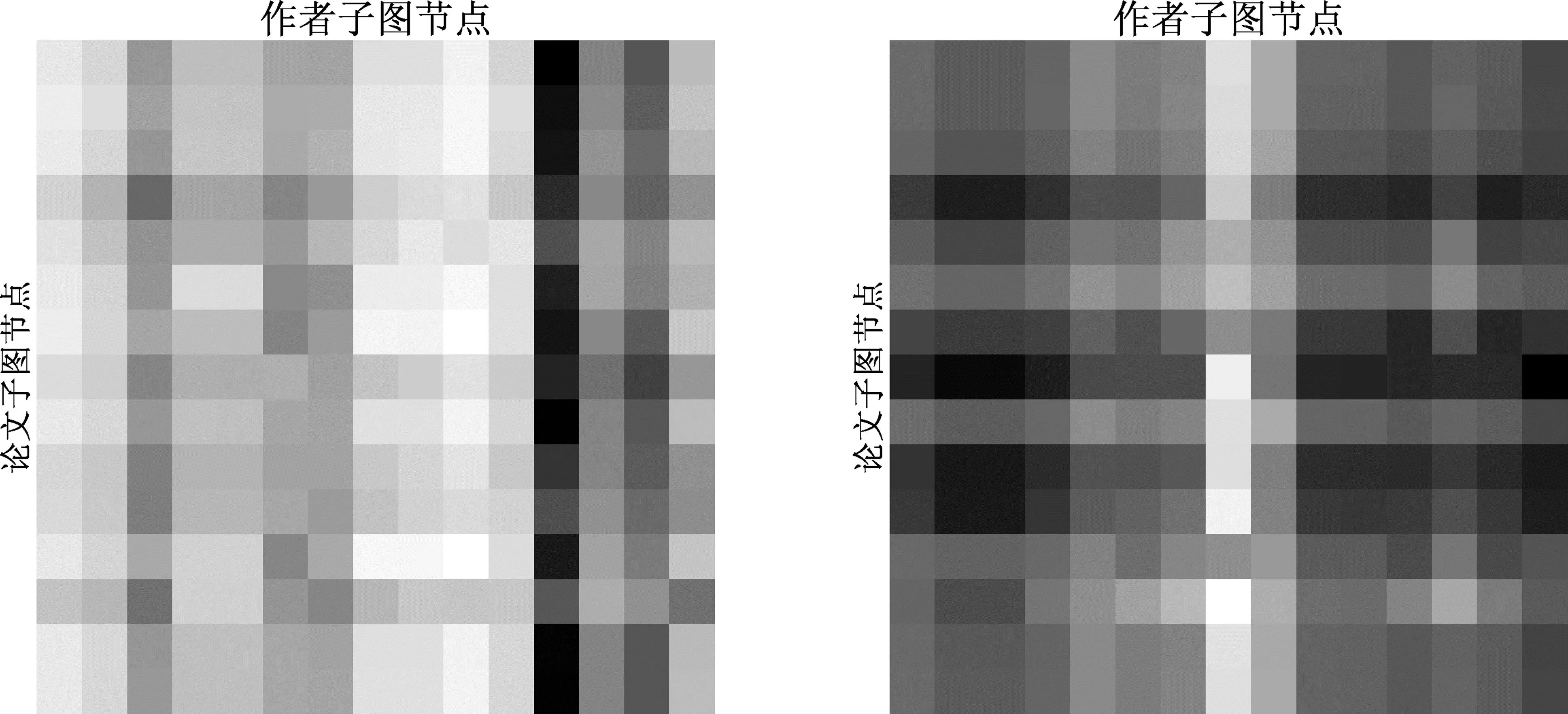

交互层的输入为待消歧论文子图Gp与候选作者子图集合GA={Ga1,Ga2,…,Gam},输出为Gp与各候选作者子图的相似度矩阵。在交互层中论文子图与各作者子图在设定的交互范围内(如一阶邻域、全量节点)逐节点计算特征相似度。M表示Gp与其中一个作者子图Ga的相似度矩阵,Mij为Gp第i个节点特征与Ga第j个节点特征的余弦相似度,若两个节点特征信息相似,则相似度应接近1,若特征信息无关,相似度应接近0,若特征信息相关且相反,相似度应接近-1。图4为待消歧论文子图与正确作者及其他作者子图的相似度矩阵,图中取相似度矩阵的前15行和前15列的数据展示。发现在交互层中很少存在节点之间特征信息相关且相反的情况,图4中最低的相似度为-0.02。白色代表相似度接近1,黑色代表相似度接近0,由图可见,本文提出的子图信息交互模块能够较准确地区分正确与其他作者。

图4 待消歧论文子图与正确作者子图、其他作者子图相似度矩阵

3.2 特征增强模块

特征增强模块的设计动机在于,各个候选作者子图的交互节点数各不相同,故子图信息交互模块所返回的相似度矩阵的尺寸不同,模型难以直接利用待消歧论文与不同作者的交互信息。此模块使用k组径向基核函数将特征矩阵转换为相同维度特征向量,同时还能够对特征矩阵蕴含的信息进行增强。最后,排序层将经归一化后的特征向量进行打分排序,以实现将待消歧论文所对应的正确作者与其他作者进行有效区分。

归一化层的操作类似于信息检索的核函数池化[21],Mi为相似度矩阵M第i行,表示Gp第i个节点与Ga中各个节点的特征相似度。在式(6)中,K(Mi)第k个元素Kk(Mi)表示对Mi使用式(7)中第k组核函数(均值μk,标准差σk)处理并进行池化求和。

归一化层最终通过对Gp每个节点所对应的K(Mi)进行对数求和得到Gp与Ga的图相关性特征φ(M),见式(8)。归一化层所使用的径向基核函数能够配置多组超参数来捕捉到M中不同层次的匹配信息。例如,当μ→1,σ→0函数关注M所包含的节点特征间完全匹配的信息,当μ→0.5,σ→0函数则关注M中相似度近似为0.5的信息。该方式使归一化层进一步丰富了交互层所传递的信息。

(8)

排序层基于排序学习[21](Learn To Rank,LTR)的思想,使用待消歧论文与各候选作者的图相关性特征来对整体框架进行有监督的训练。排序层首先使用全连接层将各个图相关性特征转换为匹配得分,然后以在表征空间中缩小论文与正确作者a+的距离、拉大与其余候选作者的距离作为目标进行训练。训练使用多负例排序损失作为损失函数,相比三元组损失,该损失函数具有更大范围的感受野,能对正确作者与其余作者实现更有效的区分。式(9)中Ai代表待消歧论文pi所对应的候选作者集合。

(9)

4 融合语义特征与结构特征的消歧模型

4.1 特征介绍

在语义信息方面,前人的工作已经证明,基于抽取待消歧论文与候选作者共现信息的特征工程方法在同名消歧任务中取得了很好的效果[7,16]。此外,使用论文与作者的语义向量进行相似度计算所求得的特征对消歧也有一定程度的帮助[7]。因此本文也集成了特征工程的方法,在作者名、题目、关键词、机构和会议5类属性上进行手工匹配特征的构建,以作者为例,待消歧论文中除消歧姓名A以外有共同作者名B、C,候选作者的某些论文的作者名出现B则视B为共现作者,根据TF-IDF得到共现作者名字的分数以及此分数在所有名字TF-IDF总分数下的比例;除作者名外的论文属性还使用Jaro Winkler距离和Jaccard相似度等算法来提取论文与论文之间多维度的共现信息,最终构建出36维手工匹配特征。随后使用学术预训练模型OAG-BERT推理得到待消歧论文与候选作者各篇论文的嵌入向量,并基于文章间的相似度矩阵使用多组核函数池化得到41维嵌入匹配特征。

在结构信息方面,通过本文的结构特征提取框架来获取图相关性特征,框架中的子图信息交互模块通过预训练模型初始化节点特征,采用训练过的图注意力网络分别对论文子图与作者子图中的节点特征进行加权聚合,再以细粒度的交互方式得到论文与各候选作者的相似度矩阵,框架中的特征增强模块使用径向基核函数将多组相似度矩阵分别转换为41维图相关性特征。

总的来说,在实时同名消歧任务中,以手工匹配特征与嵌入匹配特征来代表语义信息,以子图结构特征提取框架所推理的图相关性特征代表结构信息。

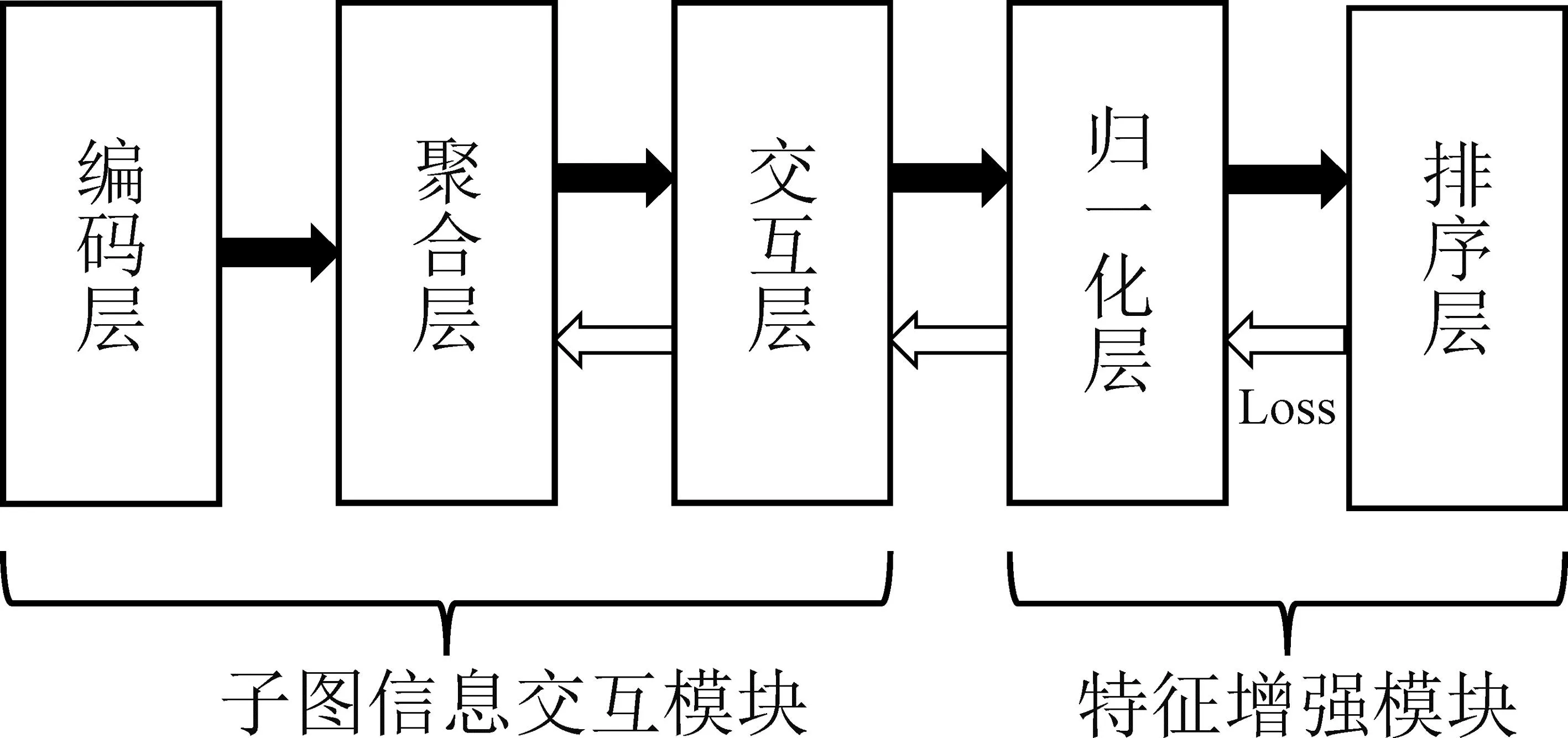

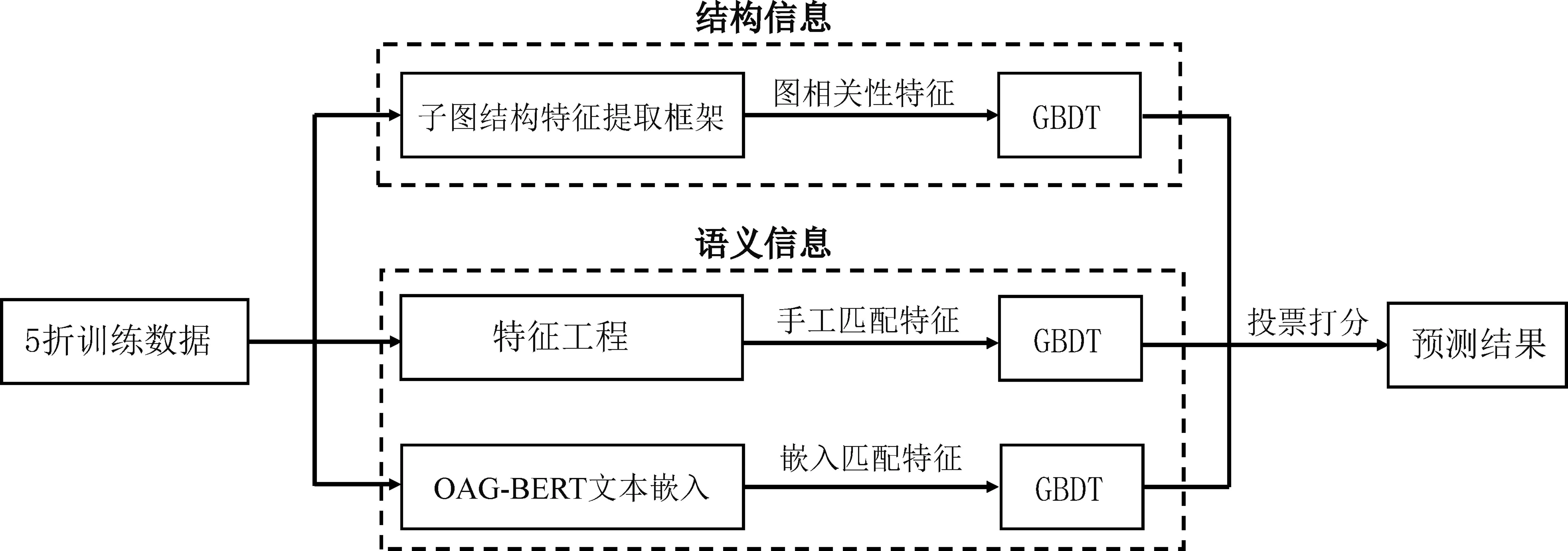

4.2 集成学习框架

本文首先通过子图结构特征提取框架、特征工程与文本嵌入的方式获取待消歧论文与候选作者间的语义和结构信息,然后使用集成学习来构建子图结构增强的实时同名消歧模型RND-all,以实现对各类消歧信息的全面融合。RND-all对图相关性特征、手工匹配特征、嵌入匹配特征均应用三类GBDT模型作为基分类器,具体分别为XGBoost、CatBoost和LightGBM。模型框架如图5所示。

图5 RND-all模型框架

训练过程中将训练集分为5等份,其中4份作为训练集,1份作为验证集。基于Bagging的思想,每一类基分类器均通过5折交叉验证的方式训练5个同分类器类别的子模型,并将子模型的平均预测概率作为基分类器的输出以提高整体模型的泛化能力。在预测过程中各类特征下的候选作者预测分数通过投票进行集成,使语义与结构特征一起参与作者的判定。

5 方法评测与实验结果

5.1 数据集及实验设

数据集:本文基于百万级人工标注的同名消歧数据集WhoIsWho(6)https://www.aminer.cn/whoiswho进行评测[7,22]。WhoIsWho数据集最新版本(v3.1)包括人工标注的 2 459个姓名所关联的 72 609个作者和 1 102 249篇论文,以及作者和论文之间的匹配关系。据统计,WhoIsWho中87%的姓名为消歧难度更大的中文姓名,数据集中的论文与作者涉及计算机、材料以及生物等十多种领域。WhoIsWho包括冷启动消歧与实时消歧两个子数据集,本文采用实时消歧数据集开展实验并基于作者档案以及论文的属性信息进行构图。由于部分作者或论文没有子图结构信息,数据集预处理时采用WhoIsWho训练集作者档案中的论文与候选同名作者列表构建出30 000组样本,并按照7∶3划分训练集与验证集,其中每组样本由待消歧论文、正确作者以及9位同名不正确作者构成;测试集为5 968篇待消歧论文,实验中将每篇待消歧论文与消歧姓名对应的所有同名作者构成待预测样本。

参数设置与实验环境:本文使用的具体参数设置如下: 节点特征维度d=768,图注意力网络层数l=2,每层注意力头数量分别为4和1,训练使用Adam优化器进行参数优化,初始学习率0.001,使用指数下降学习率调节器ExponentialLR,每一轮将学习率乘以0.9,一共训练30轮;集成学习中GBDT基分类器设置树深度为10层,学习率0.05,迭代1 000轮;径向基核函数配置41组超参数,41组核函数的均值μ为从1到-1步长为0.05的递减数列,方差σ除首位为0.001外其余均取0.1。实验平台环境为NVIDIA GeForce GTX2080Ti 显卡(11 GB显存),Intel(R) Xeon(R) CPU E5-2680 v4 @ 2.40 GHz,256 GB内存的处理器。

评估指标:实验采用命中率HR@k和平均倒数排名MRR来评估实时同名消歧任务下不同模型的效果。HR@k计算正确作者排名在前k位的样本占所有样本的比例,MRR对所有样本计算正确作者所在排名的倒数的平均值,这两种指标分别强调实时消歧模型预测的召回率与正确答案的排序位置,两种指标值越大代表模型效果越好。

5.2 基线模型

本文与多个实时同名消歧相关的基线模型进行比较,主要包括:

(1) CAMEL模型[13]首先将待消歧论文经GRU编码为论文的初始嵌入,之后基于作者与论文之间的结构关系通过随机游走的方式更新论文与作者的表示,最后直接将嵌入向量用于实时消歧。

(2) GML模型[6]提出一种基于度量学习的消歧方法。首先使用预训练的Word2Vec获取论文嵌入向量,然后通过作者已发表论文的平均嵌入来作为作者表示,在训练过程使用度量学习来拉近论文与正确作者的距离并推远与其余作者的距离,进而优化作者与论文嵌入中的语义信息。

(3) IUAD模型[16]按照共同作者、研究领域与期刊会议三方面统计出待分配论文与候选作者的相关性特征,使用EM算法学习多组匹配分布的参数用于消歧。

(4) CONNA模型[7]对待消歧论文与候选作者不同论文以及论文中的不同属性利用预训练模型来计算细粒度的语义匹配特征,同时还使用了特征工程进一步增强消歧特征的表达能力。

5.3 实验与分析

5.3.1 基线模型对比结果

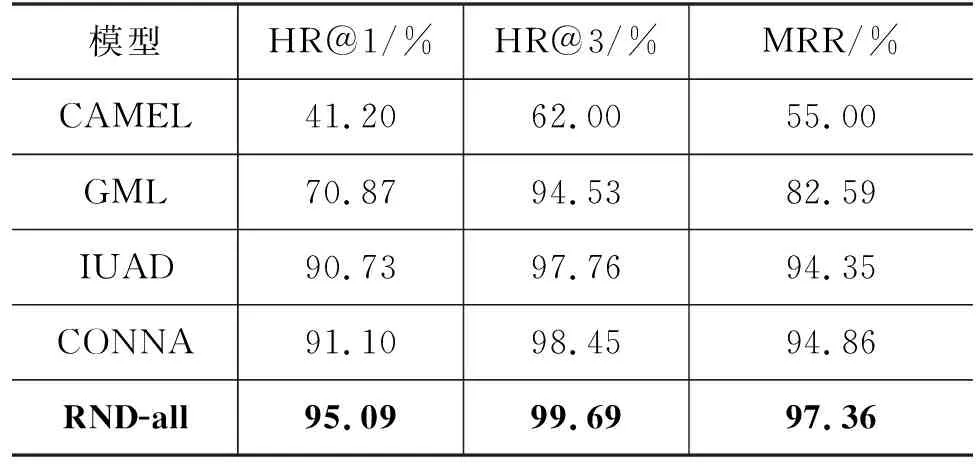

表1为RND-all与各基线模型的对比结果。CAMEL通过随机游走来学习作者嵌入向量,当出现某些作者所发表论文非常少的情况时,这类作者的嵌入向量无法得到较有效的训练,该方法结果并不理想;GML通过所发表论文的平均嵌入向量来表示作者,在很大程度上缓解了CAMEL中特征稀疏的问题,但因为缺乏文本层面的直接匹配特征表现较为一般。除此之外,GML所使用平均嵌入向量的方式无法捕获细粒度信息,忽视了待消歧论文仅与正确作者少量论文相关的情况;IUAD和CONNA均在通过文本嵌入向量进行细粒度匹配的基础上,进一步使用特征工程在文本上获取更细致丰富的直接匹配特征,两种消歧方法在特征工程设计上有一定差异,但是实际结果差距较小。

表1 不同消歧方法在实时消歧任务上的效果

本文注意到IUAD和CONNA没有利用消歧论文与候选作者之间固有的结构信息,因此,所提出的RND-all模型,首先采用子图结构特征提取框架来获取论文与候选作者之间的图相关性特征;然后,通过特征工程和文本嵌入技术得到不同维度的语义特征;最终,通过集成学习方法实现了语义和结构信息的有效融合。RND-all的HR@1、HR@3和MRR指标均达到最高,分别为95.09%、99.69%和97.36%,相比CONNA分别提升3.99个百分点、1.24个百分点和2.5个百分点。

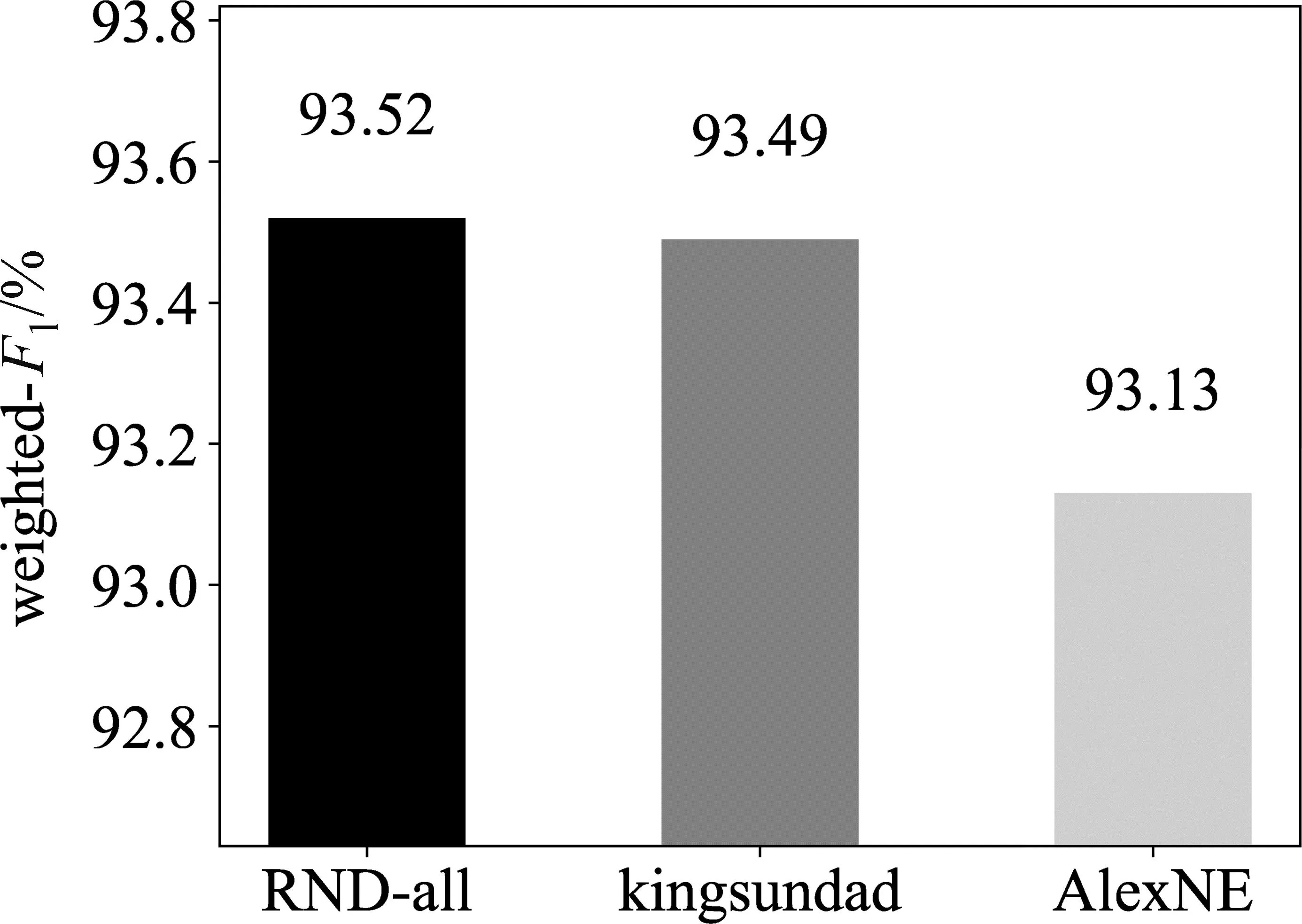

5.3.2 RND-all应用于WhoisWho同名消歧竞赛

WhoisWho是全球范围内首个考虑NIL(Not In List,NIL)问题的同名消歧竞赛,WhoIsWho竞赛已经举办三届,累计吸引了3 000余名研究者参赛。目前WhoIsWho竞赛长期维护两个同名消歧子任务的排行榜。本文在RND-all的基础上适配此竞赛,最终在实时同名消歧赛道取得第一名的成绩。

NIL问题指待消歧论文不应该属于数据集已有的任何作者,例如,平台收录了一名大学生发表的第一篇论文,但这篇论文不属于平台中任何与他同名的作者,因此实时消歧模型不仅需要根据待消歧论文的内容在候选作者中发现正确作者,还要对论文是否为NIL做出判断。该竞赛使用weighted-F1来综合衡量各参赛者的实时同名消歧算法的预测精度以及NIL的识别能力。为应对NIL场景,本文构造由论文与同名非正确作者组成的训练样本来仿真NIL数据,并在原RND-all的各基分类器的上面再叠加一层GBDT模型用于NIL数据的判定。上层所叠加的模型首先将基分类器下各作者的预测分数进行降序排列,然后取第一名作者得分、所有候选者平均得分、前两名作者分数差与第一名及最后一名分数差的比值来构造代表候选作者总体分布信息的特征向量,用于NIL的判定训练。最终,如图6所示,本文所提的子图结构增强的RND-all获得竞赛冠军,相比亚军与季军的方法,RND-all最大的区别就在于消歧特征中额外引入了待消歧论文与候选作者的结构信息。

图6 WhoIsWho同名消歧竞赛实时同名消歧子任务排行榜

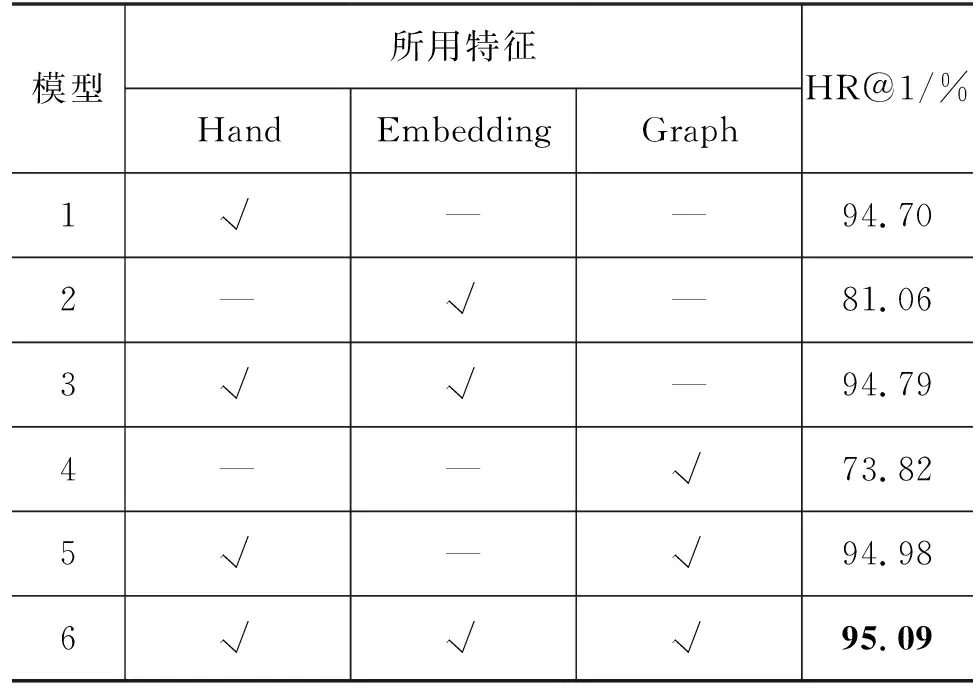

5.3.3 语义信息与结构信息对性能的影响

为探究语义信息与结构信息对实时消歧任务的贡献,本文对两类信息下的各个特征进行消融实验。语义信息上采用了手工匹配特征(简记为Hand)以及基于OAG-BERT的嵌入匹配特征(简记为Embedding),结构信息上使用第三节框架所提取的图相关性特征(简记为Graph)。下面以一篇待消歧论文与一位同名候选作者来分析计算三类特征的时间复杂度,候选作者档案中的论文数为N,论文或者机构名所构成字符序列的长度为S,预训练模型词表大小为V,词向量维度为H,预训练模型层数为L,图中的边数为E。计算手工匹配特征的时间复杂度为O(NS),计算嵌入匹配特征的时间复杂度为O(N((V+S)H+LH2)),计算图相关性特征的时间复杂度为O(N((V+S)H+LH2)+EH)。

使用不同特征的消歧效果如表2所示,模型1和3仅使用语义特征,模型3在模型1基础上引入嵌入匹配特征后HR@1有所提高,说明使用更丰富的语义信息有一定作用。模型5相比模型1多融入了结构信息,HR@1提升0.28个百分点,说明结构特征能够进一步增强模型性能。其中,融合结构信息与语义信息的模型6达到最佳效果,相比使用两种语义特征的模型3,在HR@1提升0.3个百分点,再次证明结构信息的有效性。

表2 不同特征的消融实验

通过观察引入结构特征的模型相较于仅使用语义特征的模型所多分配正确的论文,本文发现这类待消歧论文存在两个特点,一是论文与多位同名候选作者档案均存在较多的共现信息,二是论文普遍为生物、化学相关领域,文中含有大量复杂的专业术语。在此类复杂实时消歧场景下仅使用语义特征较难发挥作用,而引入结构特征能带来的性能提升是因为图模型能在较大的数据范围上关注到相对突出的信息,更利于复杂场景下的实时消歧。

另外,本文统计了各组模型在各个消歧姓名下待消歧论文的排序指标。通过模型6的结果与其余模型结果使用Paired T-test进行显著性分析,模型6与其余模型的p-value均小于0.05,说明此模型与消融实验中其余模型存在显著差异。

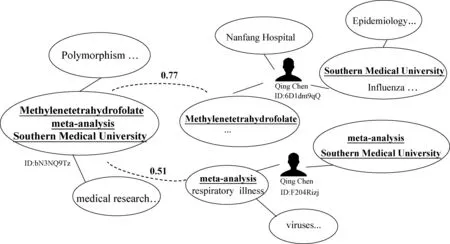

5.3.4 实例分析

为直观分析结构信息对实时消歧算法性能带来的提升,本文对仅用语义信息分配有误而在引入结构信息后分配正确的文章加以分析。

以图7中WhoIsWho中标号为“bN3NQ9Tz”的待消歧论文为例,该文待消歧作者名为“Qing Chen”、机构为“Southern Medical University”、论文关键词为“Methylenetetrahydrofolate”和“Meta-analysis”中文分别译为“亚甲基四氢叶酸”和“元分析”。两名同名候选作者均在已发表论文的机构出现过“Southern Medical University”,ID为“6D1dm9qQ”的学者主要开展基因相关研究,ID为“F204Rizj”的学者关注呼吸系统疾病的研究。通过查阅两名作者的档案,发现相关论文中均存在大量医学相关的名词以及许多复杂的化学物质名称。其中,ID为“F204Rizj”的作者较多论文出现含义更为宽泛的“Meta-analysis”关键词,因此仅使用语义信息的模型更倾向分配给此作者。而RND-all通过图注意力网络对多跳信息进行聚合,能够捕捉结构中更突出的信息,因此待消歧论文节点虽然与两个候选作者子图中的节点均具有共现词,但是在节点之间的相似度上已有较大差异,如图中相似度分别为0.77与0.51。

图7 实例分析

通过本例可以观察到,仅使用语义信息所导致的消歧错误往往是因为多位候选作者之间存在语义上易混淆的相似关键词,并且待消歧的论文普遍为生物医药以及化工材料领域。因此,本文认为结构信息所带来的效果提升源于以下两点:

(1) 部分待消歧论文所对应的多位同名作者在机构、研究领域上内容相近,导致两名学者在文章内容上具有较多的共现词汇,此时仅依赖语义信息很难进行准确地消歧,要进一步通过构建图来从全局结构上提取更突出的信息。

(2) 在生物、化学等领域,文章标题与关键词中经常出现复杂的专业名词,手工匹配与嵌入匹配特征在这类信息上表达能力比较有限,进而使用论文、作者、机构在关联结构中表达出的信息对实时同名消歧任务更有帮助。

5.3.5 不同范围下子图交互效果

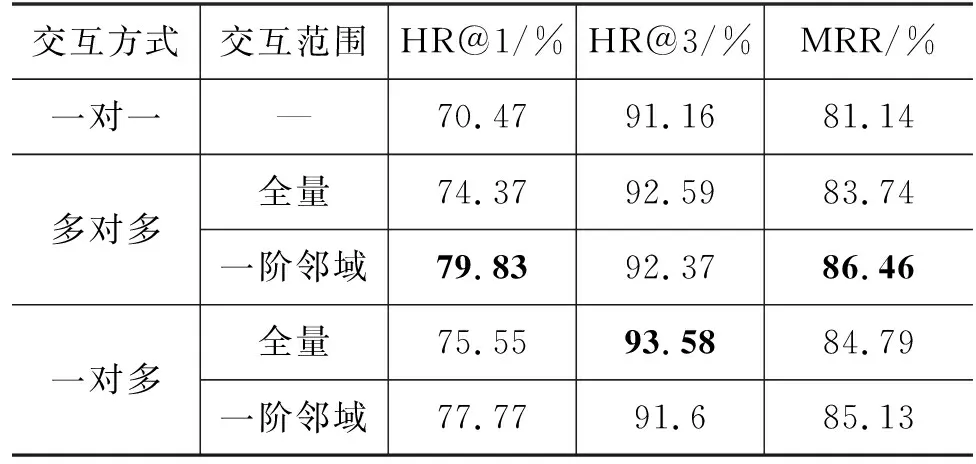

为观察子图结构特征提取框架中交互层在不同范围的交互效果,实验对待消歧论文子图Gp与候选作者子图Ga采用一对一、一对多和多对多的方式进行特征交互。一对一交互指仅对自我中心网络Gp与Ga的中心节点进行相似度计算;多对多交互分为两种交互范围,Gp与Ga全量节点之间的交互和Gp与Ga在中心节点一阶邻域的交互;类似的,一对多交互分为Gp中心节点与Ga全量节点的交互、Gp中心节点与Ga一阶邻域的交互。

通过表3观察到,仅使用Gp与Ga中心节点一对一交互的效果不佳,虽然中心节点通过邻居进行了特征聚合,但一对一的交互方式直接损失了子图中大量的信息;使用多对多方式在Gp与Ga全量节点的交互相较前者在HR@1、HR@3、MRR上均有提高,反映出利用图中丰富信息能有效提高模型消歧的能力,但在本身图的构建过程中高阶邻居节点不可避免地会引入噪声,全量节点的交互过程中可能掺杂一定的错误信息,所以HR@1表现一般;多对多方式在一阶邻域交互后的模型在HR@1和MRR下取得最好效果,本文认为论文与作者子图的一阶邻域代表待消歧论文与候选作者最直接相关的内容,其已经蕴含绝大部分有助于消歧的信息,同时此范围交互能够避免高阶噪声节点产生的误导信息,该方法相较于前面的一对一和全量交互在HR@1上分别提高9.36个百分点和5.46个百分点。另外,从一对多交互的两组实验观察到,Gp中心节点与Ga一阶邻域交互的HR@1、MRR要高于与Ga全量节点交互,而后者使用全量节点的方式在HR@3上优于一阶邻域的交互,我们发现,此现象同样出现在两组多对多实验上,因此本文认为全量匹配虽然损失一定的精度导致HR@1与MRR下降,但是引入更大范围的信息有助于部分正确作者提升在整体排序中的名次,使得正确匹配作者更有机会进入预测分数最高的前三名,从而HR@3有所提升。

表3 不同范围下子图交互效果

6 总结

本文提出子图结构增强的实时同名消歧模型RND-all,首先通过子图结构特征提取框架高效计算出论文与候选作者之间的结构特征,然后采用特征工程与文本嵌入方法提取用于消歧的语义特征,最终使用集成学习实现语义信息与结构信息融合。RND-all在WhoIsWho实时同名消歧数据集上各类指标均达到最优,并且在WhoIsWho竞赛实时消歧排行榜上排名第一,表现出语义特征与结构特征融合的优越性。在本文的消融实验与实例分析中进一步阐明了引入结构特征的有效性。

RND-all在结构信息的提取上仍有几个可能的改进点,在初始化节点特征上未来可选用更强大的预训练模型进行特征表示以提高节点的表达能力,图神经网络模型方面可采用Graph Transformer[23]等新型模型增强特征聚合能力。此外,如何将结构特征更有效地引入实时同名消歧任务也是今后值得关注的研究方向。