基于注意力机制的双分支肺炎图像分类网络

张吉友 张荣芬 刘宇红

文章编号 1000-5269(2024)01-0094-09

DOI:10.15958/j.cnki.gdxbzrb.2024.01.15

收稿日期:2022-12-05

基金项目:贵州省科学技术基金资助项目(黔科合基础-ZK[2021]重点001)

作者简介:张吉友(1998—),男,在读硕士,研究方向:计算机视觉、医学图像处理,E-mail:1916537869@qq.com.

*通讯作者:张荣芬,E-mail: rfzhang@gzu.edu.cn.

摘 要:目前许多肺炎图像分类网络大多采用单分支网络对输入图像进行特征提取,这在一定程度上忽略了图像不同维度的特征信息。为了优化这种问题,提出一种融入注意力机制的双分支肺炎图像分类网络,利用VGG16网络和加入可分离卷积以及融入卷积注意力模块(convolution block attention module, CBAM)的CNN卷积神经网络进行双分支特征提取,能够关注到肺炎图像不同层次的特征信息,将2种网络分支的特征进行不同维度的融合,最后输入全连接层进行分类判决。结果表明,该网络在正常肺部、病毒性肺炎、新型冠状病毒肺炎(COVID-19)X-ray图像组成的测试集上取得了95%的平均准确率。经过消融试验证明,该网络加入的可分离卷积模块、注意力模块和特征融合对减少网络参数、提高网络分类的准确率起到明显作用。与其他网络的性能对比也表明该网络在肺炎图像分类上表现出较高的准确率和较强的鲁棒性。

关键词:新冠肺炎;肺炎图像分类;注意力机制;双分支特征提取和融合

中图分类号:TP391.41

文献标志码:A

新型冠状病毒肺炎(COVID-19),简称“新冠肺炎”。卡式荧光PCR法是快速确诊新冠肺炎的方法[1],但是这种方法采集新冠病毒核酸存在检测结果有效期短、灵敏度较低等缺点,需要重复检测才能确诊。对于防治新冠肺炎和阻止疫情的有效方法是能够及时发现病人并快速隔离。借助X线(X-ray)胸片图像和电子计算机断层扫描(CT)图像确诊新冠肺炎是一种快速、方便、准确率高的有效方法。但是,由于新冠肺炎传染力强,许多地区的防疫形式严峻,导致医生识别新冠肺炎医学图像的工作量增大。为了对医学图像进行分类和找出病灶部位,新冠肺炎爆发以来,采用深度学习对X-ray图像进行分类成为热点研究方向。例如,宋瑶等[2]改进U-net网络以对新冠肺炎的CT图像进行分割。ICEK等 [3]把所有的2D卷积换成3D卷积块,采用批量标准化防止梯度爆炸。冉健雨[4]利用迁移学习,运用VGG19,ResNet50和CheXNet这几种卷积神经网络进行分类并比较网络的分类效果。

虽然很多专家和学者利用迁移学习和已有的网络结构在分类方面取得了不错的效果,但是许多网络存在网络层数较多,容易造成过拟合,而且采用单分支网络提取图像特征的效果不好。为解决上述问题,本文提出了一种基于并行双分支结构进行特征提取,在卷积网络融入可分离卷积和注意力模块,注重各类肺炎图像的有用特征信息,然后利用兩路网络提取到的特征进行特征融合,从而实现对肺炎图像进行高效分类,以期借助深度学习神经网络模型智能识别肺炎图像,将其作为新冠肺炎预防的一种辅助诊断手段。

1 融入注意力模块的双分支多分类网络

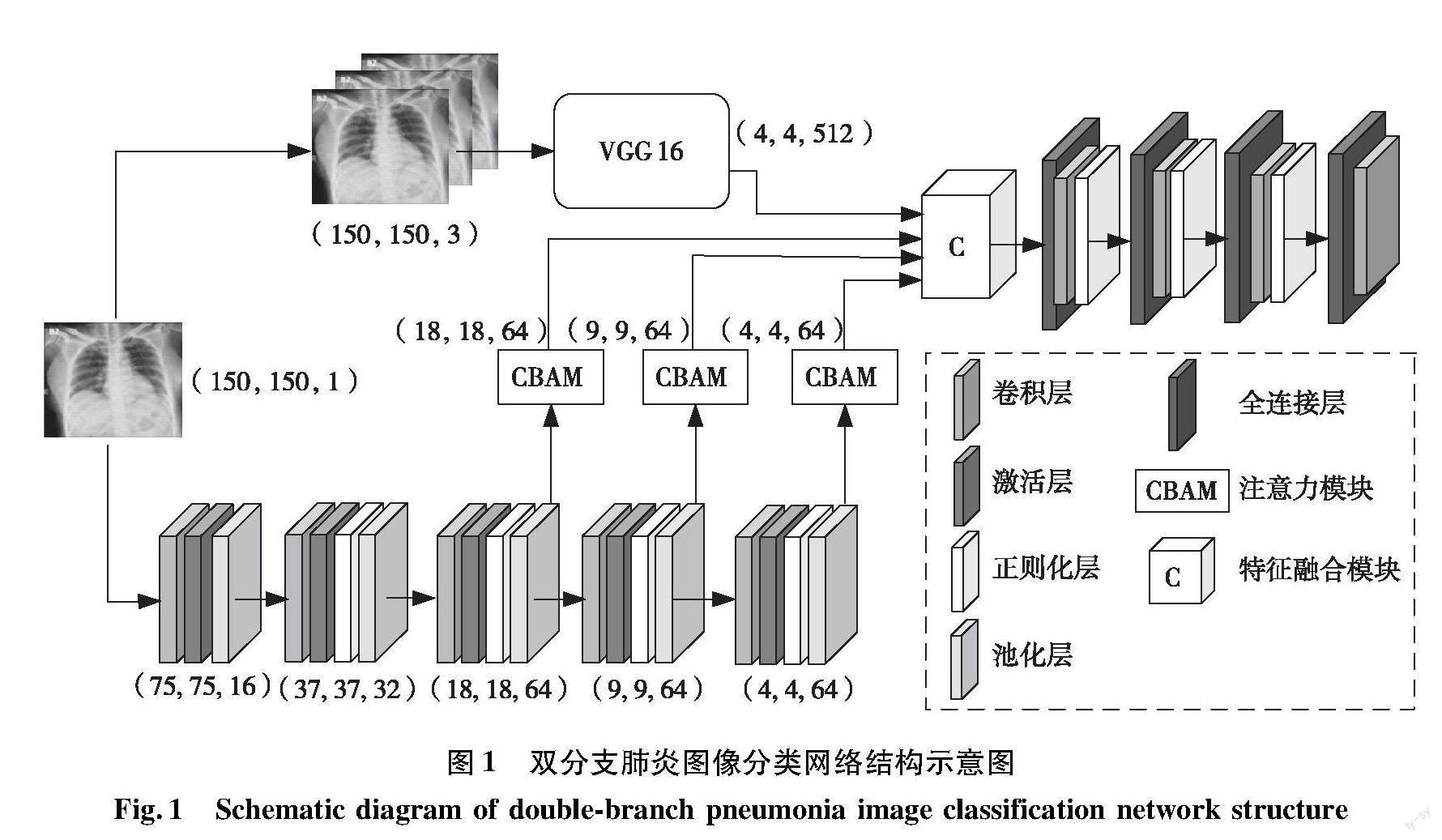

基于文献[5],本文提出了一种融入注意力机制的双分支肺炎图像分类网络,其结构示意如图1所示。双分支网络的一个分支是VGG16迁移学习网络,另一个分支网络则包括5个卷积块。每个卷积块中依次加入卷积层、激活层、正则化层和池化层。为了增强网络对各种肺炎图像的特征提取,在卷积网络的第3、4、5个模块中分别加入了卷积注意力模块(convolution block attention module, CBAM),并将其输出和第一个分支网络的输出在Concatenate模块实现特征融合,然后将融合层的输出送入到4层全连接层进行分类。

由图1可见:采用双分支网络并且加入注意力模块突破了单分支提取特征的局限,可以提高模型处理数据和提取高质量特征的能力;而将2个分支网络提取到的不同特征进行特征融合,在一定程度上获取了更多不同种类肺炎图像的特征。其中,选择第3个卷积块的输出加入CBAM模块作为融合源,能从全局上把握数据的分布情况并进行特征提取。所得特征有助于模型提取浅层特征信息,利用浅层特征信息进行图像分类。此外,将第4个和第5个卷积块的输出作为注意力机制模块特征融合的一个信息源,以获得更深层次的特征信息。经过几次卷积和注意力模块的添加,网络获取到的信息是输入数据更深层次的信息,使得网络对深层次的信息更加关注。同时,网络中的特征融合模块能对不同维度的特征信息进行整合,有利于网络结合浅层特征和深层特征进行分类。

1.1 CBAM

注意力机制在人类的感官中扮演着重要的角色。人类视觉在处理视野里面的所有对象时相对困难,但是能够抓住视野里面一些对象的主要特征进行学习,而再次遇见类似对象时则能抓住其主要特征进行识别。这一效应运用到计算机视觉领域,可以让深度学习模型注重输入的有用特征信息,忽略无关信息以便能更好地进行分类识别。

CBAM于2018年提出。在深度学习中加入CBAM注意力机制,不仅使得网络知晓应该注意哪里,而且还能提高兴趣区域的特征表示能力[6]。而CBAM注意力机制本质是一个简单而有效的前馈卷积神经网络注意力模块。CBAM计算量比较小,是轻量的通用模块,因此可以加入到任何卷积神经网络中。本文将其添加到卷积网络中,帮助网络学习到各类X-ray图像的特征信息。

图2[7]是CBAM中通道注意力模块和空间注意力模块生成特征图的示意图。CBAM可以生成一维通道注意力特征图Mc(记作Mc)和二维空间注意力特征图Ms(记作Ms)。数据输入(记作I)依次经过通道注意力(数据输出记作I1)和空间注意力模块的筛选,生成新的注意力特征图(记作O)。该过程强调重要特征,压缩不重要特征,可用公式表示为:

I1=McΘI(1)

O=MsΘI1(2)

1.2 可分离卷积模块

可分离卷积最早由Google的MobileNet提出[8],其本质是把完整卷积运算分解成2步卷积进行。第一步是在每个通道上进行卷积运算,不会改变输入的通道数目,通常称其为深度卷积部分。第二步是将深度卷积得到的特征图进行逐点卷积,最后得到输出特征图。普通卷积和可分离卷积运算的过程分别如图3和图4所示。

对于普通卷积而言,假设输入为C通道的特征图,卷积核大小为M×M,输出为C1通道,特征图大小为m×m,则此时普通卷积的运算量CC表示为

CC=M×M×C×m×m×C1(3)

对于深度卷积而言,在逐层卷积阶段,输入的C通道的特征图和C个大小为M×M滤波器分别各自进行逐层卷积,最后输出C个特征图。随后逐层卷积输出的特征图和C1个1×1×C的滤波器通过逐点卷积操作得到输出为C1通道,大小为m×m的特征图,则可分离卷积的运算量CS表示为

CS=M×M×C×m×m+m×m×C×C1(4)

对比两者运算量:

CSCC=M×M×C×m×m+m×m×C×C1M×M×C×m×m×C1

=1C1+1M2(5)

本文使用的卷积核大小M=3,1M2为1/9,C1为输出通道数,一般比较大,因此C1通常可以忽略不计。根据式(5)计算结果,利用普通卷积的运算量大概是利用可分离卷积的8至9倍[8]。但是,根据后续实验表明,利用可分离卷积实现的网络,其精度下降非常小。

1.3 特征融合模块

特征融合模块的功能是对相同的输入图像,分别利用2种以上的网络进行不同的特征提取,最后将所提取到的特征进行不同维度的融合。假设Π是含有m个被标记的训练样本空间,记为Rn,ζ是其中的一个训练样本,则

Π=[ζ|ζ∈Rn](6)

若特征向量A,B,…,N满足:

A=[x|x∈R1]

B=[y|y∈R2]

N=[n|n∈Rk](7)

那么从不同的图像所得到的特征融合向量空间

Df=cat(A,B,…,N) (8)

式中:A,B,…,N为对于相同的输入通过不同的训练分支提取的特征向量;cat为按向量维度进行拼接。

2 实验准备及模型训练

2.1 数据集

由于医学图像不易获取,而且肺炎X-ray图像需要相关的专家才能进行标注,所以本次实验的数据集来源于Kaggle公开竞赛数据集。该数据集是卡塔尔多哈的卡塔尔大学和孟加拉国的达卡大学的研究人员,以及巴基斯坦和马来西亚的合作者与医生共同构建的数据库。数据库中新冠肺炎图像包含了新冠肺炎不同阶段的图像,不同阶段的特征又不相同,这对于深度学习网络提出了更加严峻的考验。我们在数据集中随机挑选了正常肺部(Normal)、病毒性肺炎(Viral pneumonia)、新冠肺炎(COVID-19)的X-ray圖像各300张,采用等比例的训练集,防止深度学习模型对某一类较多的图像有较强的识别能力。在实验中将900张图像按照8∶2的比例划分为训练集和验证集。

2.2 图像预处理

原始数据集中的图像来自不同的医院,尺寸大小各不相同,尺寸太大不能作为输入,因此在网络的训练过程中将图像变为150×150;并且为了提高网络训练的效果,采取随机改变图像的亮度、对比度,对图像的视野进行缩放,对角度进行翻转等操作来拓展数据的输入形式。图像预处理的参数设置见表1。

2.3 实验环境和评价指标

本文基于TensorFlow2.8.0架构开展实验,利用Python3.8进行编程,所有程序在 Ubuntu16.04 LTS 64-bit 系统上运行,CPU 为 Intel(R) Core(TM) i7-7800X CPU@3.50GHz,GPU为双卡 NVIDIA GTX 1080Ti。

评价标准采用准确率A、精度S、召回率P、F1度量F1来进行评价,其计算公式如下:

A=TP+TNTP+TN+FP+FN×100%(9)

S=TPTP+FN×100%(10)

P=TPTP+FP×100%(11)

F1=2×S×PS×P×100%(12)

式中:TP为被正确预测为正类;TN为被正确预测为负类;FP为被错误预测为正类;FN为被错误预测为负类。

2.4 模型训练

在模型训练时,训练集数据采用shuffle data方法并随机打乱,再根据batch size的大小输入打乱顺序的训练数据,这样操作有效地避免了模型对某一类图像产生过拟合。在特征提取网络中,深度可分离卷积的卷积核大小为3×3,每一层都采用了最大池化,池化核大小设置为2×2,以突出每一类图像的局部特征,有利于注意力模块学习。采用输入批量归一化的方式规范输入到CBAM模块和下一层卷积层的数据。在特征融合模块之后,分别设置了4层全连接层,其神经元个数分别为518,128,64和3。经过调参,最终将第1、2、3层丢弃率都设置为0.2。全连接层的前三层采用Relu函数作为激活函数,其表达式为

f(x)=max(0,x)(13)

由于f(x)小于0无值,大于0才有值,减少了参数之间的相互依赖性,可以减少过拟合[9]。最后一层采用Softmax函数作为激活函数,其表达式为

si=ej∑nj=1ej(14)

式中:si为SoftMax层的输出概率值, ej为SoftMax层的输入值;n为SoftMax层的输入值个数。

本文模型采用动态学习率调整。如果模型在学习过程中发现验证集的损失函数在训练2个epoch后不下降,则将学习率降低为原来学习率的一半。训练模型原始学习率设为1.0×10-3,最小学习率设为1.0×10-8。另外,为了防止模型产生过拟合的问题,在实验中设置了早停机制。如果在训练中超过10个epoch的验证集损失函数没有下降趋势,则让模型停止训练。由于模型设立了早停机制和学习率下降机制,经过多次调试实验,设置epoch为25时的模型准确率比较稳定。若epoch设置过大,会产生早停;若epoch设置过小,则模型准确率比较低。网络的超参数设置如表2所示。

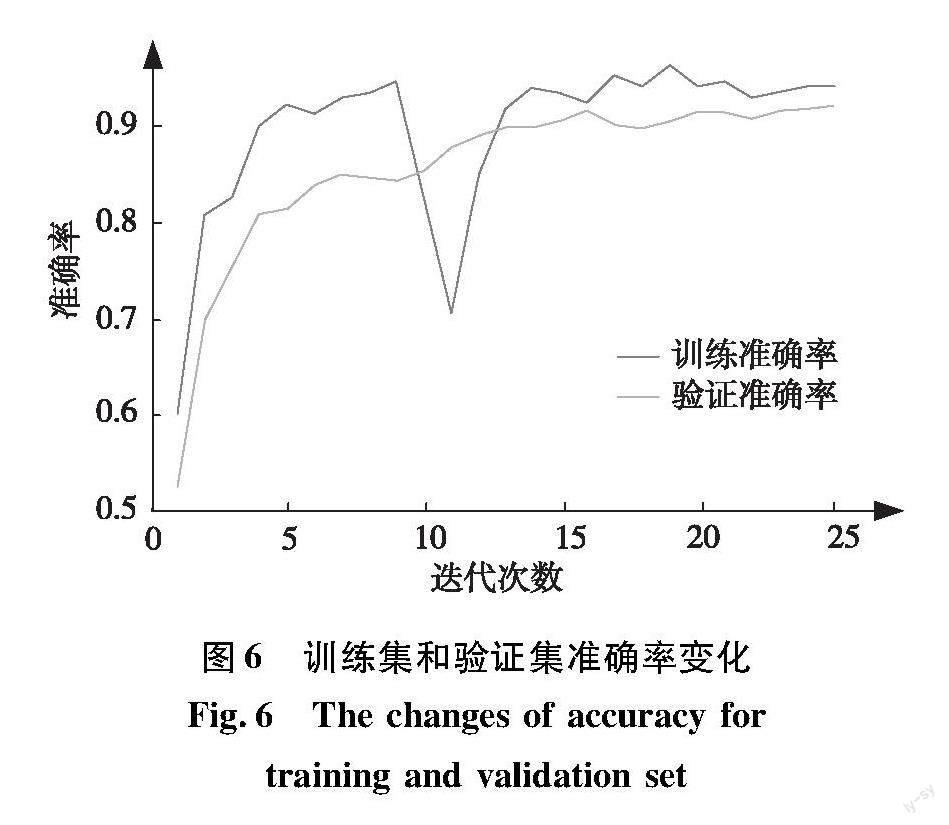

训练过程中,训练集和验证集损失函数变化和准确率变化分别如图5和图6所示。由图5和图6可知:第9~11个epoch,由于验证集的准确率不断下降,连续2个epoch的验证集损失函数升高;模型快速调整学习率,第12个epoch,验证集的准确率开始提升,验证集的损失函数开始下降;第20~25个 epoch,无论是训练集还是验证集的损失函数波动都很小,说明模型训练已经接近稳定。

3 实验及分析

3.1 分类实验

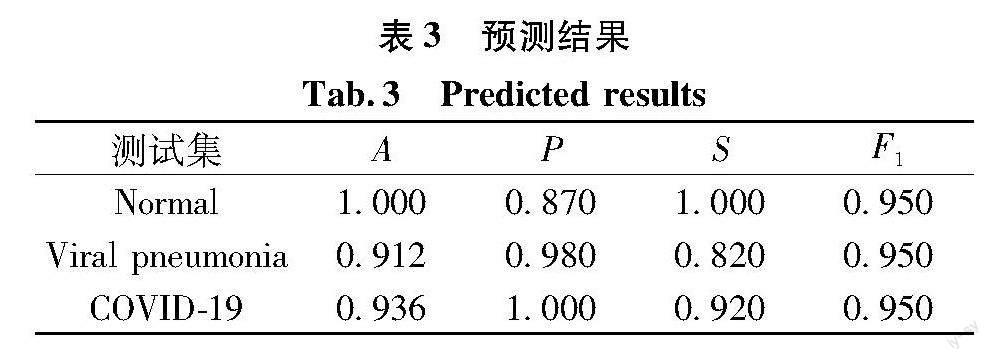

为了验证网络的鲁棒性,测试集选用的图像数

据和训练集来源不同,其中每一类的图像均为250张。表3给出了该测试集在预测后的预测结果。本文网络对新冠肺炎、病毒性肺炎的肺部图像分类能力不如正常肺部,在测试过程中容易把部分带有疾病的肺部图像识别为正常的肺部图像。

3.2 消融实验

为了证明CBAM、特征融合的有效性和验证可分离卷积减少参数对分类指标影响微弱,选择4种网络(网络A、B、C、D)和本文网络进行消融实验。消融实验的所有参数都是实验环境所用的架构自动计算出来的参数量。表4给出了消融实验的5种网络参数量、消融模块的对比。 5种网络对3类图像分类的准确率、精度、召回率、F1度量的对比见表5。

对于网络A和网络B而言,由于结构简单,需要拟合的参数少,其各项分类指标明显低于其他的网络。其中,网络A的网络相对比较深,训练参数比较多,拟合效果好,所以其各项分类指标相比网络结构简单的网络B有一定程度的提升。并行双分支融合后,网络的非训练参数量等于2种单分支未并行前的非训练参数量之和,但是融合后涉及到全连接层的权重参数,融合后的训练参数量并不等于融合前两并行分支的参数量之和。而参数增加使得分类准确率明显上升,所以双分支网络对三类图像分类的准确率相比单分支网络都相对较高,证明了并行特征融合的有效性。对比网络C和网络D,虽然网络D比网络C的总参数量多了约21万个,但是网络D对于Normal和COVID-19的准确率都有一定提升,对于Viral pneumonia略有下降但仍然高达91.2%。证明了CBAM模块在该网络中的有效性。对比网络D和本文网络,虽然运用可分离卷积构建的网络在各类别的平均准确率比运用普通卷积构建的网络低0.004,但是训练参数大约少了20万个,在运算量上少8~9倍,很大程度上减少了网络训练时间。

对比5种网络的准确率,Viral pneumonia的分类准确率均低于Normal和COVID-19。 Viral pneumonia包含多种病毒导致的肺炎,症状各有不同,对应的肺炎图像也各不相同,导致各种模型对其分类准确率较低。综上所述,双分支网络模型可以从不同尺度提取到3种类别图像的特征信息,其中,CBAM模块可以进一步关注3种图像的关键信息,特征融合模块能对2种分支网络获取的特征进行整合。通过消融实验证明本文提出的各个模块对于提高肺炎图像分类的准确率是有效的。

3.3 横向对比实验

为了进一步体现本文网络各个模块的有效性,和其他13种肺炎图像分类网络的指标进行对比,如表6所示。根据原文献,实验测试集的各个类别数量大多不相等,为了避免测试样本不均衡问题,选取测试集时将3种类别的肺炎图像数量设置相同。

由表6可知:文献[10]的准确率99.3%最高,本文算法94.9%次之;相较于文献[11] 和文献[12]运用Densnet201 和CNN的经典分类网络,本文算法的准确率分别提高了0.03和0.01,因此验证了本文模型对肺炎图像分类的可行性。此外,本文網络比其他13种网络在对肺炎图像分类方面的4个指标准确率、精度、召回率、F1度量均有一定的优势,因此本文提出的网络模型在进行肺炎图像分类具有一定的可靠性。最后,对测试集的3个测试类别进行样本均衡,获得约95%的准确率,说明模型具有较好的泛化能力和良好的鲁棒性。

3.4 显著性图实验

为了让人们直观理解深度学习是通过输入图片的哪些重要视觉特征进行分类判决,1987年,KOCH等引入显著性图来描述这些重要的视觉特征[23]。从一种角度来看,这是对模型的解释;从另一种角度来看,显著性图即输入图片的特征图,能够反映图像中的像素点对图像分类结果的影响[24]。显著性图的计算原理如下:设图片中的像素点为{x1,x2,…,xk},经过网络模型后的特征图记yk。若某个像素点k改变,改变的像素点为{x1,x2,…,xk+dx},输出特征图为y+dy,计算导数dy/dx,得到的值越大表示该点的显著性越强。

为了验证本文网络中CBAM对图像特征信息的关注度,在3种图像类别中随机选择一张肺部图像进行特征融合处理后的显著性图,如图7所示。在显著性图中,像素点越亮表示该点对于整个网络模型越具有吸引力,这对于网络模型针对不同的图像进行特征提取以及进行分类判决具有一定的帮助。对比融入CBAM和未融入CBAM的网络对应的显著性图,其像素点对分类结果的影响分布大致差不多。但是,通过对比显著性图中红框部分,无论是否融入CBAM,Normal、Viral pneumonia和COVID-19对应显著性图中重要特征点分布大致都在相同部位。值得注意的是,对于Viral pneumonia和COVID-19,添加了CBAM的网络对应的显著性图中红色框内的发亮的像素点比未加入CBAM的多,表明添加了CBAM的网络对肺部的关注度较为明显,也证明了CBAM注意到了该部分的显著特征。由此可见,并行双分支网络和注意力模块关注到了肺部X-ray图像有用的特征信息,从而提升了模型检测准确率。

在实际应用中,将该网络模型搭载小程序或网页,通过显著性图里的相关特征点可以辅助医生从视觉上关注该类别图像的特征信息,有助于医生临床诊断。

4 结论

本文提出了一种双分支肺炎图像分类网络,在卷积神经网络中融入CBAM加强特征提取,利用特征融合模块融合2个子分支提取的特征,采用Kaggle公开竞赛数据集进行实验,完成了对正常肺部、病毒性肺炎、新冠肺炎3类肺部X-ray图像的分类任务。该网络主要包括双分支网络(VGG16网络,卷积神经网络)、可分离卷积、CBAM和特征融合模块。通过在卷积神经网络不同层中添加注意力机制,使得注意力模块能够关注输入图像的深层特征信息并将这些信息进行不同维度的特征整合。验证结果显示:运用可分离卷积模块减少了运算量,加快了网络训练;特征提取和特征融合模块具有提高准确率的作用;同时,对测试集各类图像进行类别均衡,证明了该模型较强的泛化能力和较好的鲁棒性。本文网络对于当前深度学习作为医疗辅助手段诊断新冠肺炎具有一定的参考价值,在医院面临大量新冠肺炎患者的时候可以考虑运用分类网络作为框架搭载网页或小程序对疑似新冠的病人进行检测。

参考文献:

[1]YE Z, ZHANG Y, WANG Y, et al. Chest CT manifestations of new coronavirus disease 2019 (COVID-19): a pictorial review [J]. European Radiology, 2020, 30(8): 4381-4389.

[2] 宋瑶, 刘俊. 改进U-Net的新冠肺炎图像分割方法[J]. 计算机工程与应用, 2021, 57(19): 243-251.

[3] ICEK , ABDULKADIR A, LIENKAMP S S, et al. 3D U-Net: learning dense volumetric segmentation from sparse annotation[C]// 2016 International Conference on MEDICAL Image Computing and Computer-assisted Intervention. Cham: Springer, 2016: 424-432.

[4] 冉健雨. 基于深度學习的新冠肺炎X光片分类和可视化研究[D]. 河北: 燕山大学, 2021.

[5] ABDAR M, FAHAMI M A, CHAKRABARTI S, et al. BARF: a new direct and cross-based binary residual feature fusion with uncertainty-aware module for medical image classification[J]. Information Sciences, 2021, 577: 353-378.

[6] WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module[C]// 2018 Proceedings of the European Conference on Computer Vision (ECCV). Cham: Springer, 2018: 3-19.

[7] WANG S H, FERNANDES S, ZHU Z Q, et al. AVNC: attention-based VGG-style network for COVID-19 diagnosis by CBAM[J]. IEEE Sensors Journal, 2021, 22(18): 17431-17438.

[8] KALENICHENKO A G H M, ADAM W W T W, INC G. Mobilenets: efficient convolutional neural networks for mobile vision applications[DB/OL]. (2017-04-17)[2022-12-05].https://arxiv.org/abs/1704.04861v1.

[9] 张焕, 张庆, 于纪言. 激活函数的发展综述及其性质分析[J]. 西华大学学报(自然科学版), 2021, 40(4): 1-10.

[10]TOGAAR M, ERGEN B, CMERT Z. COVID-19 detection using deep learning models to exploit social mimic optimization and structured chest X-ray images using fuzzy color and stacking approaches[J]. Computers in Biology and Medicine, 2020, 121: 103805.1-103805.12.

[11]ELASNAOUI K, CHAWKI Y. Using X-ray images and deep learning for automated detection of coronavirus disease[J]. Journal of Biomolecular Structure and Dynamics, 2021, 39(10): 3615-3626.

[12]SARKI R, AHMED K, WANG H, et al. Automated detection of COVID-19 through convolutional neural network using chest X-ray images [J]. Plos One, 2022, 17(1): e0262052.1- e0262052.26.

[13]DE MOURA J, GARCA L R, VIDAL P F L, et al. Deep convolutional approaches for the analysis of COVID-19 using chest X-ray images from portable devices[J]. IEEE Access, 2020, 8: 195594-195607.

[14]ZHANG J P, XIE Y T, PANG G S, et al. Viral pneumonia screening on chest X-rays using confidence-aware anomaly detection [J]. IEEE Transactions On Medical Imaging, 2020, 40(3): 879-890.

[15]KHAN A I, SHAH J L, BHAT M M. CoroNet: a deep neural network for detection and diagnosis of COVID-19 from chest X-ray images[J]. Computer methods and programs in biomedicine, 2020, 196: 105581.1-105581.9.

[16]OZTURK T, TALO M, YILDIRIM E A, et al. Automated detection of COVID-19 cases using deep neural networks with X-ray images[J]. Computers in biology and medicine, 2020, 121: 103792.1-103792.11.

[17]MAHMUD T, RAHMAN M A, FATTAH S A. CovXNet: a multi-dilation convolutional neural network for automatic COVID-19 and other pneumonia detection from chest X-ray images with transferable multi-receptive feature optimization[J]. Computers in Biology and Medicine, 2020, 122: 103869.1-103869.10.

[18]MURUGAN R, GOEL T. E-DiCoNet: extreme learning machine based classifier for diagnosis of COVID-19 using deep convolutional network[J]. Journal of Ambient Intelligence and Humanized Computing, 2021, 12(9): 8887-8898.

[19]HEIDARI M, MIRNIAHARIKANDEHEI S, KHUZANI A Z, et al. Improving the performance of CNN to predict the likelihood of COVID-19 using chest X-ray images with preprocessing algorithms[J]. International Journal of Medical Informatics, 2020, 144: 104284.1-104284.9.

[20]RAHIMZADEH M, ATTAR A. A modified deep convolutional neural network for detecting COVID-19 and pneumonia from chest X-ray images based on the concatenation of Xception and ResNet50V2[J]. Informatics in Medicine Unlocked, 2020, 19: 100360.1-100360.9.

[21]PEREIRA R M, BERTOLINI D, TEIXEIRA L O, et al. COVID-19 identification in chest X-ray images on flat and hierarchical classification scenarios[J]. Computer methods and programs in biomedicine, 2020, 194: 105532.1-105532.18.

[22]CHANDRA T B, VERMA K, SINGH B K, et al. Coronavirus disease(COVID-19) detection in chest X-ray images using majority voting based classifier ensemble[J]. Expert Systems with Applications, 2021, 165: 113909.1-113909.13.

[23]KOCH C, ULLMAN S. Shifts in selective visual attention: towards the underlying neural circuitry[M]//Matters of Intelligence: Conceptual Structures in Cognitive Neuroscience. Dordrecht: Springer Netherlands, 1987: 115-141.

[24]HONG S, YOU T, KWAK S, et al. Online tracking by learning discriminative saliency map with convolutional neural network[C]// 2015 International conference on machine learning. New York: PMLR, 2015: 597-606.

(責任编辑:周晓南)

Double Branch Pneumonia Image Classification Network

Based on Attention Mechanism

ZHANG Jiyou, ZHANG Rongfen*, LIU Yuhong

(College of Big Data and Information Engineering, Guizhou University, Guiyang 550025, China)

Abstract:

At present, most pneumonia image classification networks use single branch network to extract features from input images, which to some extent ignores the feature information of different dimensions of images. In order to optimize this problem, this paper adopts double branch network with VGG16 network and convolutional neural network added separable convolution and CBAM for feature extraction respectively. The two networks can pay attention to feature information of pneumonia images at different dimensions. Then, the features of the two networks are fused and input into the full connection layer for classification decision. Experiments show that the network achieves 95% accuracy in the test set of normal lung, viral pneumonia and COVID-19 X-ray images. The ablation experiments prove that the feature fusion module and attention module added to the network play a significant role in reducing network parameters and improving the accuracy of network classification. The result by comparing the performance with other networks also shows that this network has higher accuracy and stronger robustness in pneumonia image classification.

Key words:

COVID-19; pneumonia image classification; attention mechanism; double branch network feature extraction and fusion