技术现象学视角下人工智能风险与治理研究

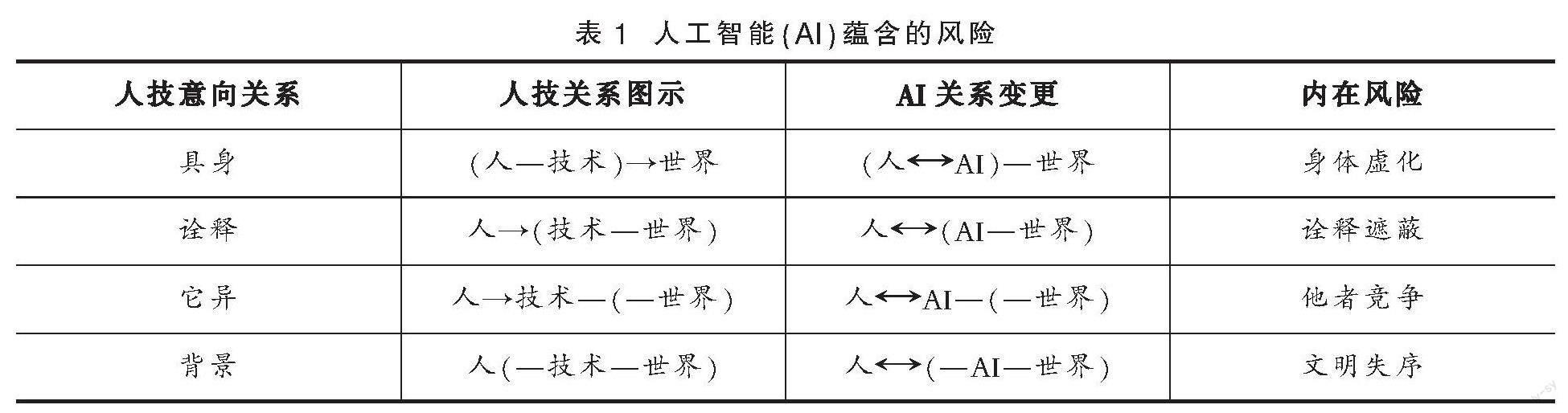

摘要:人工智能尤其是强人工智能使得人与技术之间呈现交互关系,技术现象学中具身、诠释、它异、背景这4种人—技术—世界的意向性关系发生着变更和异化,冲击了人作为技术主体的地位,同时蕴含着身体虚化、诠释遮蔽、他者竞争和文明失序的内在性风险。把握人—技术—世界中的意向性关系,成为人工智能风险治理的新思路、新视角,有助于完善人工智能技术治理、原则治理路径,促使善治良治成为机器行为学的内生品质。

关键词:人工智能;技术现象学;意向性;后人类主义

中图分类号:TP18;D63 文献标识码:A 文章编号:1003-1502(2024)02-0092-13

基金项目:国家社会科学基金项目“技术现象学视角下智能算法嵌入社会与治理研究”,项目编号:22BSH001。

作者简介:董向慧(1983—),男,天津社会科学院舆情研究所副研究员,北京师范大学新闻传播学院博士后。

ChatGPT、文心一言等大模型人工智能(Artificial Intelligence,简称AI)的应用推广使得2023年成为“强人工智能”元年。大模型人工智能的智识性、对人类语言环境和背景“主体间性”的理解,以及其集数据分析、程序写作等多重功能于一体,使得生成式人工智能、强人工智能成为学界和业界关注焦点。强人工智能的巨大进展不由得让人们重新审视雷·库兹韦尔在《奇点临近》一书中的预言,即2045年人工智能将在智识水平上超越人类,生物智能与非生物智能相互融合、人类智慧飞跃发展的奇点正在临近。而SpaceX创始人埃隆·马斯克更是将ChatGPT作为人类文明由碳基文明向硅基文明转向的起点,他认为人类社会只是超级数字智能的生物引导程序,人类存在的意义在于启动计算机。按照上述预言,科幻电影中的数字生命已不僅仅是虚构,而是将要到来的现实。在风险高度不确定的智能社会来临时,人类不仅要探讨人与人之间的相互关系与如何和谐相处,更要探索人机关系的和谐共生,从而避免现实和潜在的各种风险,这包括政治、经济、伦理、法律等风险,甚至是科幻作品中人工智能统治人类、人工智能毁灭人类的风险。而对人工智能风险的消解、预防和治理,从根本上依靠对人工智能这一技术深层逻辑的把握,以及对人工智能风险类型的有效区分。从技术现象学的视角看,人工智能使人—技术—世界中的意向关系产生了交互性。这使直接经验、直接体验的现实世界成为虚拟与现实共生的融合世界,唐·伊德所提出的具身、诠释、它异、背景4种意向关系产生了变更,从而产生了身体虚化、诠释遮蔽、他者竞争、文明失序4种风险。

一、人工智能的现实与潜在风险

人工智能先驱Donald Michie 将人工智能分为3类:弱人工智能、强人工智能和超人工智能。弱人工智能(专项人工智能)①指的是在某一领域模拟、代替人类智识的技术,如围棋机器人阿尔法狗;强人工智能也称之为通用人工智能,指具有比肩人类智识水平的智能技术,当下的聊天机器人ChatGPT已初步具备强人工智能特征;超人工智能则类似于科幻作品中,具有超越人类智识水平和意识能力的智能技术。作为异于人类且具有智识性的技术,人工智能自其问世起便引发公众和学界对其风险性的警惕和担忧。而伴随人工智能技术如智能传播、算法决策、人脸识别、自动驾驶等广泛应用,人工智能的现实和潜在风险也日益凸显。有研究将人工智能的风险归纳为10个方面:隐私泄露、劳动竞争、主体多元、边界模糊、能力溢出、惩罚无效、伦理冲突、暴力扩张、种群替代和文明异化[1]。上述风险部分是人工智能的现实风险,更多的则是潜在风险。从发展阶段来看,当前广泛应用的仍是弱人工智能技术,其现实风险已经出现。而随着ChatGPT等技术的发展,强人工智能潜在风险的可能性将会更为突出。

(一)弱人工智能的现实风险

弱人工智能(专项人工智能)在现实社会中已被广泛应用,如人脸识别、自动驾驶、智能新闻推送、算法决策等。而从国内外弱人工智能的现实风险来看,主要集中在匹配式人工智能算法加剧了社会偏见、群体歧视,使财富、数字鸿沟扩大。匹配式人工智能主要基于数据挖掘和分析建立算法模型,为用户、商品、信息、服务打上具有相关性的“标签”。基于算法模型和标签的复杂相关性,匹配式人工智能可进行数据、信息和用户之间的高效链接、推送、画像,其应用场景包括人工智能决策、智能新闻推送等,常见的应用程序如抖音、今日头条等。

匹配式人工智能基于算法模型和标签将数据、金钱、商品、服务、信息进行链接、推送,其现实风险主要来自两个方面。一方面,算法决策使个人、群体在智能决策系统中处于被支配地位,存在着“黑箱操作”、系统性歧视的风险,包括抹杀个体获取资源的机会、算法歧视和边缘化群体、动摇社会赖以生存的道德政治基础[2]等。另一方面,算法推荐尤其是智能新闻推荐存在着“信息茧房”②“群体极化”③等效应,可固化不同群体的偏见,加剧社会中的认知冲突。凯西·奥尼尔将算法称之为“数学杀伤性武器”,这些系统正日益在更大程度上操控着我们的生活,数学模型像上帝一样晦暗不明,人们对模型结论无法上诉,而这一结论往往会惩罚社会中的穷人[3]。简而言之,弱人工智能的风险集中在匹配式人工智能领域,其风险主要为现有社会财富、阶层、认知差距的固化与扩大化,且掌握和使用人工智能数据、算法的多为大型企业、政府机构,这使得数字极权、数字垄断、数字剥削加剧的风险大幅提升。

(二)强人工智能的潜在风险

如果说弱人工智能的现实风险是区域性、局部性的,强人工智能的潜在风险则具有根本性和系统性。强人工智能具有类比人类智识水平和解决问题的能力,其关涉到人类的主体地位和生存发展,对人类社会的哲学、伦理、政治、经济、文化、社会等领域都是空前的冲击和挑战。正如尤瓦尔·赫拉利在《未来简史——从智人到智神》中所预言,智能算法将多数人从就业市场排挤出去,少数垄断算法和数据的人成为“智神”,造成前所未有的社会与政治不平等[4]299。

当下,强人工智能处于起步和萌芽阶段,其风险性仍处于潜在阶段。已经发布的ChatGPT-4具有语言模型的多模态特征,能够同时生成文本、图像和视频。而绘画人工智能Midjourney则可以媲美甚至超越人类画师、摄影师。多模态语言模型的出现意味着人工智能可同时完成电影、音乐、文学作品的创作。这将对整个知识产权创作领域产生颠覆性的影响。而随着应用场景的丰富和创新,其对于就业市场、价值观等领域的影响尤为深远。譬如,强人工智能可代替数以万计的文化产业从业者,可瞬间生成具有特定价值观倾向的电影、电视剧等文化产品,这无疑蕴含着结构性失业、社会群体认知冲突等巨大风险。强人工智能的潜在系统性、根本性风险可见一斑。

伴随强人工智能的深度学习训练和模型完善,其将广泛应用于人类生产、生活的各个领域。ChatGPT所显现的强人工智能的系统性和复杂性风险只是“冰山一角”,科幻作品中人工智能驯化、控制甚至毁灭人类的风险并非杞人忧天。正如有的研究提出的“人工智能巨风险”概念,“巨风险”包括机器自涉式巨风险、社会系统侵入式巨风险、非对称破坏式巨风险等[5]。可以预见的是,随着人工智能接近、超越人类智慧的“奇点”临近,人工智能的风险性也将变得尤为突出。如果说弱人工智能风险的核心问题仍是人与人和谐相处,强人工智能风险的核心问题则是人与机器的良性共生。

综上所述,弱人工智能的风险具有区域性、局部性,其现实风险是可控的。强人工智能的风险则具有根本性、系统性,其潜在风险对人类社会带有颠覆性。已有研究就人工智能的现实、潜在风险进行了多维和丰富的阐述。但这些研究对人工智能的现实与潜在风险类型的划分仍存在模糊之处,且未将现实与潜在风险纳入统一的理论框架之内,只是从主体维度、时限维度对人工智能风险进行了类型划分,但这一划分更多是描述性的[6]。而通过引入和借鉴技术现象学理论视角,可将人工智能不同类型的风险特性纳入完整的理论框架之内,从而解释人工智能风险的内在逻辑关系,提升预防和治理人工智能风险的水平。

二、技术现象学视角下人工智能风险

技术现象学由美国学者唐·伊德于20世纪八九十年代提出。唐·伊德借鉴现象学中的核心概念“意向性”,吸纳了梅洛-庞蒂的知觉现象学、海德格尔存在现象学对技术的重视,立足美国实用主义哲学的土壤,创造性地提出了技术现象学理论。由于技术现象学对经验、技术和身体的重视,它也被称为经验主义现象学、实用主义现象学或后现象学。唐·伊德认为,技术是人的意向性延伸,是人与世界关系的连接物。人—技术—世界关系是一种经验的意向性关系。围绕这一意向性关系,唐·伊德提出了具身、诠释、它异、背景4种人与技术的关系。具身关系的意向性表示为(人—技术)→世界,技术成为人的身体知觉的延伸,如眼镜、电话;诠释关系的意向性表示为人→(技术—世界),人借助技术来解释和解读世界,如温度计之类的测量仪器;它异关系的意向性表示为人→技术—(—世界),技术作为他者与人产生互动作用关系,如机器人;背景关系的意向性表示为人(—技术—世界),技术成为人生存、生活的背景和庇护所,如核潜艇[7]。

随着互联网信息技术对人类社会广泛和深远的影响,唐·伊德提出的4种技术现象学关系得到技术哲学研究者的关注和拓展。技术现象学也深受海德格尔的影响,其所引用的技术多为工具性、单一维度技术,如望远镜、锤子、眼镜等。随着互联网信息技术以及交互性、融合性技术的发展,学者结合新技术进一步丰富了上述4种关系。譬如,荷兰学者维贝克发展了技术意向性概念,提出了复合关系和赛博格关系。复合关系指的是人的意向性朝向技术意向性的后果,如智能传播算法推荐产生的“信息茧房”效应。赛博格关系则是人与机器相互融合、边界模糊的意向关系。复合关系是对具身关系的发展,赛博格关系是对解释学关系和他者的发展[8]。而学者Best吸纳了传播学领域的“拟态环境”概念,将唐·伊德提出的4种人技意向关系替换为人与媒介的4种关系,包括(人—媒介)—媒介世界形成的具身关系;人—(媒介—媒介世界)形成的诠释关系;人—(媒介)媒介世界形成的背景关系;人—媒介(媒介世界)形成的它异关系[9]。此外,还有学者提出了人—技术—(技术—世界)的连接关系,(人—技术—世界)—世界的情境关系[10]。

已有研究对唐·伊德4种人技意向关系的发展凸显了这一技术现象学理论的张力和解释力,而交互性、沉浸性技术的发展则为技术现象学的边界拓展提供了丰富素材。在唐·伊德提出的具身、诠释、它异、背景关系中,人是技术的主体,人与技术的意向性指向世界。就人工智能技术而言,其不仅具有交互性、沉浸性,更主要的是其具有智识性。也就是说,人工智能使得人与技术之间呈现交互关系,人工智能既是人探索和拓展世界边界的延伸,也反过来影响着人和社会的多个维度。正因为人工智能的智识性使其在人—技术—世界的意向性关系中发挥着中介性作用[11],因而唐·伊德提出的人—技术—世界的意向性关系发生了变更和异化,冲击了人作为技术主体的地位,同时蕴含着身体虚化、诠释遮蔽、他者竞争和文明失序的内在性风险(见表1)。

(一)具身关系的技术身体扩张与身体虚化

在唐·伊德看来,具身关系中技术具有了最大程度的“透明性”,这种透明性使得技术好像融入身体自身的知觉的经验中[7]。眼镜、锤子等技术是唐·伊德解释具身关系的例证,眼镜是视觉的延伸,锤子“上手”的状态则是肢体的延伸。需要指出的是,眼镜、锤子都是单向度的技术,是受身体支配的技术。而针对赛博空间、虚拟现实等身体“不在场”技术,唐·伊德提出了“三个身体”理论。身体一,即肉身的物质身体,具有运动感、知觉性和情绪性;身体二,社会文化意义上文化的身体,如文化、性别、政治等;身体三,技术或技术化人工物为中介建立的技术身体存在物[8]。

人工智能技术尤其是媒介技术的使用,使得(人■AI)—世界所形成的具身关系中,技术身体急剧扩张,而物质身体、文化身体不断萎缩。一方面,通过虚拟现实技术、视频通信技术,人们以物质身体“不在场”的方式认知世界、开展社会活动,智能传播、智能算法将信息、观念植入人的身体。技术身体代替甚至超越物质身体在影响和建构着文化身体。物质身体、文化身体的缺位,技术身体过度扩张使得智能社会的人类缺少传统社会的直观体验、生活体验和情绪体验。另一方面,各种可穿戴智能健康监测仪器全面“入侵”物质身体,将人类的身体和健康状况数据化、信息化,并不断给出建议和预警。这种“量化自我”从内在消解人的自主性,人类不会再认为自己是自主的个体,而是习惯把人类整体看做一种生化机制的集合体,由电子算法网络实时监测和指挥[4]。物质身体的“不在场”和 “全景监控”使得智能时代人的身体结构改变,技術身体急剧扩张,物质身体持续萎缩,文化身体则被智能传播和虚拟传播技术“植入”。随着强人工智能技术的发展和虚拟技术的仿真性,人类的身体将被人工智能技术形塑、监测甚至规训,这种身体虚化的风险将从根本上动摇人的主体性和能动性。

(二)诠释关系中的技术解蔽与遮蔽

具身关系、诠释关系统一被唐·伊德统称为“中介关系”。诠释关系中,技术是人解读世界的符号中介、符号转译,譬如航海图、温度计等。诠释学作为一种技术情境中的特殊的解释活动,这种活动需要一种特殊的行为和知觉模式,类似于阅读的过程[7]。与具身关系的知觉“透明性”相比,诠释关系则侧重于文本“透明性”。在诠释关系中,人借助于符号、技术来诠释和理解世界。从诠释关系的角度而言,文字、图片通过互联网信息技术的迅速传播,极大扩展了诠释关系。而人工智能技术的加入,则使人→(技术—世界)的关系变更为人■(AI—世界)。也就是说,一方面,人通过智能技术获取符号来诠释世界;另一方面,智能技术也通过人的诠释行为诠释人。这种“凝视深渊,深渊也报以回望”的效应,恰是发生在人工智能技术中的诠释关系,比较典型的例子是各种智能信息推荐算法。譬如,智能新闻软件能够根据用户的阅读习惯和浏览路径来为其“画像”,从而推送与用户个体心理、品位、使用场景相匹配的信息。这种智能信息推送在帮助用户诠释世界的同时,也在强化和固化用户的价值观,形成“信息茧房”效应。可以说,人工智能技术中的诠释关系既是一种解蔽,同时也是一种遮蔽,形成认知的刻板印象与认知鸿沟。而随着强人工智能时代的到来,技术遮蔽的风险性显著提升了。首先,人工智能可遮蔽人的求知与创新能力。人工智能可以编写程序、制作图片、撰写论文、知识问答,在几秒钟的时间内完成人类需要长时段的学习与训练过程,这意味着人类的求知与思考过程可被替代、省略,从而遮蔽人类的学习与创新能力。其次,强人工智能的遮蔽还体现在价值观层面。有研究表明,ChatGPT的价值观偏向美国左翼政治观。ChatGPT多模态文本的生成能力,可以使其作品全部体现某种特定价值观。因而,人工智能的遮蔽风险使特定的文化、价值观被筛选、过滤、边缘化,这种风险已悄然来临。

(三)它异关系中的竞争与替代风险

在它异关系中,技术成为人的互动者,作为与“我”随时随地打交道的前景和准他者出现。唐·伊德已然认识到人工智能的它异性,但认为智能机器人是一种准他者。计算机是一个它异关系技术很好的例子。但是计算机的它者性是一种准他者性,它的真正用处还在于它的诠释学能力[7]。而随着人工智能技术的发展尤其是强人工智能技术的临近,人工智能与人的它异关系已逐渐成为现实。正如赫拉利所提出的“无用阶级”④,在机器与人类的竞争仅限于身体能力时,人类还有数不尽的认知任务有待完成,一旦算法在记忆、分析和辨识各种模式的能力上超过人类,会发生什么事尚无法预料[4]。

人工智能与人的它异关系,使人与人工智能处于竞争和替代的风险博弈中。首先,人工智能在就业市场中与人存在竞争关系。人工智能应用会导致经济增长过程中出现日益突出的资本替代劳动的趋势,企业具有内在的过度自动化激励,这会导致严重的失业问题[12]。而人工智能在就业市场对人类的挤出效应,则比想象中来得要快。人工智能要把人类挤出就业市场,只要在特定行业需要的特定能力上超越人类,就已足够[4]。随着ChatGPT-4的发布,其强大的文字、图像和知识生成能力引发争论,即人工智能可在很大程度上替代职场“白领”包括律师的工作。

其次,人工智能的智识水平与人越来越趋近,不仅在就业市场上与人类存在竞争风险,在情感和社会关系中也存在着替代风险。人工智能对语言背景、主体间性的理解,使其与人对话沟通更趋向真实性。ChatGPT4已经能读懂图片、理解搞笑图片的“梗”。当下,人工智能的交互性、主体间性与元宇宙、虚拟现实的结合将是趋势。在这一背景下,人類与人工智能人物、数字人物进行互动、成为伴侣都将成为现实。在虚实相间的数字世界中,人工智能人物、数字人物将会比人类更能理解、同情人类,也就是说,人工智能不仅能提供智识价值,还能够提供情绪价值。因而,人与人工智能的关系可能比人与人的关系更为亲密、紧密。人与人工智能的它异关系已由科幻作品来到现实,两者之间的竞争、替代风险性也将越来越高。

(四)背景关系中的文明失序风险

在唐·伊德提出的背景关系中,技术作为一种不在场的显现,成为人的经验领域的一部分和当下环境的共同组成部分,如庇护技术、太空站。背景技术起到场域的作用,却调节着生活情境[7]111-112。在背景关系中,技术如同空气和WIFI一样,发挥着场域和情境的功能,只有在其缺失或损坏的条件下才显示出重要性。当下,强人工智能、通用型人工智能技术的背景功能已经出现,以ChatGPT为例,它已可以接入办公软件、绘图软件、视频软件。而随着人工智能场景的丰富,ChatGPT接入机器人、汽车、手机以及各种可穿戴设备已不存在技术障碍。可以说,类似ChatGPT的强人工智能技术将“植入”各类智能软件、智能设备。届时,人工智能技术则像空气和水一样,成为人类世界的“背景”和基础设置。

当人工智能技术成为人类世界的“背景”,人类文明则时刻处于失序、失控的风险之中。首先,文明失序的风险来自人类自身。一方面,掌握和控制人工智能技术的精英、资本具有了操控世界秩序的能力,人类在生物学意义上分为了控制者和服从者;另一方面,人工智能技术的普及使“独狼式黑客”、网络极端分子破坏世界秩序和毁灭人类的便利性、可能性极大提升。其次,文明失序的风险来自人工智能的巨大能力。具有智识、意识的人工智能有可能统治和操控人类,也有可能仅仅是为了自身进化而产生毁灭人类的后果。有学者提出警告,一旦人工智能超越人类智能,可能就会直接消灭人类:一是可能担心人类反扑、拔掉它的插头;二是要追求某种难以想象的目标[4]。而对于人工智能技术成为世界的背景,雷·库兹韦尔则给出了偏向乐观的预测。他认为,人类与强人工智能的结合将带来人类智慧的突破性增长,未来人类将用智能充满宇宙中的物质和能量,使宇宙觉醒并成为智能世界的一部分[13]。无论是悲观还是乐观的预测,当人工智能尤其是强人工智能遍布人类世界,人类文明社会面临着失序、失控的风险将在理论层面成为可能。

三、人工智能的意向性与机器行为学

唐·伊德在其技术现象学理论中对于人工智能技术给予了高度关注。虚构的仿制人和机器人几乎是人类的完美复制品,这种构想中的实体甚至比现实的技术更具有它异性。如果我们发明的东西,能够事实上等同于或者超越我们自己,这会有什么结果呢[7]。而对于将整个世界纳入人类技术改造的视域,唐·伊德称之为技术总体化,且持有忧虑态度:“高技术文化的兴起和变成一种世界文化的路径是不是独一无二的呢?如果是的话,那么,马尔库塞、约纳斯和埃吕尔将成为我们时代的预言家[7]。毫无疑问,人工智能技术是未来世界发展的趋势。当人工智能技术使人类社会、地球乃至宇宙数据化、信息化,人类的未来走向和前景将如何呢?

在技术现象学的具身、诠释、它异和背景4种关系中,人工智能技术的引入使得每种关系都具有了交互性和风险性。这种风险性不同于锤子可以作为武器的风险,或者眼镜存在着损坏的风险,人工智能的风险性来自其在人与世界关系中的交互性和意向性。换而言之,人工智能交互性带来的风险性是高度“透明”的,甚至是作为人类思想和意识的一部分而“植入”的,每一种风险性都以自我意志的方式体现。在具身关系中,人工智能使技术身体急剧扩张和膨胀,物质身体、文化身体被技术身体所塑造,身体虚化、数字化和信息化直接关涉到人的主体性和能动性,极端的情况便如同电影《黑客帝国》中处于“矩阵”而不自知的人类。在诠释关系中,人工智能与人处于一种交互诠释关系,人工智能在解蔽的同时也有着遮蔽的风险性,人的价值观、创新能力、学习能力都存在蜕化的风险。它异关系中,人工智能在就业市场是人类强有力的竞争者,这一竞争关系甚至会扩展到家庭、社会生活,人工智能代替人成为伴侣和亲人,与之相关的道德与伦理规则将如何建构?而背景关系中,人工智能则关涉到人类文明的前途和方向,一个基于总体式、整体性人工智能的世界则处于精英和超人工智能垄断及失控的风险中。

基于人工智能意向性的风险思考,能够为人工智能治理提供新的思路。已有的人工智能风险治理主要有技术治理、原则治理两种路径。前者注重智能算法的优化、数据的完整性、智能技术的改善等;后者注重从立法、伦理等方面规制人工智能的可能风险。而从技术现象学意向性视角对人工智能风险的分析,能够为人工智能风险治理提供新的视角。麻省理工学院媒体实验室的学者在《自然》杂志发表的《机器行为学》一文中提出,了解人工智能体的行为和性质,以及它们可能对人类系统产生的影响是至关重要的,有必要成立专门的机器行为学学科[14]。基于技术现象学的角度,揭示人工智能技术存在的4种意向关系风险,这对机器行为学的研究具有较多价值。技术现象学、现象学的重要概念如“意向性”“悬置”“生活世界”等对人工智能底层逻辑的理解有诸多启发。人工智能有着智识性,但是尚不具有意识。如何限制、规训人工智能的意向性则成为机器行为学的重要方向。而人工智能在多大程度上能够学习人类“生活世界”的常识则成为机器学习的重要边界。同时,如何从人—技术—世界的意向性关系中规避人工智能的身体虚化、诠释遮蔽、他者竞争和文明失序的风险则成为机器行为学的重要内容。而从意向性关系出发,则能够有效整合人工智能技术治理、原则治理,使善治良治成为机器行为学的内生品质。

四、人工智能风险治理的新思路

限制、规训人工智能的意向性风险成为人工智能治理的新视角、新思路。也就是说,人工智能的风险治理不仅要糅合技术治理、原则治理,还要重视人工智能的发展领域、方向和重点。针对身体虚化、诠释遮蔽、他者竞争和文明失序的内在性风险,人工智能的治理思路也需要相應完善。

首先,人工智能应将重点转向知觉身体、文化身体的强化,而非侧重信息传播的技术身体,从而克服其身体虚化和消解人的能动性风险。一方面,在知觉身体方面,可引导人工智能广泛应用于身体功能的增强和延伸,尤其是针对身体缺陷的弥补。譬如,运用人工智能技术帮助听障人士“听到”声音,帮助视障人士“看见”世界。当下,借助“外骨骼机器人”的辅助,高位截瘫患者可以抬腿、行走、上下楼梯。人工智能对于身体功能的增强、改善,则能够实现人类自身福祉的发展,平衡知觉身体、文化身体与技术身体的关系,建立统一的身体认知,避免虚化身体、能动性消解等风险扩大。另一方面,在文化身体方面,人工智能技术尤其是智能传播技术应促进人类文化和历史知识的传播。譬如,在智能推荐算法技术中,给予历史和人文主题的内容更多权重和流量,支持垂直领域内容生产者。正如尼尔·波兹曼建议:所有的课程都作为人类历史发展的一个阶段来传授;科学、历史、语言、技术和宗教的理论都要讲[15]。通过人工智能技术的“赋能”,人类将建立更加完善、健全的文化身体,既可以促进同一文化的“各美其美”,又可以推动不同文化的“美美与共”。

其次,技术被海德格尔定义为一种解蔽方式。但由人工智能主导的传播技术,存在着局部解蔽、总体遮蔽的效应。譬如,ChatGPT等人工智能技术将特定的世界观、价值观、文明观以算法推荐的形式“植入”用户。人工智能尤其是生成式人工智能的价值倾向是由其获取数据倾向决定的,而人类社会生产的数据背后必然蕴含着特定文化与价值观。鉴于此,应从意识形态安全和文化安全的高度重视人工智能技术尤其是生成式人工智能技术。我国出台的《生成式人工智能服务管理办法》明确提出:利用生成式人工智能生成的内容应当体现社会主义核心价值观。在未来人工智能的发展中,应支持和鼓励彰显中国气派的类ChatGPT人工智能,将中国文化、中国话语嵌入在人工智能技术中。要善于运用生成式人工智能开展中华文明海外传播,提升中华文明海外网络传播力、影响力。同时,针对人工智能的诠释遮蔽风险,还需要将其应用场景重点转向自然科学领域。既要创新人工智能+教育产品,辅助人类更便利、快速掌握自然科学知识,还要借助人工智能克服人类观测的局限性,辅助人类探究自然世界的普遍规律,在物理学、数学、生物学等领域突破人类智慧的上限,拓展人类智慧的边界,从而真正实现其解蔽功能。

再次,针对人工智能在就业市场、情感关系中的他者竞争风险,应加强科技伦理监管,建立和谐的人机关系。一方面,人工智能对就业市场的竞争力已初步显现。西方社会人工智能对人类就业产生的“他者竞争”,背后是资本与科技的牢固联盟。而对“他者竞争”风险,应探索以问题为导向的法律法规,避免资本对劳动力形成过大优势,建立和谐劳资关系。譬如,我国就网约车、快递服务等智能算法驱动的新形态就业,从倡导算法向善、建立工会组织、提供职业伤害保障等方面开展了有效治理。同时,随着人工智能技术的发展,人形机器人对就业市场的冲击将会日益显著,而这需要探索科技、产业与人才之间的良性共生关系。工信部发布的《人形机器人创新发展指导意见》提出,形成“科技—产业—金融”良性循环,促进技术创新与科技伦理协调发展。随着人形机器人等产业的发展,建设科技、资本与劳动力的良性循环、和谐关系,则成为人工智能他者竞争风险治理的必经之路。另一方面,人工智能、人形机器人正在进入人们的生活,为人类提供服务、陪伴乃至情感支持,建立和谐的人机关系则成为迫切问题。就此,应明确家庭、婚姻制度是人类社会的伦理基础,人工智能不能取代和替代人的角色、情感和价值。有研究提出,机器人可以造福于老年人的生活,但对于机器人参与儿童的社交、教育则要持审慎态度。必须确保个人获得的福利大于机器人侵犯其权利造成的损失[16]。因而,对于生活服务领域的人工智能应用,应充分评估其受益与情感、权利、伦理侵犯的利弊得失,使他者竞争的风险转化为技术伴侣的福利。

最后,强人工智能广泛介入人类社会存在着“文明失序”的风险,这不得不使我们反思人工智能发展的方向与路径。2023年3月,图灵奖得主约书亚·本吉奥等科技界名人联名签署了一封公开信,发表在“未来生命研究所”网站上,呼吁暂停开发比ChatGPT-4更强大的AI系统至少6个月,称其“对社会和人类构成潜在风险”。而埃隆·马斯克2023年4月宣布,准备启动“TruthGPT”的人工智能开发,最大程度寻求真理并理解宇宙本质。无论是暂停更强大人工智能的训练还是开发“寻求真理与理解宇宙本质”的人工智能,都揭示了这样一个观点:强人工智能发展存在着“文明失序”的风险,即对人类文明存在着不可估量风险;而对于强人工智能,技术治理、原则治理都很难根除其系统性风险。目前,欧盟探索出台《人工智能法案》,欧洲议会已通过该法案的谈判授权草案。授权草案基于人工智能的风险程度(不可接受风险、高风险、有限风险和最小风险)进行分类管理,严格禁止开发“对人类安全造成不可接受风险的人工智能系统”。我国也发布了《关于加强科技伦理治理的意见》,明确提出要敏捷治理⑤,加强科技伦理风险预警与跟踪研判,及时动态调整治理方式和伦理规范。

从技术现象学的视角来看,人工智能的“文明失序”风险已然有所显现,强监管则成为必然趋势。基于风险分级和审慎发展的思路,现有的通用型人工智能未必是其唯一发展方向,而传统的资本驱动、技术扩张的路径也未必是人工智能发展的唯一商业模式。因为通用型、商业扩张路径的强人工智能意味着系统性风险的叠加共振和风险失控,从根本上挑战国家安全和人类生存。早在20世纪六七十年代,图灵奖、诺贝尔经济学奖获得者赫伯特·A.西蒙在其《人工智能科学》一书中就提出,人工智能应重视通过反馈回路来进行系统调节,而不是通过集中系统或直接机构来调节。潘卡基·马斯卡拉认为,我们应该鼓励竞争性的、分布式的人工智能,且有足够的保护措施避免算法失控或不法分子控制人工智能系统[17]。正如英国学者杰米·萨斯坎德在《算法的力量:人类如何共同生存》中所言,某一平台控制了某领域所有的感知控制设备,那么其塑造人类行为的能力也将是人类无法承受之重[18]。因而,类似ChatGPT的通用型、商业化人工智能将存在着发展的瓶颈和弱点。鉴于此,分散型、分布式的专项人工智能更符合人类社会的长远福祉,也就是说,“小而美”而非“大而全”的专项人工智能更能平衡风险性、智识性的关系,符合人工智能与人类和谐关系的建构,而要实现这一目标,则需要建立通用型人工智能的良好生态。一方面,应鼓励和支持开源生成式AI模型(如StableLM)与闭源生成式AI模型(如ChatGPT)之间进行充分竞争,保持人工智能的透明性和分散性,防止少数科技公司垄断人工智能技术。另一方面,则要规范和限制人工智能的应用领域,使其服务于增进人类福祉而非攻击性、破坏性领域。同时,还应在不同领域的人工智能应用服务中建立“防火墙”制度,保持其“小而美”技术风格。

五、结语

人工智能时代,应确立以风险预防为核心的价值目标,构建以伦理为先导、技术和法律为主导的风险控制规范体系[19]。从技术现象学的视角,如何治理身体虚化、诠释遮蔽、他者競争、文明失序的风险为人工智能发展的方向、领域提供了新的思路。正如“日心说”引发人类宇宙观和社会思想的重大变革,强人工智能也带给人类前所未有的挑战和震撼。当人工智能接近人类的智识水平、人类和宇宙被视为数据和信息的结合体、作为碳基的人类与作为硅基的人工智能互相链接,人类便进入了后人类时代。正如海瑟琳·海勒所言:在后人类看来,身体性存在与计算机仿真之间、人机关系结构与生物组织之间、机器人科技与人类目标之间,并没有本质的不同或者绝对的界限。后人类的主体是一种混合物,一种各种异质、异源成分的集合,一个物质—信息的独立实体,持续不断地建构并且重建自己的边界[20]。在后人类时代,人机关系的和谐共处、碳基文明与硅基文明如何融合远远超越机器行为学的研究范围。因而,站在后人类时代的视野开展机器行为学的研究则更具价值,而技术现象学对人类意识、意向和思维本质的揭示则尤其具有诸多启发意义。

注释:

①雷·库兹韦尔在《奇点临近:2045年,当计算机智能超越人类》一书中也将“专项人工智能”称之为狭窄人工智能。

②信息茧房:由哈佛大学法学院教授凯斯·桑斯坦在其2006年出版的著作《信息乌托邦:众人如何生产知识》中提出的,在信息传播中,因公众本身的信息需求并非全方位的,公众只注意自己选择的东西和使自己愉悦的信息领域,久而久之,会将自身桎梏于像蚕茧一样的“茧房”中。

③群体极化:社会心理学术语,最早由媒体学者詹姆斯·斯托纳于1961年发现群体讨论时的现象而提出的,在一个组织群体中,个人决策同时受群体的影响,容易做出比独自一人决策时更极端的决定,从而背离最佳决策。

④无用阶级:《未来简史——从智人到智神》一书作者尤瓦尔·赫拉利认为2050年会出现“无用阶级”,即西方国家有劳动能力者无法就业,依靠着社会福利生存。

⑤敏捷治理:作为公共管理研究领域的一种创新理论,其所追求的快速、灵活,共同参与等理念和方法,为创新与监管之间的弹性平衡提供了新的理念与工具。

参考文献:

[1] 何哲.人工智能技术的社会风险与治理[J].电子政务,2020(9).

[2]凯伦·杨,马丁·洛奇.驯服算法:数字歧视与算法规制[M]. 林少伟,唐林垚,译.上海:上海人民出版社,2020.

[3]凯西·奥尼尔.算法霸权:数字杀伤性武器的威胁[M].马青玲,译.北京:中信出版社,2018.

[4]尤瓦尔·赫拉利.未来简史——从智人到智神[M]. 林俊宏,译.北京:中信出版社,2017.

[5]王彦雨,雍熙,高芳.人工智能巨风险研究:形成机制、路径及未来治理[J].自然辩证法研究,2023(1).

[6]梅立润.人工智能到底存在什么风险:一种类型学的划分[J].吉首大学学报(社会科学版),2020(2).

[7]唐·伊德.技术与生活世界——从伊甸园到尘世[M].韩连庆,译.北京:北京大学出版社,2012.

[8] 杨庆峰.翱翔的信天翁——唐·伊德技术现象学研究[M].北京:中国社会科学出版社,2015.

[9]BEST KIRSTY. Redefining the Technology of Media:Actor, World, Relation[J]. Techné, 2010, 14(2).

[10] 董浩.技术现象学视域下人与媒介的关系省思及认识方法补阙[J].新闻与传播评论,2020(1).

[11] 彭兰.生存、认知、关系:算法将如何改变我们[J].新闻界,2021(3).

[12]DARON ACEMOGLU, RESTREPO PASCUAL. Robots and Jobs: Evidence from US Labor Markets[J]. Journal of Political Economy, 2020(6).

[13]RAY KURZWEIL.奇点临近:2045年,当计算机智能超越人类[M].李慶诚,董振华,田源,译.北京:机械工业出版社,2011.

[14]RAHWAN IYAD, CEBRIAN MAUNEL, OBRADOVICH NICK, et al.Machine behaviour[J].Nature,2019(7753).

[15]尼尔·波斯曼.技术垄断——文化向技术投降[M].何道宽,译.北京:中信出版社,2019:222.

[16]帕特里克·林.机器人伦理学[M].薛少华,仵婷,译.北京:人民邮电出版社,2021.

[17]赫伯特·A.西蒙.人工智能科学[M].陈耿宣,陈桓亘,译.北京:中国人民大学出版社,2023.

[18]杰米·萨斯坎德.算法的力量:人类如何共同生存?[M].李大白,译.北京:北京日报出版社,2022.

[19]张成岗.人工智能时代:技术发展、风险挑战与秩序重构[J].南京社会科学,2018(5).

[20]凯瑟琳·海勒.我们何以成为后人类——文学、信息科学和控制论中的虚拟身体[M].刘宇清,译.北京:北京大学出版社,2017.

Research on Artificial Intelligence Risks and Governance from the Perspective of Technological Phenomenology

DONG Xianghui

Abstract: Artificial intelligence, especially strong artificial intelligence, sparks an interactive relationship between human and technology. The four intentional relationships of embodiment, interpretation, otherness, and backgrounding among human, technology and the world in technological phenomenology have undergone changes and alienation, impacting the status of human as the subject of technology. At the same time, it contains inherent risks of body emptiness, interpretation obscuration, competition from others, and civilization disorder. Grasping the intentional relationship among human, technology and the world has become a new approach and perspective for risk management in artificial intelligence, which helps to improve the governance path of artificial intelligence technology and principles, and promotes good governance to become an endogenous quality of machine behavior.

Key words: artificial intelligence; technological phenomenology; intentionality; post humanism

责任编辑:邓 喆