自动写作评阅反馈系统研究述评与展望

张 荔 Mark Warschauer 盛 越

(上海交通大学,上海,200240;University of California,Irvine,CA 92697;上海工程技术大学,上海,201620)

自动写作评阅反馈系统研究述评与展望

张 荔 Mark Warschauer 盛 越

(上海交通大学,上海,200240;University of California,Irvine,CA 92697;上海工程技术大学,上海,201620)

文章论述了PEG、IEA、IntelliMetric、e-rater、BETSY这五种具有代表性的自动作文评阅(AES)系统的原理、特征、功能、优缺点,分析比较其共性和差异,论证其发展过程,总结和展望未来发展的若干特点:设计有助于提高学习者认知能力和辩证性思维能力的AES系统;评判重点从语言和结构转向论点思辨和修辞效果;能够对各种文体类型的作文进行评定;开发对写作过程提供形成性评估的AES系统;利用机器学习技术,设计开放式AES系统平台;开发和利用可进行人机对话的反馈模式;交叉学科的合作在系统发展中的作用将更为突出;逐步建立对多种语言的评分反馈功能。

自动作文评分,评分原理要素,自然语言处理,认知思维能力

1.引言

计算机技术的不断进步使科技在测试和教学领域中的应用越发深入与广泛,其中一个重要的应用是自动作文评分系统(AES-Automated Essay Scoring)或自动作文评阅系统(AWE-Automated Writing Evaluation)①的开发和应用。这不仅有利于高风险、大规模测试中增加评分的信效度,还有助于写作教学中给予即时反馈和减轻教师作文评阅负担。比较有代表性的AES系统有PEG(Project Essay Grader)、IEA(Intelligent Essay Assessor)、e-rater(及Criterion②)、IntelliMetric(及MY Access!③)和BETSY (Bayesian Essay Test Scoring sYstem)。人们对系统开发和应用展开了大量研究(如 Attali 2015; Chapelleet al.2015;Warschauer 2006,2008,2014),随着人工智能和自然语言处理技术的不断推进,AES必将产生新的发展。然而,通过分析系统及写作模式的变化发展来推测AES未来发展趋势的研究还没有。因此,本研究将分别论述各系统的原理、特征、功能、优缺点等,揭示系统的共同特征,比较其差异,论证其发展过程,总结和展望该领域未来发展的方向。

2.不同时期典型AES系统的特征与优缺点

上述AES系统在整个AES系统发展过程中比较具有代表性,每种系统有其特征与优缺点,也有其共性和个性。这些系统的发展并不是一个静态的过程,多数系统经过逐步发展不断完善,至今仍然在测试和教学领域中得到广泛应用。

2.1 PEG

最早的AES系统PEG是由Page等人于1966年开发的。其基本原理是使用相关分析推测作文的内在质量(Chung&O'Neil 1997),即通过从作文文本中提取间接反映其质量的表层文本特征项(称作proxes,如词性、词长、词义等)来衡量作文质量的内在要素(称作trins,如流利度、用词、语法等)(Page 1966)。

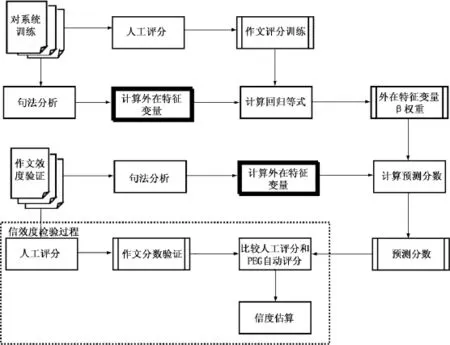

PEG的评分主要分为三个步骤:(1)选取训练集作文进行人工打分,并利用自然语言处理技术(NLP-Natural Language Processing)提取若干文本特征项以确定评价作文质量的特征值。(2)将文本特征项作为自变量,人工评分分数作为因变量,输入预测方程,进行多元回归分析,得出各变量的beta值,即各项特征在作文评分中的权重。(3)将beta值代入计算程序换算出作文最终得分(Chung&O'Neil 1997)。图1为PEG系统评分过程,虚线部分表示系统与人工评阅的信效度检验过程。

Page和Peterson(1995)对PEG的信度加以分析后发现,人机评阅相关性为0.72~0.78,高于人工评阅者间的相关性。系统还具有评分方法直接、技术支持充分和性能不断提升等优点。但PEG只测量了作文的表层特征,未涉及作文内容的评判;每次评分需要对变量重新校正;只能提供与其他作文相比较而言的分数;而且PEG的开发者们没有提供详细的研究报告,对其实质内容很难进一步了解(Kaplanet al.1998)。

图1 PEG评分方框图(引自Chung&O'Neil 1997)

2.2 IEA

IEA是20世纪90年代末由Landauer基于潜在语义分析(LSA-Latent Semantic Analysis)技术开发的AES系统。LSA是“比较词汇使用意义相似性的统计模型”(Foltz 1996),也是“提炼和推导文本段落语境中词的使用情况的自动统计方法”(Landaueret al.1998)。其基本思想是:段落的意义,在很大程度上取决于该段落所包含词汇的意义。

Landauer和Dumais(1997)认为,LSA既是理论也是技术。从理论上来说,任何文本中都隐藏着潜在的语义结构,该结构是所有词汇的语义之和,体现了不同文本中词汇使用的潜在模式,并可通过统计方法加以计算(Foltz 1996)。从技术层面看,LSA是一种矢量空间模型(VSM-Vector Space Model)技术,通过减少维数的方法提取文本数据中的潜在语义结构,使词汇的意义通过词汇所在的语境加以表征(Lemaire&Dessus 2001)。具体就是通过词汇项-文档矩阵(term-by-document matrix)来表示,矩阵中每一行代表一个词汇项,每一列代表一个段落,因而矩阵的每一个单元格为对应词汇项在段落中的频数(梁茂成、文秋芳2007)。该频数代表了词在文章中的重要性和词所传递的信息,由大型文本语料库中词的共现(co-occurrence)情况所决定(Lemaire&Dessus 2001)。

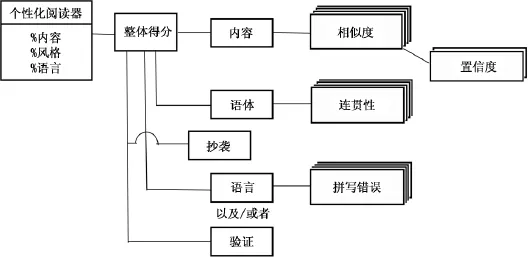

用IEA评分时,由人工评阅者对所有训练集作文打分,然后将训练集作文与待评作文视作矢量,用LSA技术加以分析,确定十篇与待评作文相似的作文,进行cosine加权平均,得到待评作文与训练集作文在内容上的相似度分数,经转换后成为机阅分数(Landaueret al.2003)。具体步骤如图 2所示。

IEA与人工评分间的相关性达到0.85(Landaueret al.2000),与人工评分在词汇和文本的意义方面有较高的相似性。IEA将三个主要成分即内容、风格和语言加以结合,可模仿人进行词汇选择和类别判断,提供与内容相关的反馈信息(如作文的连贯性),对写作教学有积极意义。而且IEA还可用作阅读理解检测(如比较文章摘要与原文的匹配度)。另外 IEA还增加效度和置信度的测量(validity confidence measures),可测定作文是否有抄袭现象(Landaueret al.2003)。其缺点是只能对词义加以分析却没有考虑词的顺序、句法关系、逻辑等因素,因此缺乏完整性(Landaueret al.2004)。

2.3 e-rater和Criterion

e-rater是20世纪90年代末由ETS(Educational Testing Service)开发的一项基于NLP技术,矢量空间模型技术和线性回归模型(Valentiet al.2003),通过从作文中提取特征项来预测人工评阅作文得分的AES系统(Enright&Quinlan 2010)。

图2 基于三个部分个性化结合及辅助措施的IEA评分示意图(引自Landauer et al.2003)

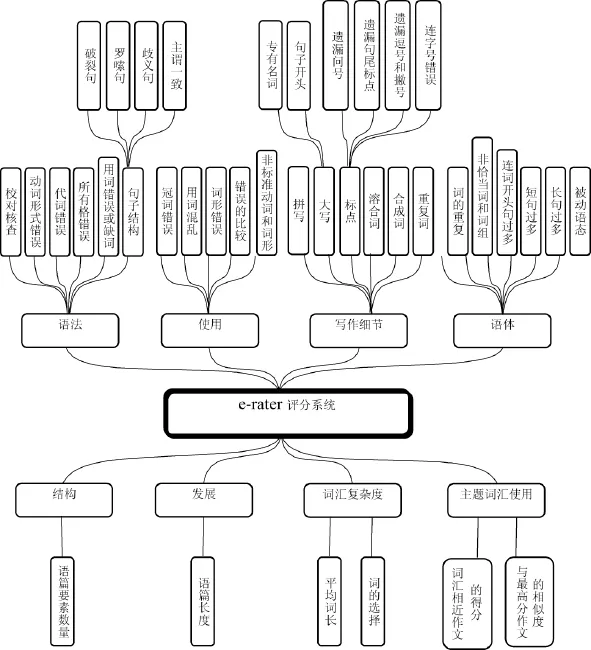

e-rater围绕篇章、句法和内容/话题三个模块评判作文(Burstein&Marcu 2000)。篇章模块使用在文本中搜索“In summary”、“In conclusion”等提示词的方法;句法模块使用NLP技术中的句法分析程序(parser)对句子进行解析;内容/话题模块则通过检测文本所含与题目高度相关的主题词来确定与内容相关的特征项的分数档。图3展示了e-rater评分要素的基本构成。

e-rater的评分过程是:(1)使用线性回归模型分析人工评分的作文,确立可预测人工评阅分数的最优化加权模型。(2)对作文的各个特征项进行测量和汇总,形成各特征项分数。(3)通过加权模型将特征项分数加权平均后形成最终分数(Burstein 2003)。

e-rater与人工评分之间的完全一致性为87%~97%,相关性为 0.73~0.93(Bursteinet al.2004; Valentiet al.2003)。e-rater能评判作文的语言、内容和篇章结构,因此是较为全面的自动评分系统。然而,e-rater着重语言的准确度和作文的结构,不能对观点的论述和内容的逻辑性、连贯性加以评估,且e-rater给出的是作文的分数,没有具体的反馈内容。

Criterion利用e-rater对作文进行评分,又利用Critique分析工具对语法错误、语言使用、语篇结构、文体特征等提供反馈信息(Bursteinet al.2003)。Criterion利用语料库和统计的方法检测语言使用中的违规现象,方法是从语料库中提取和计算双连词(bigrams),包括相邻词(sequence of adjacent words)和词性组对(part-of-speech pairs),并与学生作文中双连词出现的频率进行比较,如有差异则说明作文中可能出现错误(Bursteinet al.2004)。Criterion对语篇和内容的反馈是通过人工标记语篇单元项(discourse unit),如介绍、中间段(主题句和细节展开)、结尾等要素。系统利用概率分析方法(probabilistic methods)和基于决策的方法(decisionbased approach)分析语篇,将句子归入语篇各要素中,对不符合语篇要素的作文给予修改建议(Bursteinet al.2003)。Criterion能帮助学生减少错误的发生,其内置在线参考资料能帮助学生进行自主学习。但是系统并不能准确查出所有的错误,只能指出表面性的语言错误,对于内容方面的反馈比较欠缺(Cheville 2004)。

2.4 IntelliMetric和MY Access!

IntelliMetric是由Vantage Learning于1998年开发的能对开放式问题进行评分和反馈的作文评价系统。该系统基于人脑的信息处理的认知模式,融合了人工智能和计算语言学原理,利用NLP技术和机器学习方法,开发了认知搜索(CogniSearch)和量子推理(Quantum Reasoning)技术(Elliot 2003)。IntelliMetric基于人脑,使用神经合成法重现人工评分过程。它利用自主学习引擎,基于人工评分获得系统评分所需信息,再使用数学工具形成多种信息,利用系统的复杂功能将各部分合成、归纳,形成得分(Vantage Learning 2005)。

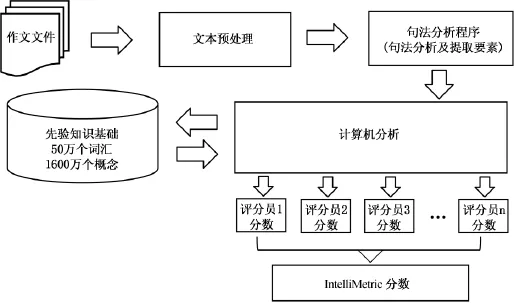

IntelliMetric从内容和结构两方面对作文的语义、句法和语篇层面的多个要素进行评价(Vantage Learning 2005)。评分步骤为:(1)将已知分数的训练集作文输入系统,由系统归纳出评分标准并建模,然后不断矫正模型直至最终确定后运用于待评作文。(2)使用NLP技术中的句法分析程序理解句型和语法结构,从文本中提取信息,转化成数字形式以支持数学模型的运算。(3)确定一个或多个数学模型、整合模型的信息获得最终分数(Rudneret al.2005)。这一评分步骤可通过图4加以说明。

IntelliMetric与人工评分一致性达 94%到98%,相关达0.83,高于人工评分者间的一致性和相关性(Elliot 2002)。IntelliMetric的优点是针对不同学业水平和学科内容进行评阅,与其他反映写作水平的测量方法有很强的关联,不同样本测试结果稳定(Elliot 2002)。另外,它能够通过机器学习技术,模仿人工评分过程建立模型并不断加以改进。它还能支持其他多种语言的作文评分。不过系统未涉及写作过程中的思维和认知能力方面的评定。

图3 e-rater评分要素分解图(引自Quinlan et al.2009:9)

图4 IntelliM etric评分过程图(Vantage Learning 2005:12)

体现IntelliMetric在网络环境中实际应用的MY Access!是基于互联网、针对美国教育环境的自动写作评估系统,与IntelliMetric在评分的核心理论上是一致的。MY Access!为学生提供了一个写作环境,使学生得到迅速的结构化的反馈,有利于学生根据反馈结果修改作文,提高写作能力。MY Access!还为教师提供了一个基于网络的教学环境,教师可以浏览历史记录,分析作文错误。但是MY Access!只能评定系统自带的写作任务,对教师布置的新任务却无法评定(Dikli 2006)。

2.5 BETSY

BETSY是由Runder等人于2002年开发的以概率论为导向、基于贝叶斯文本分类技术方法的AES系统(Valentiet al.2003)。BETSY使用了贝叶斯方法的多元贝努利模型(Multivariate Bernoulli Model)和多项式模型(Multinomial Model)。这两种模型分别把作文看作是校正特征(calibrated features)的特例和范例(Dikli 2006)。在贝努利模型中,某一特征出现的概率通过计算作文中所包含的该特征的比例加以实现。在多项式模型中,作文获得某个分数的概率则是计算该作文所有特征的条件概率的乘积(Rudner&Liang 2002)。换句话说,贝努利模型关注某一特征在文中是否存在,而多项式模型关注所有特征在文章中出现的概率(Rudner& Liang 2002)。

BETSY的评分主要通过将作文分类的方法。首先,BETSY使用约1000篇训练集作文对系统进行训练,形成优、良、中、差四个级别;然后系统利用上述模型对待评作文的特征项加以分析,包括特定的词和词组、词频、词数、句长、动词数、概念呈现顺序、名词性词组的共现情况等;最后系统对待评作文进行分类,确定作文所属级别(Dikli 2006)。

Rudner和Liang(2002)用462篇作文作为训练集,使用BETSY对80篇测试作文评分,得到了80%的准确率。其研究人员声称BETSY不但包含了其他系统的优点,且具有自身特点,可应用于不同专业学科,能产生诊断性结果且易于解释,还可免费下载使用(Valentiet al.2003)。但是,BETSY的应用不多,相关研究非常有限,训练集作文数量要求大,否则准确率较低,使用效果未得到论证(Valentiet al.2003)。

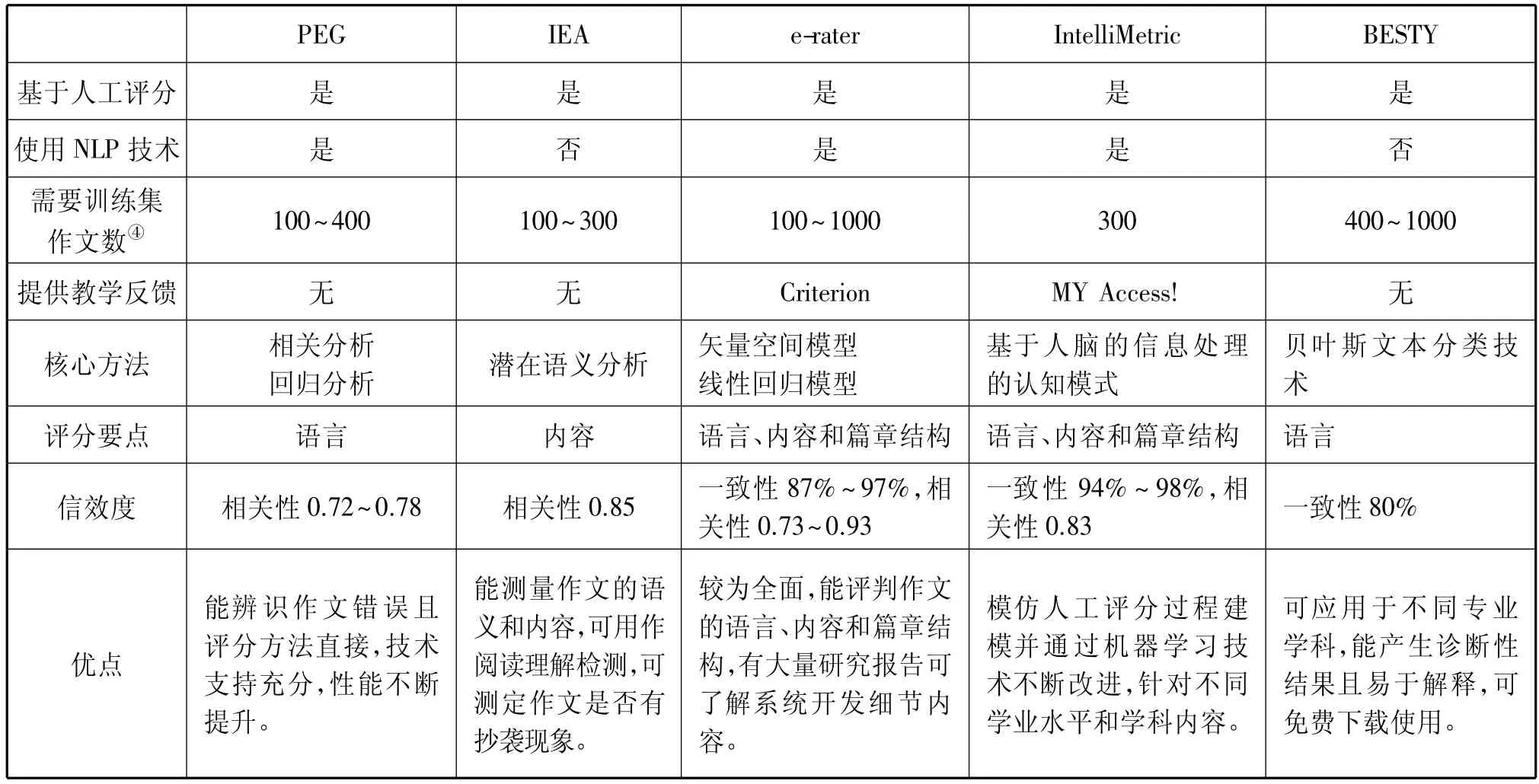

3.AES系统的共性和个性

从以上分析来看,五大AES系统的最重要的共性是系统都基于而非脱离人工评分,是对人工评分的模拟,需用基于人工评阅的作文对系统进行训练。虽然有的系统(如e-rater)也开发了适用于不同写作题目的通用(generic)模型,但由于通用性无法涉及作文内容的评分而影响了准确度。此外,多数系统都使用了NLP技术。NLP技术是指计算机对自然语言的各级语言单位进行的自动处理,包括对字、词、句、篇章等进行转换、分析与理解,对未来AES的发展有着十分积极的意义。最后,研究者对各自所开发的模型都给出了信效度的验证,说明其准确性,但是在实际使用中,尤其是在作文反馈方面仍存在问题。表1更为清晰地展示了各系统的共性和个性,便于分析和比较。

表1 五种AES系统的个性和共性比较

续表

4.存在问题和发展方向

AES的一个共同问题是目前多数系统只能对语言的表层现象加以评定,对深层次的语言现象的评判不足,更是忽视了写作过程中的修辞、认知、思维发展过程等方面的因素。Weigle(2013)阐述了写作能力的结构模式,该模式包含了修辞知识、思辨能力、阅读能力、写作能力、写作过程、写作惯例、网络环境下的写作能力等因素。而AES的评分标准需符合写作能力的结构模式(Weigle 2013),因此,使用AES对作文进行评分不能仅限于对传统的写作惯例的评判,更要从写作能力的各方面,尤其是针对写作的修辞、认知、思辨能力、过程等因素对作文加以评判,这是未来AES系统发展的趋势。

Kukich(2000)认为,未来AES所提供的反馈将使人们更好地理解写作中所包含的各种认知和思想交流过程。因此未来AES将基于认知,更加注重写作过程中思维的发展。Deane等(2011)在对新型AES的开发设想中提出了基于认知的写作能力测试模型。该模型体现了任务特征所反映的基本写作能力和文本特征所反映的有效论证能力,其主要作用是建立学生外在的写作表现和内在的写作能力之间的联系。Deane等认为写作能力、思辨能力、阅读能力和整体文化素养之间没有明显的界限,至少从形成性角度来看,阅读、写作和思辨能力是紧密联系的。

目前,美国加州大学Warschauer(2014)教授已经开始着手新型AES系统的研究计划,旨在能够对各种写作形式提供形成性反馈,并强调写作的高级思维能力。该研究将使用具有机器学习功能的开放性AES系统LightSIDE,利用系统的修改助手工具对写作过程提供实质性反馈,并试图对文、理科的各类作文分别提供适合学科内容的有效反馈。系统还将设计人机对话和智能指导系统加强反馈效果,帮助学生更好地提高写作能力。

AES系统的发展,离不开交叉学科间的相互渗透和共同合作,包括写作教师、语言测试研究开发人员、认知心理学家、心理测量专家、计算机科学家等(Shermis&Burstein 2003)。写作教师和语言测试人员可以使我们了解AES系统如何在最大程度上帮助学生提高写作能力。认知心理学家帮助建立更加优化的模型,以反映学生写作的思维过程。心理测量专家对系统的评估工作有利于人们更好地了解系统的信度和效度。计算机科学家的重要作用在于系统的实施和功能的优化。

AES也将不再局限于对英语作文的自动评分,而是逐步建立对多种语言的评分功能。我国研究人员除了研发针对我国英语学习者的AES评阅反馈系统外,也开始研发针对汉语作文考试的AES系统。例如黄志娥等(2014)研究了汉语水平考试的自动作文评分的特征选取方法。刘明杨等(2016)研究了将文采特征加入到基准系统中对高考作文进行自动评分的可能性。这些研究对整体AES的发展都将产生一定的影响。

随着NLP技术的发展,越来越多的AES系统得以开发和利用,诸如 MaxEnt(Sukkarieh& Bolge 2010)、Writing Roadmap (Richet al.2013)、LightSIDE(Mayfield&Rose 2013),Crase(Lottridgeet al.2013)等。进入21世纪,NLP延续20世纪末的语料库和概率统计的方法,更多地利用语料库中的“大数据”对自然语言加以分析处理(Agerriet al.2015)。此外,人们基于交互理论,研究NLP中的人机交互,利用自然语言处理方法创建自然语言界面,使人机交互更加有效(Valencia-García& García-Sánchez 2013)。概率统计模型促成了当今概率建模的繁荣与发展。概率统计建模采用从数据中学习的方法,成为NLP中占统治地位的建模方法,形成了基于语料库的数据驱动法。随着NLP的智能互联网的建立,对语言高级层面的处理成为可能。Wang等(2014)分析了NLP的结构和功能,提出了基于语义网络本体论(Semantic Web Ontology)的NLP系统,将本体论运用于人工智能、语义网等的自然语言处理可以降低其复杂性,有利于解决实际问题。NLP的发展历程似乎正遵循着莫里斯和卡尔纳普的理论,在经历了前一阶段的语形网之后,正逐步迈向语义网这一新的阶段,最终很有可能迈向语用网这一更高层次(殷杰、董佳蓉2008)。这些对AES的进一步发展将起到关键性作用。

5.结论

以上我们对五种最有代表性的AES系统的原理、特征、功能、优缺点等进行了分析,比较了其共性和个性。未来AES系统的发展将在更高层面上依赖NLP技术的发展并呈现以下八个特点:(1)以基于认知的写作模型为基础,设计有助于提高学习者认知能力和批判性思维能力的AES系统。(2)评判重点从作文的语言和结构转向作文的论点思辨和修辞效果。(3)对各种文体类型的作文进行评定,包括语言类和学术科技类。(4)开发能够对学生写作过程提供有效形成性评估的新型系统软件。(5)利用机器学习技术,设计能够解决新问题的开放式AES系统平台。(6)开发和利用可进行人机对话的反馈模式,增强反馈效果,提升系统功能。(7)各学科领域的合作在系统发展中的作用将更为突出。(8)逐步建立对多种语言的评分反馈功能。

附注

①AWE指除了有对作文评分外还提供反馈。由于文中多数系统为评分系统,故统称AES系统。

②将Criterion与e-rater合并讨论是由于Criterion是e-rater评分系统在教学环境中的应用,可提供写作反馈。

③同样MY Access!是IntelliMetric在教学环境中的应用。

④同一种AES系统中,训练集作文数与系统评分准确度成正比。

Agerri,R.,X.Artola,Z.Beloki,G.Rigau&A.Soroa.2015.Big data for natural language processing:A streaming approach[J].Knowledge-Based Systems79:36-42.

Attali,Y.2015.Reliability-based feature weighting for automated essay scoring[J].Applied Psychological Measurement39 (4):303-313.

Burstein,J.2003.The E-rater® scoring engine:Automated essay scoring with natural language processing[A].In M.D.Shermis& J.C.Burstein(eds.).Automated Essay Scoring:A Cross-Disciplinary Perspective[C].Mahwah: Lawrence Erlbaum Associates.113-121.

Burstein,J.,M.Chodorow&C.Leacock.2004.Automated essay evaluation:The criterion online writing service[J].AI Magazine25:27-35.

Burstein,J.&D.Marcu.2000.Benefits of modularity in an automated essay scoring system[A].Proceedings of the COLING-2000 Workshop on Using Toolsets and Architectures to Build NLP Systems[C].Luxembourg:Association for Computational Linguistics.44-50.

Burstein J.,D.Marcu&K.Knight.2003.Finding the WRITE stuff:Automatic identification of discourse structure in student essays[J].IEEE Intelligent Systems18:32-39.

Chapelle,C.A.,E.Cotos&J.Lee.2015.Validity arguments for diagnostic assessment using automated writing evaluation[J].Language Testing32(3):385-405.

Cheville,J.2004.Automated scoring technologies and the rising influence of error[J].English Journal93:47-52.

Chung,K.W.K.& H.F.O'Neil.1997.Methodological approaches to online scoring of essays[OL].[2016-07-06].http://www.cse.ucla.edu/products/reports/tech461. pdf.

Deane,P.,T.Quinlan&I.Kostin.2011.Automated scoring within a developmental, cognitive model of writing proficiency[R].Princeton:Educational Testing Service.

Dikli,S.2006.An overview of automated scoring of essays[J].Journal of Technology,Learning,and Assessment(5):1-35.

Elliot,S.2002.A study of expert scoring,standard human scoring and IntelliMetric scoring accuracy for statewide eighth grade writing responses[R].Newtown:Vantage Learning.

Elliot,S.2003.IntelliMetric:From here to validity[A].In M.D.Shermis&J.Burstein(eds.).Automated Essay Scoring:A Cross-Disciplinary Perspective[C].Mahwah:Lawrence Erlbaum.71-86.

Enright,M.& M.Quinlan.2010.Complementing human judgment of essays written by English language learners with e-rater scoring[J].Language Testing27:317-334.

Foltz,P.W.1996.Latent Semantic Analysis for text-based research[J].Behavior Research Methods,Instruments and Computers28:197-202.

Kaplan,R.M.,S.E.Wolff,J.Burstein,C.Lu,D.A.Rock&B.A.Kaplan.1998.Scoring essays automatically using surface features[R].Princeton:Educational Testing Service.

Kukich,K.2000.Beyond automated essay scoring[J].IEEE Intelligent Systems15:22-27.

Landauer,T.,K.&S.Dumais.1997.A solution to Plato's problem: The latent semantic analysis theory of the acquisition,induction,and representation of knowledge[J].Psychological Review104:211-140.

Landauer,T.K.,P.W.Foltz&D.Laham.1998.Introduction to latent semantic analysis[J].Discourse Processes25:259-284.

Landauer,T.K.,D.Laham&P.W.Foltz.2000.The intelligent essay assessor[J].IEEE Intelligent Systems15:27-31.

Landauer,T.K.,P.W.Foltz&D.Laham.2004.What is LSA?[OL].[2016-07-06].http://lsa.colorado.edu/whatis.html.

Landauer,T.K.,D.Laham&P.W.Foltz.2003.Automatic essay assessment[J].Assessment in Education10(3):295-308.

Lemaire,B.&P.Dessus.2001.A system to assess the semantic content of student essays[J].Educational Computing Research24:305-306.

Lottridge,S.M.,E.M.Schulz& H.C.Mitzel.2013.Using automated scoring to monitor reader performance and detect reader drift in essay scoring[A].In M.D.Shermis&J.Burstein(eds.).Handbook of Automated Essay Evaluation:Current Applications and New Directions[C].New York: Routledge.233-250.

Mayfield,E.& C.P.Rose.2013.LightSIDE:Open source machine learning for text[A].In M.D.Shermis&J.Burstein(eds.).Handbook of Automated Essay Evaluation:Current Applications and New Directions[C].New York: Routledge.124-135.

Page,E.B.1966.The imminence of grading essays by computer[J].Phi Delta Kappan47:238-243.

Page,E.&N.S.Peterson.1995.The computer moves into essay grading:Updating the ancient test[J].Phi Delta Kappan76:561-565.

Quinlan,T.,D.Higgins& S.Wolff.2009.Evaluating the construct-coverage of e-rater Scoring Engine [R].Princeton:ETS.

Rich,C.S.,M.C.Schneider&J.M D'Brot.2013.Applications of automated essay evaluation in west Virginia[A].In M.D.Shermis& J.Burstein(eds.).Handbook of Automated Essay Evaluation:Current Applications and New Directions[C].New York:Routledge.99-123.

Rudner,L.M.&T.Liang.2002.Automated essay scoring using Bayes'theorem[J].The Journal of Technology,Learning,and Assessment1(2):3-21.

Rudner,L.,V.Garcia& C.Welch.2005.An evaluation of IntellimetricTMessay scoring system using responses to GMAT AWA prompts[R].McLean:Graduate Management Admission Council.

Shermis,M.D.&J.Burstein.2003.Introduction[A].In M.D.Shermis&J.Burstein(eds.).Automated Essay Scoring:A Cross-disciplinaryPerspective[C].Mahwah: Lawrence Erlbaum.xiii-xvi.

Sukkarieh,J.Z.&E.Bolge.2010.Building a textual entailment suite for the evaluation of automatic content scoring technologies[OL].[2016-07-06].http://www.lrec-conf.org/proceedings/lrec2010/pdf/310_Paper.pdf

Valencia-García,R.& F.García-Sánchez.2013.Natural language processing and human-computer interaction[J].Computer Standards&Interfaces35:415-416.

Valenti,S.,F.Neri.&A.Cucchiarelli.2003.An overview of current research on automated essay grading[J].Journal of Information Technology Education2:319-330.

Vantage Learning.2005.How IntelliMetricTMWorks[OL].[2016-07-06].http://www.cengagesites.com/academic/ assets/sites/4994/WE_2_IM_How_IntelliMetric_Works.pdf.

Wang,Y.,J.Zhang&Y.Xu.2014.Research on construction of natural language processing system based on semantic web ontology[J].Journal of Chemical and Pharmaceutical Research6(12):291-296.

Weigle,S.C.2013.English language learners and automated scoring of essays:Critical considerations[J].Assessing Writing18:85-99.

Warschauer,M.2014.Next-generation automated feedback in support of iterative writing and scientific argumentation[R].Irvine:University of California.

Warschauer,M.&D.Grimes.2008.Automated essay scoring in the classroom[J].Pedagogies3(1):22-36.

Warschauer, M.& P.Ware.2006.Automated writing evaluation:Defining the classroom research agenda[J].Language Teaching Research10(2):1-24.

黄志娥、谢佳莉、荀恩东.2014.HSK自动作文评分的特征选取研究[J].计算机工程与应用(6):118-126.

刘明杨、秦兵、刘挺.2016.基于文采特征的高考作文自动评分智能[J].计算机与应用(1):1-8.

梁茂成、文秋芳.2007.国外作文自动评分系统评述及启示[J].外语电化教学(5):18-24.

殷杰、董佳蓉.2008.论自然语言处理的发展趋势[J].自然辩证法研究(3):31-37.

(责任编辑 管新潮)

H319

A

1674-8921-(2016)06-0054-08

10.3969/j.issn.1674-8921.2016.06.009

张荔,博士,上海交通大学外国语学院副教授。主要研究方向为计算机辅助语言教学、学术英语写作。电子邮箱:zhangli@sjtu.edu.cn

Mark Warschauer,加利福尼亚大学欧文分校教育学院教授。主要研究方向为CALL、Cloud-Based Writing、Virtual Learning。电子邮箱:markw@uci.edu

盛越,上海工程技术大学外国语学院副教授。主要研究方向为计算机辅助语言教学。电子邮箱:sheng.yue@163.com

*本研究受国家社科基金项目“基于语料库和云技术的网络自动作文评阅系统信效度及其辅助教学研究”(编号13BYY081)资助,特此感谢!