融合残差上下文编码和路径增强的视杯视盘分割

梅华威,尚虹霖,苏攀,刘艳平

1.华北电力大学控制与计算机工程学院,保定 071003;2.复杂能源系统智能计算教育部工程研究中心,保定 071003;3.河北省能源电力知识计算重点实验室,保定 071000

0 引言

眼睛是人体重要的视觉器官,也是最容易产生疾病的器官之一。青光眼是全球第二大致盲原因,它的早期诊断非常重要。临床上,除基于功能的视野检测和眼压测量外,另一种主要青光眼筛查技术是基于眼底图像的视盘(optic disc,OD)又称视神经乳头(optic nerve head,ONH)和视杯(optic cup,OC)(视盘的中心部位)评估,为一种早期发现青光眼的便捷方法,需要医生手动定位视盘和视杯的区域和边界。通过观察视杯区域增大情况,判断是否存在青光眼。青光眼判别的评价指标包括盘直径(optic disc diameter,ODD)、杯盘比(cup disc ratio,CDR)与盘沿(rim),通常认为杯盘比是视盘和视杯区域最具代表性的青光眼检测指标之一,临床上通常认为CDR 大于0.65 的眼睛为青光眼(Akram 等,2015),且杯盘比越大,患有青光眼的概率越高。

对于视盘和视杯的分割与CDR 的确定,通常需要医生手动计算,该过程存在较强的主观性,不确定性高且耗时昂贵。因此,亟需一种自动评估方法高效精准地进行视盘分割,提高效率和质量。

计算机辅助视盘和视杯分割大致分为传统方法和基于深度学习的方法。传统的分割方法包括基于形状和模板匹配的方法、基于活动轮廓模型的方法以及超像素的方法。在大多数基于模板的算法中,通常把视盘近似为椭圆,因此采用霍夫变换的方法,例如Aquino 等人(2010)利用椭圆霍夫变换获得视盘边界近似结果。Cheng 等人(2013)通过消除来自非视杯盘结构周围萎缩的边缘滤波,约束椭圆霍夫变换使分割更准确;在基于活动轮廓的方法中,Lowell 等人(2004)首先使用基于图像梯度的变形轮廓模型进行视盘轮廓检测,赵晓芳等人(2011)也将不同类型的活动轮廓模型应用于视盘和视杯的分割;此外,Xu 等人(2012)提出了一种基于视网膜先验结构的超像素学习框架,并通过局部上下文信息对分割结果进行微调。值得注意的是,传统的分割方法通常容易受到噪声的影响,当目标与背景灰度值有重叠时,分割效果不佳。

随着卷积神经网络在图像以及视频处理中的发展,深度学习网络也逐渐广泛应用于医学图像处理中。端到端全卷积网络(fully convolutional network,FCN)(Long 等,2015)和U-Net(Ronneberger 等,2015)的出现开辟了分割任务的新时代。Fu 等人(2018a)提出M-Net(multi-label deep network),在U-Net基础上增加了极坐标预处理与多尺度输入,并增加额外的损失函数使得网络能够得到更多的监督信息,但是没有充分考虑像素与像素之间的关系。Al-Bander 等人(2018)和Tabassum 等人(2020)采用对称的U 形架构允许像素级分类。Yu 等人(2019)使用改进的U-Net 架构,采用鲁棒分割方法实现视盘和视杯区域的精确分割。Gu 等人(2019)提出了context encoder network(CE-Net),通过引入密集空洞卷积模块去捕获更广泛和更深层次的语义特征,残差多路径池化模块可以防止梯度消失,保留更多的空间信息。Fu 等人(2018b)和Murugesan 等人(2019)通过考虑视盘和视杯中不同层次与模块间的相互关系,更好地捕捉边界信息,但是这类方法没有充分利用视杯在视盘内且二者近似椭圆的先验知识。Jiang 等人(2020)将图像分割问题转换为目标检测问题,通过剪裁视盘的相应区域来指导视杯分割。Surendiran等人(2022)改进递归神经网络,构造片内和片间上下文的特征映射来提取细节信息,进行视盘和视杯联合分割。

近年来,注意力机制广泛应用在计算机视觉领域中,它可以区分不同局部信息的重要程度,忽略无关信息,更适合应用在医学图像分割任务中。刘洪普等人(2021)通过聚合全局上下文信息,采用注意力指导模块增强有用特征并抑制无用特征响应。Zhang 等人(2019)提出了一种注意力引导网络保存结构信息并指导扩展操作,在部分公共数据集下提高了视盘和视杯分割的精度。为了提高模型的泛化性,Zhu 等人(2021)采用不同数据集下的混合训练策略,通过引入权重共享注意力和密集连接的深度可分离卷积,将多尺度特征充分融合。Mou 等人(2021)提出一种基于双自注意模块的曲线结构分割网络,能够更有效地从背景中分类曲线结构,学习视盘和视杯丰富的层次信息。

本 文提出RCPA-Net(residual context path augmentation U-Net)算法对视盘和视杯进行分割,具体步骤如下:首先提取视盘周围感兴趣区域(region of interest,ROI);再将感兴趣区域作为RCPA-Net 分割网络模型的输入,分别分割视盘与视杯,将传统的联合三类别分割转换为两个二类别分割;最后将分割得到的视盘和视杯区域融合为一幅图像,实现可视化操作。

虽然深度学习卷积网络已经在视盘和视杯分割方面取得了不错的成果,但是在精度上仍然存在很大的提升空间。U-Net 网络及其变体模型在提取特征时会产生粗糙的分段,具有大量不连续线段。同时,目前主流的分割网络都是针对某一特定数据集,通常在同类任务的其他数据集中分割效果不好,模型泛化能力差。此外,在训练过程中使用交叉熵损失函数会给图像带来类别不平衡的问题,导致背景像素干扰视盘和视杯的分割。

为了解决上述问题,本文主要做出以下几点贡献:1)提出并实现一个端到端的深度学习网络RCPA-Net,使用预训练ResNet34(residual neural network)模型与注意力机制融合作为特征提取网络,采用统一架构实现了视盘和视杯的精准分割,提高了分割精度;2)提出残差空洞卷积模块(residual atrous convolution,RAC)和路径增强模块(path augmentation module,PAM),即能够多尺度提取上下文语义信息,同时获取精确的边界定位信息,增强整个特征层次;3)提出一种新型多标签损失函数,提高视杯盘与背景区域的像素比例,指导网络进行分割。

1 相关工作

1.1 残差模块

传统卷积神经网络具有多尺度表示信息的能力,往往通过增加卷积层数量来提取图像中更丰富的细节。ResNet(He 等,2016)为神经网络引入了残差单元,防止因网络过深导致梯度爆炸或者梯度消失,同时获得更深入的网络结构,大幅提升网络性能。

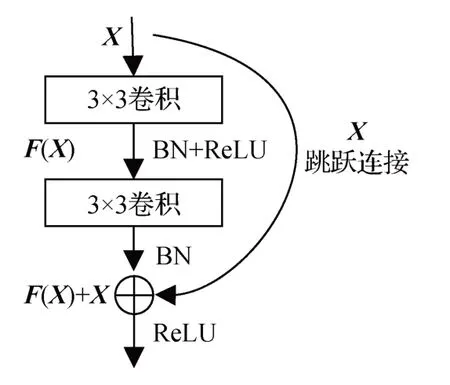

本文中残差单元结构如图1 所示,F(X)表示残差路径。恒等连接路径X与跨卷积的数据通路在没有引入额外计算量与参数量的情况下相加,得到最终结果。

图1 残差单元结构图Fig.1 The structure of residual block

1.2 空洞卷积

空洞卷积(atrous convolution)最初用于促进更加高效的小波变换计算。数学上,空洞卷积在二维信号下表示为

式中,x[i]表示输入特征图,ω[k]表示卷积核中第k个参数,y[i]表示输出特征图。r表示空洞卷积参数空洞率(dilation rate),对应于输入信号进行采样的步幅。空洞卷积在没有引入额外参数的情况下,通过设置不同的参数空洞率自适应修改感受野的大小。空洞卷积通过调整卷积扩大感受野来捕获多尺度上下文信息。一方面随着感受野的增大,网络可以检测大目标物体;另一方面空洞卷积可以精确控制由分割网络计算出的特征图分辨率,通过提高分辨率促进目标的精确定位。

1.3 注意力机制

SE-Net(squeeze-and-excitation network)(Hu 等,2018)核心思想是在全连接网络中根据loss 自动学习特征权重,而非根据特征通道的数值分配判断。在实际训练中,SE-Net 中的降维处理操作会对通道注意力机制的预测产生负面影响,ECA-Net(efficient channel attention)(Wang 等,2020)对SE-Net 进行了改进,在避免降维问题的同时,有效捕获跨通道的特征交互。

如图2 所示,ECA 模块输入为X,维度为H×W×C(H,W,C分别表示输入特征图的高、宽及通道数)。首先对X沿着维度H×W进行全局平均池化操作,输出的特征描述符维度为1 × 1 ×C;其次再经过全局平均池化,通过一个一维卷积(1D)进行学习,卷积核的大小由函数自适应变化,使得通道数较大的层可以更多地进行跨通道交互;最后执行sigmoid 激活函数将值固定到0~1 之间来学习通道注意力。

图2 ECA模块结构图Fig.2 The structure of ECA block

ECA 模块通过卷积核大小为k的1D 卷积有效实现,本文采用自适应函数确定k,避免了交叉验证对k进行调试。自适应函数为

式中,C为通道数,γ和b为非线性函数中的参量,|t|odd表示t向上舍入后最接近的奇数。通过映射函数ψ,高维通道具有更长范围的相互作用,而低维通道通过使用非线性映射进行更短范围的相互作用。ECA 模块有效捕获了跨通道的交互,避免维度缩减问题的产生,同时,ECA 模块模型复杂度低,只需少量参数就能达到很好的效果。

2 实验模型

2.1 数据预处理

针对眼底图像通常存在光照不均和视网膜血管干扰等问题,本文增强了每幅图像目标和背景区域的对比度,再进行限制对比度自适应直方图均衡化(contrast limited adaptive histogram equalization,CLAHE)(Zuiderveld,1994)和颜色归一化处理,增强对比度的同时有效抑制噪声。最后将增强图像与原始图像组合后取平均,构成一幅新的三通道图像,丰富图像信息的同时防止数据不平衡,让模型学习目标分割物体更多的特征信息。图3(a)中的图像经过CLAHE处理后的结果如图3(b)所示,视盘和视杯区域更加明显。

图3 CLAHE处理图像结果Fig.3 Result of CLAHE processing image((a)original image;(b)image processed by CLAHE)

2.2 RCPA-Net网络模型

本文提出的RCPA-Net 网络模型主要包括3 个部分:特征编码模块(feature encoder module,FEM)、残差空洞卷积模块(residual atrous convolution,RAC)和路径增强模块(path augmentation module,PAM),RCPA-Net网络整体结构如图4所示。

图4 RCPA-NetFig.4 RCPA-Net

2.2.1 特征编码模块

视盘和视杯分割是一项基于像素分类的密集预测任务,本文使用预训练ResNet34 模型与ECA 模块融合作为特征提取网络,通过跨通道信息获取来增强图像特征提取的能力。

改进后的ResNet34 保留原始7 × 7 卷积以及前4 个特征提取块,删去平均池化层和全连接层。如图5 所示,输入图像首先通过7 × 7 卷积以及最大池化层直接降采样,最大限度地保留原始图像信息的同时,稳定通道数。

图5 Conv 7 × 7+MaxPoolFig.5 Conv 7 × 7+MaxPool

特征提取块由两个3 × 3 卷积层、批标准化(batch normalization,BN)以及ReLU 激活函数组成,如图6所示。

图6 残差模块Fig.6 Residual block

本文使用经过预训练ResNet 的改进U-Net 作为骨干网络,在每一层残差块后添加ECA 模块,保留视盘和视杯的空间信息细节。ECA 模块中1D 卷积的卷积核大小会影响通道注意力机制每个权重的计算以及通道数量,从而改变跨通道交互的覆盖率,这直接影响视盘和视杯特征信息的提取。

本文在所有实验中分别将γ和b设为2 和1,根据通道维数的非线性映射自适应地计算卷积核大小,输入和输出的维度均为1 × 1 ×C。本文中编码器的构造通过学习每个卷积块的通道注意力,增加了信息获取的能力。

2.2.2 残差空洞卷积模块

在深度学习中,Inception(Szegedy等,2017)系列网络通过增加网络宽度来提高网络性能,ResNet 通过恒等连接路径在不改变网络性能的基础上减少参数量与计算量,同时有效抑制了梯度消失与梯度爆炸。受两种网络的启发,本文提出了残差空洞卷积模块(RAC)来获取更深层的特征信息。

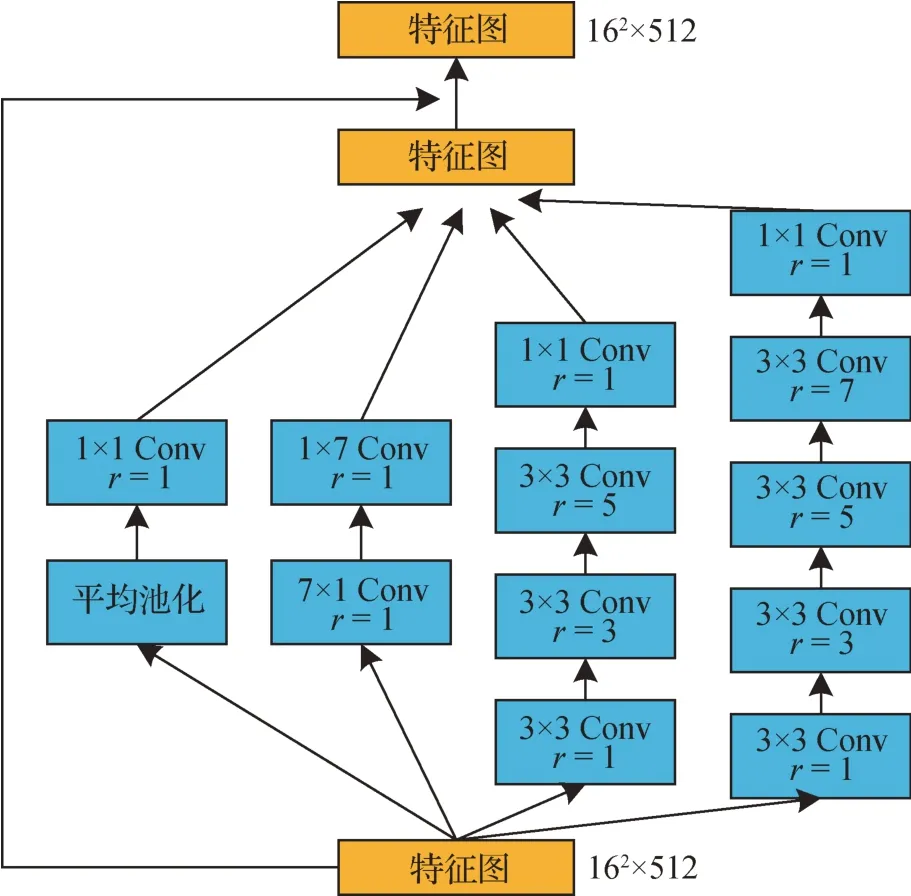

RAC 模块用来提取上下文更高层的语义特征信息,如图7 所示。模块中使用空洞卷积代替传统卷积,在参数量不变的情况下,增大感受野。RAC模块有4 个连级分支,卷积块个数分别为2、2、4 和5,随着卷积层个数的增加,每个分支的感受野在逐渐增大,分别为3、7、19和33。结合不同的参数空洞率可以产生不同大小的感受野,提取更加详细的特征。在RAC 模块中,采用全局平均池化,将特征图中所有像素值相加求平均得到特征向量,特征层更容易被转化为分类概率,避免了过拟合。同时采用空间可分离卷积,使用7 × 1 和1 × 7 两个串联卷积模块代替一个7 × 7模块,保证感受野的同时减少了网络参数并增加非线性和模型的表达能力。在每个分支后增加1 × 1卷积调整线性激励与维数,减少参数与运算量,提升运算效率。最后将4 个分支的输出结果与输入图像融合,得到预测结果。

图7 残差空洞卷积模块Fig.7 Residual atrous convolution module

与Inception 系列网络在网络结构上相比,RAC模块仅有4条联级分支且每条分支的模块数量更少,使得模型更简洁,同时也保证了结构的稀疏性;其次,在结构内部使用多个3 × 3 空洞卷积来代替普通卷积,在进一步增加网络深度的同时稳定了参数量;最后,RAC模块每条分支的感受野逐步增大,通过组合不同空洞率的卷积,实现了高级语义信息与浅层全局信息的融合,更易提取不同尺寸的目标特征。

2.2.3 路径增强模块

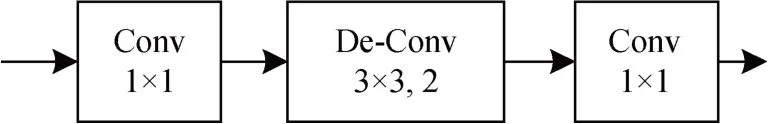

特征解码模块恢复了特征编码模块与上下文特征提取模块得到的深层语义特征。为了弥补连续的池化与卷积操作造成的信息损失,采用跳跃连接的方式,直接从编码器到解码器获得对应图像维度的信息。解码模块采用转置卷积,放大图像并自适应学习特征映射,恢复图像更高分辨率的信息。特征解码模块如图8 所示,主要包括两个1 × 1 卷积层以及一个3 × 3转置卷积层。基于跳跃连接和4次上采样解码操作,特征解码器输出与原始输入大小相同的图像。

图8 解码模块Fig.8 Decoder block

在网络结构中,浅层特征包含精确的视盘和视杯边界信息,对图像分割有很大帮助。但从浅层特征到深层特征的路径较长,获取准确的定位信息难度较大。针对上述问题,受到PANet(path aggregation network)的启发(Liu 等,2018),本文提出自上而下的路径增强模块(PAM)。PAM 利用浅层特征图存在的精确定位信息,缩短信息路径,增强特征信息。与之前的研究(Fu 等,2018a)不同,PAM 模块不仅利用了浅层特征,并且通过传播浅层特征增强了整体功能层次结构与定位能力。

PAM 模块如图9 所示,RCPA-Net 中定义相同空间大小的特征图在同一阶段,如用{F1,F2,F3,F4}表示特征解码模块生成的特征图,扩充路径从最浅层F1 开始,以步幅2 进行下采样操作,逐渐接近F4。使用{N2,N3,N4 }来表示新生成的特征映射,对应于{F2,F3,F4 }。每个PAM 模块由高分辨率特征图Ni以及深层特征图Fi+1通过横向连接拼接后生成新特征图。Ni首先经过一个3 × 3 卷积与ReLU 激活函数,再与Fi+1进行拼接操作。融合后的特征图经过另一个3 × 3卷积处理,同时通道数降至128,生成后续网络的Ni+1特征图,再经过不断迭代,保证输出每个特征图Ni的通道数恒为128,优化模型的同时减少参数与计算量。此外,本文构建了一条从浅层到深层的横向连接路径(图4 中绿色虚线)类似于跳跃连接,通过传播浅层特征的精确信息,进一步增强整个特征层次结构的定位能力。

图9 路径增强模块Fig.9 Path augmentation module

2.2.4 侧输出层

RCPA-Net 引入了侧输出层,与M-Net 类似,采用4 个特征层。作为早期分类器,为浅层特征提供局部输出特征映射。4 个特征层权重参数共享,通道数均为2,输出与输入图像分辨率均为512 × 512像素,融合相加后作为最终的预测结果。

侧输出层能够将损失函数反向传播到对应解码器的浅层卷积网络中,帮助浅层卷积训练并防止出现梯度消失的问题,且浅层特征信息更容易传播,加快训练速度。同时,融合多尺度信息促进了特征信息的高性能融合,侧输出层对不同尺度的结果进行监督,以便输出更好的分割图像。

2.3 损失函数

视盘和视杯分割本质上是像素分类的问题,最常见的损失函数是交叉熵损失函数(cross entropy loss function)。但是,视盘在眼底图像中占比非常小,视杯是在视盘中心的杯状明亮区域,边界轮廓不明显,尤其对于青光眼患者的眼底图像来说,前景与背景区域像素比例十分不平衡,交叉熵损失函数往往得不到最优的解决办法。针对上述问题,本文提出一种基于Dice 系数(Milletari 等,2016)与Focal Loss(Lin 等,2017)的损失函数。Dice 系数是一种集合相似度度量函数,广泛应用于对分割结果的评估,其计算为

式中,N表示像素点数量,p(k,i)∈[0,1]表示像素预测为k类的概率,g(k,i)∈{0,1}表示像素属于k类的真实标签值。K代表分类数,包括前景(视盘或视杯)与背景两类,ωk表示每个类的权重,本文中设置ωk=1/K,即0.5,ε为常值系数,取0.9。而Focal Loss损失函数主要解决前景与背景样本之间不平衡的问题,具体为

式中,p表示模型预测为目标区域的概率,y取1时代表前景目标区域,取-1 时代表背景。当Pt增大时,样本分配得越均衡,loss 值越小,Pt趋向于1 时,样本更容易区分。αt与γ均为常值系数,用于调节前景与背景样本之间损失的比例,分别取0.5与2。

在视盘和视杯分割任务中,目标分割区域只占很小的面积,Dice系数不受前景大小的影响,可以很好地处理前景与背景像素数量不均衡的情况,常应用于较小目标区域的挖掘任务中。

此外,Focal Loss 在训练过程中可以使模型更聚焦于目标区域,有助于从背景中提取清晰的视盘和视杯边界信息。

综上,本文采用由Dice Loss与Focal Loss组成的LLoss作为总损失函数,其定义为

代价敏感损失函数可以加快梯度的反向传播,促进更新权重矩阵,提高目标区域与背景区域的像素比例,更有效地解决训练过程中像素分布不平衡的问题。

3 实验结果分析

3.1 实验设置

本文实验的主要步骤如下:1)数据采集与数据预处理;2)通过训练迭代测试调整参数以保证分割网络性能最优,即在每个训练周期后进行结果验证,保存最佳的训练模型;3)测试保存的最佳模型并进行结果预测;4)模型评估与结果分析。

实验部分基于Python以及Pytorch深度网络学习框架实现,采用NVIDIA GeForce GTX3090 GPU(24 GB)来加速网络训练。训练阶段使用Adam优化器对模型进行优化,每次选取的样本数量为8,权重衰减为0.000 1。Adam集成了一阶动量与二阶动量,收敛速度很快,通常能获得更好的性能。初始学习率为1E-4,训练过程中根据选取样本的数量大小自适应调整学习率,动量为0.9。输入图像均调整为512 ×512 像素,训练周期为150。在输出预测结果时,选择视盘和视杯中最大连通区域,产生最后的分割结果。

由于眼底数据集图像数量较少,因此,在实验中对每幅图像进行随机水平、垂直以及对角翻转,从而进行数据扩充,将每幅图像增加至8 幅。之后对图像进行50%—200%的随机缩放并进行长和宽的扭曲以及HSV(hue,saturation,value)颜色空间抖动。

3.2 数据集

本次实验使用4 个公开的眼底视盘和视杯分割数据集,包括ORIGA(online retinal fundus image database for glaucoma analysis)(Zhang 等,2010)、Drishti-GS1(Sivaswamy 等,2015)、Refuge(retinal fundus glaucoma challenge)(Orlando 等,2020)以及RIMONE(retinal image database for optic nerve evaluation)-R1(Fumero等,2011)数据集。

ORIGA 数据集由650 幅3 072 × 2 048 像素的彩色眼底图像构成,其中包含168 幅青光眼病例图像以及482幅正常眼底图像,将650幅眼底图像分为两组数据集,A组包括325幅训练样本,B组包括325幅测试样本。为了根据原始分辨率分割彩色眼底图像视盘和视杯区域,按照Wang等人(2019)的方法在最亮的点周围裁剪了800 × 800像素的区域。

Drishti-GS1 数据集由101 幅视网膜眼底图像组成,其中包含31 幅正常图像以及70 幅患病图像。Drishti-GS1 数据集标签是由4 位眼科专家医生手动标注,并将4 组金标准取平均后得到标签集合。实验中,将101 幅眼底图像分为两组数据集,A 组包括50幅训练样本,B组包括51幅测试样本。

Refuge 数据集包含训练集、测试集和验证集3 部分,本文选取测试部分400 幅由Zeiss 眼底相机拍摄的彩色眼底图像,分辨率为2 124 × 2 056 像素。同样也分为两组数据集,A 组包括320 幅训练样本,B组包括80幅测试样本。

RIM-ONE-R1数据集包含169幅眼底彩照,该组标签仅提供了5 名眼科专家逐像素标注的不同视盘结果。为了模型的测试与训练,实验中将169 幅图像分为A组训练集101幅以及B组测试集68幅。

3.3 评价指标

为了评估视盘和视杯分割的性能,本文采用JC(Jaccard)指数和F-measure 作为视盘和视杯分割的评估指标。

JC的计算式为

式中,JC表示预测结果与标签结果的重叠率,JC指数值介于0 到1 之间,越接近0,表示视盘或视杯重叠的面积越大,分割效果越精准。

F-measure的计算式为

式中,Rec(recall)为召回率,Pre(precision)为精度。Rec与Pre的计算式分别为

式中,TP(true positive)、TN(true negative)、FP(false positive)、FN(false negative)分别为目标区域的真阳性、真阴性、假阳性、假阴性像素数量。

为了评估视盘和视杯边界的分割精度,在ORIGA 数据集使用平均绝对值误差(mean absolute error,MAE)与豪斯多夫距离(Hausdorff distance,HD)来衡量预测结果与标签之间的差异。

评价指标MAE 表示所有预测结果与标签之间绝对误差的平均值,计算式为

式中,y与y’分别代表预测像素与标签像素,n为像素数量。

豪斯多夫距离(HD)在图像分割任务中应用广泛,主要用来评估预测结果的边界分割性能。计算式为

式中,A、B分别代表预测结果集合与标签集合,sup表示计算一个集合最小的上界,inf 表示计算一个集合最大的下界。

3.4 实验结果及分析

3.4.1 网络模块间消融实验

本文在以下4 个方面进行消融研究:1)基本模块;2)模块位置;3)预训练权重;4)损失函数。所有消融研究都遵循相同的实施方案。

首先,为了验证所采用模块的性能,在ORIGA数据集与Drishti-GS1 数据集上验证本文提出的4 个模块(限制对比度自适应直方图均衡CLAHE、ECA模块、残差空洞卷积模块RAC 以及路径增强模块PAM)的有效性。基础网络(baseline)仅采用经过预训练ResNet34 的改进U-Net 网络,不包含上述模块。实验结果如表1所示,baseline 在ORIGA 数据集上分割视盘的JC与Fmeasure指标分别为0.929 4与0.963 4,视杯分割分别为0.769 2 与0.869 5;在Drishti-GS1数据集上视盘分割分别为0.935 5 与0.966 7,视杯分割分别为0.812 3 与0.896 4。在baseline 的基础上分别使用上述4 个模块,模型分割性能都有明显的提升,体现了各个模块的有效性。此外,再将性能提升较为明显的ECA、RAC 以及PAM 模块分别组合进行训练,结果表明,当4 个模块组合使用时分割精度提升最多,在视盘分割中ORIGA 数据集上JC与Fmeasure比baseline 分别提高了1.04%与0.54%;在Drishti-GS1 数据集上分别提高了1.69%与0.86%。同时,4 个模块组合在视杯分割相比baseline 也有不小的提升,在ORIGA 上JC与Fmeasure比baseline 分别提高了3.33%与1.84%;在Drishti-GS1 上分别提高了6.28%与3.37%。

表1 不同模块对模型精度的消融实验对比Table 1 Comparison of ablation experiments with different modules on our algorithm accuracy

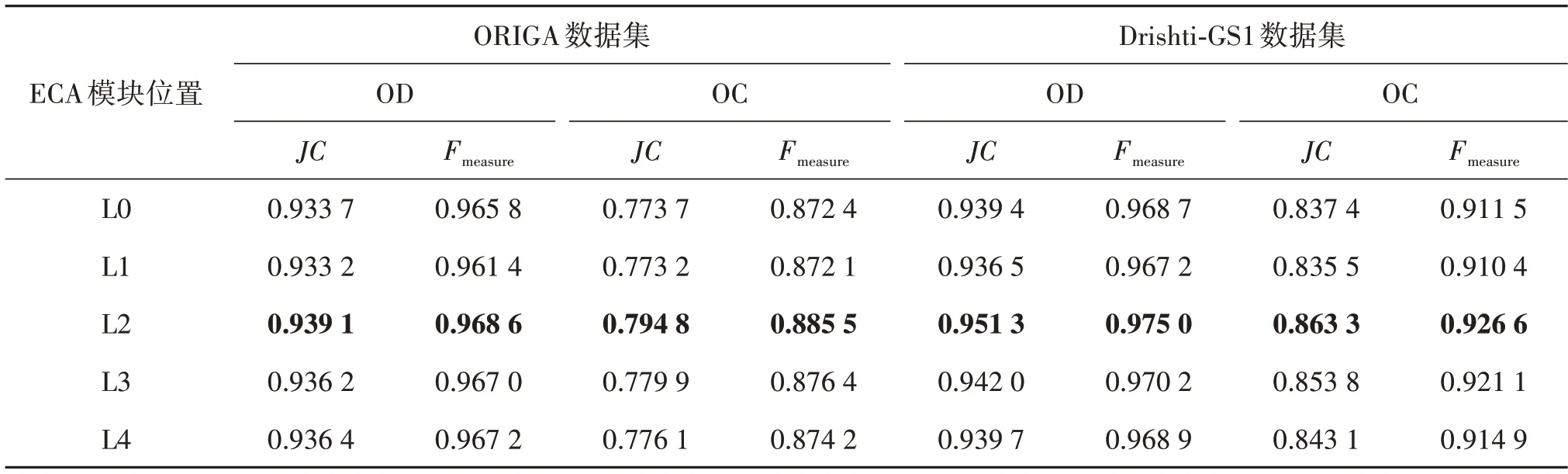

ECA 模块可以加到特征编码器的任何一个位置,不同位置对模型分割性能的影响也不同,针对不同数据集测试的位置如图10所示。其中,L0表示不加ECA 模块;L1 表示在第1 个7 × 7 卷积后;L2 表示在全部特征编码器模块后(不包括第1 个7 × 7 卷积);L3表示在最后一层特征编码器模块后;L4表示在全部特征解码器模块后。

图10 ECA模块的不同位置Fig.10 Different locations of ECA module

为了验证ECA 模块不同位置对模型分割精度的影响,本文在ORIGA 数据集与Drishti-GS1 数据集上分别对ECA 模块的位置进行对比实验,实验结果如表2 所示。可以看出,当ECA 模块在L2 位置时,分割模型性能达到最优,在ORIGA 数据集上视盘分割结果相比不加ECA 模块,JC与Fmeasure分别提高了0.58%与0.29%;视杯分割结果分别提高了2.73%与1.50%。在Drishti-GS1数据集上视盘分割结果分别提高了1.27%与0.65%;视杯分割结果分别提高了3.10%与1.66%。在L1 位置时,相比于不加入ECA模块,视盘和视杯分割精度反而下降,这可能是因为在第1 个卷积后,浅层特征图感受野较小,只能覆盖小目标,无法实现对于整体视盘或视杯的精准分割。基于实验数据结果,本文模型将ECA 模块放在L2位置上,即在全部特征编码器模块后。

表2 ECA模块位置对分割精度的影响Table 2 Influence of ECA module position on segmentation accuracy

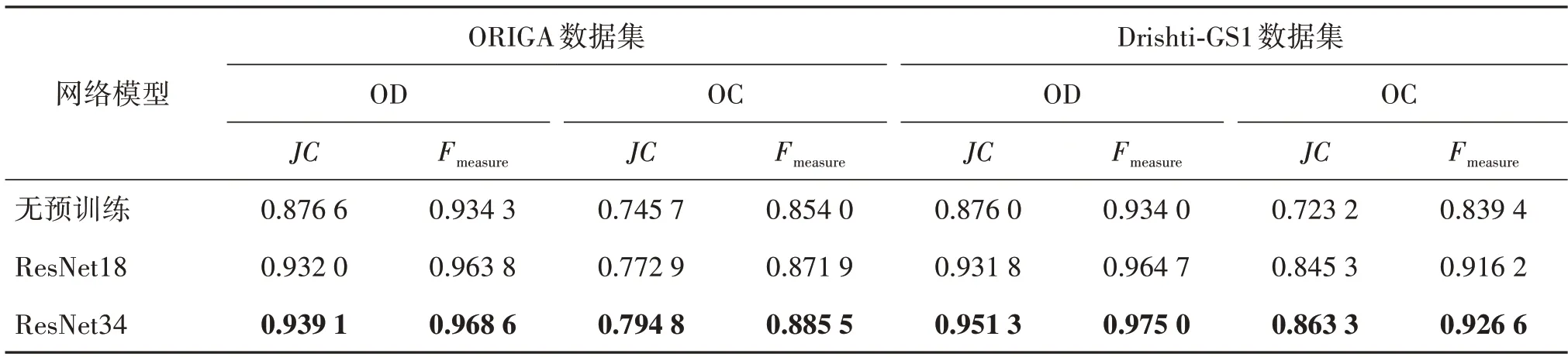

为了验证不同特征提取网络等因素对于分割精度的影响,在ORIGA 和Drishti-GS1 数据集上做了对比实验,结果如表3 所示。相比不经过预训练,加载预训练权重明显提升了模型的分割精度,防止由于网络参数过多造成过拟合的现象。此外,不同预训练权重对于网络模型的性能也有明显差异,ResNet34 作为特征提取网络得到的预测结果好于ResNet18,在ORIGA 上加载ResNet34 预训练权重相比不加载预训练权重,视盘分割的JC与Fmeasure分别提高了7.13% 与3.67%;视杯分割分别提高了6.58%与3.69%;在Drishti-GS1 上视盘分割分别提高了8.60%与4.39%;视杯分割分别提高了19.37%与10.39%。因此,本文采用ResNet34 作为预训练骨干模型,加强特征信息提取的同时促进视盘和视杯分割精度的提升。

表3 不同因素对分割精度的影响Table 3 Influence of different factors on segmentation accuracy

最后,为了验证模型中损失函数的有效性,将损失函数中的Dice 系数与Focal Loss 分别在ORIGA 数据集上进行对比实验。实验结果如表4 所示,相比于将两个损失函数结合起来,单个损失函数进行训练分割结果精度较低,组合使用后性能提高更明显,更适合应用在视盘和视杯分割任务中。

表4 不同损失函数在ORIGA数据集对分割精度的影响Table 4 Influence of different loss functions on the segmentation accuracy on ORIGA dataset

3.4.2 与其他方法对比实验

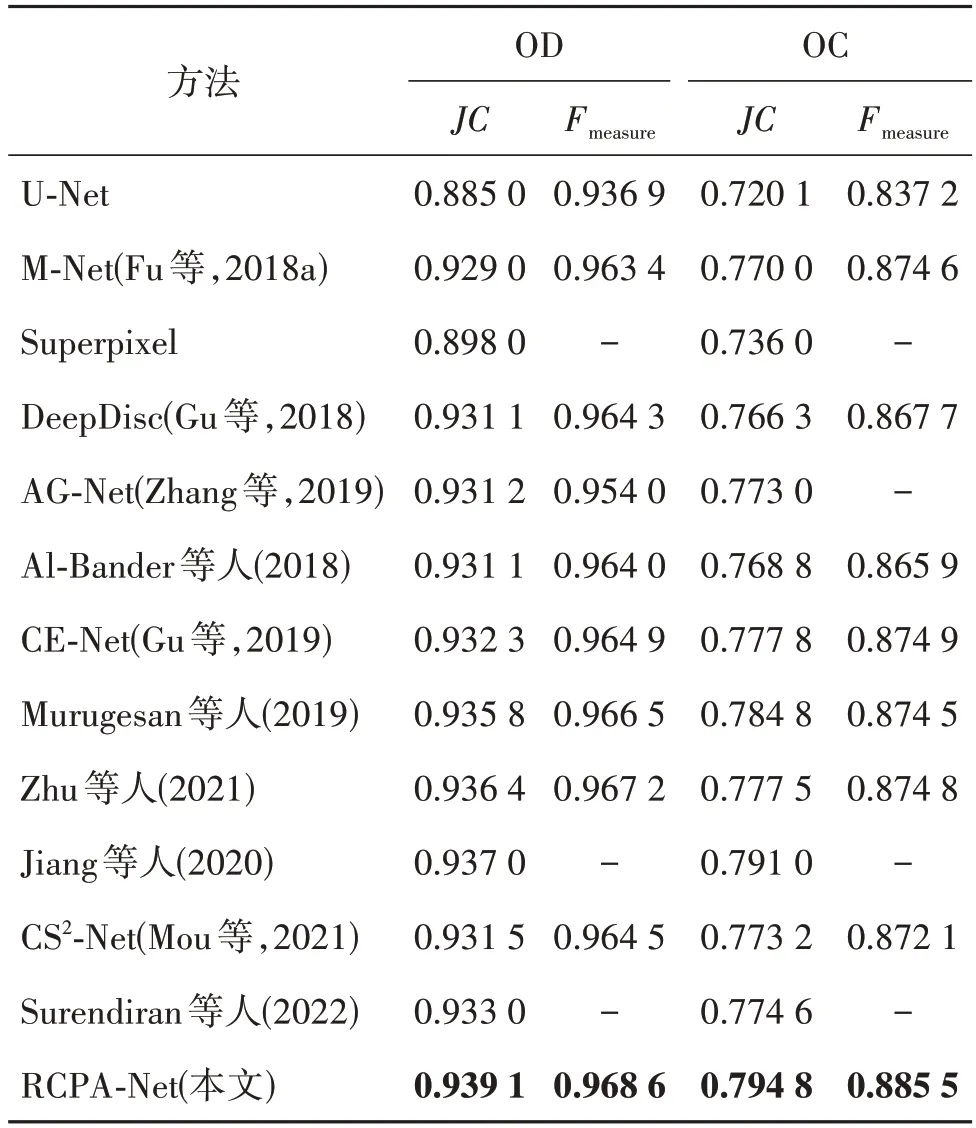

为了验证RCPA-Net 网络模型在视盘和视杯分割任务上的泛化性与有效性,与已有的多种方法在4 个数据集上分别比较,包括与U-Net、M-Net 和CENet等其他主流医学图像分割网络进行对比实验,训练过程中每组数据预处理权重参数均统一。首先,在ORIGA 数据集上对比,实验结果如表5 所示。通过评价指标的计算可以看出,RCPA-Net领先于目前的主流视盘视杯分割算法,视盘分割的JC与Fmeasure分别为0.939 1与0.968 6。相比于U-Net算法,分别提高了6.11%与3.38%;视杯分割的JC与Fmeasure分别为0.794 8 与0.885 5,比U-Net 算法分别提高了10.37% 与5.77%;比CE-Net 算法分别提高了2.19%与1.21%。在ORIGA中,RCPA-Net在两个指标中均达到了最优,说明了网络的有效性。

表5 不同方法在ORIGA数据集的分割结果比较Table 5 Segmentation comparison results of different methods on ORIGA dataset

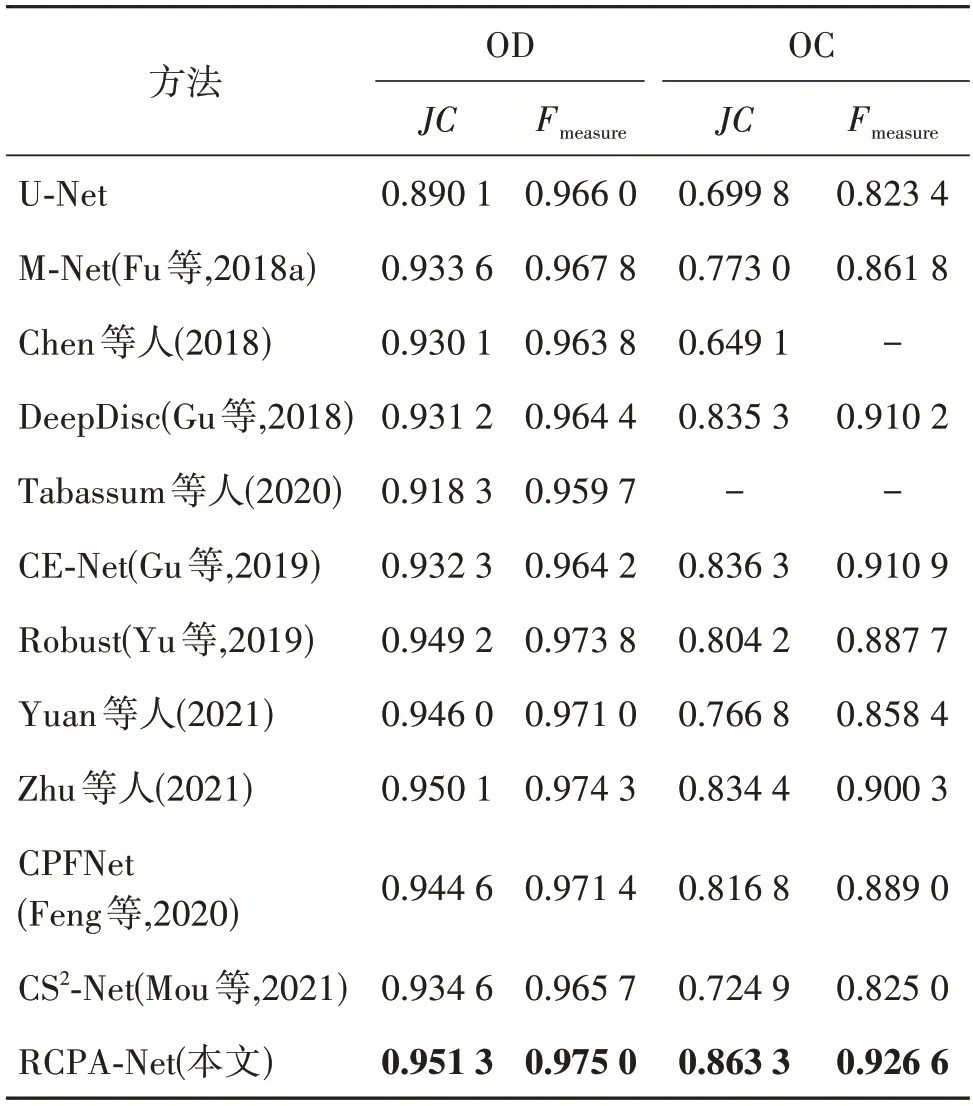

在Drishti-GS1数据集上进行实验得到的结果如表6 所示。可以看出,RCPA-Net 分割视盘的JC与Fmeasure分别为0.951 3与0.975 0,相比于U-Net,分别提高了6.88%与0.93%;相比CE-Net,JC提高了2.04%;相比最近提出的CS2-Net,JC提高了1.79%。RCPA-Net 分割视杯的JC与Fmeasure分别为0.863 3 与0.926 6,比U-Net 分别提高了23.36%与12.53 %,比CPFNet 提高了5.69%与4.23%,比CE-Net 提高了3.23%与1.72%。

表6 不同方法在Drishti-GS1数据集的分割结果比较Table 6 Segmentation comparison results of different methods on Drishti-GS1 dataset

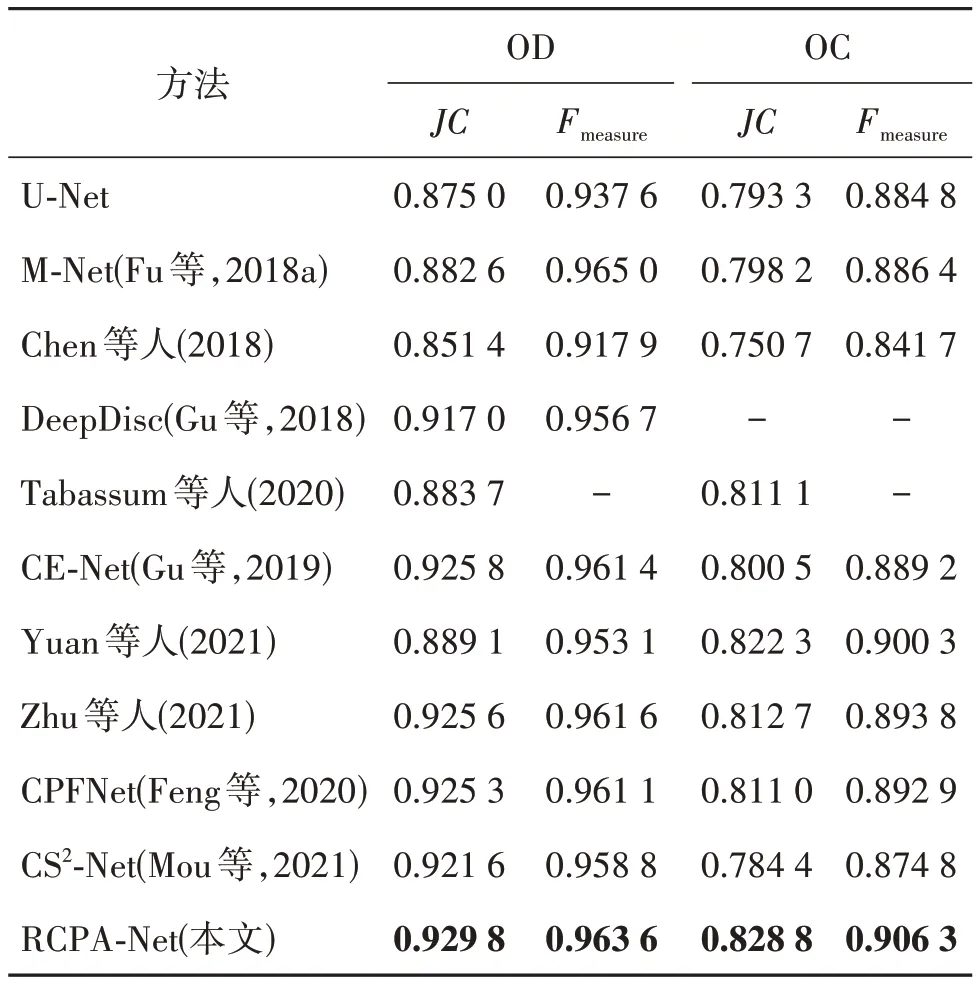

从表7 可以得到,在Refuge 数据集上,分割视盘的JC与Fmeasure分别为0.929 8 与0.963 6,相比于U-Net 分别提高了6.26%与2.77%;相比CS2-Net 分别提高了0.89%与0.50%,相比CE-Net,JC提高了0.43%。RCPA-Net 分割视杯的JC与Fmeasure分别为0.828 8 与0.906 3,比U-Net 分别提高了4.47%与2.43%;比CS2-Net 提高了5.66%与3.60%,比CENet提高了3.54%与1.92%。RCPA-Net得到预测结果的评价指标均优于其他对比算法,在视盘和视杯分割任务中展现了更高的分割精度。

表7 不同方法在Refuge数据集的分割结果比较Table 7 Segmentation comparison results of different methods on Refuge dataset

RIM-ONE-R1 数据集中有5 个独立的金标准,RCPA-Net 模型通过实验分别得到了5 类预测视盘图像并计算平均值,如表8 所示。JC与Fmeasure指标在视盘分割中分别为0.929 0与0.962 8,比U-Net分别提高了7.21%与3.69%;比CE-Net 提高了2.03%与1.01%;比CS2-Net 提高了3.03%与1.12%。实验研究过程中发现,RCPA-Net在部分专家的金标准下由于图像中视网膜血管等因素的干扰导致分割性能稍差,但总体结果显示RCPA-Net的性能优于CE-Net等主流算法。

表8 不同方法在RIM-ONE-R1数据集的分割结果比较Table 8 Segmentation comparison results of different methods on RIM-ONE-R1 dataset

为了验证RCPA-Net 对于视盘和视杯分割边界的性能,在ORIGA 数据集通过使用作者公开代码分别复现了U-Net、CE-Net 和最近提出的GDCSeg-Net网络(Zhu等,2021)的MAE 和豪斯多夫距离(HD)结果,并对预测结果的边界进行评估分析。对比实验结果如表9 所示,RCPA-Net 分割视盘的MAE与HD分别为0.009 7与7.6923,分割视杯的MAE与HD分别为0.014 1 与14.239 4,均低于对比网络,说明RCPA-Net分割结果边界与原标签边界更相近,吻合度更高。

表9 不同方法在ORIGA数据集对视盘和视杯边界分割精度的影响Table 9 Influence of different methods on the accuracy of optic disc cup boundary segmentation on ORIGA dataset

为验证RCPA-Net的泛化性能,本文进行跨库实验验证,采用ORIGA 上训练得到的模型,分别在Drishti-GS1 与RIM-ONE-R1 测试集上进行测试,实验过程中复现了U-Net、CE-Net 和GDCSeg-Net 的结果,并与本文模型进行对比,实验结果如表10 所示。可以看出,在Drishti-GS1 测试集中,分割视盘的JC与Fmeasure分别为0.946 5 与0.972 5,分割视杯的JC与Fmeasure分别为0.816 3 与0.897 2。在RIM-ONER1 测试集中选取5 个金标准分别预测视盘,得到5 个 结果取平均 后,JC与Fmeasure分别为0.862 7 与0.924 6。相比在Drishti-GS1的分割结果,RCPA-Net在RIM-ONE-R1 的分割精度有所降低,可能的因素有RCPA-Net 在ORIGA 数据集训练的图像特征与Drishti-GS1 数据集更为相似,所以得到的分割结果更精确。综合可知,RCPA-Net在跨数据集实验测试中仍表现优于其他主流的分割算法,说明其泛化性强。

表10 不同方法在Drishti-GS1与RIM-ONE-R1测试集的分割结果对比Table 10 Comparison of segmentation results on Drishti-GS1 and RIM-ONE-R1 testing datasets among different methods

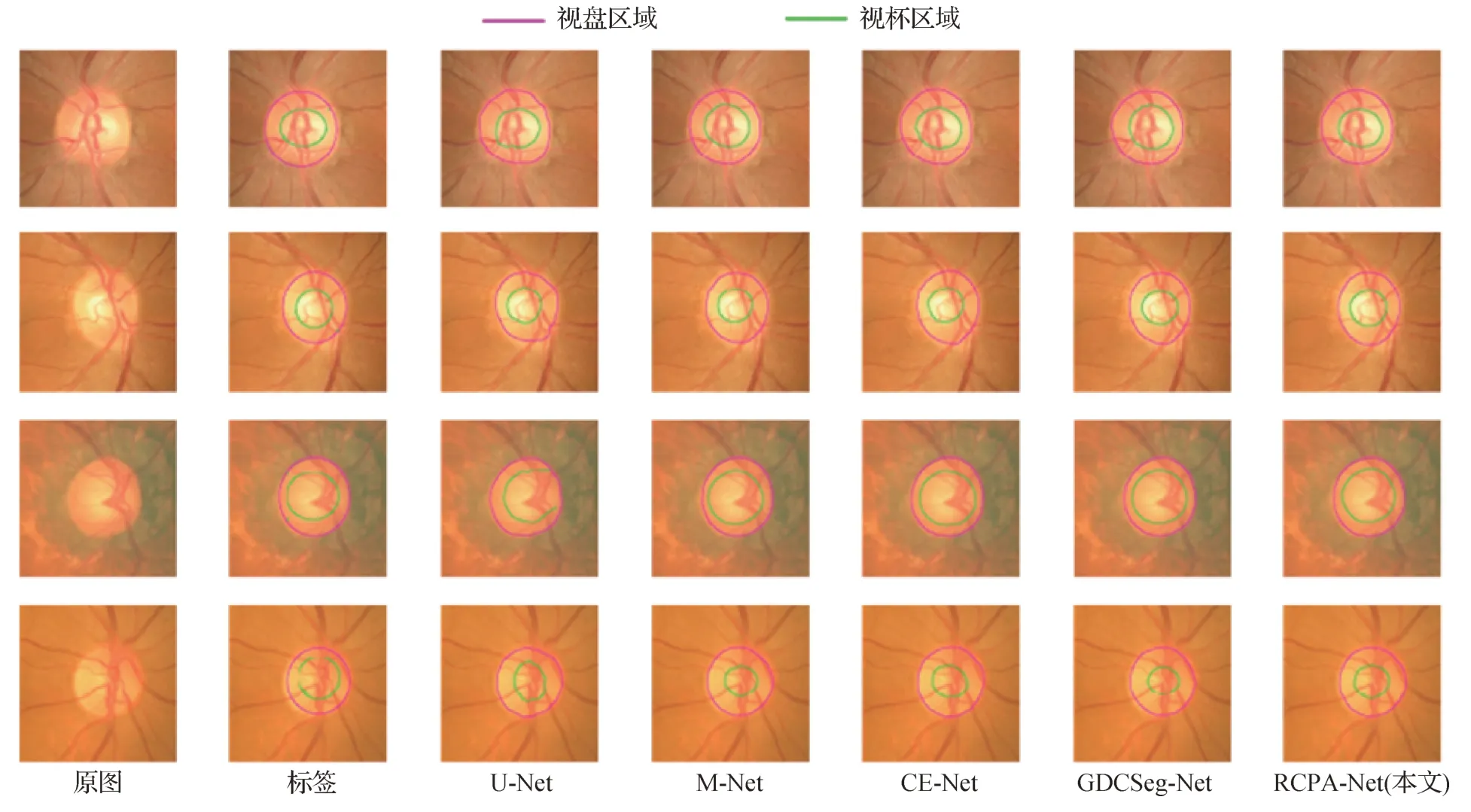

3.4.3 分割结果可视化

本文提出的RCPA-Net 在4 个公开数据集上均表现最优,为了进行更加直观的比较,图11 展示了在ORIGA 数据集上选取的4 幅图像的数据可视化,可以看出本文的分割网络在性能上与其他网络相比取得了明显提升,通过U-Net 网络训练得到的视盘和视杯预测区域较为粗糙,M-Net 网络分割结果定位精度偏低,与CE-Net 等网络相比,本文模型预测图像更接近标签图像,分割结果更准确。

图11 不同方法在ORIGA数据集的分割结果比较Fig.11 Comparison of segmentation results of different methods on ORIGA dataset

图12 为不同方法在Drishti-GS1 数据集上的分割结果比较,与ORIGA 数据集中眼底图像相比,Drishti-GS1数据集图像对比度低,图像比例不均,更难达到精准的预测结果。从图中可以看出,U-Net网络分割出的视盘和视杯区域不规则,M-Net 网络分割出的区域边界不连续,而RCPA-Net的预测结果更加接近专家手动标注的真实结果。

图13—14 为本文 网络与U-Net、CE-Net、GDCSeg-Net 和M-Net 网络在Refuge 数据集与RIMONE-R1 数据集中选出4 幅图像进行的分割结果可视化对比,其中RIM-ONE-R1 数据集在图中展示的4 组分割结果以其中一种金标准为标签,且仅有视盘分割,而Refuge 数据集相比其他3 个数据集图像对比度更低,分割难度更大。通过与其他流行算法模型的实验结果对比可以看出,RCPA-Net 可以更好地识别视盘和视杯区域,分割结果边界平滑且连续。尽管部分眼底数据集因为视网膜病变或者视网膜血管挡住视盘和视杯等因素导致分割结果出现偏差,但是整体结果仍显示RCPA-Net 的预测结果更加接近真实标签,并优于对比的分割方法。

图13 不同方法在Refuge数据集的分割结果比较Fig.13 Comparison of segmentation results of different methods on Refuge dataset

图14 不同方法在RIM-ONE-R1数据集的分割结果比较Fig.14 Comparison of segmentation results of different methods on RIM-ONE-R1 dataset

4 结论

眼科图像视盘和视杯分割在疾病诊断中具有重要意义。本文提出一种端到端的RCPA-Net 网络应用于眼底图像中视盘和视杯分割任务。相比于传统的编码器解码器网络,RCPA-Net采用残差空洞卷积模块以及路径增强模块来捕获更深层次的特征以及更精准的定位信息,侧输出层产生局部预测图,有利于早期的训练。此外,在图像预处理阶段采用限制对比度自适应直方图均衡来增强图像对比度,更清晰地显示视盘和视杯边界信息。在ORIGA、Drishti-GS1、Refuge 和RIM-ONE-R1 4 个数据集上进行实验,结果表明在不同数据集上RCPA-Net的分割性能均优于对比的视盘和视杯分割网络,证明了本文方法的有效性。虽然RCPA-Net 对分割性能的提升较为显著,但是模型中包含大量模块组合,增加了训练时长。另外在视杯分割任务中,模型精度没有太明显的提升,主要是由于视杯区域边界模糊等限制,尤其是在一些对比度低的图像上,视盘和视杯分割精度差异较大。未来工作拟用自监督学习代替残差网络作为主干,在缩短训练时间的同时提高网络分割精度。