全监督和弱监督图网络的病理图像分割

沈熠婷,陈昭*,张清华,陈锦豪,王庆国

1.东华大学计算机科学与技术学院,上海 201620;2.上海市第一人民医院,上海 200080

0 引言

随着科技的进步,医学领域成像技术也在飞速发展,数字病理图像给病理诊断、教学带来极大便利(Anwar 等,2018)。在癌症的诊断和治疗中,计算机辅助诊断技术和显微病理图像处理技术起到了重要的作用,显微病理图像技术可以处理常规的RGB 图像和高光谱图像等(Li 等,2013)。病理图像分割技术是显微病理图像处理技术的重要分支,其一般指将目标区域(例如肿瘤细胞、腺体、癌巢)从背景中分离出来,进而用于癌症分级、生存预测等下游任务。传统的病理图像分割是依据医生和专家自己的经验来确定病变区域,需要医生手动标注,这不仅会花费大量的时间,还可能导致漏检和误检。因此,自动化组织病理学图像分析在临床实践中具有重要的应用价值,其可以准确地识别和定位病变区域,帮助医生更快速、更精准地诊断和治疗疾病,同时可以避免因为手工勾画带来的误差和不一致性。

随着人工智能特别是深度学习技术的快速发展,基于深度学习的图像分割方法取得了良好的效果(Jia 等,2017;Zhu 和Li,2023)。现有大多数深度学习网络采用全监督学习模式,依赖于精准的标注,但是由于细粒度注释需要经验丰富的病理学家的高水平专业知识且标注工作费时费力,因此具有精确标注的数据集极少。同时,病理组织学图像具有以下3 种特征,使得现有方法分割结果并不理想。1)目标和背景很难辨别,导致类间同质性;2)同一组织的数据集中,病理对象之间存在很大差异,表现出类内异质性;3)患者之间的差异与图像特征之间的非线性关系,使得多数算法需要重新训练才能适配新的数据集。Chen 等人(2021)引入了局部监督信息,其针对前景与背景区分度不高、病理图像的类内异质性强的问题提出了解决方案,但是没有很好地捕捉图像特征之间的非线性关系,因此使仍存在较多漏检误检区域和噪声。

为了使模型能够挖掘数据之间的非线性潜在特征,许多学者提出使用图学习的方法来提高模型适应复杂数据图像的能力(Kipf 和Welling,2017;Lu等,2019;Anklin 等,2021)。图学习中的一个关键部分是图网络,包含图结构的模型可以称为图网络(Battaglia 等,2018),例如WSNTG(weakly supervised network based on tensor graphs)模型(Zhang 和Chen,2022)、BASGCN(backtrackless aligned-spatial graph convolutional network)模型(Bai 等,2022)。针对病理图像中腺体等局部组织的识别问题,本文提出了一种新颖的基于图网络的分割框架,其具有全监督和弱监督两种训练模式。

本文主要贡献如下:1)框架可根据不同数据集的人工标注量和精度需求灵活转换为全监督图网络模式(full supervised graph network,FSGNet)或弱监督图网络模式(weakly supervised graph network,WSGNet);2)将弱监督语义分割转化为超像素分类问题,在少量点注释的情况下有效地处理病理图像,期望将病理学家从繁重的注释工作中解放出来;3)所提出的框架利用图卷积网络(graph convolutional network,GCN)来处理组织病理学图像中的不规则形态,能够准确分割不同的组织。实验结果表明,所提框架可以从多种染色方式的数据集成功分割出不同组织,分割精度优于多种经典和先进方法,弱监督模式的评价指标不仅能超过其他弱监督算法,还能超过一些全监督算法。

1 相关工作

1.1 全监督病理组织图像分割

全监督分割方法是指通过像素级标签数据来训练分割模型。全卷积网络(fully convolutional network,FCN)(Long等,2015)、U-Net(Ronneberger等,2015)等分割网络在精细刻画边缘方面具有很强的优势。

在病理图像分割领域,Long 等人(2015)首次提出的FCN 是一个能进行端到端像素预测的网络。Chen等人(2016)基于FCN结构提出一个高效的深度轮廓感知网络,利用辅助监督和辅助损失函数来进一步提升模型对中间特征的判别能力。Gunesli等人(2020)引入了自适应机制,提出一种新的基于自适应的多注意力学习模型,为FCN 引入了一种新的损失调整机制,用于组织病理图像中腺体实例的分割。为了进一步提高模型的预测效率,Ronneberger 等人(2015)提出了U-Net结构,在上采样之间加入跳跃连接,将高层抽象特征和底层细节图像特征进行结合,在一定程度上弥补了FCN 的不足,是医学病理图像上一个里程碑式的工作。Zhou等人(2020)设计嵌套结构并重新设计了跳跃连接,提出U-Net++。Lu等人(2019)提出了Graph-FCN模型,首次将图卷积网络应用于图像语义分割任务,利用GCN 的结构特点扩大感受野和接受野,避免局部位置信息的丢失。Zhang等人(2021)提出FGNet(fully convolutional and graph convolutional networks),通过动态超像素操作将FCN和图卷积网络连接起来,使模型可以自动分割病理图像。

基于全监督的病理图像分割模型训练时需要大量的像素级标签数据,而这些数据需要经验丰富的医生或病理专家才能进行注释,现有符合上述条件的数据集较少。学者们提出了众多办法来减少模型对大量像素级标注数据的依赖,基于弱监督的病理图像分割方法是可行途径之一。

1.2 弱监督病理组织图像分割

弱监督是指提供的一些先验知识,但这些先验知识远少于完成任务所需要的信息。在基于弱监督的图像任务中,图像具有部分监督标签信息,但又不像全监督那样精准。在病理图像分割任务中,基于弱监督的方法逐渐成为一种流行,常见的弱监督信息包括图像级标签(Ahn 等,2019)、边框标签(Yang等,2018)和点标签(Bearman等,2016)等。

Bearman 等人(2016)采用点标签的方式来训练语义分割网络,引入物体性约束来避免优化少数已标记像素时陷入局部最优。Qu 等人(2020)用新型弱监督细胞核分割方法,首次将点标签应用到细胞核分割问题。Zhao 和Yin(2021)提出一种基于弱监督端到端的细胞分割网络,研究了利用点标注训练网络的3种训练方案。Kipf 和Welling(2017)提出一种可扩展的弱监督学习图结构数据的方法,使用图结构表示不规则数据,使网络能够表示远程上下文信息。Anklin 等人(2021)用基于图的弱监督分割方法,利用不精确和不完整注释分割任意图像,用图节点描绘组织区域,学习图形节点的上下文特征。

弱监督算法极大地缓解了全监督算法像素级标签数据不足的问题。但由于病理图像的复杂性,弱监督模型的泛化性和鲁棒性还有待进一步加强。

2 方 法

2.1 整体框架

为适应不同数据集的标注量和精度需求,本文提出了一个灵活的框架,在具有像素级标签的数据样本且对精度要求较高时,以全监督模式进行训练,如图1(a)所示;在样本只有稀疏点标签时,以弱监督模式学习病理图像信息并训练分割网络,如图 1(b)所示。全监督模型FSGNet由主干网络和图网络GCN 组成。主干网络为编码—解码器,用于提取病理图像深层特征,实现病理组织分割;GCN 可以处理任意结构的数据,通过对病理图像构建拓扑图来学习图像的非线性结构,能够更好地表示病理组织的不规则形态,提高整个网络的性能,有助于提升病理图像分割的精度。弱监督模型WSGNet 将语义分割问题转化为超像素分类问题,以弱监督的方式训练模型。同时使用GCN 进行图拉普拉斯正则化,提升模型的鲁棒性和泛化性,降低过拟合风险,在标注量不足时也有出色的表现。

图1 整体框架(浅色代表前景,深色代表背景)Fig.1 The scheme of framework(light colour stands for foreground and dark colour for background)((a)FSGNet,where samples have pixel-level labels;(b)WSGNet,where samples only require sparse point labels)

2.2 基于图网络的全监督分割模式

FSGNet 将图像输入到主干网络中,学习其深层特征,然后用GCN 进一步学习病理组织非线性结构,提高网络表达和泛化能力,最终将目标从背景中分割出来。该模式框架如图2所示。

图2 全监督模式细节示意图Fig.2 The detail diagram of FSGNet

2.2.1 全监督主干网络

如图2 所示,FSGNet 使用从头训练的UNeXt(Valanarasu 和Patel,2022)作为全监督模式的主干网络Ψ0,学习病理图像深层特征,实现病理组织分割。UNeXt 是一种基于卷积多层感知器(multilayer perceptron,MLP)的图像分割网络,是一种编码器—解码器体系的网络,适用于FSGNet通过分割掩膜回归来实现病理图像分割,其结构如图3所示。

图3 全监督区域分割主干网络结构Fig.3 Fully supervised segmentation backbone framework

通过UNeXt 提取病理图像特征的流程如下:用X∈RW×H×3表示一幅病理图像,其中W和H分别代表宽度和高度。输入的病理图像首先通过编码器,编码器前3 个是卷积块,后2 个是Tok-MLP,每个编码器卷积块将特征分辨率降低为之前的1/2。然后再通过解码器,解码器有2 个Tok-MLP 和3 个卷积块,每个解码器块将特征分辨率提高2 倍。UNeXt中的每个卷积块都有一个卷积层、一个批量归一化层和ReLU(rectified linear unit)激活层,不同编码器或解码器之间还存在池化层或上采样层。为了保证卷积输出特征大小与输入大小相同,本文对输入图像或特征使用边缘填充0 的方法。输出特征为F=[f1,f2,…,fi,…,fI]T∈RI×C,其中i是病理图像中单个像素索引,I为像素总数(I=WH),C为特征通道数,本文中C=1。卷积层能聚合像素周围局部信息,使网络获取局部区域特征。

UNeXt 采用MLP 模块,以有效标记和投影卷积特征,使其能更专注于学习局部依赖关系。UNeXt比U-Net(Ronneberger 等,2015)参数量更少,计算复杂度更低,有更好的图像分割性能。

2.2.2 图卷积网络

将UNeXt 提取的特征输入GCN,进一步学习病理组织的不规则结构,并进行病理组织分割。GCN是一种从数据的拓扑图中提取信息的神经网络,可以捕获上下文信息。拓扑图易于表达高维流形特征和非线性关系,适用于表征医学病理图像中形态不规则的组织(唐朝生 等,2021)。本文将其用于病理图像分割。通过使用图拉普拉斯正则化项促使整个网络学习相邻节点的相似特征(Smola 和Kondor,2003),有效聚集相似节点,提高模型的泛化能力。本算法的GCN 采用一跳(one-hop)邻域图G={V,E},其中,V表示顶点的集合,E是边的集合,每个顶点与其最近1 个相邻节点相连接,若一对顶点p,q∈V之间存在边(p,q),则(p,q) ∈E⇔(p,q) ∈E。节点之间的连接关系由邻阶矩阵A定义,式中1 表示两个节点存在边,0 表示两个节点不存在边。将图输入GCN,如图4 所示,在每一层聚合一跳邻域的信息,第l+1 层的输出特征表示为

式中,σ为非线性函数(如ReLU 函数),θl是第l层可训练权重矩阵,Zl为第l层输出是A的对称归一化(Kipf 和Welling,2017)。FSGNet使用主干网络编码器最终输出特征作为顶点,按照上述方法构建拓扑图,即令并输入GCN。

2.2.3 全监督目标函数及最优化

FSGNet 的损失函数包含两部分:主干网络分割损失和图网络正则化项。主干网络UNeXt 使用二元交叉熵(binary cross entropy,BCE)和Dice 系数之和作为损失函数进行训练。由于图像分割可视为前景和背景二分类,故主干网络目标函数包含二分类损失函数BCE,并用Dice 系数表示真实区域和预测区域的相似性和重叠程度。通过最小化这两个损失函数之和,使模型更准确地学习病变区域的位置和形状。主干网络的损失函数定义为

式中,yi为该像素真实标签为模型对该像素的预测值。二元交叉熵损失函数定义为

式中,I为像素总数。Dice损失定义为

基于GCN的图拉普拉斯正则化项定义为

式中,yg是GCN 输出,Ag是图邻接矩阵。由此,FSGNet损失函数为

式中,λ为图拉普拉斯正则化项平衡因子,本文将其设置为0.3。采用随机梯度下降(stochastic gradient descent,SGD)实现FSGNet 参数最优化(Richie 等,2023)。

2.3 基于图网络的弱监督分割模式

FSGNet 需要使用像素级标签的数据集进行训练,对病理图像进行精准的语义分割;当对精度要求不高且标签数据不足时,本文提出基于图网络的弱监督模式(WSGNet),将病理图像语义分割转化为超像素二分类的问题。该模式框架如图5 所示。在WSGNet 中,首先将数据集中的病理图像进行超像素分割,再将超像素分割后的图像输入弱监督主干网络,学习超像素层级化特征并训练分类模型,使用GCN 对超像素层级化特征进行拉普拉斯正则化,提升WSGNet的鲁棒性和泛化性。

图5 弱监督模式细节示意图Fig.5 The detail diagram of WSGNet

2.3.1 点标签生成超像素标签

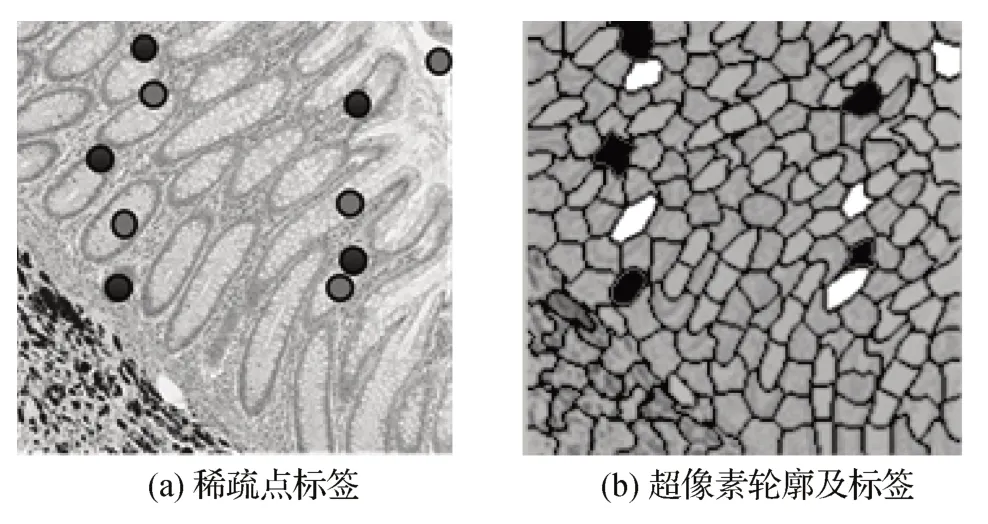

为了对病理图像进行预处理,将原本对图像的点标签变成对图像超像素的标签。超像素利用局部空间相似性能够大幅度降低后续处理的计算复杂度。本文使用SLIC(simple linear iterative clustering)(Achanta 等,2012),其具有出色的效率和边界粘附性,可以更快更好地表征病理组织轮廓。点标签的语义信息可以扩散到整个超像素区域,从而生成超像素标签。这种扩散操作有助于减少像素级标注的工作量,可以使用极少的点标签来对完成对病理图像的分割,并提供对超像素级别的语义信息,将后续对图像的语义分割转变为对超像素的分类。使用SLIC将病理图像X分割成超像素其中,M是超像素的数量。为了获得超像素标签其中,ML是带有标签的超像素的数量,采用众数投票机制,以出现次数最高的标签作为该超像素的标签;如果某个超像素没有包含任何点标签,则将该超像素标签记为空。

图6 展示了一幅病理图像的稀疏点标签及其通过SLIC 算法过分割生成的超像素。其中,黑边表示超像素轮廓,深色和浅色分别表示通过稀疏点标签生成的目标类超像素和背景类超像素。

图6 稀疏点标签以及超像素轮廓和标签Fig.6 Sparse point labels and superpixel contours and labels((a)sparse point labels;(b)superpixel contours and labels)

2.3.2 弱监督主干网络

预处理完成后,为了得到图像特征,WSGNet 使用在ImageNet(Russakovsky 等,2015)上进行预训练的VGG-16(Visual Geometry Group)(Simonyan 和Zisserman,2015)模型,并在此基础上进行一些改进,作为弱监督模式提取病理图像特征的主干网络Ψ1,如图5所示。

由于VGG-16 是一个较深的神经网络模型,因此能够学习更复杂的特征表示,有助于识别目标的边缘和纹理等细节,从而提高模型的表达能力和学习能力,更适用于处理病理图像这种复杂的任务。其没有编码器的结构,因此无法做语义分割,但适用于WSGNet 通过超像素分类来实现分割的任务。除此之外,VGG-16 网络中的卷积层参数是共享的,可以减少模型的参数量,提高模型的效率。本文将VGG-16 最后的1 × 1 全连接层去掉,并改进了后续的池化层,增加了双线性插值方法,将每个卷积层的特征图输出到与Xn相同大小,使该网络能接受任意大小的图像输入。主干网络Ψ1的输入为一幅病理图像X∈RW×H×3,经过Ψ1后得到所有卷积层输出的特征图其中,Lconv是主干网络中的卷积层数为第l层的特征图。

2.3.3 层级特征图网络

为了高效实现弱监督分割,本文对原始图像进行超像素分割,将目标和背景分割问题转换为所有超像素分类问题,如图2 所示。本文使用层级化特征表示超像素特征(Zhang 和Chen,2022),使用多尺度训练和推理,对目标进行随机缩放,获得对目标尺寸差异的鲁棒性。首先将主干网络Ψ1中获得的每个卷积层的特征图通过双线性插值算法上采样到与Xn相同的大小。接下来串联起所有的特征图得到fh。通过将超级像素的轮廓叠加在fh上,并对每个超级像素内的像素的深层特征进行平均,产生了超级像素的深层特征fm。但此时所有卷积层特征图的维度过大,执行效率低,本文使用MLPΨ2非线性映射降低其维数,降维后的特征即为超级像素Sm的层级化特征hm,hm的特征维度远小于fh的维度。如图5 所示,与全监督FSGNet 类似,弱监督WSGNet 将超像素层级化特征hm输入GCN,进一步学习其中的非线性结构,GCN的构造如图4所示。

2.3.4 层级特征图网络

除了将超像素层级化特征hm输入GCN,WSGNet 还将其输入分类器Ψ3,预测各超级像素Sm的类别(病理目标或背景),即=Ψ3(hm)。超像素分类损失函数为

式中,ym为每个超级像素Sm的真实类别为每个超级像素Sm的预测类别,ςm是处理类别不平衡的类别特定类别权重,g(⋅)是交叉熵损失。

同2.2 节,为了提高模型的表征能力,WSGNet将GCN 学习得到的图拉普拉斯(式(7))作为正则项加入总损失,得到联合分类损失函数。具体为

采 用SGD 实 现WSGNet 参数最优化(Richie 等,2023)。

3 实验与分析

本节介绍并分析了多个先进算法在3 个组织病理学数据集上的实验结果,以证明FSGNet 和WSGNet的有效性和普遍性。

3.1 数据集

本文通过4 个病理图像数据集来评估提出模型以及多种对比算法模型的性能。

1)公开的腺体分割挑战数据集GlaS(Gland Segmentation Challenge Dataset)(Sirinukunwattana 等,2017),包括165 幅病理组织图像,来自16 幅苏木精和伊红(hematoxylin and eosin,H&E)染色T3 或T4期结直肠腺癌病理的组织学全切片,由蔡司MIRAX MIDI 全切片扫描仪扫描而成。其训练集和测试集的比例为85∶80,数据格式为位图(BMP),大部分病理图像尺寸为775 × 522 像素。数据集中每个全切片来自不同的病人,因此,该数据集在染色分布和组织结构等方面都具有较高的差异性。GlaS数据集根据组织学等级和视野进行分层,将测试集分为A 部分(60幅图像)和B部分(20幅图像)。

2)公开的结肠直肠腺癌数据集CRAG(colorectal adenocarcinoma gland)(Graham 等,2019),包 含213 幅放大20 倍的H&E 染色的大肠腺癌图像,大部分病理图像为1 512 × 1 516 像素,其训练集和测试集的比例为173∶40,图像格式为PNG(portable network graphics),每幅图像都具有完备的实例级标签。CRAG 数据集取自用Omnyx VL120 扫描仪扫描的38个H&E染色的全切片,其每个像素大小为0.55 μm,示例图像如图7所示。

图7 在GlaS,CRAG及LUSC数据集上分割效果Fig.7 Segmentation performance on the GlaS,CRAG and LUSC datasets

3)私有的肺鳞状细胞癌数据集,LUSC(lung squamous cell carcinoma)。该数据集由合作公司中国上海组织病理诊断中心(Histo)提供,包含110 幅免疫组化染色的PD-L1 图像,其训练集和测试集的比例为70∶40,图像格式为PNG。该数据集来自4幅染色全切片,其使用KF-PRO-120数字切片扫描仪在40 倍物镜放大倍率进行扫描获取,每幅病理图像均为1 000 × 1 000像素,示例图像如图7所示。

4)公开的多维胆管癌数据集MDC(multidimensional choledoch)(Sun 等,2022),包含538 个场景,具有用于二进制MHSI(medical hyperspectral imaging)分割任务的高质量标签,这些MHSI 由具有20倍物镜的高光谱系统收集,MDC 的波长从550 nm到1 000 nm。每个场景产生60 个光谱带。该数据集的单波段图像的大小都被调整为256 × 320 像素。使用以患者为中心的硬分割方法将数据集划分为训练集和验证集,比例为3∶1,图像格式为hdr 和img。每个患者的数据都被完全分配到3 个集合中的某个集合,以确保同一患者的数据不会出现在多个集合中,示例图像如图8所示。

图8 由UMAP方法对FSGNet和WSGNet所学习到的特征进行可视化Fig.8 Visualization of the features learned by UMAP on FSGNet and WSGNet

3.2 实验设置

3.2.1 对比算法模型和评价指标

将FSGNet 算法模型与完全监督模型FCN-8(Long 等,2015)、U-Net(Ronneberger 等,2015)、UNeXt(Valanarasu 和Patel,2022)以 及YAMU(yet another modified U-Net)(Samanta 和Singhal,2022)进行比较;将WSGNet 模型与最近提出的弱监督模型MICRANet(microscopy analysis network)(Bilodeau等,2022)、WESUP(weakly-supervised framework)(Chen等,2021)、CDWS(constrained deep weak supervision)(Jia 等,2017)和SizeLoss(Kervadec 等,2019)进行比较。另外,还使用MDC 数据集来进一步证明本文所提模型不仅在RGB 图像上表现出色,在高光谱图像上也表现出良好的性能。使用整体像素级分类精度(overall accuracy,OA)和Dice 指数(Dice index,DI)作为模型分割性能评价指标,记录每个模型运行3 次得到的平均结果指标。OA 和DI 指标以百分比的形式记录,得分越高,代表模型性能越好。所有算法模型都由PyTorch框架编程实现,并运行在64 GB内存且GPU配置为NVIDIA GeForce RTX 3090的机器上。

3.2.2 弱监督点标签信息生成

本文模仿病理专家在实践中的做法为数据集产生弱监督标签。首先,从每幅训练图像的像素级标签中识别出目标和背景。然后,在目标和背景中随机选择少量的标签来形成稀疏点标签集,本文的点标签比例为0.001%。在弱监督实验中,GlaS、CRAG、LUSC 和MDC 四个数据集的点标签量分别约为20 点/样本、35 点/样本、25 点/样本和64 点/样本。其余弱监督配置与对比方法论文中描述一致。

3.2.3 超参数设置

在输入模型之前,每个输入样本都经过模糊、颜色抖动和翻转等数据增强处理。在弱监督训练中,对于多尺度训练和推理,GlaS、CRAG、LUSC 和MDC的缩放因子范围分别设置为[0.35,0.47]、[0.2,0.3]、[0.4,0.6]、[0.4,0.6]。对于SLIC 算法的设置,本文将每个超级像素的面积大小设定为约300像素,紧凑度参数设定为40。对于SGD 优化(Richie等,2023),动量设置为0.9,权重衰减为0.001,小批量大小为1,初始学习率为0.001,每次评估10 个轮次,对于每一次评估,如果整体损失没有减少,则学习率减半。这个过程持续进行,直到总体损失完全停止下降或学习率达到0.000 01。各对比算法超参已根据原文调至最优,WESUP 每个超像素的面积设定约为50 个像素,SizeLoss 初始学习率为0.000 5,CDWS 和全监督的对比算法与本论文设置一致。

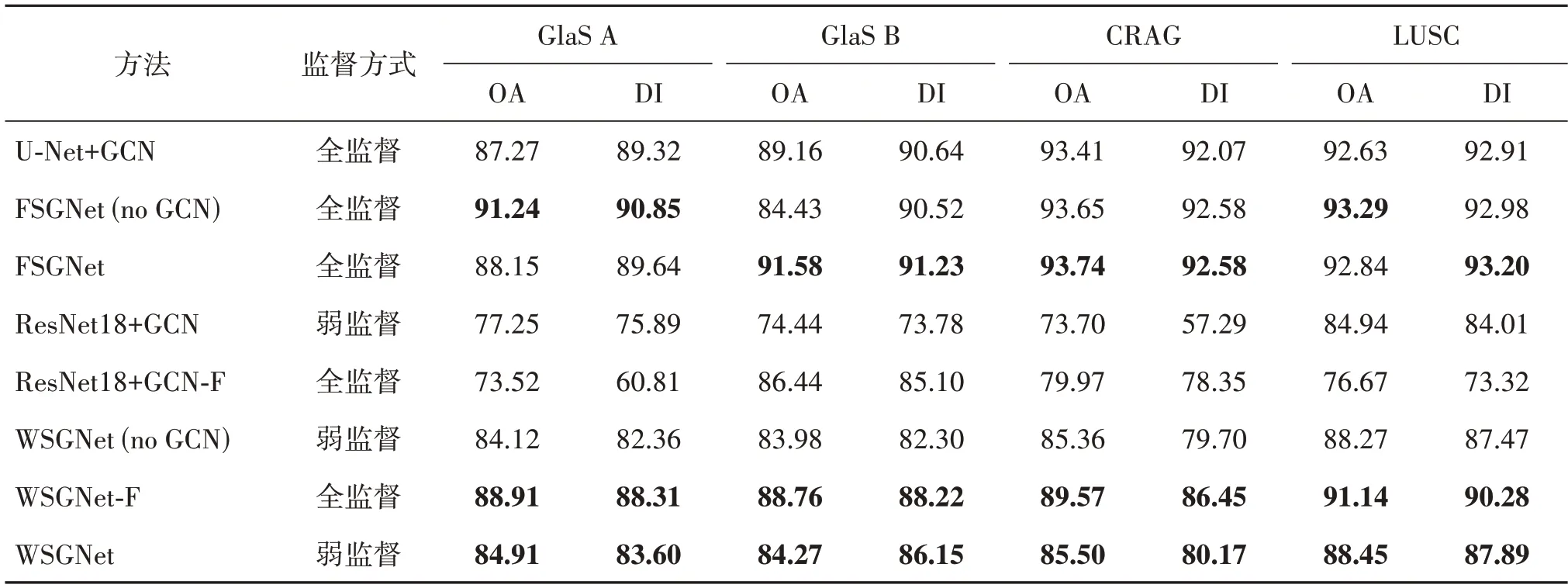

3.3 定量分析

在相同条件下,在3 个数据集上对几种先进的全监督和弱监督对比方法进行测试实验。其定量指标对比如表1 所示,定性评价如图7 所示。FSGNet在3 个不同的数据集下都取得了最好的效果。通过比较UNeXt及FSGNet 模型的指标参数,发现添加了GCN 的FSGNet 指标 均高于UNeXt。且FSGNet 在面对不同数据集时性能差异不大,证明加入GCN 能使得模型在3 个不同的病理图像数据集上有更强的鲁棒性、更广的泛化性以及更好的性能表现,WSGNet表现出优于其他弱监督模型的性能,这说明主干网络提取的层次特征有良好的表示能力和用超像素过分割策略的优越性能。不仅如此,仅使用稀疏点标记的WSGNet 的分割精度超过了使用全监督的FCN-8 模型。本文所提框架可以适应不同应用场景,FSGNet 使用像素级标签的数据集进行训练精准分割病理图像目标和背景,WSGNet 适用于标记数据不足的情况。

表1 在GlaS、CRAG及LUSC数据集上的性能Table 1 Performance on the GlaS,CRAG and LUSC datasets /%

3.4 定性分析

图7为预测分割样例。FSGNet能够更加完整地分割样例,更准确预测样本目标中心区域,漏检和误检的情况更少。证明FSGNet 能够更好地生成预测分割图,并且能够有效处理复杂区域并减少中心漏检问题的发生。如 图7 所示,CDWS,SizeLoss 和MICRANet 三个模型在分割效果上表现不佳,很难准确分割出癌变区域。Wesup 模型在预测分割图时能够大致捕捉到目标区域的轮廓,但仍存在较多漏检误检区域和噪声。相比之下,WSGNet 模型的预测分割图能够准确地分割出目标区域,很少出现漏检情况,并且能够减少误检噪声,具有更好的鲁棒性和泛化性。从图7 还能看出,经弱监督模型学习后,超像素特征的类别区分性更强,说明弱监督图网络比全监督图网络更为鲁棒。

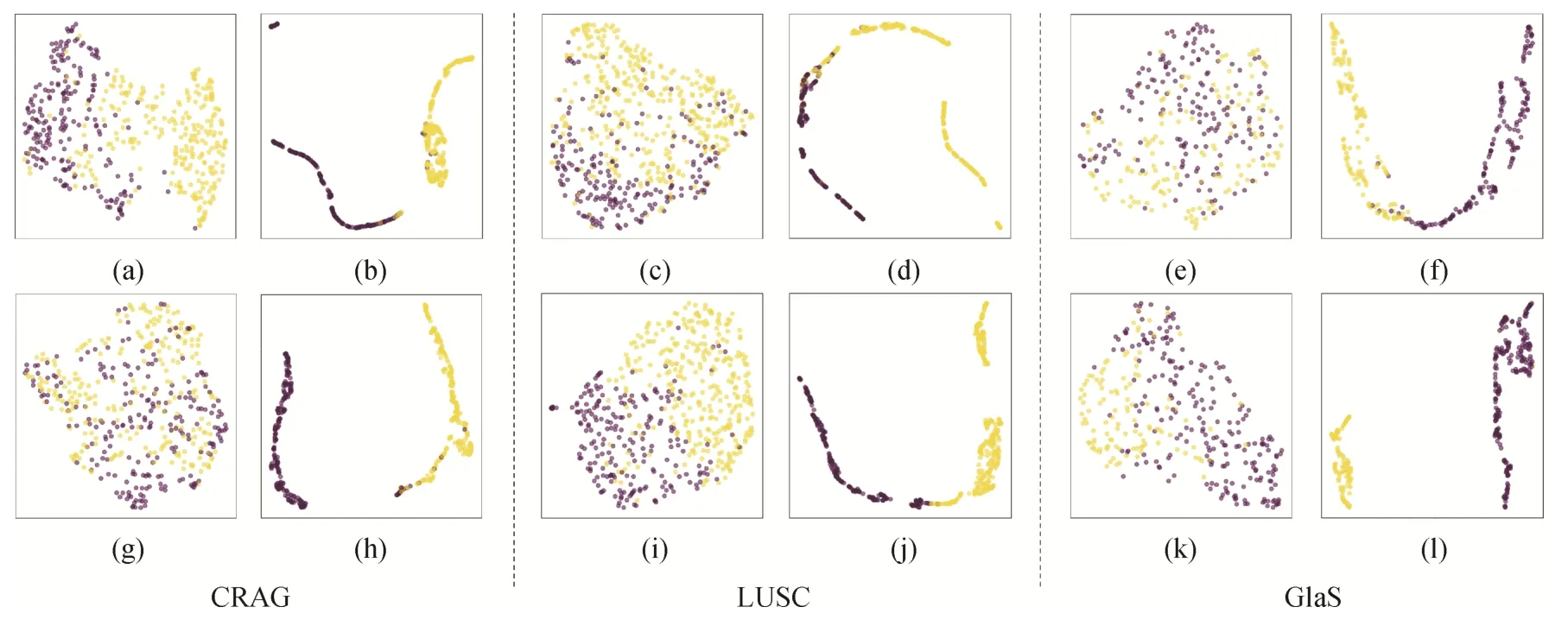

图8 是使用UMAP(uniform manifold approximation and projection)的方法对数据集的图像特征进行可视化的结果。其中,图8(a)(c)(e)(g)(i)(k)是随机选取数据集中的图像得到的特征可视化结果,图8(b)(d)(f)是经过FSGNet 训练得到的特征可视化结果,图8(h)(j)(l)是经过WSGNet训练得到的特征可视化结果。图8 中,浅色代表前景超像素,深色代表背景超像素。由于病理组织具有严重的类间同质性和类内异质性,同时还存在背景杂质、染色深浅不一等问题,因此在初始未进行训练时,不同标签的超像素样本特征混合分布。而经过FSGNet和WSGNet模型训练后,同类超像素特征聚在一起,不同类超像素特征相隔间距较大,说明提出框架能够有效区分目标和背景,从而识别病理组织区域。

3.5 消融实验

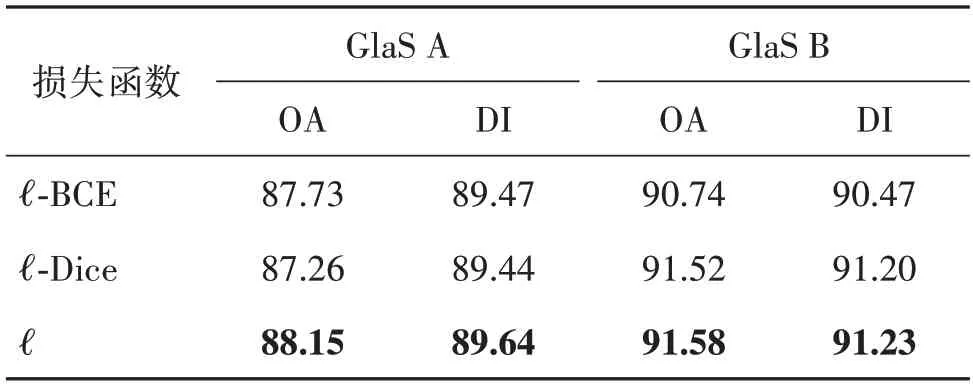

为了分析模型架构的有效性,在GlaS、CRAG 和LUSC三个数据集上完成了一系列消融实验,结果如表2—表4 所示。首先,比较FSGNet 采用不同的损失函数在性能上的差异。发现FSGNet 的损失函数除去任意一项都会使模型分割性能降低。其次,比较使用不同主干网络的模型在性能上的差异。发现FSGNet 和WSGNet 在替换主干网络后,模型性能大幅度下降。最后,冻结了GCN 模块,发现FSGNet 和WSGNet的OA 和DI评价指标都有一定程度下降(尤其是DI),这是因为GCN 能够更好地学习病理组织的不规则形态,有助于提高分割性能。由于监督信息的增加,全监督模式的WSGNet 得到了更加优秀的分割结果。弱监督模式中只有少量引导标签可用,要求网络具备更强大的表达能力以捕捉数据中的非线性特征和细微变化。相比之下,全监督模式在数据集相对简单且标签充分的情况下,引入非线性的作用不明显,所以FSGNet 在没有GCN 的情况下,在GlaS A中的表现更好。

表2 FSGNet采用不同损失函数的性能对比Table 2 Performance comparison of different loss functions in FSGNet%

表3 不同算法运行时间对比Table 3 Comparison of running time with different algorithms/s

表4 主干网络和图网络的消融实验Table 4 Ablation experiments of backbone and GCN%

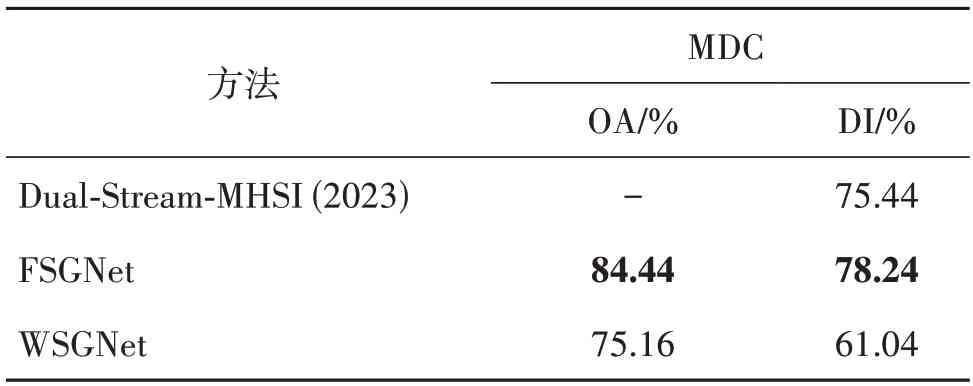

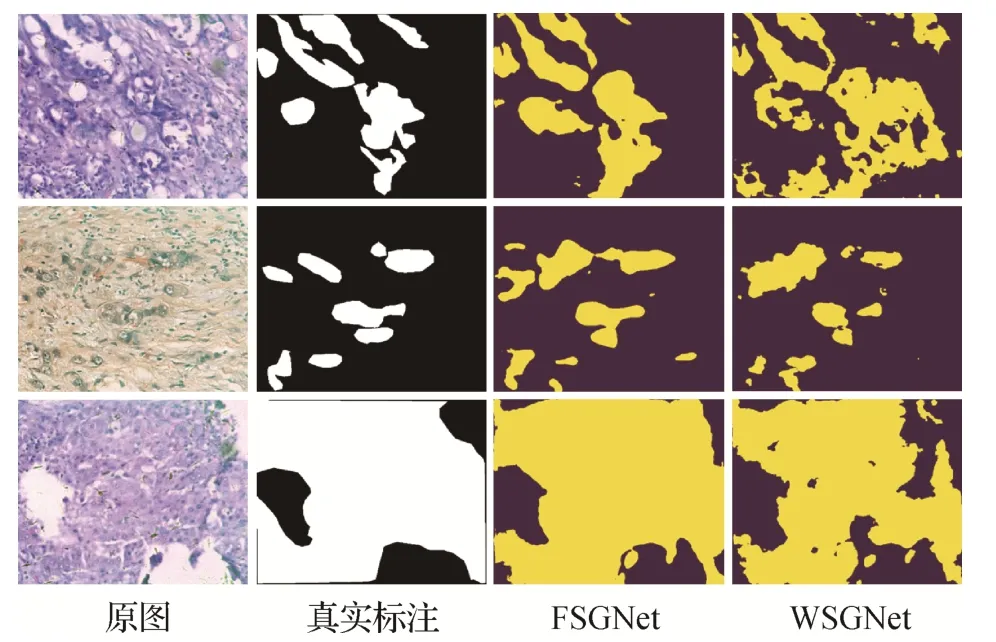

3.6 泛化性分析

将本文算法与Yun 等人(2023)提出的Dual-Stream-MHSI 算法在高光谱数据集MDC 上进行比较,其定量指标对比如表5 所示,定性指标对比如图9 所示。Dual-Stream-MHSI 采用DI 作为评价指标。从表5 可知,本文所提的全监督模式在相同标注量情况下DI 指标超过Dual-Stream-MHSI 算法2.8%,这是因为Dual-Stream-MHSI 依赖于CP(candecomp/parafac)分解,该技术主要用于挖掘低秩特征,所以在语义分割任务表现不如图学习。从图9 可知,本文提出的全监督模式能够得到更优秀的分割结果,弱监督模式能在只含有极少数量的点标签且MDC数据集波段多的情况下表现良好。除此之外,发现拓扑图学习能表达数据隐藏的非线性结构,不受浅层形态特征限制,能够表达丰富的病理图像信息,具有较强的泛化性。

表5 本文算法与Dual-Stream-MHSI在MDC数据集的性能对比Table 5 Comparison of performance on MDC dataset between Dual-Stream-MHSI and ours

图9 在MDC数据集上分割效果Fig.9 Segmentation performance on the MDC dataset

3.7 收敛性分析

如 图10 所 示,FSGNet 和WSGNet 在 不同 数据集中的损失值随着轮次的增加而减小直至平稳;其DI 值随着轮次的增加而增加直至平稳。这两者都得到较好的收敛效果,证明本文所提框架的有效性。

图10 FSGNet和WSGNet在不同数据集上的表现Fig.10 Performance of FSGNet and WSGNet on different datasets((a)loss curves of FSGNet;(b)DI curves of FSGNet;(c)loss curves of WSGNet;(d)DI curves of WSGNet)

3.8 超参数分析

在3 个数据集上,对式(8)中的正则化项平衡因子进行超参数分析,并记录FSGNet 在验证集中DI指标的变化,结果如图11所示。

图11 FSGNet的超参数分析Fig.11 Hyperparameters analysis of FSGNet

FSGNet使用GCN 进行正则化时,发现随着图正则化系数因子的增加,验证集中的DI 指标呈现一定规律。当正则化系数因子等于0 时,DI 指标达到最小值;而当正则化系数因子等于0.3时,DI指标达到最大值。这表明添加正则化项,可以提高分割性能。然而,当正则化项稀疏因子过大时,会降低主干网络特征的重要性,影响特征的丰富性,导致性能下降。因此,本文中将正则化系数因子设置为0.3,以达到最佳性能。

4 结论

针对精细标注的病理图像非常稀缺,且病理组织具有类间同质性和类内异质性,图像特征之间具有复杂的非线性关系,本文提出了一种新颖的病理图像区域分割框架,包括全监督和弱监督两种模式,可以根据不同标注量的数据集和不同应用场景的精度需求灵活切换监督模式。通过GCN 来学习病理图像中组织的不规则形态。FSGNet 能达到更高的分割精度,WSGNet 通过稀疏点标签将语义分割转化为超像素分类问题,实现精细分割。正如本文实验所证明,提出的框架在各种数据集上学习效率高,表现出较好的泛化性和鲁棒性,两种模式取得的实验结果均优于多种先进的算法。但本文提出的全监督模式在处理简单数据集上GCN 表现略有不足,主要是简单数据集对网络的要求更低,对此将在后续工作中进一步研究和改进,区分模型对简单和复杂数据集的处理方式。