基于双目视觉的吊卡识别及其方位检测方法

针对钻井自动化中的吊卡方位需要人工参与,存在识别定位缓慢和准确性差等问题,建立了基于双目视觉的吊卡自动识别和方位检测系统。通过搭建双目相机视觉检测系统,对获取的吊卡图像进行标定、立体校正和立体匹配,进而获取吊卡图像的深度图。在原YOLOv5s目标检测算法的主干网络中引入卷积注意力机制模块,将要识别的目标即吊卡图像进行增强,进一步提高吊卡的识别准确率,结合深度图计算出吊卡中心位置相对机械手的距离和偏转角度,从而实现自动送管。通过在钻井平台的试验,验证了吊卡识别和检测方法的有效性。所得结论可为钻井平台自动化程度的进一步提高提供技术借鉴。

吊卡识别;方位检测;双目相机;YOLOv5s算法;卷积注意力机制模块;试验验证

Elevator Recognition and Orientation Detection

Method Based on Binocular Vision

In order to solve the problems such as manual involvement,slow recognition and poor accuracy in elevator positioning in drilling automation,a binocular vision based elevator automatic recognition and orientation detection system was built.By means of building a binocular camera visual detection system,the obtained elevator images were calibrated,stereo corrected,and stereo matched to obtain depth maps of them.A convolutional attention mechanism module was introduced into the backbone network of the original YOLOv5s target detection algorithm to strengthen the target to be recognized,i.e.,the elevator image,further improve the recognition accuracy of elevator,and figure out the distance and deflection angle of the elevator center position relative to the manipulator combined with depth maps,thus achieving automatic pipe feeding.The effectiveness of elevator recognition and detection method was verified through tests on drilling platforms.The conclusions provide technical reference for further improving the automation level of drilling platforms.

elevator recognition;orientation detection;binocular camera;YOLOv5s algorithm;convolutional attention mechanism module;experimental verification

0 引 言

在鉆井平台作业中,需要频繁进行起钻和下钻作业,其中的管柱处理不仅占用了大量钻井时间[1],而且需要多人配合完成,存在明显的效率和安全问题。近些年发展起来的钻井管柱自动化操作技术实现了将单根钻杆从排管架输送到钻台面、在钻台面将钻杆连接成立根、将立根有序排放在立根区内指定位置等步骤的自动化操作,初步实现了钻井管柱操作的过程自动化,不再需要人工接触操作管柱[2-6]。

目前,不论国外还是国内生产的自动化钻机,在自动化操作过程中,仍需要人工通过摄像头来判断管柱位置以及吊卡方位,还不能实现完全的无人自动化,且人工识别还存在缓慢和准确性差等问题,这些都极大影响着排管操作过程的流畅性、安全性及操作速度。

针对上述问题,笔者设计了一套视觉检测系统,进一步提升了钻井自动化程度,首次实现了管柱和吊卡的自动识别和检测。因吊卡自身随时都存在前后和左右的晃动,故机械手在推送过程中不仅要检测吊卡的左右位置,还要检测出吊卡的深度信息,然后才能对管柱推送进程进行准确的调整。本文只介绍吊卡的自动识别与定位检测技术。

李进付:基于双目视觉的吊卡识别及其方位检测方法

1 吊卡检测任务及方案

在自动化钻井平台进行下钻操作时,二层台机械手从指定指梁内抓取管柱并拉出,再推送至吊卡处。图1是二层台机械手将管柱推送至吊卡处的示意图。

在推送立柱过程中,因为吊卡的位置不固定,前后和左右都在摇摆,需要实时检测吊卡相对机械手的方位信息,即吊卡相对机械手的距离和偏转角度,以确保二层台机械手能够准确地将管柱推送到吊卡中心处。

吊卡识别及方位检测方案如下。

(1)双目相机视觉检测:采用双目相机,得到吊卡图像的深度图。

(2)吊卡识别:采用改进的YOLOv5s算法识别图像中的吊卡及其中心位置。

(3)吊卡方位检测:通过吊卡中心位置的深度信息,计算出吊卡方位,即吊卡相对机械手的距离和偏转角度。

2 基于双目相机的吊卡相对距离测量

因为目前的深度相机无法满足钻井平台所要求的防爆功能,所以通过2个防爆相机组成双目视觉检测系统。在2个不同位置的相机内生成不同的图像,吊卡在2幅图像中的位置差异称为视差,利用视差再转换为吊卡相对相机平面的深度信息,最终转换为吊卡相对机械手的距离。

2.1 双目相机标定

使用张正友标定法对双目相机标定[7],除了计算出左右2个相机的内参数矩阵,还要计算出左右2个相机的空间位置关系,即2个相机之间的旋转矩阵R和平移矩阵T。

设空间中任意一点的坐标矩阵为P,其在左右2个相机坐标系下的坐标矩阵分别为Pl和Pr,根据相机的针孔成像模型,可得:

式中:Rl和Rr分别为左、右相机的旋转矩阵;Tl和Tr分别为左、右相机的平移矩阵。

式(1)中消去P,可得:

Pr=(RrRl-1)Pl+(Tr-RrRl-1Tl)(2)

若以左相机为参考基准,则右相机相对于左相机的旋转矩阵R和平移矩阵T分别为:

2.2 图像立体校正

利用几何图形变换关系,使得2个相机的成像平面处于同一平面。采用Bouguet算法进行立体校正[8],构造变换矩阵Rt为:

Rt=r1Tr2Tr3TT(4)

其中:

式中:r1、r2及r3分别为变换矩阵Rt的3个列向量。

将左右2个相机坐标系分别沿旋转矩阵R的正方向和反方向各自旋轉90°后,相应的旋转矩阵分别记为R1和R2,进而得到左右2个相机立体校正后的投影矩阵RL和RR分别为:

校正前后的结果对比如图2所示。校准前左右2个相机的吊卡图像不在一个水平线上,经过立体校正处理后,左右2幅吊卡图像的对应点处于同一水平线上。

2.3 图像立体匹配

将左右2个相机图像上的对应点进行匹配,计算左右图像匹配点的视差,进而得到图像的深度信息。采用SGBM(Semi-Global Block Mathing)算法进行立体匹配[9]。该算法是通过动态规划的方法,构建左右2个相机匹配像素点之间的最小代价路径,并将其转化为视差图。代价的累计函数如下:

式中:p为像素点;d为视差;Lr为当前路径的累计代价函数;c为当前像素点的代价;P1、P2分别为相邻像素点视差存在较小和较大变化时的惩罚系数;r为某条路径的像素点;在此为像素点P左边的相邻像素点;γ为各个方向路径长度不同形成的影响量;γ=minLr(p-r,i),其中i为任一点视差。

之后通过平行双目视觉的几何关系,将视差图转换为深度图。转换公式如下:

式中:Hd为深度;f为归一化的焦距;b为2个相机光心之间的基线距离。立体匹配结果如图3所示。

图中深度图的颜色越深表示深度越大,如地面离相机较近在图中为浅蓝色,墙壁离地面较远在图中为深红色。

3 基于CBAM的YOLOv5s吊卡识别算法

尽管YOLOv5s算法在公开数据集上有着不错的性能表现[10-11],但钻井现场应用时仍会出现误检或者漏检的情况:尤其是当所送管柱与吊卡位置重合时,吊卡的位置检测会出现错误;当天气环境变化时,也容易造成漏检。为此引入卷积注意力模块CBAM(Convolutional Block Attention Module),以提升YOLOv5s算法在复杂场景下的检测性能[12]。

3.1 卷积注意力机制模块

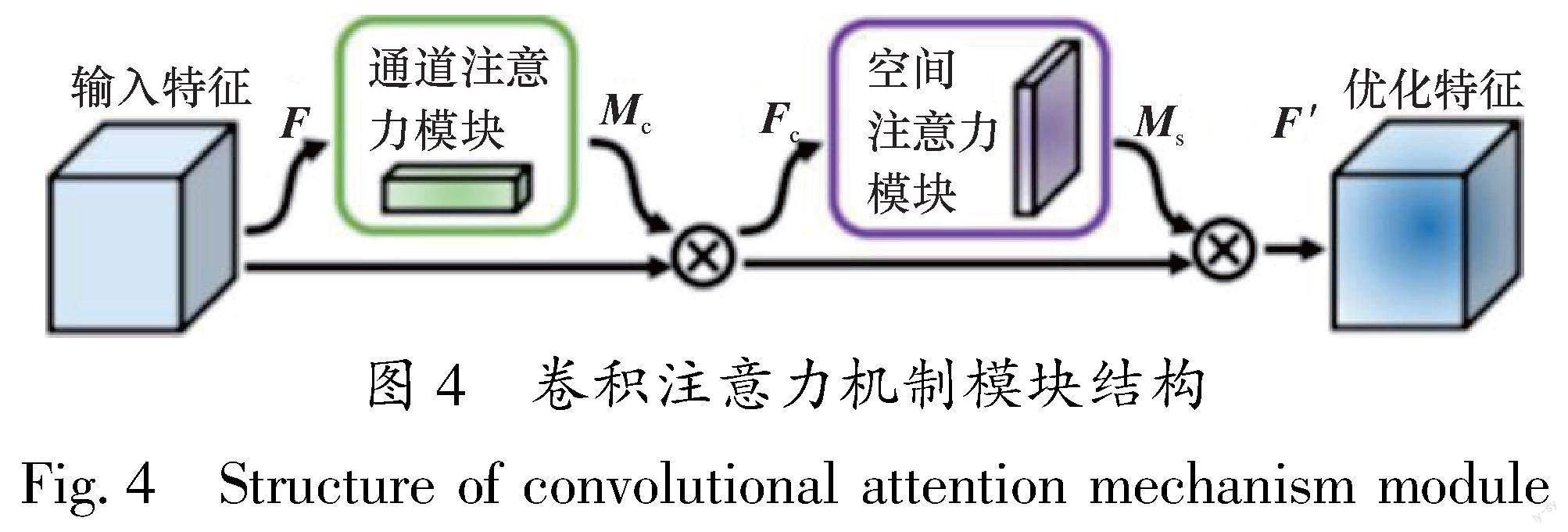

CBAM是一种用于增强卷积神经网络(CNN)性能的注意力机制模块,结构如图4所示。其由通道注意力模块和空间注意力模块2部分组成。

在通道注意力模块中,先对输入特征矩阵函数F(H×W×C)分别进行全局最大池化和全局平均池化操作,得到2个1×1×C的特征矩阵;之后2个特征矩阵经过两层隐含层的多层感知机(MLP),并通过矩阵逐元素加法操作相结合;最后通过Sigmoid激活函数生成通道注意力特征矩阵Mc,将Mc与原始输入特征矩阵F进行矩阵逐元素乘法操作(哈达玛积),得到空间注意力模块所需输入特征短阵Fc。Fc也是通道注意力模块的输出特征矩阵,其计算公式如下:

Fc=σ(MLP(AvgPool(F))+

MLP(MaxPool(F)))⊙F(9)

式中:σ为Sigmoid激活函数;⊙为哈达玛积;MLP为图中的多层感知机;MaxPool(F)为对输入特征矩阵函数F全局最大池化;AvgPool(F)为对输入特征矩阵函数F全局平均池化。

在空间注意力模块中,使用通道注意力模块的输出特征矩阵Fc作为输入特征矩阵。首先对输入特征矩阵Fc分别进行基于通道的全局最大池化和全局平均池化操作,得到2个H×W×1的特征矩阵;接着,将这2个特征矩阵在通道维度上进行拼接;之后通过一个7×7卷积操作,将通道数降为1,即H×W×1;再利用Sigmoid激活函数生成空间注意力特征矩阵Ms,与原始输入矩阵Fc相乘得到经过CBAM后的优化特征矩阵F′。计算公式如下:

F′=σ(f7×7([AvgPool(Fc);

MaxPool(Fc)]))⊙Fc(10)

式中:f 7×7表示7×7的卷积操作。

CBAM注意力机制模块中的通道注意力模块可以增强有效通道、抑制无效通道,空间注意力模块可以增强有用信息而排除噪声和冗余信息[13-16]。

3.2 吊卡识别主干网络总体架构

图5为YOLOv5s的主干网络架构。图6为图5的改进结构,即加入了2个CBAM:一个是在CPS1_3和特征融合模块CBL之间;另一个是CBL和空间金字塔池化结构SPP之间。

改进的YOLOv5s算法可根据采集的图像实时生成吊卡检测锚框,锚框的中心点作为吊卡的中心位置,吊卡识别结果和吊卡中心位置如图7所示。

3.3 机械手旋转角度计算

识别出吊卡及其中心位置后,通过其像素坐标(x,y)计算出相对双目相机坐标系原点的距离,结合吊卡中心位置的深度Hd,即可计算出吊卡相对相机的偏转角度,如图8所示。

偏转角度θ计算公式为:

双目相机位置和二层台机械手的相对位置是已知的,通过坐标系转换,可得到机械手相对吊卡的偏转角度和深度,实现自动送管。

4 试验验证

4.1 吊卡识别性能试验

一共采集了1 000张不同天气情况、不同位置的吊卡图像,并使用数据增强方法(增加随机噪声、随机亮度、随机掩码等)将图像数据扩充到4 000张,将数据集划分为训练集、验证集和测试集,比例为7∶1∶2。使用目标检测任务中常用指标评估模型性能,包括精确率(Precision)、召回率(Recall)、平均精度(Average Precision,AP)以及多类别平均精度(Mean Average Precision,mAP)。

分别采用YOLOv5s、YOLOv5s+CBAM以及SSD(Single shot multibox detector)[17]进行了试验验证。模型的部分训练参数统一设置如表1所示;其余超参数采用YOLOv5s算法官方代码中的默认参数值。输入深度学习网络图像的分辨率全部设置成640×640,使用VOC2007数据集的训练权重作为3种检测算法的预先训练权重,模型各训练300个周期后结束。

图9为3种方法在吊卡识别模型训练过程中的表现情况。对比3种算法损失函数曲线的变化和平均精度曲线的变化可知,基于CBAM的识别模型训练收敛快,同时识别精度更高。

3种方法对吊卡模型的识别效果对比如表2所示。首先,SSD相比YOLOv5s具有较高的精确率,但是其模型更大,识别时间更长。在YOLOv5s上引入CBAM结构,在检测时间少量增加的情况下,识别效果得到了显著的提升,3个评估指标都超过了99%。可见CBAM模块有效提升了模型的性能,相较于原YOLOv5s算法,多类别平均精度提高了7%。

4.2 吊卡方位检测精度试验

在中石化四机石油机械有限公司组装的自动化钻井平台上,对吊卡的识别及其方位检测方法进行了实际验证。

首先在钻台面对吊卡的方位检测精度进行了试验,双目相机外部安装有防爆外壳。为了尽量模拟实际的工作场景,深度相机的位置固定不动,将吊卡打开放置于钻台面,如圖10所示。

通过吊卡左右两边的吊钩改变吊卡的前后位置以及偏转角度,模拟吊卡在二层台上的晃动情况。检测范围也尽量模拟实际场景,将双目相机到吊卡的距离范围设置为3~5 m,偏转角度范围设置为-30°~30°。

使用深度检测的绝对误差、相对误差及角度检测的绝对误差这3个指标来对视觉检测系统进行评估。采用钢卷尺测量吊卡到深度相机的距离、数显角度尺测量吊卡相对深度相机的偏转角度,以此作为人工测量值,将算法程序输出的结果作为检测值,用正负表示角度的左右偏向,试验结果如表3所示。

从试验结果可知,在双目相机视觉检测对吊卡方位的检测中,其深度最大相对误差为3.28%,角度检测的最大绝对误差为2.5°,由于吊卡开口大小是管柱直径的几倍,上述误差并不影响管柱的推送。

之后在二层台上进行了实际验证,双目相机安装在井架二层台的挡风墙处。在二层台上无法测量吊卡的真实距离和偏转角度,但通过实际操作验证可知,通过对吊卡的识别及方位检测,机械手送管柱至吊卡处的过程已无需人工干预,其过程实现了完全自动化。

5 结 论

针对自动化钻井平台的吊卡方位需要人工判断的实际问题,建立了基于双目视觉的吊卡自动识别和方位检测系统。

(1)在YOLOv5s目标检测算法的主干网络中引入CBAM注意力机制,将要识别的目标即吊卡图像进行增强,从而进一步提高了吊卡的识别精度。

(2)采用2个防爆相机构成双目相机系统,生成吊卡图像的深度图并计算出吊卡中心位置的深度信息,再通过坐标系转换,计算出机械手相对吊卡的偏转角度和深度,从而实现自动送管。

(3)在实际钻井平台进行了测试,由于相机与吊卡的距离远、且相机安装了防爆玻璃,使计算出的吊卡相对距离和偏转角度都有些误差,但吊卡开口是管柱直径的几倍,所以该误差并不影响管柱的推送。该系统的成功应用,将进一步提升钻井自动化和无人化程度。

[1] 罗健,刘传世,杨中兴,等.管柱自动化技术在石油钻机中的应用[J].中国设备工程,2022(14):222-223.

LUO J,LIU C S,YANG Z X,et al.Application of pipe automation technology in oil drilling rigs[J].China Plant Engineering,2022(14):222-223.

[2] 王定亚,王耀华,于兴军.我国管柱自动化钻机技术研究及发展方向[J].石油机械,2017,45(5):23-27.

WANG D Y,WANG Y H,YU X J.Research and development trend of domestic automated drilling rig[J].China Petroleum Machinery,2017,45(5):23-27.

[3] ATCHISON B.Automated well control:a step change in safety[J].Digital Chemical Engineering,2022,3:100022.

[4] 杨传书,张好林,肖莉.自动化钻井关键技术进展与发展趋势[J].石油机械,2017,45(5):10-17.

YANG C S,ZHANG H L,XIAO L.Key technical progress and development trend of automated drilling[J].China Petroleum Machinery,2017,45(5):10-17.

[5] 刘清友.若干智能钻井装备发展現状及应用前景分析:以四川盆地页岩气开发为例[J].钻采工艺,2022,45(1):1-10.

LIU Q Y.Development status and application prospect for several intelligent drilling equipment: a case study of shale gas development in Sichuan Basin[J].Drilling & Production Technology, 2022,45(1):1-10.

[6] 郭华,周超,郑清华,等.中国海上固定平台模块钻机自动化技术现状及展望[J].中国海上油气,2022,34(4):194-202.

GUO H,ZHOU C,ZHENG Q H,et al.Present status and prospect of automation technology of offshore fixed platform modular drilling rig in China[J].China Offshore Oil and Gas,2022,34(4):194-202.

[7] ZHANG Z.A flexible new technique for camera calibration[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2000,22(11):1330-1334.

[8] BOUGUET J Y.Pyramidal implementation of the lucas kanade feature tracker description of the algorithm[M].Intel Corporation Microprocessor Research Labs,2000.

[9] GEHRIG S K,EBERLI F,MEYER T.A Real-Time Low-Power stereo vision engine using Semi-Global matching[C]∥International Conference on Computer Vision Systems.Berlin,Heidelberg:Springer,2009:134-143.

[10] ZHANG Y,GUO Z Y,WU J Q,et al.Real-time vehicle detection based on improved yolo v5[J].Sustainability,2022,14(19):12274.

[11] ZHU X K,LYU S,WANG X,et al.TPH-YOLOv5:improved YOLOv5 based on transformer prediction head for object detection on drone-captured scenarios[C]∥2021 IEEE/CVF International Conference on Computer Vision Workshops (ICCVW).Montreal,BC,Canada,2021:2778-2788.

[12] WOO S,PARK J,LEE J Y,et al.CBAM:convolutional block attention module[C]∥ Proceedings of the European conference on computer vision (ECCV).Cham:Springer,2018:3-19.

[13] 刘彦清.基于YOLO系列的目标检测改进算法[D].长春:吉林大学,2021.

LIU Y Q.An improved algorithm for object detection based on YOLO series[D].Changchun:Jilin University,2021.

[14] 何敏.改进YOLOv5绝缘子及其破损检测算法研究[D].武汉:武汉纺织大学,2022:000328.

HE M.Research on insulator and damage detection algorithm of improved YOLOv5[D].Wuhan:Wuhan Textile University,2022:000328.

[15] GUO M H,XU T X,LIU J J,et al.Attention mechanisms in computer vision:a survey[J].Computational Visual Media,2022,8(3):331-368.

[16] NIU Z Y,ZHONG G Q,YU H.A review on the attention mechanism of deep learning[J].Neurocomputing,2021,452:48-62.

[17] LIU W,ANGUELOV D,ERHAN D,et al.SSD:single shot MultiBox detector[C]∥European Conference on Computer Vision.Cham:Springer,2016:21-37.